Hirdetés

- Luck Dragon: Alza kuponok – aktuális kedvezmények, tippek és tapasztalatok (külön igényre)

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- Brogyi: CTEK akkumulátor töltő és másolatai

- Sub-ZeRo: Euro Truck Simulator 2 & American Truck Simulator 1 (esetleg 2 majd, ha lesz) :)

- eBay-es kütyük kis pénzért

- lezso6: Nemzetközi újév visszaszámlátor alkoholistáknak

- Kalandor: „Ha engedtem volna a lelkiismeretemnek, az üzlet kevésbé lett volna jövedelmező”

- vrob: Próbálkozás 386 alaplap újraélesztésre

- Luck Dragon: Asszociációs játék. :)

- sziku69: Szólánc.

Új hozzászólás Aktív témák

-

Asbee

veterán

válasz

#85552128

#27298

üzenetére

#85552128

#27298

üzenetére

Szokásos és sokadik mosdatás.... nem kell folytatnom szerintem. Az még oké, hogy valakit nem érdekel, de hogy meg kell magyarázni ez miért is jó és extra... Nem egy nagyon nagy dolog, de elég pofátlan, teljesen jogos akit zavar és elítéli az ilyen titkolt reklámokat.

-

#45185024

törölt tag

Itt a Poor Vega : 1030

)

)

-

#85552128

törölt tag

Radeon Software Adware Edition

"Edit: In case you are wondering where that Quake Champions Beta shortcut on your desktop comes from, AMD's 17.4.4 driver installation stealth-adds that to your desktop, with a bit.ly tracking link, instead of directly to the official page. Looks like AMD is making some $$ from it, a referral id is included in the final URL destination, too."

Gyönyörű.

Már csak a pop-up hirdetések integrálása hiányzik. Ennyire kell a $$, hogy a driverbe kell integrálni más szarjának a reklámozását ?

Bit.ly, meg referal ID, lol. Mi jön legközelebb, Lisa Su livecam ?

-

mlinus

őstag

nem úgy volt hogy a prey-el együtt jön a vega?

-

Abu85

HÁZIGAZDA

válasz

Raggie

#27291

üzenetére

Raggie

#27291

üzenetére

Az nem bug. A motor támogatja a dinamikus napszakváltozást. Tehát, ha tovább állsz egy helyen, akkor a napból származó shadow casting fény már nem olyan szögben világít be. Ez okozza az eltéréseket. Ha pontosan ugyanabban az időben történne a felvétel, akkor ugyanolyan szögből érkezne a fény. A számításigény egyébként ettől nem változik meg, mert a shader úgyis lefut, csak más lesz az output az eltérő input miatt.

(#27285) FLATRONW: Tükröződik, csak valószínűleg egy pár percet állt az egyik gép a felvétel előtt, és ez elmozdította a shadow casting fényforrás helyét.

(#27286) Yutani: Mindkettőn jó, csak mozog a fényforrás. Persze az ennyire erős visszaverődés nyilván egy dizájnhiba, de ezt nem a kártyák rontják el, hanem ilyen a játék. Őszintén szólva az eddigi CI címekhez képest...

-

Raggie

őstag

válasz

FLATRONW

#27287

üzenetére

FLATRONW

#27287

üzenetére

Nem akarok a vitátokba avatkozni, mert nem néztem meg a konkrét videót, de pl ez a "tükröződő talaj" effektus engem rohadtul zavar/zavart. Én örülnék ha reálisabbak lennének ilyen szempontból a játékok.

A víz is pl sok játékban szinte tök átlátszó, miközben a valóságban gyakorlatilag alig látni bele a vízbe ha nappal kültéren van az ember, mert a felszíne annyira tükrözi a környezetet.

Ez a két grafikai logikátlanság már egy jó ideje zavar, most ki kellett írnom magamból. Sry, hogy beletrollkodtam a vitátokba!

-

FLATRONW

őstag

válasz

Yutani

#27286

üzenetére

Yutani

#27286

üzenetére

Persze, persze, nyilván az elmúlt évek játékainak mindegyikében csak egy hiba miatt tükröződik a napfény a talajon.

Az össze autós játékban fénylik az ut a víztől, pedig sosem esik az eső.

Az össze autós játékban fénylik az ut a víztől, pedig sosem esik az eső.

Ezek után egyáltalán nerm merült fel bennem a hiba lehetősége. Tehát AMD-n valamiért nem tükröződik a napfény. -

Yutani

nagyúr

válasz

FLATRONW

#27285

üzenetére

FLATRONW

#27285

üzenetére

Az fel sem merül, hogy a napfénynek a sima talajon nem is kellene így tükröződni? Egy eset van, ha éppen eső után vagyunk és a nedves felület miatt verődik így vissza a fény. Azonban nem láttam utalást a videóban arra, hogy éppen eső utáni helyszínen játszódik ez a jelenet.

Tehát valamiért NV-n jelenik meg rosszul a tükröződés.

Persze mindenkinek joga van a saját szemszögéből vélt igazát hangoztatni.

-

FLATRONW

őstag

válasz

#45997568

#27282

üzenetére

#45997568

#27282

üzenetére

Nekem sincs ezzel semmi bajom. Az agyontuningoltat az 580 miatt mondtam, hiszen alapból az is egy agyontuningolt kártya a 480-hoz képest, ami az alap 1060-nak a közvetlen ellenfele.

(#27284) Abu85:

Nyilván megmaradna az előny, de nem lenne ekkora. És azért vegyük figyelembe ennél a videónál, hogy Radeon-on valamiért nem teljes a grafika, nem tükröződik a napfény a talajon. -

Abu85

HÁZIGAZDA

válasz

FLATRONW

#27281

üzenetére

FLATRONW

#27281

üzenetére

Az se lett volna erősebb igazából, hiszen a nagy látótávolságú jeleneteknél 20 fps különbség is volt. Itt azért erős a Radeon, mert a CI Games frissítette a CryEngine-t, és az újabb verziók PC-re kétféle módon oldanak meg bizonyos problémákat. A szabványos kóddal szimplán sok atomi műveletet használ a motor a préseléshez, míg a másik mbcnt és ballot függvényt. Utóbbi sokkal gyorsabb már a kód szintjén, de csak GCN-en fut le, tehát a GeForce rá van kényszerítve a lassú kódra. Ennyi a titok. Majd ha az egész szabvány lesz a shader modell 6-ban, akkor ezek a függvények általános szinten is használhatók, és valamennyit gyorsítanak a GeForce-on is.

-

#45997568

törölt tag

válasz

FLATRONW

#27281

üzenetére

FLATRONW

#27281

üzenetére

Nincs azzal gond ha egy jatek fekszik az egyik gyarto kartyajanak, amig X jatekra vetitve atlagolom az eredmenyeket es hasonloan szerepelnek. A gond az lenne ha csak az egyik gyarto kartyain mennenek a jatekok rendesen, a masikon meg ugy ahogy.

Ez a jatek az AMD kartyaknak fekszik, masik meg az NV-seknek.

A logikat sem ertem, miert kellene egy agyontuningolt kartyaval versenyezni, az igazan mervado az lenne, ha fognal ket hasonlo egyedi huteses kartyat, betenned a gepbe es ugy probalnad ki, leven a felhasznalok 90%-a amugy is igy hasznalja, nem allitgat semmit.

-

Crytek

nagyúr

válasz

TTomax

#27279

üzenetére

TTomax

#27279

üzenetére

Hihetetlen büszke lehet rá a CI Games! A második része is cryengine már és ez a 3. rész ahhoz képest az év grafikája + minden tekintetben sokkal jobb lett. Jöhetne tőlük egy cryengines open world rpg mert ha ők nem soha senki se fog csinálni semmit ezzel a Cryenginnel ami rpg

-

TTomax

félisten

válasz

#45185024

#27277

üzenetére

#45185024

#27277

üzenetére

Nem tudom erre mennyire lehet büszkének lenni,se DX12,se Vulkan,se Mantle... CryEngine,de a Crysis 3 mérföldekkel jobban nézett ki nála ugy 2012ben,olyan 2007-2008ban voltak ilyen kinézettel játékok.Bár mondjuk ennek a játéknak az elsö-második része is kb igy nézett ki...de kell is néha egy-egy "zs" ketgóriás játékot találni ami megnyugtatja a kedélyeket... nálam max akkor lesz megvéve ha a humble 1 dolláros csomagban benne lesz...Ha már AMD igaz off,de ez érdekes...

-

#45185024

törölt tag

Sniper Ghost Warrior 3 GTX 1060 Vs AMD RX 580 1080p Videó

-

Petykemano

veterán

válasz

Yutani

#27261

üzenetére

Yutani

#27261

üzenetére

Ezzel csak egy baj van. Mármimt ha nem lesz gyorsabb, csak olcsóbb. Olyan elképelhetetlenül kicsinek és mocskosul alacsony fogyasztásúnak kell lennie, hogy arra azt lehessen mondani, valójában ezért pofátlanul magas árat kér az amd, miközben kevesebbért árulja ugyanazt a teljesítményt, mint az nvidia. Hogy a volta se gyalulja le. Mert azt lehetett sejteni, hogy az intelnek nincs csodafegyvere és csak pár százalékos játéktere van. De a gpuk esetén nem ritka a generációnkénti 30-50%-os teljesítménynövekedés.

-

Yutani

nagyúr

válasz

wjbhbdux

#27263

üzenetére

wjbhbdux

#27263

üzenetére

az a baj hogy megint nem egy intelt felülmúló terméket csináltak hanem csak intelt helyettesítőt

Tudom, mindig van valami baj, ha AMD-ről van szó. Eddig az volt a gond, hogy az FX-szel nagyon le voltak maradva. Most hoztak egy terméket, ami c4c felveszi a versenyt az Intellel, de most meg az a baj, hogy nem múlja felül az Intelt. De. Felülmúlja sok esetben, játékban kissé elmarad, főleg az órajelnek köszönhetően, néhol meg az optimalizálatlanság miatt (az Intel jelenlegi uarch-ja 7 éve van piacon kvázi változatlanul, és erre van optimalizálva minden szoftver).

Azt nem értitek meg, hogy van választási lehetőség. Nem tudom szebben megfogalmazni.

És nagyon remélem, hogy a VEGA hozza legalább azt, amit a Ryzen CPU fronton, hasonló filozófiájú árazással. Azaz VGA fonton is lesz választási lehetőség, ha valaki RX580 feletti teljesítményt akar.

Konzolt hagyjuk, csak beírtál valamit, ami az AMD-re nézve negatív felhangú, és csak egy érzés a részedről. Ha van forrásod, ami azt mutatja, hogy esnek a PS4/XONE eladások és az oka a szar AMD, szívesen látom.

-

Abu85

HÁZIGAZDA

válasz

Raggie

#27268

üzenetére

Raggie

#27268

üzenetére

Amelyik motort sok magra tervezték ott mindig volt haszna, ha négynél több magod volt.

Senkit sem zárnak ki a játékból. A legjobb az új API-kban a skálázhatóság. Alapvetően a szimulációt most sem tervezik többre, mint két mag, annyival pedig mindenki rendelkezik. Ergo azt nem kell skálázni igazán. A rajzolási parancsokkal viszont végre el lehet szállni. A látótávolság lehet igen extrém is, és egy rakás objektumot ki lehet rajzoltatni, és nem kell a LOD-dal levágni. Akinek négy magja vagy négy szála van, annak elég a world detailt low/medium-ra rakni, és rögtön tökélesen fut. Akinek pedig van hat magja mehet highra. Esetleg a 10-12 magos szörnyeknek lehet csinálni egy ultra beállítást.

A lényeg, hogy az új API-k lehetőségeivel a processzoroldali terhelés nagymértékben skálázhatóvá vált, újra, mint régen. Meghatározható, hogy mennyire messze jelenjenek meg az árnyékok az objektumokon, mi az a távolság, ameddig egyáltalán rajzoljon animált objektumot a rendszer. Erre ma is lehetőség van, de a legacy API-k fogják a rendszert, tehát nem tudják nagymértékben skálázni ezt a beállítást egy ideje. Pedig régen nagy különbségek voltak ebből a szempontból. Ez most végre visszatér. -

Raggie

őstag

Lehetséges, de eddig is voltak már próbálkozások a játékok "többmagosítására", amiknek nem igazán lett foganatja. Kb csak a BF multik és pár kirívó cím esetén érezhető igény a 4 magnál többre.

Meglátjuk mi fog ebből teljesülni, mert azt nem tudom melyik játék készítő meri megtenni, hogy a "büdzsé CPU"-val rendelkező tábort alapból kizárják követelmény szinten...

Én mondjuk üdvözítőnek tartanám a több szálas processzorokban rejlő erő tényleges értelmes mindennapi kihasználását játékokban. Most a Ryzen miatt már egyre nő az a hardverbázis amivel meg lehet ezt lépni, de még jóideig nem lesz mainstream a 6 mag. -

Abu85

HÁZIGAZDA

válasz

Raggie

#27264

üzenetére

Raggie

#27264

üzenetére

Nem a Ryzen miatt adják ki, hanem azért, mert az új minimum a négy mag lesz, és egy négymagoson már kurtítani kell majd a látótávolságot, hogy fussanak a következő éra játékai, ezzel csökkentve a kiadott rajzolási parancsok számát.

Az ID tech 7 már duruzsol a Bethesdánál, és kiszedték belőle a régi API-k támogatását. Csak Vulkan API-ra építik, aminek az az előnye, hogy minden legacy eljárástól megfosztották, de cserébe nem a két mag a minimum, hanem a négy, és az ajánlott a hat-nyolc mag. A következő kör motorfejlesztései lényegében abban merülnek ki, hogy kiszedik belőlük a legacy API-k támogatását, így ezekhez már nem kell a motor szintjén igazodni, vagyis sokkal jobban lehet skálázni több magra. Ez nagyobb megengedhető látótávolságot, és több számítási lehetőséget jelent. A hat mag csupán ezért kell az Intelnek is, hogy tudjon az inteles felhasználó is hat magot venni ezekhez az igényekhez. Ha nem lenne Ryzen, akkor is kiadták volna, mert itt sokkal inkább a programokhoz kell hardvert kínálni. -

Abu85

HÁZIGAZDA

A "looks nice" igazából egy szabványszöveg. A helyzet az, hogy soha senki sem írhat mást hivatalosan. Így van ez az NV-nél, az AMD-nél, az Intelnél. Ezek a szövegek arra jók, hogy ha valaki kérdez egy érkező termékről, akkor egy ilyen szabványszöveggel lehet válaszolni, még akkor is ha agyonveri vagy kikap nagyon. Ezek központi utasítások az ilyen cégeknél. Aki ebből hírt ír nem nagyon érti, hogy hogyan működik a cégek közösségi médiájában az irányított kommunikáció. A "looks nice" azért jó szöveg, mert úgy érzi a kérdező, hogy válaszoltak neki, és eközben igazából nem történt konkrét utalás semmire.

-

tailor74

addikt

válasz

wjbhbdux

#27263

üzenetére

wjbhbdux

#27263

üzenetére

Ez nettó baromság volt most, azt ugye tudod?

A csak "intelt helyettesítő" kifejezés értelme szerint pont ugyanúgy alkalmas mindenre, mint az inteles kispajtása.

Nyilván teszteket sem olvasol, amikben az szerepel, hogy valóban kevesebb a max fps, mint intelnél, ugyanakkor magasabb a minimum, azaz összességében ugyanúgy alkalmas játékra is.

A vga résszel nagyjából egyetértek, annyit fűznék hozzá, hogy aki nem szereti az nv-t ilyen-olyan okok miatt, csak amd-t tud venni.. Azért azt is látni kellene, hogy egy ideje igencsak erős konkurenciája a 480 az 1060-nak.

Az árról meg annyit, hogy egyetlen egy hardver sem er annyit, amennyibe kerül. Piacgazdaság van, vagy megveszed ennyiért, vagy el lehet sétálni.

A konzolokat meg végképp nem kellene idekeverni. Több száz millió darab fogy belőlük, mert van aki leszarja a pc-t, eltesped a fotelban, bekapcsolja és játszik. Ennyi.

-

wjbhbdux

veterán

válasz

Yutani

#27261

üzenetére

Yutani

#27261

üzenetére

rycen annak jó akinek nemvolt gamer gépe (i5+) az elmúlt 5 évből, az a baj hogy megint nem egy intelt felülmúló terméket csináltak hanem csak intelt helyettesítőt, ahogy vga fronton is megcsinálták a gtx970/1060 mását már 4x 290/390/480/580 dehát mire mennek vele. és már az a régi mondás sem igaz hogy az amd az olcsóbb alternatíva.

az a szerencséjük hogy amerikában még mindig havonta százezrek ábrándulnak ki az alulteljesítő (amd) konzolokból meg az RGB világításos üveg pc ház a menő a 12 éveseknél, így nekik most egész jó választás a ryzen

-

válasz

FollowTheORI

#27259

üzenetére

FollowTheORI

#27259

üzenetére

Azt nyilván senki se fogja mondani tőlük, hogy "we are trying to catch the 1080ti, but for now we are stuck at the 1080 performance, with double power consumption"

Tehát az óvatos megfogalmazás, miszerint "looks really nice" inkább rosszat sejtet, mint jót, mert akkor azt mondanák, hogy "absolutely demolishes the titan xp"

-

AMD Radeon Vega in the League of GTX 1080 Ti and TITAN Xp

"Vega performance compared to the Geforce GTX 1080 Ti and the Titan Xp looks really nice," Woligrosky stated.

Mondjuk ezt többféleképp is lehet érteni... lehet akár jóval lassabb is, csak ők tudják milyen áron jön pl, és ha úgy nézzük, akkor egész jól helytáll majd szerintük... emlékezzünk a 480-at is CF-be a 1080-hoz mérték.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Szóval fokozódik a hype...

-

sejtettem, hogy ez nem fog hamar kikerülni ide.

szemlátomást elég tisztességesen sikerült optimalizálni. -

Abu85

HÁZIGAZDA

válasz

huskydog17

#27252

üzenetére

huskydog17

#27252

üzenetére

Az a baj, hogy egy külön UE4 branchbe került. Ugyanígy van Hairworks, VXAO, Flame, Turbulence, és egy rakás eltérő branch az UE4-re. Az Epic nem engedi meg, hogy bármilyen külső gyártótól származó DRM bekerüljön a main branchbe, és ezáltal a DRM-hez kötött effekteket sem tudják ott szállítani. Ugyanez lesz ennek is a sorsa, mint a fenti sok másik, UE4-be DRM-mel integrált effektnek. A fejlesztők többsége nem kockáztatja meg, hogy nem hivatalosan supportált branchre menjenek, inkább nem érdekli őket az effekt.

Ennek akkor lenne igazán áttörő hatása, ha szimplán egy MIT-szerű licenc mellett felkerülne az effekt a GitHUB-ra, tehát nem úgy, hogy ott a forrás, de bele nem nyúlhatsz, mert a DRM a módosítást nem engedi lefutni, hanem úgy, hogy vidd a forrást, nincs DRM sem és integrált a main branchbe, hogy minél többen használhassák. Ilyen formában sajnos halottnak a csók.

Egyébként az jó hír, hogy a DRM-tól megszabadulhat egy GameWorks effekt. A HBAO-t már megkapta az Epic DRM nélkül, és láss csodát be is építették a main branchbe, de persze közben jelentősen átírták, így sokkal gyorsabban is fut.

-

FLATRONW

őstag

válasz

huskydog17

#27252

üzenetére

huskydog17

#27252

üzenetére

Gondolom DX12-őt akartál írni, mert a DX11 támogatás nem meglepő.

szerk.: Elsiklottam az első mondatod felett, így már érthető.

-

huskydog17

addikt

NVIDIA Flow - Tűz- és füsteffektek DX12-ben

Szerintem tök jól néz ki.

A forráskódja fent van Github-on és az effekt integrálásra kerül az UE4-be. DX11 alatt is működik. (Hivatalos oldal)

-

Új RADEON PRO DUO

2x polaris 10 chip

32GB GDDR5 (ráadásul "ultra fast" )

)

De hogy ez hogy fért bele nekik 250W-ba?

-

#45185024

törölt tag

válasz

#85552128

#27247

üzenetére

#85552128

#27247

üzenetére

Az egész REBELS kampány rossz.

Nem azért mert az arcukat odaadták hozzá. Hanem mert ez refress ezért nem üt.

Tehát rosszkor rossz helyen...

Ráadásul negatív kamány, az meg etikusan sosem jó! Kitűnni kell nem másról mondani hogy miben rossz...

Amúgy ha igazi VS-t akartok látni akkor most jön ki az AORUS 1060 9Gbps

Na ez egy remek hűtés és van az 580-ból is ugyanez a refress úgyhogy nekik kell le VSezni, árban és FPS-ben. -

#85552128

törölt tag

Még hogy szar marketing. Ilyen promó mellett ki ne venne RX500-as kártyát ?

-

Yutani

nagyúr

válasz

->Raizen<-

#27243

üzenetére

->Raizen<-

#27243

üzenetére

Ugyanaz, mint 256 bites GDDR3 versus 128 bites GDDR5. Mivel a GDDR6 sávszélessége duplája a GDDR5-nek, így egy RX580-at is lehetne 128 bittel hozni, ha GDDR6 kerülne rá. A GTX 1060-ra meg elég lenne 96 bit.

-

Abu85

HÁZIGAZDA

válasz

->Raizen<-

#27243

üzenetére

->Raizen<-

#27243

üzenetére

128 bites GDDR6-tal igazából kiváltasz egy 256 bites GDDR5-ös kiépítést. Nyilván sokkal jobb ezt 128 biten csinálni. A GDDR6-nak árhátránya csak az első fél évben lesz. Utána felfut a gyártás, normalizálódik a verseny, és onnantól már ez éri meg a GDDR5 helyett.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#27241

üzenetére

Petykemano

#27241

üzenetére

A GDDR6 simán jó a középkategóriába, ott nagy sikere lesz. Szerintem belépőszinten marad a GDDR5, míg a felsőházba a HBM2 kell. De középre a GDDR5 kevés, míg a HBM2 nem feltétlenül előnyös, ha nagyon drágán gyártja az adott GPU-t a bérgyártó. Ott a GDDR6 lesz az arany középút.

-

Petykemano

veterán

Az a szomorú ezekben a technológia-fogyasztás-ár kérdésekben, hogy a HBM(2) a maga alacsony fogyasztásával pont oda, az alsóbb szegmensekbe nem jut le, ahol mind a méret, mind az alacsonyabb fogyaztás miatt illetékessége lenne - az ára miatt.

Mit gondolsz, a GDDR6 elterjedésével - ha ahogy mondod olcsóbb lesz, mint a HBM2 -, lejuthat a HBM2 az alacsonyabb árszegmensekbe? Mobil gpu-knál, illetve miniPC-k esetén indokolt is lenne, mégha drágább is. Lehet-e ezzel piaci előnyre szert tenni?

-

Abu85

HÁZIGAZDA

válasz

schawo

#27236

üzenetére

schawo

#27236

üzenetére

Elég régóta lehet tudni, hogy milyen újításokat vezet be. Ezek egy részét már az elmúlt évben tartott GDC-n beharangozta Matthaus, ezért maradt egy évig titok a publikum előtt a saját előadása, mert olyan dolgokat mondott el, amelyeket az AMD csak idén tárt fel, de a fejlesztőknek tudnia kellett róla korábban.

A legfontosabb nyilván a HW page menedzsment. Ez a GPU-k következő generációja, kb. akkora áttörés, mint anno a unified shader bevezetése volt. Az egyetlen probléma vele, hogy nehéz megcsinálni, de ha egyszer működik, akkor hatásfokban agyonveri a mostani VRAM menedzsmenteket. Muszáj erre rátérni, mert nem minden fejlesztő fog relatíve használható memóriamenedzsmentet írni a programba a DX12 és a Vulkan API-hoz, másrészt ha mondjuk a fejlesztők tényleg 8 GB-ot fognak igényelni a VRAM-ból, akkor optimálisan 32 GB kell a VGA-kra. Ez fél TB/s-os sávszél mellett már jó 80 wattos fogyasztás GDDR6-ból, és ezt a 32 GB-ot muszáj vinned a normális esetben 120 wattos TBP-jű VGA-kra is, ahol ugye 40 watt marad a memórián kívül minden másra. Ebből látható, hogy mekkora a probléma.

-

schawo

titán

válasz

#85552128

#27237

üzenetére

#85552128

#27237

üzenetére

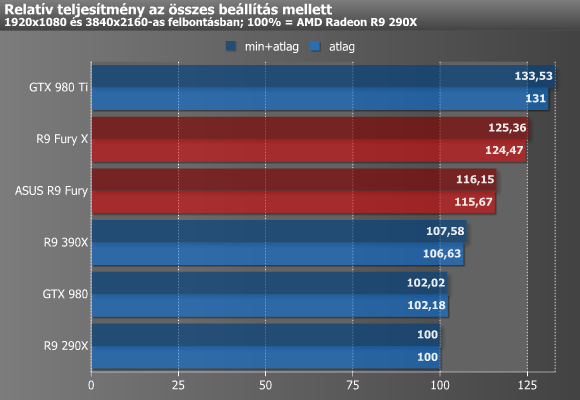

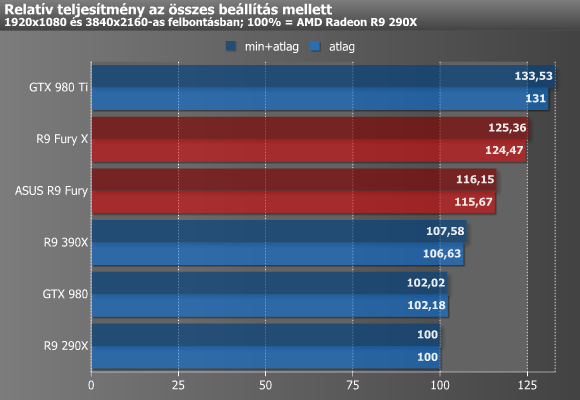

Jó, akkor egy másikat, amiről több minden leolvasható:

p/w

980 < 390X

980Ti > Fury X

És hasonló az arány, mint 480 és 1060 közöttMásk érdekesség, hogy mi történt az ASUS Furyval két év alatt. A régi tesztben még bőven a 980 fölött volt a p/w. Ha pedig a Fury X is ugyanígy bukott, mint a sima Fury, akkor még rosszabb az arány.

-

schawo

titán

Nyilván huszonhárom extra átevezés után, hogy valamennyire igyekezzenek utolérni a magukat a késés miatt. Mert egy outdated modellt kiadni hatalmas csúszással teljesen fölösleges. De ezt sose fogjuk megtudni. Vagy te már egy éve tudod, hogy milyen tudod, hogy milyen rakás olyan dolgot fog tudni, amilyet más hardver még nem?

-

Abu85

HÁZIGAZDA

válasz

schawo

#27231

üzenetére

schawo

#27231

üzenetére

Semmi köze a HBM2 fejlesztésének a Vega 10-hez. Régóta kész van a HBM2, régóta rendelhető, nagy mennyiségben. A Vega 10 egy később indított fejlesztés volt, mert azt már a következő generációs problémák megoldására tervezték. Emiatt tud egy rakás olyan dolgot, amilyet más hardver még nem.

De mondjuk az AMD-nek a memóriaválasztása eleve sokkal szabadabb lehet az NV-nél, mert sokkal olcsóbban gyárt nekik a GloFo, mint az NV-nek a TSMC. Nyilván az NV-nél számításba kell venni, hogy nagyon drágán veszik a wafert, ez korlátozza a választási lehetőségeiket. Amúgy mennének ők is a HBM2-re, mert nincs ellenérv rá. Viszont drágán gyártható GPU-k mellett már megfontolandó a GDDR6.

-

Abu85

HÁZIGAZDA

válasz

Locutus

#27230

üzenetére

Locutus

#27230

üzenetére

A Fury X a HBM nélkül jó 20%-kal lassabb lett volna. A Vega 10 is lassabb lenne HBM2 nélkül. Azt még nem lehet tudni, hogy mennyivel, de nézd azt a tényezőt, hogy ha nem HBM2 lenne rajta, akkor a TBP-ből nem 4 wattot venne el a memória, hanem úgy 40-et, és emiatt a GPU működési órajele is -200-300 MHz lenne.

Nagyon tipikus probléma a VRAM-ra vonatkozó memória, hogy a hagyományosan épített konstrukciók iszonyatosan fogyasztanak már. Főleg a 256 bit feletti kiépítésben, mert ott már sok memórialapka kell, minimum 12 ugye, de lehet, hogy 24, és utóbbi már megint dupla fogyasztás, vagyis repülnek a mínuszok a GPU órajelére. És ugye ott az a szoftveres probléma, hogy kapacitásban minimum az igény négyszeresére érdemes építeni, mert a program által kontrollált rendszerben elveszhet 75%-nyi memória is. Erre mondjuk pont megoldás a HW page menedzsment, de ezt még csak a Vega tudja.

-

#85552128

törölt tag

válasz

Locutus

#27230

üzenetére

Locutus

#27230

üzenetére

Mert ott csak arra volt elég a HBM, hogy a még mindig sokat zabáló GPU-t kompenzálja és szintre hozza a Ti-vel.

Amúgy ja, ahhoz képest, hogy a G5X mennyire "átmeneti", meg "drága" technológia az nV simán felhúzott rá egy félgenerációt és rekordbevételeket könyvelt el, ezzel párhuzamosan pedig az AMD semmit nem tudott felmutatni HBM2-vel.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#27227

üzenetére

Yutani

#27227

üzenetére

Nagyon messze van a HBM2 fogyasztásától a GDDR6 is. Egy 1 TB/s-os 8 GB-os HBM2 stack csupán 4 watt. Egy szintén 1 TB/s-os 8 GB-os GDDR6 stack nagyjából 30 watt, beleszámolva a fogyasztáscsökkentést a GDDR5-höz képest. Ez azt jelenti, hogy GDDR6 mellett a TDP keretből 25 wattal kevesebb jut a GPU-nak. És azzal is számolni kell, hogy kell-e a 16 GB VRAM, aminél a HBM2 stack fogyasztása 6 wattra nő csak, de a GDDR6 stack esetében már 60 watt lesz az energiaigény, vagyis rögtön megint 30 wattal kevesebből gazdálkodhat a GPU. Akkora űr van a kettő között, hogy a GDDR6 a középkategória fölött használhatatlan. Persze az olyan trükkök segíthetnek, mint a HW page menedzsment, így mondjuk nem raknak a kártyára csak 4 GB-ot a 16 GB helyett, de még így is nyer a HBM2.

A GDDR6 elsődlegesen azért kell, mert a GDDR5X ára rendkívül magas. Rosszabb rá építeni, mint a HBM2-re, mert drágább lesz a VGA. Viszont a GDDR6 igazi, gyártók által széles körben támogatott szabvány lesz, tehát nem csak a Micron fogja gyártani, így ez végeredményben árversenyhez fog vezetni, és emiatt a GDDR6 végül olcsóbb lesz, mint a HBM2. Lehet, hogy nem az első pillanatban, de úgy fél éves távlatban simán bezuhan majd az ára, ahogy a tömeggyártás felfut.

-

Yutani

nagyúr

-

#45185024

törölt tag

-

#45185024

törölt tag

---

-

-

wjbhbdux

veterán

RIP HBM [link]

-

-

#45997568

törölt tag

válasz

#45185024

#27211

üzenetére

#45185024

#27211

üzenetére

A 1060 az nem erdekes reszemrol, de a 1070 es afeletti kategoriaban NV azt csinal amit akar. Ket dolog miatt, egyreszt nincs aki versenyezzen veluk, masreszt azok a termekek jok is (ja, leirtam

).

).Itt jon ki az hogy erolkodes nelkul meg tudjak tenni ha akarjak mert alapbol eros a cucc es meg tartalek is van benne eleg.

Egyszeru pelda, a 1080 FE-m GPU base clockja 1607, boost 1733, amikor leulok jatszani egy kattintassal feltolom 2100-ra, memoriat meg 10k-rol 11k-ra, 52C fole nem megy viz alatt.

Ide kell lonie AMD-nek ami piszkosul nehez lesz es alapesetben aki ezt a kategoriat megvette mar annak nemlesz sok ertelme valtani csak ha megvan a +30%.

Valaszolva: Nincs rendben, de van aki megteheti, van aki nem, ennyi.

-

#45185024

törölt tag

NVIDIA launches GeForce GTX 1080 11 Gbps and GTX 1060 9 Gbps

Alcím :Faster memory and higher price

Gondolom az 580 Hatereknek ez teljesen rendben lesz

-

füles_

őstag

válasz

Laja333

#27208

üzenetére

Laja333

#27208

üzenetére

Igazad van, ilyen durva dolgokat ne várjunk a Vegától, mert pofáraesés lesz.

Egyébként elég megbízható forrásból azt hallottam, hogy a Vegát nem boltból kell majd megvenni, hanem le kell tölteni az AMD oldaláról. Nem olyan bonyolult mint elsőre hallatszik, ugyanaz lesz a szitu, mint RAM letöltésnél.Egyébként arról nem tudok valamit, hogy a HD 4850-es kártyámon tudom-e majd használni a Vega vBIOS-át?

-

Laja333

őstag

válasz

füles_

#27207

üzenetére

füles_

#27207

üzenetére

Na, ne jósgömbözzünk, mert jön majd a nagy arcraesés! Lesz nagy meglepődés, ha kiderül, hogy nem is 1, hanem egyenesen 3 PCB lesz egybeépítve, egyenként 2 Pitcairn-al. Majd akkor mondani fogom, hogy "Ééén meg mondtam!44négy" A sok AMD-s meg majd sírhat, ha kiderül, hogy nem úgy lesz, ahogy senki sem várta, hogy lesz...

-

wjbhbdux

veterán

vega átnevezett fury lesz

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

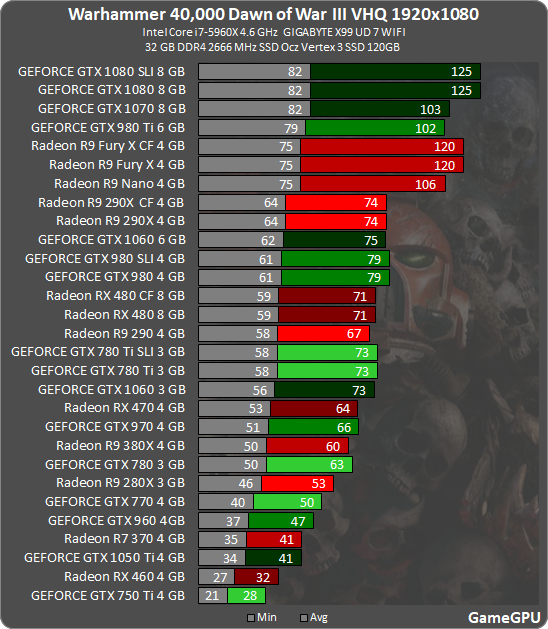

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Hardcore café

- Xbox tulajok OFF topicja

- Motorola Edge 50 Ultra - szépen kifaragták

- Luck Dragon: Alza kuponok – aktuális kedvezmények, tippek és tapasztalatok (külön igényre)

- Samsung Galaxy A56 - megbízható középszerűség

- NVIDIA GeForce RTX 4080 /4080S / 4090 (AD103 / 102)

- Spórolós topik

- Kerékpárosok, bringások ide!

- Google Pixel topik

- Path of Exile 2

- További aktív témák...

- Samsung Galaxy A36 5G / 6/128GB / Kártyafüggetlen / 12Hó Garancia / BONTATLAN

- Yurbuds Ironman fülhallgató

- Huawei Quidway S5324TP-SI-AC - 24G, 4SFP, L2, managed switch

- ÁRGARANCIA!Épített KomPhone i7 14700KF 32/64GB RAM RTX 5080 16GB GAMER PC termékbeszámítással

- Xiaomi Redmi Note 14 Pro+ / 8/256GB / Kártyafüggetlen

Állásajánlatok

Cég: Laptopszaki Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Várom a PH-s hírt erről

Várom a PH-s hírt erről

)

)

![;]](http://cdn.rios.hu/dl/s/v1.gif)