Hirdetés

- Geri Bátyó: Agglegénykonyha 2 – Főzés: szabályok, vagy szabadság?

- Brogyi: CTEK akkumulátor töltő és másolatai

- sziku69: Fűzzük össze a szavakat :)

- sziku69: Szólánc.

- Luck Dragon: Asszociációs játék. :)

- sh4d0w: Netflix? Ugyan, VW előfizetés!

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- eBay-es kütyük kis pénzért

- gban: Ingyen kellene, de tegnapra

- bambano: Bambanő háza tája

Új hozzászólás Aktív témák

-

Petykemano

veterán

Érdekelne a valós helyzet (nem pedig a PR nyilatkozatok)

Az áremelkedéssel tulajdonképpen maguk alatt vágják a fát. Mármint a piaci szegmens alatt.

Értem, hogy az AMD-t a konzol/kézikonzol, az nvidiát pedig az AI miatt nem érdekli.

De azért érdekes volna látni objektíve, hogy mondjuk az említett célpiacokra fókuszálás (onnan érkező emelkedő kereslet) miatt emelkednek a költségek, vagy csak arról van szó, hogy nem kereslet kiszolgálására, nem profitra, hanem magas margóra optimalizálnak.Megjegyzem, nekem évek óta az a véleményem, hogy az AMD-nél ez zajlik, ezért nem hajolnak le az aprópénzért. Vajon mi lehet az oka, hogy ennyire hangsúlyos tényezővé vált a margó egy cég teljesítménye, egészsége szempontjából olyanokkal szemben, mint profittömeg, vagy piaci részesedés?

Ez az Apple minta, oké....lehet, hogy itt már nem is a cég számít, vagy a profit. Mármint hogy ugye gyakorlatilag végtelen pénz van a tőzsdén. A részvémyesek számára sokkal többet ér, ha a cég sikeresnek, egészségesnek, domimánsnak látszik, mert az ebből fakadó árfolyamnyereség sokszorosa lehet annak, amit a cég sikeres reáltevékenységéből fakadó profitból osztalékként realizálható.

-

Petykemano

veterán

válasz

Alogonomus

#48412

üzenetére

Alogonomus

#48412

üzenetére

Talán félreérthetően fogalmaztam, amikor azt mondtam, hogy nem mondták konkrétumot. Azt akartam mondani, hogy hibákat, nyilvánvalóan félresikerült, vagy sikertelen, várakozásokhoz képest alulteljesítő tényezőket soroltál. Én viszont azt mondtam, hogy szép, hogy látjuk ezeket, de az korántsem egyértelmű - legalábbis számomra - hogy hol és mik voltak azok a stratégiai ballépések, amelyek nélkül az Intel még mindig, vagy legalábbis nyerőbb pozícióban lenne.

Raymond megemlítette a Raptor lake hiba fiaskót. Ami jogos, összességében tényleg rosszabb kihatása van, mintha kevésbé bátorak a frekbenciával és amiatt rosszabb picit az eredmény.

Te most azt mondod, hogy Bob Swan által kijelölt double-sourcing irány lett volna helyes. Ezzel kapcsolatban én is tettem az előzőekben néhány a te érveiddel szembenálló állítást, ezt nem ismétlem meg. Ez egy jó pont lehet, persze nyilván egyikünk se tudja, mi történt volna másként.

-

Petykemano

veterán

válasz

Alogonomus

#48408

üzenetére

Alogonomus

#48408

üzenetére

Az a baj, hogy nem mondtál konkrétumot.

Említettél pár tényezőt.

Az alder lake sokat késett a gyártástechnológia miatt, mire kiszenvedtek valami használhatót.

A raptor lake-nél már nem volt más út, mint tolni. Persze lehetett volna óvazosabban, hogy ne legyen botrány, de akkor az eredményebbek lettek volna rosszabbak.

Az Intel szerintem elsősorban a gyártástechnológián csúszott el. Szerintem elég nyilvánvaló, hogy viszonylag ritka a mérnöki csoda (Apple) és helyette mindent a gyártástechnológiablehetőségei határolnak be.Szerintem Gelsinger jól látta azt, hogy ezt kell felrázni és hogy valószínűleg a tsmc azzal húzott el, hogy nagyon sok partnercég dolgozik együtt a gyártástechnológián, az Intel tervező és gyártástechmológiai részlegei között meg ellentét volt, dobálták a problémát egymás közt, mint a forró krumplit.

Az Intel így is piaci első tudott maradni. Ha a termékeit leveszi a saját gyártástechnológiájáról, akkor annak kaszáltak. Viszont az USA gyártástechmológia stratégiai ágazat, arra kapták a CHIPS ACT pénzt, ami nélkül talán már rég kifogytak volna a cashflowból.

Lemaradtak a cryptóról és az elég jövedelmező AI-ról is. Pedig voltak felvásárlások is. Én Raja Koduri távozása óta ritkán hallok a One API témáról, pedig.valószínű, az az egyik legfontosabb komponens az AI-hoz.

Nehéz egyszerre hibáztatni a CEO-t azért, mert túl sok hangsúlyt fektetett egy területbe és hogy az pénztemető volt, mert lemaradt. Ha nem lenne ARC, akkor meg pont ugyanazért lehetne hibáztatni, hogy Brian Krzanich-ot, aki lelőtte az akkori gpu fejlesztéseket.

Félre ne érts, én nem állítom, hogy Gelsinger minden döntése jó és helyes volt, és azt se, hogy ne lettek volna hibákat, csak magamtól nem látom, hogy mik lehettek volna azok a stratégai irányváltások, amik meglépése, vagy meg nem lépése mellett az Intel nem lenne gondban

-

Petykemano

veterán

válasz

Alogonomus

#48406

üzenetére

Alogonomus

#48406

üzenetére

A hibás eredmények láthatók. De vajon mikor és mit kellett volna másként csinálni?

-

Petykemano

veterán

válasz

#90868690

#47901

üzenetére

#90868690

#47901

üzenetére

Szerintem csodásan sikerült a Lunar lake. Lehet kritizálnj a Strix Pointot, de azért ne tegyünk úgy, mintha ez a mobil/mini workstation kategória nem létezne, vagy nem bontogatná szárnyait az Apple égisze alatt évek óta és a Qualcomm nemrég debütált chipje képében.

A másik sarkalatos kérdés az ár szokott lenni. Lehetne például felvetni, hogy a N3-on készülő, bonyolultabb tokozási technikát alkalmazó Lunar lake előállítási költsége biztos drágább, mint az évek óta használt és finomított N5/N4.

De sajnos nem ezt fogjuk majd látni, hanem készülékek árait. És nem biztos, hogy abban reflektálódni fog a SoC költsége. Ha egyiken vagy másikon esetleg sokat spórolnak is, miért adná át direktben a fogyasztónak?

Sok esetben szerintem Intelhez készült designt alakítanak át amdhez, és ennek az átalakításnak a költségét a fogyasztóval fizettetik ki. (Tudtommal legalábbis az intelnek van olyan részlege, amelyik notebook tervezésben segít a gyártóknak)

Arról nem is beszélve, hogy az OEM számára is biztos fontos szempont az árazásban a skálázódás, vagyis hogy melyik készüléket milyen volumenben fogják rendelni/venni.Bármilyen szomorú is abból a szempontból, hogy az AMD tehet vagy nem tehet valamiről, de egyébként végeredményben tényleg azt kell nézni, hogy a célterület szempontjából a Legjobb teljesítményt adja, megfelelő üzemidővel és megfelelő áron.

-

Petykemano

veterán

válasz

Alogonomus

#47884

üzenetére

Alogonomus

#47884

üzenetére

Én ezt tökre nem tenném a szálak számától függővé.

Szerintem mindegy hogy mi egy adott MT teljesítményhez vezető technológia, ha a fogyasztás is.rendben van. A költség már az árazásban játszik szerepét, de azt a versenyhelyzet is befolyásoljaLehet, hogy nem erre akartad kihegyezni

-

Petykemano

veterán

válasz

Alogonomus

#47882

üzenetére

Alogonomus

#47882

üzenetére

Tóbbféleképpen lehet nézni.

Arra reflektáltam, hogy többekben felmerült, hogy egy ilyen csinos vékony notit nem a kimagasló MT teljesítménye miatt vesz az ember, ennélfogva a Strix point feleslegesen bír olyan számítási teljesítménnyel.(Mások persze egy Kraken pointot, ha csak az létezne, biztos a QC SDXE-hez méregetnék, hogy hát ma már, amikor lokálba fut az AI, egy egy kis extra kakaó elfér.)

-

Petykemano

veterán

válasz

Alogonomus

#47874

üzenetére

Alogonomus

#47874

üzenetére

Lehet, hogy a 4+4 konfigurációjú Lunar lake számára jobb szembeállíthatóságot és összehasonlíthatóságot jelent majd a 4+4 konfigurációjú Kraken Point.

-

Petykemano

veterán

válasz

FLATRONW

#47850

üzenetére

FLATRONW

#47850

üzenetére

"Pont az NV fog Intel gyártásra menni azok után, hogy jól megégették magukat a Samsunggal."

valóban úgy tűnhet, hogy megégették magukat, de...

1) ez valószínűleg inkább csak presztízsben mérhető, vagyis, hogy az AMD látszólag veszélyesen közel került teljesítményben. Viszont abu mondott valami olyasmit, hogy az nvidia csak a jó lapkákért fizetett és elég alacsony árat. És azt se zárnám ki, hogy akkortájt a konzolchipek mellett talán a samsungé volt a nagyobb kapacitást kínáló/lehetővé tevő ajánlat.

2) de ami a mondanóm lényege, hogy a Samsung gyártástechnológiája híres arról, hogy elsősorban sűrűségben tudnak lépést tartani, magasabb frekvencián viszont durván elszáll a fogyasztás. (Talán épp azért, mert nagyobb tranzisztorokat raknak sűrűbben)

Az Intel gyártástechnológia viszont épp ezzel ellentétes karakterisztikát mutat. Gondolj csak arra, hogy a raptor lake Intel 7 gyártástechnológián készül, ami a korábbi 10nm, tehát ez a TSMC nomenklatúrájához.viszonyítva 7nm-es osztály és mégis magasabb frekvenciát tud elérni vele az Intel CPU, mint az AMD. (Persze ebben nyilván nem kizárólagos faktor a gyártásechnológia)Szóval én egy olyat el tudnék képzelni, hogy a mainstream konzumer lapkákat, ahol nem tényező a reticle limit, az intelnél gyártsa.

-

Petykemano

veterán

válasz

Aljasvip

#47822

üzenetére

Aljasvip

#47822

üzenetére

Egy ismert jelenség, hogy az AMD a biztonságra játszik, vagyis akkora termékmennyiséget tervez (és ahhoz szabja a megrendelt wafer mennyiséget), amit az ismert piaci viszonyok között biztosan és lehetőleg jó marzzsal el tud adni. Ha valami nem jön össze, akkor is legfeljebb pár negyedévvel tovább árulnak valamit (RDNA2?), ha meg nagyobb a kereslet a vártnál, akkor örülnek a marzsnak. Nem kockáztat, nem próbál meg nagyobb mennyiséggel, alacsonyabb árréssel piaci részesedést szerezni.

Ennek nyilván van egy olyan oka is hogy ezt nem minden piacon lehet megtenni kis lépésekben. Elképzelhető, hogy akár 5-10x nagyobb mennyiség is kellhetne,.ami valóban komoly kockázatot jelent.

A Coreteksnek volt egy videója, amiben épp azt pedzegette, hogy Lisa Su-nak nagy köszönet és gratuláció mellett, azért, hogy felfuttatta a céget, át kéne adnia a székét valakinek, aki tovább tudja vinni, mert a biztonságra játszó lépésekkel örökre 2-3. Helyen marad a cég.

-

Petykemano

veterán

Számomra elég hihetetlen a hír. Már ha szó szerint vesszük.

Azt a részét érteném, hogy a Mali felfelé skálázását tűzték volna ki célul (vö: Strix Halo)

Az is érthető lenne, ha azt jelentették volna be, hogy AI gyorsító IP-t készítenek.Nyilván a sweet spot az az, ha ugyanazt az IP-t több piacon is tudod hasznosítani. De ezzel az nvidia és az AMD is küszködik.

Mindezt úgy, hogy

1.) Az Arm nem szokott chipeket gyártatni, csak IP-t állít elő, amit más chiptervező cégek felhasználnak saját célpiacit célzó elképzeléseik szerint

2.) A kártyákat nem is az AMD / Intel / nvidia gyártja, hanem további partnercégek. -

Petykemano

veterán

Igazad lehet abban, hogy elhamarkodott az ítélet.

Talán ott ment félre, hogy annyira hangsúlyozták, hogy a frekvenciával skálázódik csak.

Ami eleg valószínű, hogy a frekvenciávak kb lineárisan a cache mérettel meg kb logaritmikusan skálázódik.A ryzenek esetén nekem az az emlékszerű megfigyelésem, hogy az 5600X és 5600G közötti kb 10%-os gaming különbségért kb 45-55%-ban felel a frekvencia és 16MB vs 32MB L3$ különbség.

Ebből fakadóan 3-8MB cache különbség a 20-30MB magasságban valóban csupán 1-3%-ot magyarázhat -

Petykemano

veterán

Roppant érdekes teszt és eredmény: az Intel jelenlegi architektúrája esetén nem volna gyakorlati haszna, ha ők is 3D v-cache segítségével bővítenék az L3$ kapacitását. [link]

-

-

Petykemano

veterán

válasz

Alogonomus

#47487

üzenetére

Alogonomus

#47487

üzenetére

A Meta terve az, hogy lecseréli robotokra a felhasználóit.

De a viccet félretéve, Rehoboam-ot éppenséggel építhet. Mindenki Facebook tevékenységét logolja, arra egyenként épít egy-egy profilt és ezrével futtatja a szimulációkat, hogy pontosan belője, hogy ki mit fog tenni (kattintani) következőre. -

Petykemano

veterán

Az Amazonról is kikerült valahogy a mindfactory-hoz hasonló CPU eladási adat.

A minta mintegy 4x nagyobb. Irányait tekintve hasonlítos a mindfactory-hoz, bár kevésbé szélsőségesnek mondható.

[link] -

Petykemano

veterán

Korábban voltak olyan magyarázkodások, hogy a cowos vagy más advanced packaging eljárás túl drága, vagy túl kis kapacitással elérhető ahhoz, hogy konzumer termékben alkalmazni lehessen. Főleg most, hogy az AI miatt minden kapacitást felvásárolnak, arra fordítanak.

Vagy legalábbis az AMD részéről szoktak ilyenek jönni.

Aztán mindig jön egy hír, hogy lehetne azt nagyobb volumenben is, megérősen.

Jó, persze az se mindegy, mikor. Tudjuk, hogy az ilyen összeszerelő kapacitádokat nagy erőkkel bővítik és A későbbiekben az AMD is több terméket fog ilyen módon összerakni.

Nekem az nem áll össze, hogy vajon mi indokolja ezt az együttműködést? Az nvidia nem tud CPU-t tervezni? Biztosan tud. Arra gondoltam, hogy talán valami olyasmiről lehet szó, mint a Samsung+AMD esetén, csak az nvidia nem IP-t, hanem a mediatek által készített SOC-hoz köthető lapkát ad. De a hír CPU-ról szól.

-

Petykemano

veterán

válasz

huskydog17

#47310

üzenetére

huskydog17

#47310

üzenetére

Az Adamantine várós.

-

Petykemano

veterán

válasz

huskydog17

#47192

üzenetére

huskydog17

#47192

üzenetére

Így fogalmaztál:

"Az AMD mérnökei viszont itt megveregethetik saját vállukat, ugyanis sikerült elérniük, hogy az RX7900XTX gyorsabb, mint az RTX 4090. Igaz, az általános sebessége a játéknak annyira pocsék, hogy még viccnek is rossz. Legalább majd az AMD marketingesei megveregethetik a mellüket, hogy "a mi kártyáink gyorsabbak Starfield-ben, mint a konkurencia".

[...]

A baráti VRAM igény viszont számomra is kellemes meglepetés, itt sokkal rosszabbra számítottam az AMD-től."A megfogalmazásod számomra azt a benyomást kelti, mintha azért ugyan a Bethesdát okolod, hogy minden szempontból ennyire rossz minőségű lett a játék, de azt, hogy az Nvidia kártyák - kivételesen - alulteljesítenek önmagukhoz, a szokásoshoz képest, ezáltal - kivételesen - alulmaradnak az AMD kártyákhoz képest, azért az AMD-t tartod felelősnek.

Abból szűröm ezt le, hogy ebben a két kiemelt bekezdésben 3x jelenik meg felelősségi kontextusban az AMD márkanév és egyszer a Bethesda.Erre lehet mondani, hogy hát ha az AMD emberei ott voltak, akkor bizonyára van közük/kezük abban, hogy olyan lett az optimalizálás, amilyen és hogy lehet benne szándékosság is.

De ha ezt feltételezzük, akkor akkor ugyanez elmondható a számos TWIMTBP és Gameworks játékról is, ahol az Nvidia emberei voltak jelen?

Ha esetleg tévednék, vagyis valótlanul fedeztem fel soraidban cinizmus és valójában tényleg megdícsérted az AMD mérnököket és marketinget, akkor elnézést kérek.

Szerintem az van, hogy ez egy "Hát ez nem történthet meg!!!" típusú felfújt ügy, ami remek alkalmat teremt arra, hogy rossz színben lehessen feltűntetni az AMD-t.

Bocsánat, elnézést, az Nvidia nem ismert el semmit hivatalosan.

Arra nézve, hogy a Starfield megfelelő driver-optimalizációjához nem volt meg a szükséges dedikált erőforrás MLiD a forrásAmi számomra azért hihető, mert az alulfogyasztás miatt láthatóan nem GPU limitbe ütközve teljesítenek alul, így itt meg lehet majd találni idővel a hiányzó teljesítményt.

Esetleg az vetődhetne fel, hogy nem az Abu által sokat emlegetett CPU limitről van-e szó, vagyis hogy az Nvidia drivernek nagyobb a CPU overheadje. Elképzelhető, hogy a driver megfelelő optimalizálása részben arról is szól, hogy miképp lehet a driver feladatait konzisztens módon többszálasítani és ez nem minden játéknál működik egyformán. Tehát lehet, hogy amikor megérkezik az a driver, ami jobban teríti a munkát a CPU szálak között, hirtelen meglesz a kártyák hiányzó teljesítménye is.

Még annyit tennék hozzá, hogy olvastam egy olyan állítást a játékról, hogy nincs benne brightness control. Nem tudom, hogy ez vajon a játék jellegéből fakadóan van-e így, de aki ezt a megjegyzést tette, olyan módon rótta fel, hogy ha még ez sincs beépítve a játékba (nem is beszélve microlagekről és egyéb polírozatlanságokról) akkor nem csoda, hogy a fejlesztőknek nem volt idejük (büdzséjük) az FSR-on kívül más skálázót beépíteni, vagy más GPU-gyártókkal együttműködni a megfelelő optimalizáláson.

-

Petykemano

veterán

Szerintem nem az.

És attól, hogy időről időre van egy-egy játék, ami különböző körülmények miatt esetleg jobban fekszik az AMD-nek, attól még nem lesz az. Még ha annak szánták is. Egy fecske nem csinál nyarat.

Persze jó lenne, ha ez az összehasonlítás trendszerűvé válna, (Persze lehetőleg nem amiatt, mert az nvidia elhanyagolja drivert.) de nem tartunk ott.Tudjuk hogy a kártyák látható teljesítményét nem kizárólag a hardver és a driver (most az egyéb szoftvertől tekintsünk is el) adja. Annak része a játékok optimalizációja is. Ezt volt hivatott szolgálni a TWIMTBP, a gameworks. És nyilván ugyanerre apellál az AMD a konzol irányból megközelítve. Ebben az nvidia nagyon jó. (Ebben is)

-

Petykemano

veterán

válasz

huskydog17

#47182

üzenetére

huskydog17

#47182

üzenetére

Nvidia vezet - Nvidia király

AMD vezet - AMD szabotázs!!444!Aham...

Mindazonáltal tényleg értem a kritikát a játék teljesítményével kapcsolatban. De ehhez mégis mi köze van az AMD-nek?

Ráadásul az Nvidia már elismerte, hogy nem volt elegendő erőforrásuk a day0 driver megfelelő elkészítéséhez.

-

Petykemano

veterán

Szerintem ez egyszerű és egyértelmű is: 50% perf/w volt a cél ("ígéret") és ezt végül sajnos nem sikerült elérni. Úgy kellett összeválogatni, hogy zen3 vs zen4 rendszerben valahogy ki lehessen mutatni.

Persze nyilván ez relatív. Nyilván az RDNA2-höz képest jobb. A kedvezőtlen megítélés a saját célokhoz és a konkurencia előrelépéséhez viszonyítva alakul ki. Nem rossz, csak elmaradást jelent a várakozáshoz képest és lemaradást a konkurenciához képest.

A Navi33 különösen stagnálás, legfeljebb refresh érzetet kelt. Persze értem, hogy az árazása sokkal kedvezőbb lett, mint a Navi23-é volt, de azért szerintem ez főként a piaci viszonyoknak köszönhető, nem az architektúrának.

Egyébként abban egyetértek, hogy azon a sávon belül van, hogy árazással lehet kedvező pozícióba helyezni, és a nevezékben is kár volt az XTX

-

Petykemano

veterán

Szerintem több szempontból is furcsa ez a specifikáció.

A PS5-ben módosított Zen2 magok vannak. A zen2 2019-ben, a PS5 2020-ban jött ki.A PS5 pro a pletykák szerint 2024 végefelé jön. Ehhez képest a Zen5 2024 elejére várható. Ez alapján lehetne benne akár Zen5 mag is. Persze értem, hogy egyáltalán nem a CPU A legmeghatározóbb része.

Különös az is, hogy a nem kifejezetten jól sikerült RDNA3-at nevezik meg, mint grafikus egység. Főleg amiatt, mert ha jól emlékszem, a konzolok valahol az RDNA1 és RDNA2 között vannak tudásban és képességben. Rossz nyelvek szerint az RDNA2 épp azért lett jó, mert beépítették a konzoloknál kitalált és kipróbált remek elképzeléseket (Persze tudjuk, hogy hermetikusan el vannak zárva egymástól a külsős és belsős csapatok)

Az RDNA2 abban az évben jelent meg, mint a PS5. 2024-ben - elvileg akár - meg is jelenhet az RDNA4. Illogikusnak tűnik RDNA3-ra építeni, vagy RDNA3-nak nevezni azt, amire építik.

Vagy... akár úgy is mondhatnám, hogy ez a specifikáció akkor lenne logikus a PS5 körülményeit alapul véve, ha a PS5 Pro még idén év végén megjelenne.

Ami végülis lehet, hogy nem is olyan elképzelhetetlen figyelembevéve, hogy nemrég volt PS5 árvágás.

(Megkockáztatom, hogy akár az is lehet, hogy az RDNA3 egy sajnálatosan félresikerült tesztága a PS5 Pro-nak)Ami viszont különös az az, hogy miért nincs benne infinity cache egyáltalán?

Monolitikus formában 4/5nm-en ez szerintem olyan 300-350mm2 lehet.

Illetve olvastam egy olyan véleményt, hogy valószínűbb, hogy sima GDDR6, mint GDDR6X, mert fontos, hogy legyen megfelelő verseny és ellátás a beszállítók között.

-

Petykemano

veterán

Abu tévedhetett is. Félreérthetett valamit, vagy akár neki is hazudhattak. (megjegyzem, emlékeim szerint MLiD is arról számolt be, hogy az AMD RDNA2 készletei alacsonyak)

De megkockáztatom, hogy esetleg nem volt-e - legalább részben - tudatos döntés az, hogy így alakult.Az szerintem nyilvánvaló, hogy az RDNA3 fejlesztési célja leginkább a chipletezés és az a chipletezésből az elszálló wafer árak mellett nyerhető versenyképes költség és kapacitás elérése lehetett.

Azonban a GPU bányászat lecsillapodása, valamint egy általános recesszió beköszönte miatt a wafer árak - különös tekintettel a TSMC N5/N4-re - végülis jelen információink alapján nem szálltak el. Bár nem beszéltek rendkívüli olcsóságról, de az év eleji meglehetősen alacsony N6/N7 kihasználtság alapján azért lehet azt feltételezni, hogy TSMC ajánlhatott kedvezményt az AMD-nek a gyártósorok kihasználtságának fenntartása érdekében.

Mi történt tavaly év végén? A Zen4 elsőre kissé borsos árazása meglepő gyorsasággal esett be. Nem csak a meglehetősen hamar megjelenő X nélküli változatok, hanem néhány hónap elteltével az X változatok is elég kedvezményes árazással mentek.

Ezek alapján szerintem történhetett akár az is, hogy az AMD látva azt, hogy az RDNA3 a kialakult piaci helyzetben (csökkenő gyártósori kihasználtság, stagnáló wafer árak, stb) nem igazán lesz képes kamatoztatni azokat az erősségeket, amilyen céllal készült. A Navi31-et kiadták, mert az ténylegesen nagyobb teljesítményre volt képes, mint az addigi csúsznak számító Navi21, de minden más szinten az RDNA3 architektúra és a chiplet, az N5 wafer használata nem hozott volna kézzelfogható (költség)előnyt, ezért úgy döntöttek, hogy

- inkább tovább gyártják az RDNA2 lapkákat - megkockáztatom - azon a kedvezményes áron, amit esetleg a TSMC ajánlott

- a lefoglalt N5 kapacitásokat pedig Zen4 lapkák gyártására fordítják és a nagyobb gyártási volument olcsóbb áron fogják kínálni, ami ugyan kisebb marzzsal, de összességében nagyobb profit volumennel fog járni.Persze nem tudjuk.

De ebben a szcenárióban fel kell tenni a kérdést: vajon mi változhatott, hogy most (mégis) kiadják. -

Petykemano

veterán

válasz

Busterftw

#46884

üzenetére

Busterftw

#46884

üzenetére

Az Nvidia próbálkozásának célja valójában nem annyira a gamer piac kímélése volt, hanem hogy a lapkákat úgy értékesíthesse a nyilvánvalóan túlkeresletet eredményező bányászat felé, hogy amikor a bánya beomlik, a kiáramló nagy mennyiségű használt kártya ne döntse be az új - akkor esetleg már újgenerációs lapkákra épített - kártyák piacát.

Ezt a célt szolgálta a dedikált kártya, amin nincs display kimenet és némiképp tweakelve volt a BIOS. De miért venné ezt az újraértékesíthetetlen kártyát a bányász a gamer kártya helyett? Na ezt a kérdést volt hivatott megválaszolni a gamer kártyákra kitalált korlátozás.

Nem tudom pontosan, hogy a lapka, vagy' a dram vagy egyéb alkatrészek jelenthették-e a szűk keresztmetszetet, de abban az időben valószínűleg mindent eladtak, amit le tudtak gyártani. Nincs okunk azt feltételezni, hogy a szűk keresztmetszetet a display kimenetek jelentették volna, ennélfogva biztosak lehetünk benne, hogy a miner kártyák nem valamiféle "kvóta feletti" mennyiségként jelentek meg a piacon.

Az, hogy az nvidia legalább próbálkozott valamivel, valójában egy zöldszemüveges mítosz (kábé olyan, mint hogy az eredményes kormányzati intézkedések hatására csökken az infláció)

Az nvidia ezzel nem a gamer piacot, a gamereket akarta megmenteni, hanem saját magát a később beomló áraktól és eladási mennyiségektől. Ebben nincs mit számonkérni az AMD-n. -

Petykemano

veterán

válasz

Yutani

#46848

üzenetére

Yutani

#46848

üzenetére

Szerintem azt ők is érzékelik, hogy a kurrens "big thing" a grafikában a raytracing, a next big thing meg a neural rendering. Jelentsen utóbbi akármit is a gyakorlatban.

De hiába erős a pozíciójuk a konzol piacon, a PC piacon nem ők diktálják a trendet.

A dolog érdekessége, hogy - elvileg - nagyon sok dolgot az AMD (+ a konzol gyártók) dikálnak (az AMD-nek). Szerintem az FSR is valahol egy ilyen dolog. Valahol mintha azt olvastam volna... Nehezemre esne elhinni, hogy ne tudtak volna jobb algoritmust megalkotni - ugye nem egyedül, hanem a MS-tal és/vagy a Sony-val. De vélhetően fontos szempont volt, hogy legyen takarékos az erőforrásokkal.Azon gondolkodtam, el, hogy vajon az AMD tudott-e volna hozni - egy nem a konzol piacról származó, ott be nem vetett - jobb felskálázó megoldást, ami

1.) jobb minőséget biztosít, mint az FSR, aminek persze - mint azt a XeSS esetén láttuk sokszor nagyobb erőforrásszükséglet az ára

2.) A nagyobb erőforrásszükségletet úgy próbálja tompítani, hogy fixfunkciós/FPGA elemeket épít be. (ilyen hardverelemet be lehetne építeni a konzolba is)Szerintem nem lenne lényegesen jobb a helyzet, mint most. Az AMD tulajdonosok - legalábbis a frissebb kártyával rendelkezők - örülnének a jobb minőségnek, amit az új kártyások többletterhelés nélkül élvezhetnek.

De az Nvidia tulajdonosok akkor is vernék a tamtamot, hogy ők nem hajlandók bevállalni sem a rosszabb (hagyományos) FSR minőséget, sem a többletterhelést, ami a jobb minőséggel jár, és amihez nincs megfelelő hardverelemük, hanem igenis a fejlesztő építse be a nekik járó DLSS-t. -

Petykemano

veterán

válasz

hokuszpk

#46754

üzenetére

hokuszpk

#46754

üzenetére

Ha ezzel arra akarsz utalni, hogy mint felskálázó technológia kizárólag DLSS-t tartalmazó játék is bőven van, akkor azt kell mondjam, látom, nem érted.

Amikor egy játékban csak DLSS van, akkor az nincs is. Ha van, akkor sincs. És ha mégis van, akkor az jól átgondolt, megalapozott és helyes üzleti döntés a fejlesztő/kiadó részéről. Ahhoz az Nvidiának semmi köze. Az Nvidia még örülne is, ha a felhasználók saját szemükkel tudnák összehasonlítani mennyivel jobb a DLSS ugyanabban a játékban. Annyira támogatja és bíztatja a partnereit erre, hogy éppenhogy csak embert nem ad rá, hogy saját maga tegye meg. De a fejlesztők befolyásmentesen önérdekből meghozott saját döntésével nem csak maguknak spórolnak egy csomó időt és energiát, amit a következő játékok jobb minőségére fordíthatnak inkább, hanem valójában azzal, hogy a jobb minőséget építik be, felhasználókat is megkímélik a választás terhétől. A felhasználók pedig értékelik a minőséget és a kényelmet.

De amikor egy játékban csak FSR van, az nyilvánvalóan az AMD bűnös és sötét összeesküvésének, lefizetésének és ravaszkodásának eredménye, amivel a felhasználók érdekeit figyelmen kívül hagyva ellehetetleníteni igyekszik a szegény, ártatlan, és fair Nvidiát. Kifejezetten büntetni akarja a szar, semmirekellő felskálázó technikájával az Nvidia felhasználókat. Ez teljesen nyilvánvaló. Olyan ostobák! A pénzt, amit erre az értelmetlen gátlástalan piacrombolásra fordítanak (ráadásul eredménytelenül), költhetnék inkább arra, hogy jobb hardvert és szoftvert készítsenek. Szánalmas, amit amit csinálnak.

Így már érted?

-

Petykemano

veterán

válasz

bobalazs

#46752

üzenetére

bobalazs

#46752

üzenetére

Azt sajnálom, hogy nem állnak bele, hanem maszatolnak.

Az exkluzivitás jelensége nem ismeretlen a piacon. Pontosan tudjuk, hogy az Nvidia is kínált olyan segítséget, eszközöket, amivel a gyakorlatban exkluzivitást vásárolt. Ha nem pénzben, akkor természetben (munkával, eszközök rendelkezésre bocsájtásával) fizet azért, hogy a saját hardverét helyzetbe hozza.

Hajdanán több technológia is volt különböző effektek megvalósítására. Az NVidia a haj emulációjára a Hairworks-öt kínálta, az AMD-nek meg valami TressFX nevű megoldása volt. Különös, hogy nem emlékszem egyetlen olyan esetre sem, hogy egy Hairworks beépítő játék kapcsán hírverés, patália lett volna abból, hogy az AMD vásárlók számára miért nem építik be egy alternatív, az AMD hardver számára kedvezőbb, jobb eredményt nyújtó technológiát.

Amennyiben az AMD - hasonló módon - tényleg exkluzivitást vásárolt a játékban az FSR-re, akkor abba szerintem bele kellene állnia. Nem igaz az, hogy a DLSS-nek csak előnye, az FSR-nek pedig csak hátránya van: még ha árnyalatnyi különbséget fel is lehet fedezni a DLSS javára, az FSR mellett szól, hogy bármilyen hardveren fut. Ezt egészen nyugodtan lehetne mondani. Abban is biztos vagyok, hogy ha ilyen exkluzivitás létrejött, az nem szól örökre.

Nem megalapozott magánvéleményem az, hogy nem az FSR2-ről lehet szó, hanem az FSR3 első implementációjáról szól és annak szerettek volna megágyazni.

-

Petykemano

veterán

az AMD versenyellenes tevékenységet űz [link] máglyára vele!

-

Petykemano

veterán

Befejezték az Aurora telepítését. [link]

novemberre lesz eredmény, amit 2EFlop/s fölé várnak.Az egyetlen szépséghibája, hogy míg a Frontier 23MW-ot fogyaszt 1.2EFlop/s mellett, és az El Capitan szintén 2 EFlop/s melletti várható fogyasztása 30MW lesz, addig az Aurora 60MW körül lehet.

-

Petykemano

veterán

Bocs, lehet, hogy volt már róla szó...

Azon gondolkodtam el, hogy állítólag a DLSS jobb képminőséget ad, mint az FSR. Nekem semmilyen alapom nincs ezt az állítást kétségbe vonni. Csak elgondolkodtam, hogy vajon ennek mi lehet az oka.

Ez szimplán az alkalmazott algoritmus által eredményezett - szoftveres - különbség? Vagy elképzelhető, hogy lenne mód az AMD számára is, hogy valamilyen olyan módon fejlessze az algoritmust, ami megfelelő - dedikált - hardverelemek megléte esetén jobb képminőséget és/vagy teljesítményt nyújtana, csak épp sem az AMD kártyák nem tartalmaznak ilyen dedikált hardverelemet, és az FSR-ral kapcsolatos policy is az, hogy bármilyen hardveren futhasson, ennélfogva azzal kapcsolatban, hogy milyen trükköket lehetne bevetni a minőség javítása érdekében, limitált.Az RDNA3-mal kapcsolatban korábban volt egy olyan várakozás, hogy az AMD dedikált gyorsítókat épít(het) amitől az FSR amd hardveren futtatva gyorsabb/jobb lesz, de eddig ennek sincs semmi jele.

Viszont ha dedikált hardverelem nélkül, bármilyen GPU-n futó algoritmussal nem lehet a DLSS-nél jobb megoldást kivitelezni, és ennélfogva a vásárlók hozzáállása az, hogy megveszem a jobb felskálázó megoldást biztosító GPU-t, akkor az AMD miért nem csinál valami olyasmit, hogy az FSR bár default minden hardveren megy, de AMD hardveren mégiscsak jobb - és annálfogva a DLSS-szel versenyképesebb?

-

Petykemano

veterán

válasz

paprobert

#46667

üzenetére

paprobert

#46667

üzenetére

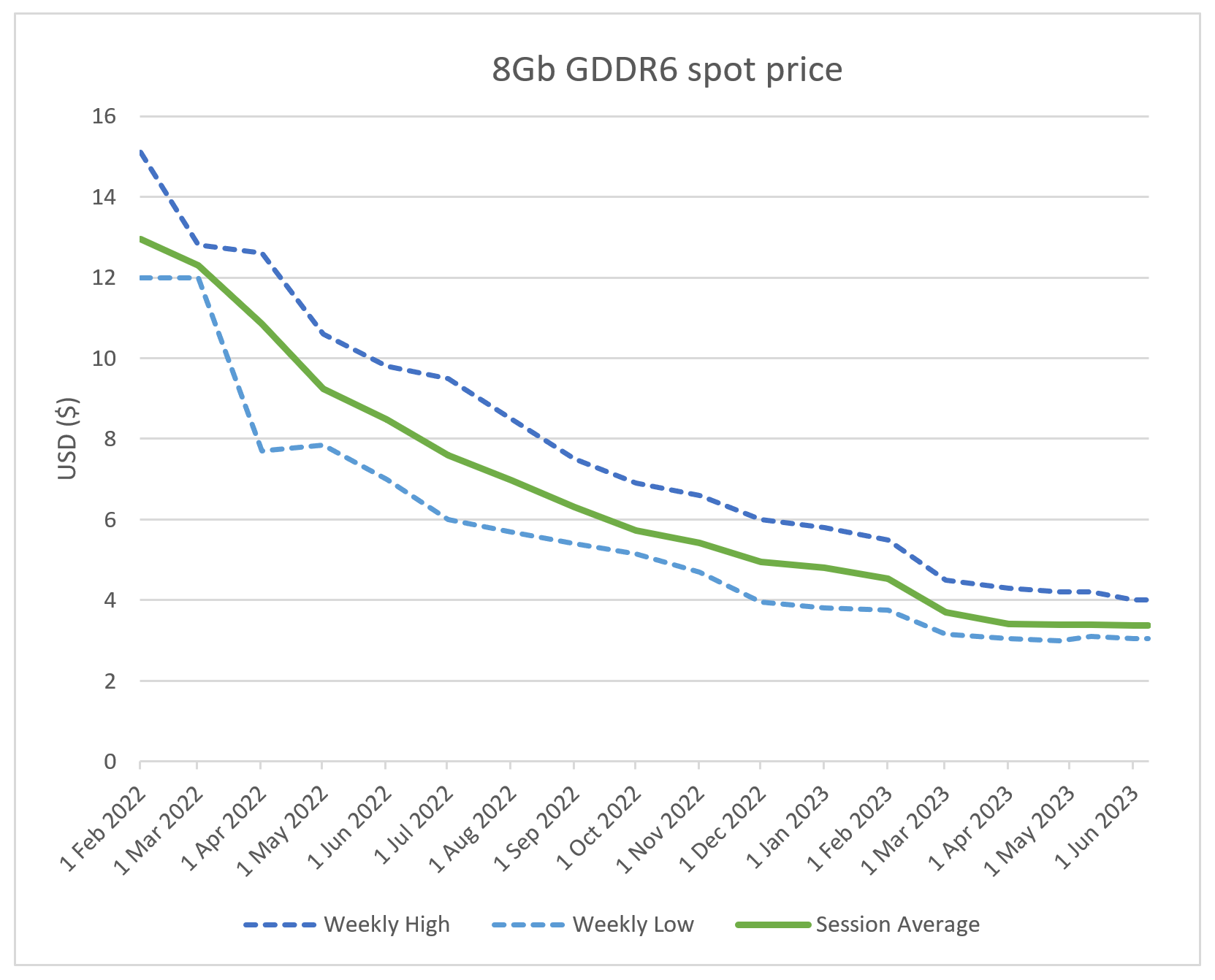

én el tudom képzelni. 2022 elején még azért enyhén leszálló ágban, de azért a csúcs közelébe volt még a bányászat.

Én nem gondolom, hogy az elképesztő GPU árak kizárólag a boltokban kialakult hiány miatt alakult ki. Értem ez alatt azt, hogy a GPU alkatrész gyártók is tervezett mennyiségekkel és árakkal dolgoznak, ha a bolti GPU szűkösség miatt növelni akarják a termelést akkor a tervezetthez képest GDDR6-ból, rézből, alumíniumból is hiány alakulhat ki, ami azok árát is felveri.

Az ábrán a felszálló ág nem látszik, csak a leszálló.Én úgy vélem, hogy az RTX 3000 széria msrp árai nem voltak eleve, tervezetten kamuk. Persze az AIB kártyák ára mindig jellemzően magasabb, de nem annyival, mint amilyen különbség 2020 végétől elkezdett kialakulni. A kialakult extrém kereslet az alkatrész árakra is nyomást gyakorolt, azok árát is felverte és én úgy már tényleg nem fért bele az msrp-be. Nem fogjuk sosem úgy megtalálni, hogy ki járt jól, hogy egyvalakire rá lehet mutatni. Az egész láncban a tervezőtől, félvezetőgyártótól a réz, alumínium szállítótól, összeszelőn át a szállítóig és boltig mindenkinek vastagabban fogott a ceruzája.

Valahol azt is érthetőnek tartom, hogy egy ilyen váratlan és vélhetően nem tartós piaci sokkra nem reagáltak a hivatalos msrp árak folyamatos igazításával.

Úgy fogalmaznék, hogy az akkoriban a hivatalos $329 ellenére $500-600-ért árusított RTX3060-ba valószínűleg tényleg $180 értékben kerülhetett VRAM.

-

Petykemano

veterán

-

Petykemano

veterán

FSR2 és DLSS2 összehasonlítása egy a videoenkódolás minőségét értékélni hivatott szoftver, a VMAF segítségével. Elég érdekes [link]

-

Petykemano

veterán

Ez a részvényárfolyam változás annyit jelent, hogy a részvényvásárlóknak mondjuk 5-10%-a azt gondolja, hogy az AI nagyon jó üzlet lesz, sokat lehet rajta majd keresni, tőzsdézők fennmaradó 90-95%-a pedig azt, hogy az AI által keltett tőzsdei hullám lesz nagyon jó üzlet, amin sokat lehet majd keresni.

-

Petykemano

veterán

válasz

Devid_81

#46537

üzenetére

Devid_81

#46537

üzenetére

Lapkagyártásra talán nem használhatatlan.

De packaging terén a Samsungtól még semmilyen gyakorlatban megvalósított terméket nem mutatott, de megkockáztatom, hogy komolyabb termékbejelentést sem láttunk. Az élen járó TSMC-t az Intel követi a Foveros és EMIB nevű technológiákkal, de ezek is azért elég ritkán használt eljárások, amikkel szerintem az Intel nagyon sokat szívott az elmúlt években.A chiplet és a packaging a jövő, sőt a ma egyik nagy dobása. Ebben a Samsung szerintem még a lapkagyártásnál is jobban le van maradva, kevesebb tapasztalattal rendelkezik. Nem tudom, hogy a TSMC vajon 3rd party hozott lapkát képes és/vagy hajlandó csomagolni. Amennyiben nem, akkor a Samsung tényleg csak monolitikus budget termékek gyártására lesz használható.

Így szerintem legfeljebb mankónak nevezhető, alternatívának sajnos nem.

-

Petykemano

veterán

Elmondom mégegyszer a véleményem a Steam HW Survey-ről.

Szerintem ez nem nem statisztikai célú hardver-konfigurációkra vonatkozó felmérés.

Ha kizárólag a hardverről szólna, akkor a Steam-nek elegendő lenne az ÁSZF-ben regisztrációkor elfogadtatni, esetleg valamilyen rejtett beállításnál opt-out módon kikapcsolhatóvá tenni.

A Steamnek nem jelent gondot milliárdnyi felhasználói fiókot játékokkal, játékidővel, fórumokkal, üzenetekkel, stb nyilvántartartani, nem gondolhatjuk azt sem, hogy problémát jelentene ezeknek a felhasználóknak a hardveréről nyilvántartást vezetni.Egyrészt, azt, hogy ezekben az időről időre felmerülő felmérésekben való részvételi szándékot újra és újra ki kell nyilvánítani, azt sokkal inkább az indokolhatja, hogy nem csupán a hardvert mintavételezik, hanem más felhasználói szokásokat is és az is valószínű, hogy ezeket az adatokat a Steam nem kizárólag magának gyűjti, hanem megrendelésre.

A megrendelt felmérésnek pedig nyilván nem terjed ki az összes Steam játékosra, hanem van egy a megrendelő által meghatározott célcsoportja. Pl: XYZ játékokkal játszó ilyen és olyan jellemző hardverrel rendelkező ilyen és ilyen korcsoportú, vagy földrészen elhelyezkedő játékosok

Ez lehet a magyarázata annak, hogy miért szerepelhet gyakrabban felmérésben az, aki AAA játékokkal, vagy nagyon népszerű játékokkal játszik. (pl most a CSGO2 érkezését megelőzően CSGO)

És a megrendelő általi célcsoport meghatározás lehet a magyarázata arra is, hogy miért kerülhet bele célcsoportba gyakrabban Nvidia felhasználó: mert maga megrendelő is azt gondolhatja, hogy annyira kevés az AMD felhasználó, hogy spórolás végett inkább kiszűri.Az eltérő célközönséget célzó megrendelt felmérések hardveres adatait aztán a Steam közzé teszi.

Valójában persze nincs értelme. Mindenki jobban járna, ha az ÁSZF-ben elfogadtatnák, hogy a játékosok hardvereit statisztikázzák és abból készülne a SHWS.

-

Petykemano

veterán

Természetesen aki $1000-1500-os kártyákban utazik, az nagyonis tapasztalhat komoly előrelépéseket, a maga módján "jóljárást", de már egy pár éve érzékelhető, tapasztalható, hogy mennyire nincs fejlődés (perf/$) a mainstreamben.

Ez kissé szokatlan jelenség, hiszen azt szoktuk meg, hogy a prémium árrést a prémium minőséget/teljesítményt nyújtó termékeken szedik.Úgy szoktam mondani: A mainstream az új prémium

A 3DCenter készített pár grafikont.kár, hogy a 10=>20, valamint a 20S=>30 váltás nem szerepel az ábrák között.

-

Petykemano

veterán

válasz

Yutani

#46403

üzenetére

Yutani

#46403

üzenetére

Érdekes...

Az elmúlt hetekben cikkeztek arról, hogy jön a CSGO2, ami tulajdonképpen a CSGO frissítése lesz. Új motort kap. Nem mélyedtem el benne, csak találkoztam vele.

március 22-én cikkezték, hogy már tesztelik. [link]

a steamDB alapán a legtöbbet játszott játékok között szerepel a CSGO és a top10-ben is toronymagasan a legtöbbet játszott és emellett az egyetlen, ami az elmúlt 3 hónapban elég meredeken emelkedett játékos szám tekintetében. [link]

Nem lehet véletlen.

Ugyanakkor az ugrásszerű növekedés márciusban történt, miközben a CSGO játékosok száma már januártól elkezdett emelkedni. Ha csupán arról lenne szó, hogy más platformon játszó játékosok vették felő a CSGO-t, akkor szerintem hasonló graduális emelkedést kellett volna látnunk a HW Survey adataiban is.Azt gondolom, hogy a Steam Hardware Survey nem annyira véletlenszerű, esetleges, mint amilyennek gondoljuk.

Szerintem a Steam Hardware Survey-nek nem az a célja, hogy közérdekű statisztikai adatokat biztosíton a publikum számára amolyan érdekességképpen. Ez csupán mellék ág.

Szerintem az alapvető célja, hogy a játékfejlesztőket szolgálja ki technikai adatokkal. Kvázi mint a piackutató/közvélménykutató cégek felmérései. A játékfejlesztő cégek megbízást adnak a Valve-nek, hogy mérje fel az általuk meghatározott, megcélozni kívánt játékosok hardverét, hogy ők arra tudják optimalizálni a játékukat.

Ha történetesen egy-egy ilyen megrendelt felmérés célcsoportba tartozol, máris feldobódik a survey-ben való részvétel.Még én sem olvastam el sosem, de egészen biztosan benne van, hogy a felmérésben való részvétel jóváhagyásával azt is jóváhagyod, hogy valamilyen third party szervezetnek átadják a gyűjtött adatokat, ami feltehetőleg nem csupán a hardverre, hanem használati szokásokra is kiterjed. Na ez már olyan személyes adat kezelése, amit minden alkalommal jóvá kell hagyatni.

Ha a Steam telepítve van a gépedre, akkor azt, hogy a profilod részeként tárolják a gép hardveres elemeit (amit ugye mi is látunk) az ÁSZF-be bele lehetne foglalni és nem hiszem, hogy bárkit is különösebben zavarná, hogy a Steam ezt tárolja, és adatbázist épít. Ehhez szerintem egyáltalán nem lenne szükség külön részvételi jóváhagyásra minden egyes alkalommal. Semmi értelme nem volna a kis létszámú mintavételre sem, vagy tényleg azt gondoljuk, hogy ha a Steam képes többmilliárd profilt kezelni, akkor problémát jelentene ezekhez a profilokhoz hardver-adatokat is tárolni és abból statisztikát készíteni és ezért kénytelen véletlenszerűen beválogatni felmérésbe néhány tíz vagy százezer profilt? Már önmagában a fent linkelt steamDB-n elérhető adatok, hogy ki mikor mivel játszik bizonyítja, hogy hogy ugyan dehogy.

Úgyhogy valószínűleg az történhetett, hogy CSGO2 megjelenésének küszöbén a Valve végzett egy felmérést a potenciális CSGO2 játékosok között és ezek az adatok jelenhettek meg most a steam HW survey-ben.

-

Petykemano

veterán

> Annál több esze van az nV vezetésének...

Őszintén szólva én nem is annyira értem a Raja Koduri körülötti személyi kultuszt.

Vannak szereplők, akiknek a nevéhez tényleg lehet valami jellegzetes és pozitív érdemet csatolni. De szerintem Raja Koduri nem ilyen, szerintem nem lehet elmondani róla, hogy letett volna az asztalra bármilyen olyan eredményt, amiért az az ismertség és tisztelet kijárna neki, ami körüllengi. Nyilván amit csinál, az nem one-man show, sokat számítanak a körülmények. Lehet mondani, hogy az AMD-nél a fiskális háttér, az Intelnél meg a tapaztalati háttér nem volt meg ahhoz, hogy Koduri az itt-ott eltöltött 5-6 év alatt kompetitív eredményt tudjon felmutatni. Persze azt is nézni kell, hogy lehetett-e volna jobban csinálni - lehet, hogy helyett más még ennyit se tudott volna összehozni abból, ami rendelkezésére áll. Emiatt elég nehéz megítélni, hogy ő most elrontotta, vagy épp emberfeletti erővel hozott össze a lehetőségekhez képest kimagasló eredményt, vagy bárki más is pont ugyanerre lett volna képest.Annyi biztosnak tűnik, hogy pl David Wang nevéhez azért jóval kevésbé kötődnek - akár pozitív, akár negatív előjellel - az RTG eredményei, én se azt nem látom, hogy az RTG megtáltosodott volna, s azt se, hogy Raja Koduri emberfeletti képességei tartották volna egyben a divíziót. Ez alapján Raja Koduri személye és jelentősége szerintem túlértékelt volt.

-

Petykemano

veterán

A Samsung is régóta ígérgeti a GAAFET alapon készülő 3nm osztályú eljárását.

Elvileg a 3LPE elvileg kész, a 3LPP viszont csak jövőre készül el. Végülis nem tudom, használja-e valaki. Az a gyanúm, hogy sajnos nem.

Az, hogy az Intel 20A-n történt már tapeout nem biztos, hogy többet jelent ugyanennél, vagy annál, mint az eső 10nm-es lapkák, amelyek után még 2-3 évig dolgozni kellett az eljáráson, mire versenyképes kihozatalt és frekvenciát elért.A TSMC látszólag "bealudt" a GAAFET-tel. persze elvileg az ő részükről a finfet alapú N3 tudatos döntés volt, de már az elején lehetett tudni, hogy jelentkeznek problémák és hogy szélesebb körben majd csak az N3_ variánsok lesznek használva. Egyébként ha tudatos döntés volt, nem tudom, mit nyertek azzal, hogy finfeten csináltak N3-at. Úgy értem, hogy kijöhet a végén az, hogy végül mindenki elkínlódik a GAAFET-tel 2025-2026-ig, mire használható lesz, és közben kinek-kinek GAAFET vagy finfet alapon volt többé-kevésbé használhatatlan 3nmo osztályú eljárása.

mostanában volt szó az Arrow Lake-ről. Asszem az 2024-ben lesz esedékes, de ebben lehet, hogy tévedek. Mindenesetre a jelenlegi pletykák szerint az IGP és a CPU rész is TSMC N3-on készülne. Persze lehet, hogy a végső döntés a gyárástechnológiák állapota alapján mostanában születik meg, de önmagában az, hogy az amúgy még nem túl jó kihozatallal rendelkező TSMC N3 versenyben van, nem arra utal, hogy az Intel 20A piacra kész lenne (jövőre)

Persze nem akarnám leírni az Intelt, lehet, hogy az Intel 20A mondjuk egy esetleg két évvel is megelőzi végül az TSMC N2-t. Az biztos, hogy nagy lesz a gyártástechnológiai turbulencia a következő 2-3 évben. Kérdés, hogy mennyivel lehet jobban kijönni belőle úgy, hogy ha chipletekre bontod az architektúrádat? Mármint hogy már ez is egy rugalmassági tényező lehet, hogy nem egy egész chipet, hanem csak annak részeit kell erre vagy arra a gyártástechnológiára duplán tervezni backup céllal.

-

Petykemano

veterán

válasz

huskydog17

#46340

üzenetére

huskydog17

#46340

üzenetére

> Ezt mi alapján szűrted le?

Abból, hogy "akciós" Intel ajánlatokat linkeltél azzal a konnotációval, hogy szerinted ez milyen kedvező és jó ajánlat. Szerintem ez triviális. Szintén szerintem nem gond.

> Akkor legközelebb nem írok oda átszámított árakat

Ha jól értelek, akkor azt mondod, hogy Te csak fogtad és átváltottad forintra az amerikai webshop dollárban számolt árait tekintet nélkül arra, hogy egyébként az amerikai webshopokban látható árakhoz képest általában milyen "extrákkal" terhelt áron szokott megérkezni a magyar (vagy európai) boltba a termék.

Ha így történt, akkor remélem sikerült felhívnom a figyelmedet, hogy ez nem ennyire egyszerű és legközelebb a forintosított árak számítása során figyelembe veszed az "extrákat", amik egy reális képhez vezetnek azzal kapcsolatban, hogy a fogyasztó milyen árakkal találkozhat magyar üzletben, vagy tényleg nem számítod át ilyen egyszerű, de félrevezető módon. -

Petykemano

veterán

válasz

huskydog17

#46336

üzenetére

huskydog17

#46336

üzenetére

Engem nem zavar, hogy az Intel termékeket próbálod népszerűsíteni.

Valóban, láthatólag csak az Intel igyekszik felkavarni az állóvizet, ezért megérdemlik a hírverést.Én csak arra kívántam felhívni a Te és mások figyelmét, hogy az általad alkalmazott átszámítási mód (nem számítva persze a kézközön, vagy ilyen félhivatalos tranzit-házhozszállításos módszereket) nem helyes és ne legyenek túlzott várakozásai a magyar boltokban tapasztalható árakkal kapcsolatban és ne is kezdje el a "felárral dolgozó, lehúzó magyar kisker bandában" keresni a boltban látott és az általad beharangozott árak közötti különbségre a magyarázatot.

Szintén a Neweggen az AMD-től lehet kapni $230-ért RX 6600-at, ami valahol az A750 táján van nem számítva az RT-t. Ha ezt lehetne kapni annyiért, ahogy Te számoltad, már megvettem volna. Talán innen ered a rugózás a 27% árkülönbözeten.

-

Petykemano

veterán

válasz

huskydog17

#46333

üzenetére

huskydog17

#46333

üzenetére

Én úgy tudom, hogy az amerikai tagállamokban eltér a forgalmi adó mértéke, de bevallom, nem tudom, hogy az értékesítő székhelye, telephelye, az értékesítés helyszíne (raktár?) vagy a vásárló lakcíme alapján kell-e rászámolni.

Én úgy tudom, hogy részben amiatt adnak meg nettó árat, merthogy nem mindegy, hogy melyik államból nézed, na meg azért is, hogy ne őket, hanem az államot hibáztasd, hogy mennyivel többet kell fizetni még az adóért is. (Valószínűleg Magyarországon is lenne csodálkozás, ha a cégek levonhatnák a megjelenített árból az áfát és azon túl a mindenféle forgalmi különadókat)

Ebből nem is csinálnék hitvitát, de az is biztos, hogy az USÁban csak 5-10%-os a forgalmi adó, nem 27%. Tehát ha az msrp-be a vám és disztribúciós költségeket (ide értve a vámokat) bele is kalkuláljuk, már csak ennyivel is drágábbnak kellene lennie.

Nemrégiben $249 lett az A750 hivatalos ára.

Általában az árukeresőn 116-120e között szoktam látni. 27%-os áfával és 360Ft-os USD árral számolva nagyjából ki szokott jönni.

Egyébként most épp 116eFt és 366, szinte fillérre kijön a $249.Én csak ezért gondolom, hogy az általad számolt forint ár túlságosan alacsony.

(Itt csak zárójelben hozzátenném, hogy ha valaki a kereskedői nyereséget keresné, akkor nem feltétlenül gondolnám, hogy ez a 116e valamiféle ügyeskedős ár lenne, mert a $249 az ajánlott fogyasztói ár, amiben elvileg már belekalkulálva kellene lennie a szállításnak, esetleg a vámnak is. Tehát elvileg a magyar kisker/nagyker nem a Neweggtől rendeli $249-ért)

-

Petykemano

veterán

válasz

huskydog17

#46331

üzenetére

huskydog17

#46331

üzenetére

Szerintem Magyarországon ehhez a dollárban számolt árhoz még hozzá kell adni a 27%-os áfát + párszázalék vámot.

-

Petykemano

veterán

szegény AMD pont akkor nem nőtt meredeken, amikor az Intel és az Nvidia.

Persze az is kérdés, hogy egyáltalán tudtaj-e volna nagyobb volumenben értékesíteni, vagy nem is lett volna több kapacitás?

Mondjuk legalább vissza sem esett.Elnézést a tájékozatlanságomért, de kiváncsi lennék a Broadcom mivel szerepel ezen az ábrán?

-

Petykemano

veterán

Újabb kínai GPU

14nm

GTX 1650

[link] -

Petykemano

veterán

válasz

Petykemano

#46263

üzenetére

Petykemano

#46263

üzenetére

Ez még ide tartozik

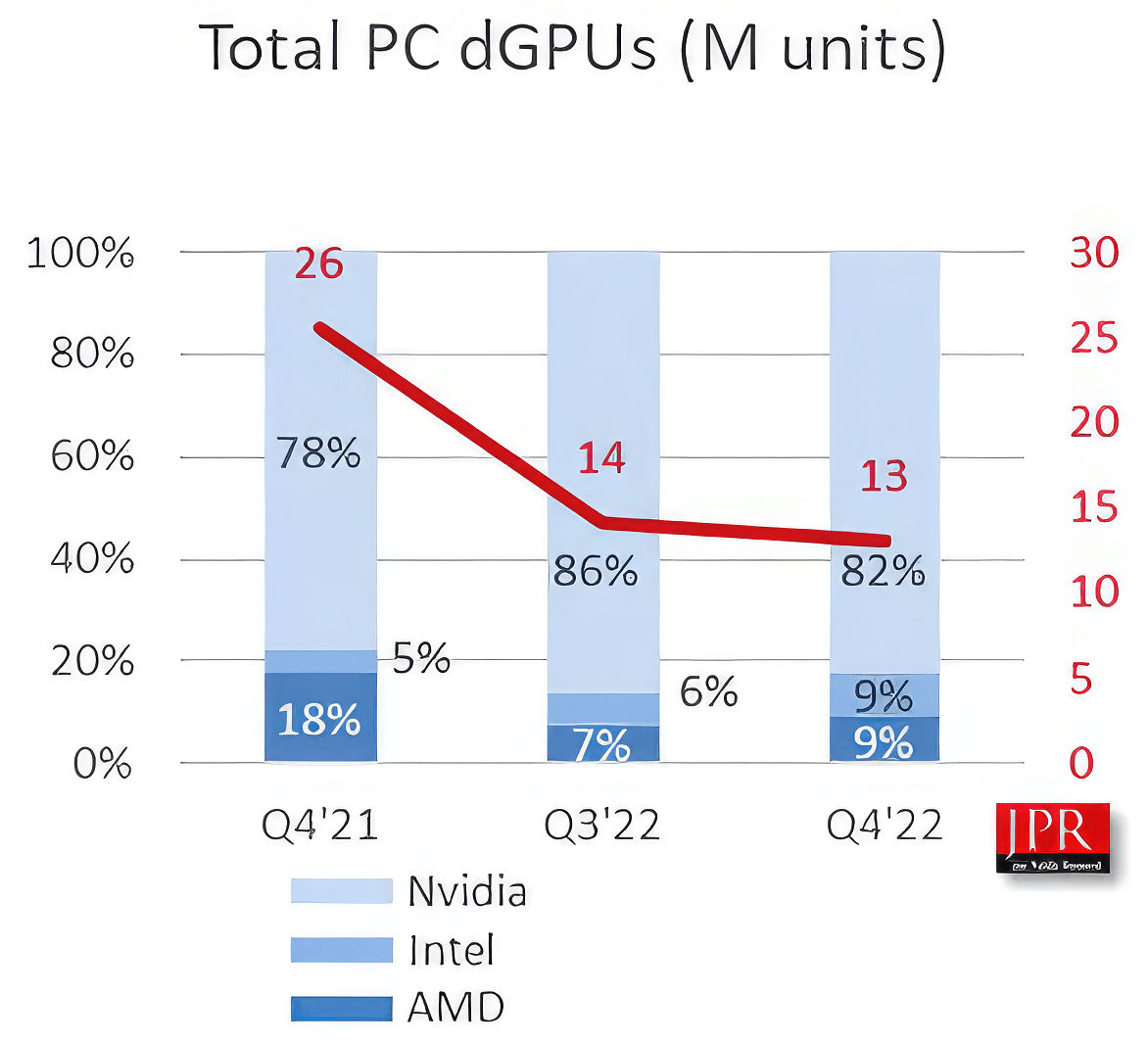

Az valószínű, hogy az Intel nem a dobozos dGPU-k piacán szedi össze a 9%-os részesedést, hanem notebookokban, prebuilt gépekben.

Abu az AMD részesedésének visszaesését azzal magyarázta, hogy felhagytak a 14nm-es Polaris 14 gyártásával. De végső soron akkor nem igazán sikerült pótolni.

Így vagy úgy, de egyelőre úgy néz ki, hogy az Intel belépése valóban nem az Nvidia részesedésébe harapott bele, ahogy azt az alapján várni lehetett, hogy milyen gyakori az Intel+Nvidia kombináció, hanem az AMD részesedésébe. -

Petykemano

veterán

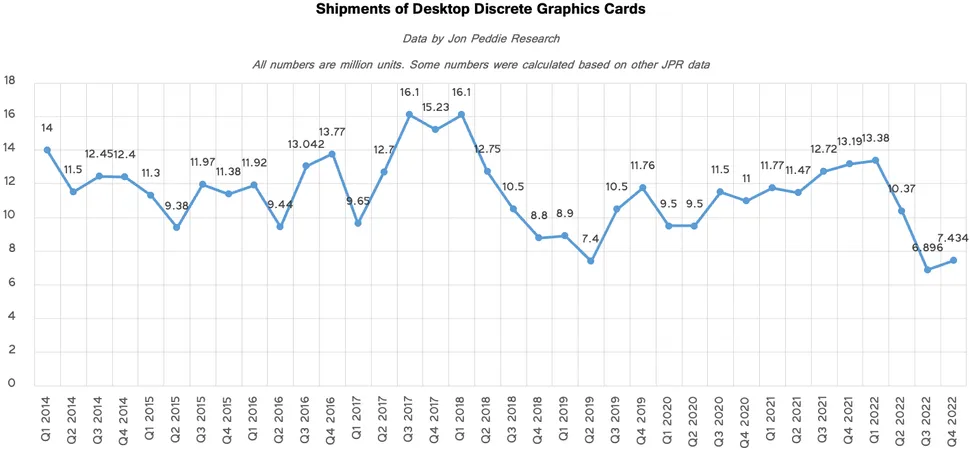

JPR (Jon Peddie)

Q4-re megállt a GPU eladások esése.

Persze tegyük hozzá:

- az összes elemzés szerint a mostanihoz képest decemberben még jobb árak voltak.

- ünnepi szezon volt. Az elmúlt évek legalacsonyabb volumenét produkáló ünnepi szezonja. Ehhez képest a Q1 20-25%-os visszaesést szokott produkálni. (Kivéve persze 2020-2021, amikor a kriptovalutáknak minden nap karácsony volt)Persze recesszió, infláció és szankció is van, de az elmúlt 8 év egészét tekintve szerintem kijelenthetjük, hogy nem volt igaz, hogy a GPU vásárlók zsebében van pénz és el is lehet kérni ugyanazért többet - mármint persze abban az értelemben, hogy piac jellegének, volumenének átalakulása nélkül.

Ez különösen a 2017 előtti időszakra érvényes, amihez képest a 2022Q3-Q4 a kb dupla mértékű áraival feleakkora volument produkált.

Itt gyorsan hozzá is teszem, hogy 2017 és 2018 természeten egy outlier, mert 2017 táján is volt kriptoboom, amit alacsony árak követtek. Máskülönben az Nvidia 2018-ban a Turinggal kezdte az áremelési ciklust, ami meg is látszott a volumenen, amit csak a 2019Q3-ban elérhetővé vált RDNA és arra válaszul kiadott Super széria által teremtett verseny pezsdített fel újra. -

Petykemano

veterán

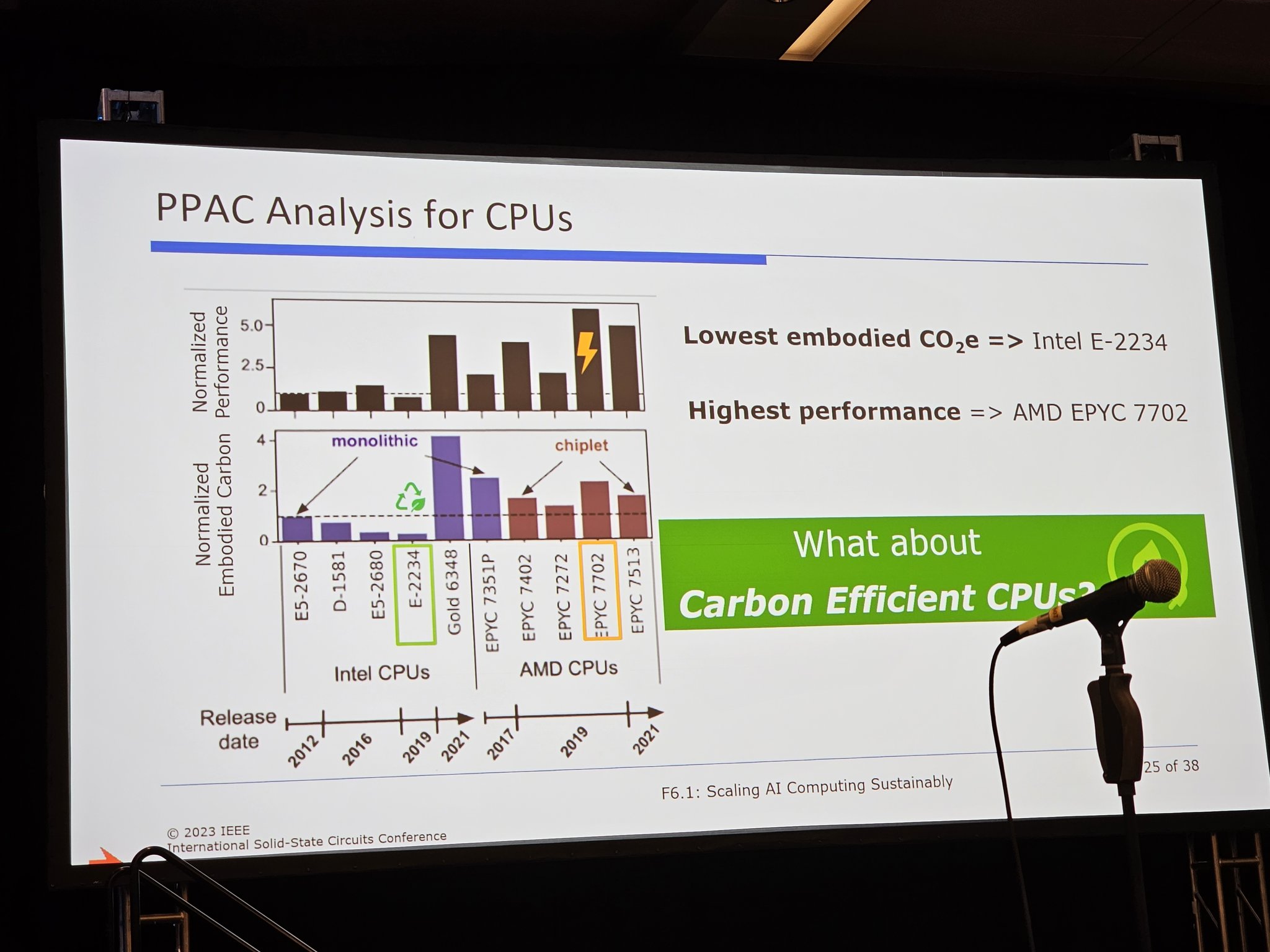

TCO2 - Total Cost of Karbonlábnyom

Elvileg a Meta állt elő egy "újfajta" (legalábbis eddig ritkán firtatott), zöld mutatóval, ami a környezezettudatosságot emeli egy olyan szintre azáltal, hogy a szerver infrastruktúra választásban nem csak az energiahatékonyságot és az számításhoz szükséges energia karbonlábnyomát, hanem már az adott szerver chip előállításához szükséges CO2 kibocsátást is figyelembe veszi.Ezen mutató alapján a kompakt monolitikus CPU-k a legkörnyezetbarátabbak, míg a chipletekből összeállított verziók pazarlók, környszezetszennyezők.

A "TCO2" egy új komolyan veendő irány, egy valóban fontos szempont, amely meghatározhatja a jövőt,

vagy ez szerver/cloud-mogulok új szeszélye, egy új, zöld buzzword, vegánság a techpiacon

vagy ez az új Intel marketing stratégia (ami aligha lehet, mert az utolsó két (?) termékkel ők is vastagon érintettek)

vagy valaki a Metánál próbálja ügyesen elsikálni az elhibázott választást?

vagy a Meta próbálja magát zöldre festeni? -

Petykemano

veterán

Amd vs Nvidia driver problémák - számokban

[link]Tldw

Ha a professzionális felhasználást kivesszük a képből, Nvidia driver problémából összességében valamivel több van, azonban ha a problémákat lebontjuk súlyosság/megoldhatóság szerint, akkor az AMD esetén valamivel több a nagy hatású, megkerülhetetlen probléma, míg az Nvidia esetén a közepes hatású probléma előfordulási aránya nagyobb. Persze nagyságrendi különbség nincs.

A kutatás egyértelműen, számokkal támasztja alá, hogy az AMD driver ugyan valamivel több fejfájást okozhat, de az a percepció, hogy az "Nvidia driver egyszerűen csak jó, az AMD driver meg szar" nem megalapozott.Az AMD driver talán valami hasonló jelenség áldozata lehet, mint amit a covid vakcinák esetén lehetett megfigyelni: az Astrazeneca oltásról futótűzként terjedt, hogy vérrögképződést okozhat, ezért olcsósága ellenére hamar elfordultak tőle más oltóanyagok felé. Már akkor is felvetődött, hogy az ilyen hírek felfújása a konkurens oltóanyag beszállítók érdekében állhat. A versenyben maradt oltóanyagokról pedig még manapság is derülnek ki, hogy egyébként azok milyen súlyos, akár halálhoz vezető mellékhatásokkal járnak (pl szívizomgyulladás) Valójában tehát egyik sem kockázatmentes, de a pánikkeltéssel sikerült az egyik oltóanyagot teljesen lejáratni.

-

Petykemano

veterán

válasz

Yutani

#46234

üzenetére

Yutani

#46234

üzenetére

Pedig a jelenség nagyon hasonlatos ahhoz, amit az 5500XT 4GB esetén lehetett látni.

Nem láttam ilyen gyártó és felbontásonkénti bontásban prezentált VRAM igény táblázattal, de élek a feltételezéssel, hogy a 8GB-ba épphogy nem fér bele. PIcit kilóg. A picit kilógást a PCIE még tudja kompenzálni, de mivel a PCIe lassabb a kellettnél, ezért a kompenzációs hatás is enyhe.

Ugyanez történt a 4GB az 5500XT esetén is, csak ott a 4GB volt ez a határ. -

Petykemano

veterán

árak: [link]

eléggé stagnál minden. Továbbra is.

A nyár vége felé volt egy kis esés és ennyi.Ami csak azért érdekes, mert - ahogy a videoban is elhangzik - ha az új generáció tetejét úgy vezeted be, hogy a magasabb teljesítményért magasabb árat is kérsz, akkor az semmilyen nyomást nem fog helyezni a korábbi generációs / lejjebb levő termékek árazására.

És végülis ez látható.Ami csak azért érdekes, merthogy arról volt szó, hogy hát az Nvidia biztos azért szabott meg az Ampere kártyáknak ilyen magas árat, mert elképesztően nagy készletek terhelik (b. szerint ez nem igaz már, Abu szerint a készlet valószínűleg lapka formájában az Nvidia raktáraiban csücsül és a partnerek nem rendelik) amin először túl akarnának adni.

Vajon elégedettek lehetnek a mostani eladásokkal?

Azt gondolhatják, hogy sem régi terméket leárazva, sem új terméket nem föléárazva nincs értelme kiadni, mert úgyis mindenki megvásárolta már a maga kis GPU-ját és senki nem rohanna úgyse a boltba?Vajon mikor érhet véget az elvileg átmeneti "csak az Ampere készlet kifuttatásáig" tartó feláras időszak?

Vajon bődületesen sok még a készlet? vagy épp azért emelkedtek enyhén az árak decemberhez képest, mert fogyóban van? -

Petykemano

veterán

válasz

Yutani

#46223

üzenetére

Yutani

#46223

üzenetére

Vajon

- ez a gémer community-t célozza amolyan extra feature-ökkel, vagy ez a gamer közösségen túlnyúló piacra, általános célra irányul?

- Ha utóbbi, akkor ehhez venned kell egy 100.000-500.000Ft-os videokártyát (vagy notebook esetén hasonló értéknövekedéssel kell kalkulálnod), vagy ez majd nemsokára a CPU-k részét képező IGP vagy más AI accelerator meg fogja oldani?

Vagy zárt rendszer lesz és ilyen feature-ökre rá lehet építeni egy Nvidia eszközbrandet? (lásd: Apple)

- És vajon hogy teszik teljesítményfüggővé? Másként megfogalmazva: milyen előnyök (vagy épp hátrányok) érhetnek ilyen felhasználási célok esetén kisebb vagy nagyobb teljesítményű kártya használata mellett? -

Petykemano

veterán

válasz

Busterftw

#46192

üzenetére

Busterftw

#46192

üzenetére

> miert lenne ez az Nvidia sara?

Ha Nvidia kártyával tapasztalunk valamilyen problémát, az a MS hibája, az api hibája, az optimalizálatlan szoftver hibája, a third party szoftver hibája.

Ha AMD kártyával tapasztalunk valamilyen problémát az az AMD driver hibája.> AMD-nel ha nem dupla annyi volt az entry, de sokkal tobb.

Én nem állítottam, hogy melyik cégnél van több vagy kevesebb.

Még csak azt sem, hogy mondanám, hogy a hibák mennyiségének 20-30-50%-kal magasabb mennyisége ne jelenthetne ez ennél lényegesen nagyobb eltérést a vásárlási hajlandóságban.Csak azt a kérdést feszegetem, hogy miért van az, hogy az emlékezetben az marad meg, hogy az Nvidia hibátlan, az AMD driver meg bughalmaz?

És hogy vajon ennek oka lehet-e az, hogy például az AMD találgatósba, vagy a redditre mindig eltalál valaki valami AMD-vel összefüggő problémáról hangoskodni, az NVidia találgatósba meg nem. -

Petykemano

veterán

Normál körülmények között nem szoktam az ilyeneket felkapni. És nem is célom kereszteshadjáratot űzni.

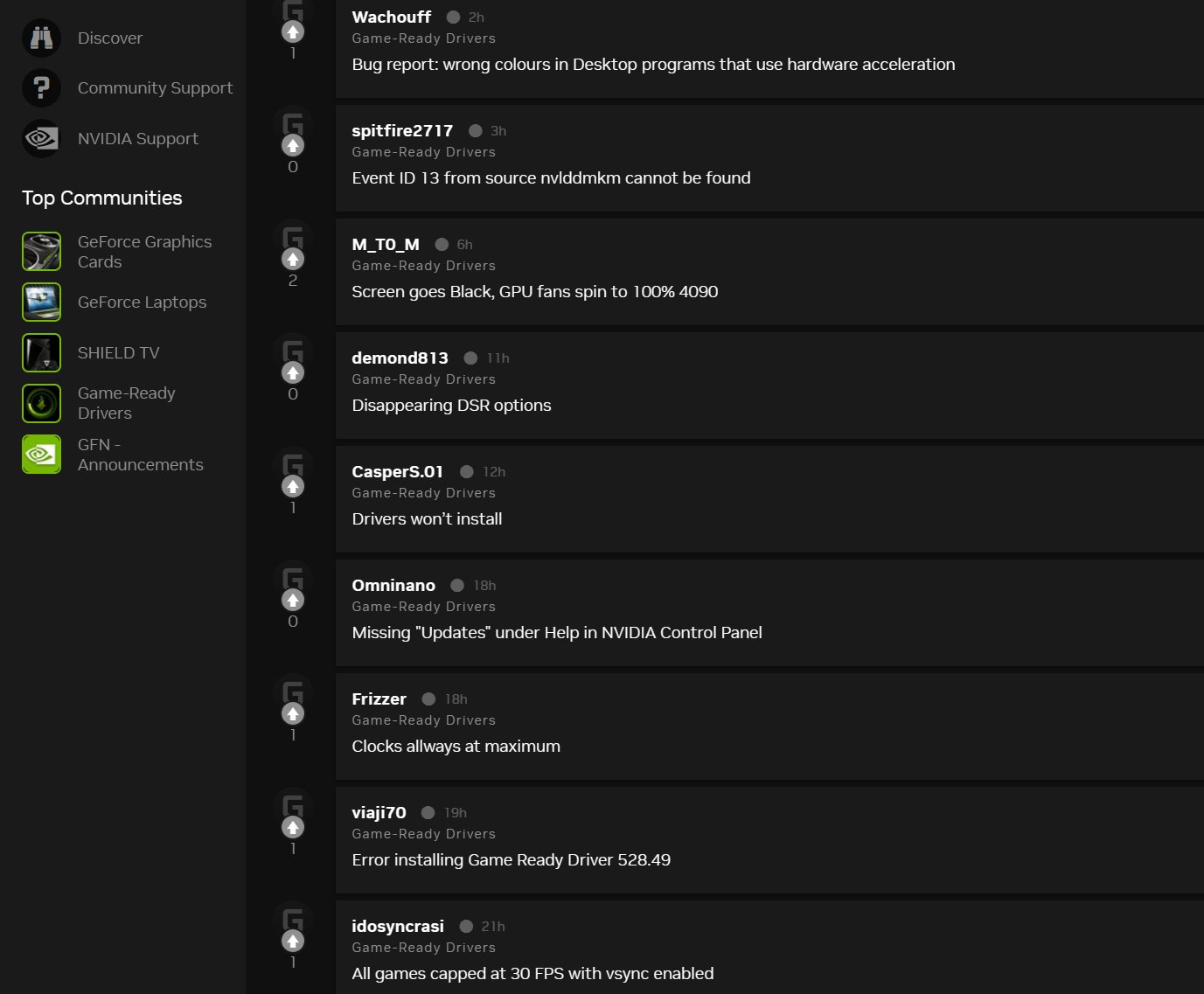

Csak volt jómúltkorjában ez a téma az AMD találgatósban lényegében arról, hogy miért őrződik meg az emlékekben jobban az AMD hibái és miért felejtődnek el az Nvidiáé és hogy ezzel összefüggésben vajon igaz vagy hamis percepció-e az, hogy az Nvidia drivere jobb és/vagy kevesebbszer tartalmaz hibát, mint az AMD? Pontosabban megfogalmazva, hogy tartalmaz-e az AMD driver annyival több mennyiségű, minőségű hibát vagy annyival gyakrabban, hogy az indokolja a piaci részesedést közötti hibát. [link]

Azóta már azt is megállapítottam, hogy természetesen az AMD találgatósba be lett doba lelkes, de elégedetetlen AMD rajongók által, hogy nem jött két hónapja driver, meg hogy elhasal az AMD a varázslós játékban RT alatt és szörnyű.

De érdekes módon az Nvidia találgatósban még egyetlen lelkes, de elégedetlen Nvidia rajongó sem hőbörgött azon, hogy az felhasználói élményét rontotta az Nvidia bughalmaz drivere discord használat közben.

az RDNA2 driverfrissítés megérkezését követően felmerült problémák kapcsán Ismét fellángolt a vita. Mivel nekem szembejött ez, fenti téma köré mementóként álljon itt ez a két gyűjtés:

[link]

Ide idézném Fless szavait is:

"Amíg egy kicsit is tájékozottabb OEM menedzser az AMD drivergondjai miatt síró emberkéket lát..."Nem végeztem számossági összehasonlítást, hogy vajon AMD driver probléma miatt síró emberek a redditen, vagy az Nvidia drivergondok miatt az Nvidia fórumán síró emberek lehetnek-e többen.

Lehetséges volna, hogy a Geforce Experience regisztrációhoz kötött használata valójában intelligens damage control mechanizmus, amivel az NVidia betereli a saját fórumába a panaszokat ahelyett, hogy azt szétkürtölnék a redditre?Mivel azt nem is merném feltételezni, hogy esetleg az Nvidia irányában elkötelezettek járnának sírni a redditre az AMD driverproblémái miatt, ezért feltételezem az AMD-nek nincs ilyen fóruma, ahol a problémákat lehetne jelenteni/megosztani a közösséggel?

-

Petykemano

veterán

BestBuy price cuts (MSRP → new price):

GeForce RTX 3090 Ti: $1999.99 → $879.99

GeForce RTX 3080 Ti: $1199.99 → $719.99

GeForce RTX 3080: $699.99 → $419.99

GeForce RTX 3070: $599.99

GeForce RTX 3060 Ti: $399.99

GeForce RTX 3060: $329.99 → $299.99

[link]Elszigetelt jelenség? Végkiárusítás?

Lehet valami oka a mozgolódásnak? -

Petykemano

veterán

válasz

paprobert

#46161

üzenetére

paprobert

#46161

üzenetére

Én inkább úgy mondanám, hogy egy álló óra is naponta kétszer a pontos időt mutatja.

Ami pedig Abut illeti...

Azért nehéz kérdés - szerintem - mert nem mindig egyértelmű (talán saját maga számára sem), hogy amiket mond, amilyen álláspontot képvisel, az a szakma (grafikus szoftverfejlesztők) álláspontja, vagy az AMD mondja tollba. -

Petykemano

veterán

Nézd, én nem mélyedtem el ennyire a DXR rejtelmeiben, és hogy varázsol-e az Nvidia vagy sem.

Abu sokat szokta szidni a DXR-t. HSM most azt állítja, hogy a jelenlegi szabványon kívüli megoldásban a memóriára nézve jóval kevésbé pazarlóan lehet megoldani. Én elhiszem.

Én azt az egy részét értem az AMD hozzáállásának, hogy egy (szerintük) rossz RayTracing implementációhoz nem akarnak hardveres gyorsítót készíteni.

De....

Az eddig sosem működött, hogy az AMD hoz egy "jobb" megoldást és csak mert jobb az terjed. Pontosabban lehet, hogy a GPUk hőskorában, amikor még volt 30-40%-os piaci részesedése volt ilyen. De már a tesszeláció esetén is az történt, hogy az AMD formabontó módon betette a hardverbe, különösebben senkit nem érdekelt (úgy értve, hogy nem készült olyan szoftver, ami ezt használta volna, és hátrányba került volna emiatt az Nvidia), aztán amikor az Nvidia meghozta a saját megoldását a hardverbe, akkor meg még itt-ott kicsit meg is nyomták a használatát.

Az AMD bizonyára sokmindent el tudott intézni, ki tudott könyökölni fű alatt (Mantle), de ahhoz, hogy te hozol valamilyen újdonságot a hardveredben és az arra írt szoftverekkel előnyhöz jutsz (hátrányba kerül a versenytársad) mielőtt még a versenytársad behozná a lemaradását, piaci penetráció kell.

Ennek megfelelően nekem semmilyen illúzióm nincs afelől, hogy ha és amennyiben a későbbiekben beigazolódik, hogy az AMD megközelítése a programozhatóságról volt a helyes megközelítés, azon is, akkor is, abban is az Nvidia lesz majd a zászlóvivő. Abu majd hiába mondja, hogy 5 éve pofázom nektek, hogy a fixfunkciós hardver zsákutca, majd az lesz mondva az Nvidia fanok részéről, hogy azért kellett a fixfunkciós hardver a hőskorban, mert a kártyákban nem volt még akkor elég számítáci kapacitás. És végül ebben is az Nvidia lesz a nyerő.

-

Petykemano

veterán

> L2 miért nem egészen ugyanaz

Nem ugyanaz a funkciójuk, ok. Akkor azt mondod, hogy a ez a compute shaderen futó bejárás azért nem működne jól a méretében közel ugyanakkora L2$-sel rendelkező Nvidia kártyán, mint a GPU cache rendszertől némileg távolságot tartó L3 victim cache-től eltérően, mert utóbbit nem szemeteli tele.

Hát nem tudom. Nem állítom, hogy ne lehetne oylan felhasználási módot találni, amire az egyik jó, de a másik elvérzik tőle, de az eddigiek alapján eléggé kiegyenlítettnek tűnik a meccs.Lehet, hogy ez lesz az első use-case, amin az Nvidia féle L2$ elhasalna, de ha szerinted úgyis implementálják a DXR-féle utat is, akkor igazából mindegy.

-

Petykemano

veterán

> Ami miatt hatékonyabban gyorsítótárazható is lesz egyből a BVH struktúra.

Ha csak az AMD rendelkezne nagy méretű cache-sel, akkor érteném, de az Nvidia behozta a lemaradását az L2$ méretének megnövelésével.> Mivel Nv-n egyből ugrik a kötött fixfunkciós egységek használhatósága ekkor.

Ez alapján nagyjából olyan erősorrendnek kéne kialakulnia kb, mint RT mód nélkül, nem?

> Én arra számítok, az AMD mód jól fog futni, míg az Nv-re jönni fog egy hagyományos DXR alapú módMiért gondolod, hogy egy olyan játékban, ahol megcsinálják ezt a programozhatóságot, fognak még foglalkozni azzal is, hogy az Nvidia által prefereált de hardveres erőforrásokban pazarlóbb DXR irányt is implementálják, hacsaknem jár az egyébként komoly teljesítményelőnnyel - persze megfelelő VRAM kapacitás mellett?

-

Petykemano

veterán

> Érdekes lesz a Snowdrop2 is az AMD RT megoldásával.

Úgymond, nem lesz semmi.

Abu leírása alapján én azt szűrtem le, hogy a programozható eljárás abban segít, hogy ne legyen olyan nagy VRAM igénye az eljárásnak. Ebből ugyanúgy profitálhat majd AMD és NVidia kártya is. Elképzelhető, hogy mivel programozott, ezért az Nvidia fixfunkciós hardverei kevésbé/nem lesznek használhatók hozzá. Ez alapján talán egy hardvergyártók szempontjából kiegyensúlyozottabb RT teljesítmény jöhet ki.A "Semmi"-t tehát úgy kell értelmezni, hogy lehet, hogy szoftvertechnológia szempontjából egy hatékonyabb eljárás lesz, mint az NVidia által preferált mód, de mivel többletmunkával jár, ezért idővel ez is bekerül majd más "optimalizáció" jellegű kuriózumok sorába és mivel nem valószínű, hogy itt/emiatt az AMD átvenné az RT teljesítményben a dominanciát, ezért ez egy újabb ok lesz gúnyolódni azon, hogy "Abu technológia blablával ígérte, hogy az AMD átveszi a vezetést és nem lett belőle semmi" (miközben abu csak annyit mondott, hogy ez az eljárás hatékonyabb és az AMD emiatt ezt tartaná követendőnek)

-

Petykemano

veterán

Ezek is elmehetnek... [link]

-

Petykemano

veterán

válasz

Yutani

#46080

üzenetére

Yutani

#46080

üzenetére

Számomra rendkívül valószínűtlen ez a dolog, hogy ez az új 4090 máris megelőzi a 2 éve piacon lévő csúcs AMD kártyákat.

Engem nem lep meg.

Válságról válságra szűkülnek az erőforrások. A nyertes 10% (esetleg 20%) egyre nagyobb jövedelem és vagyon fölött diszponál (Természetesen a szupernyertes az 1%), a vesztes 80-90% pedig lesüllyed.Nem arról van szó, hogy egyre többen engedhetik meg maguknak a 4090-et, hanem arról, hogy azok, akik eddig is a legdrágább, legerősebb kártyát vették, egyre magasabb árat is megengedhetnek maguknak.

Mindig is volt és lesz is egy olyan réteg, amelyik pénz nem számít alapon a legjobbat vásárolja. Nem biztos, hogy a következő hónapokban ugyanilyen dinamikusan fog növekedni.

Viszont valószínű, hogy a következő, ami meg fog jelenni, az a 4070Ti.

A ciki majd az lesz, ha kétes ár/érték arányú 4080 a 7900XT és 7900XTX együttes részarányát is meghaladja majd.Vígasztaljon, hogy dinamikusan növekedett az RX 6600 és 6700XT részesedése is az elmúlt hónapokban, amik között lehetett találn jónak számító ajánlatot. Persze ez így is csak tizedére elég, mint amit pl a 3050 és 3060 család hoz.

(Ebből kiindulva természetesen ne legyenek illúzióink arról, hogy az előbb említett ciki helyzet be fog állni)

Persze tudjuk, hogy a Steam survey nem reprezentatív és beszámolók tucatjai szóltak már arról, hogy Nvidia kártyával valamiért 4-5x gyakrabban kérdez be a steam, de ettől függetlenül én azon lepődöm meg, amikor Abu ennek ellenére mondja, hogy az AMD több N5 wafert allokált csak GPU-ra, mint az Nvidia. Vajon hol vannak azok a GPU-k és miért nem jelennek meg a steamben?

(Természetesen nagy változást várni még akkor is irreális, ha abunak igaza van, mert a több wafer allokációból legfeljebb a JPR által mérhető piaci eladási részesedés lehet, míg a Steam HW survey piaci penetrációt mér, ami az elmúlt ~10 eladásainak minusz értékvesztés, forgalomból való kivonás eredőjének pillanatnyi állapotát mutatja.)

@bertapet11: Touché!

-

Petykemano

veterán

https://prohardver.hu/hir/tsmc_reg_nem_tortent_olyan_ami_iden.html

Kiváncsi vagyok, hogy a csökkenő kihasználtság kinek (a döntésének) fog kedvezni a végén.

Az Nvidia monolitikus chipeket gyárt. A monolitikus chip ugyanakkor teljesítményhez általában kisebb lapkát igényel, és kisebb késleltetést jelent. hátránya értelemszerűen az, hogy bizonyos méret fölött a gyártás a hibás chipek miatt drága (sok a selejt), bizonyos méret fölé pedig nem is lehet menni. Ráadásul a finfet technológia kimerülésével egyre kevésbé skálázódnak bizonyos típusú áramkörök, így a kisebb tranzisztor ellenére a lapkaméret csökkenése csökkenő hatékonyságú.

Az AMD a chipletek mellett tette le a voksát elég korán, hogy optimalizálja a waferhasználatot. Kisebb lapkák kevesebb selejtet, jobb válogatási lehetőséget biztosítanak és azáltal, hogy mindent a megfelelő gyártástechnológán készíthet, a waferfelhasználás is optimális lehet. Ez jelentheti azt is, hogy valami olcsóbb lehet és azt is, hogy több kapacitás állhat rendelkezésre.

Egy fél évvel ezelőtt úgy tűnt, hogy az N5 kapacitások szűkössége és drágasága miatt AMD döntései (Chiplet + Navi33 N6-on tartása) lehet a helyes megközelítés, ami mind a költségek fékentartásában, mind pedig a kapacitáskihasználás vonatkozásában nyerő lehet (nem is beszélve a jövőbeni skálázódásról)

Viszont ha az N5 ára (is) esetleg csökkenésnek indul és szabad kapacitások alakulnak ki, akkor könnyen lehet, hogy a végén az Nvidia megközelítése fordulhat nyerővé.

Mert persze ha az N5 és N6 szabad kapacitás nő és az ár csökken, az persze az AMD számára is rejthet lehetőséget, de az ő esetükben számolni kell azzal is, hogy a szerelés (ide értve a Navi31 chipletezését és a CPU-k 3D tokozását is) lehet volumen-korlátos. (Vagy legalábbis nehezebben skálázható)

De a nagyobb kapacitásban rendelkező, esetleg olcsóbbodó wafer a jelenleg nem túl magas tranzisztorhatékonyságú Intel GPU-k számára is kedvező környezet, hiszen jóval kisebb költség jellegű büntetés mellett versenyezhetnek pazarló lapkaméretű GPU-ikkal, mint tehették volna akkor, ha éles küzdelem zajlik a kapacitásokért.

Persze nyilván a TSMC nem fog azonnal hanyatt-homlok pánikba esve kiárulni a kapacitásokat, de vajon fog-e átrendeződést eredményezni néhány alacsony kihasználtságú negyedév a GPU és/vagy CPU piacon? Lecsap-e valaki a szabad kapacitásra, hogy piacot szerezzen, vagy hogy alacsonyabb árszegmenseket is kiszolgáljon, vagy elengedik?

-

Petykemano

veterán

"Elég káros, amikor óriási meggyőződéssel állít butaságokat valós állítások közé keverve, ráadásul "emberi nyelvezeten". Az esetleges rossz szándékú manipulációk lehetőségét nem is említve....

Persze, ugyanez a veszély fennáll a hagyományos internet/keresők esetében is, de sokkal jobban ellenőrizhető a forrás, mint az Ai-chat esetén."Különös, ezt mintha én mondtam volna. Mondtam is, de asszem nem ezen a fórumon. Csak meglepődtem, mennyire ugyanezt gondolom. Eszembe is jutott Rehoboam, meg a Westworld. Szürreális lehet real life visszahallani a gondolataidat mástól, amit azért tudnak előrejelezni, mert a múltad teljes ismeretével párhuzamos szimulációkban gyorsabban előrejelezhető vagy, mint a saját kémiai neurontranszmittereid.

-

Petykemano

veterán

válasz

Yutani

#46069

üzenetére

Yutani

#46069

üzenetére

Egyébként érdekes, hogy volt így is sales a gaming szegmensben. Részleteket persze nem ismerünk, csak annyit, hogy a csökkenő a GPU eladásokat a megnövekedett konzol chip gyártás kompenzálta.

Egyébként annyira nem meglepő, ha így volt, hiszen a elmúlt 1-2 generáció során közel annyival nőttek az árak, mint amennyivel a teljesítmény is, nem is beszélve az elmúlt 2 év kripto-árairól nem is beszélve így valószínűleg elég sokan ugorhattak rá a GPU vásárlásra, amikor az árak csökkenő trendet vettek fel. Persze tudjuk, hogy nem reprezentatív, de a Steam Survey is arról árulkodik, hogy meglehetősen sok az elhalasztott vásárlás (1050-től 2060-ig bezárólag)

-

Petykemano

veterán

válasz

Yutani

#46067

üzenetére

Yutani

#46067

üzenetére

a napokban mintha azt is hallottam volna valahol, hogy ez úgy történik, hogy lapkákat tartják vissza az AiB-októl. Tehát nem a kész kártyákat tartják bedobozolva raktárban, csak a alapkákat. Ez abból a szempontból logikus, hogy sokkal kevesebb helyet foglal és mondjuk a bezúzás (leírás) esetén sem a teljes $100-600-os (előállítási költségű) kártya értéke vész el, csak a $10-100-os lapkáé.

-

Petykemano

veterán

AMD in its Q4-2022 earnings release call disclosed to investors that it "undershipped" chips in the second half of 2022 to keep prices (margins) high and save itself from unsold inventory, in the wake of a steep slump in the PC market. "We undershipped in Q3, we undershipped in Q4," AMD CEO Dr Lisa Su told investors. "We will undership, to a lesser extent, in Q1 [sic]," she added.

[link]

hóhó, ármanipuláció - ilyenért jár valami versenyhatósági kivizsgálás? -

Petykemano

veterán

Intel drops price of A750 to $249

Egész jól hangzik, reméljük, apa kezdődik.

A TPU adatbázis szerint a 3060, amihez az intel hasonlítja magát, 7%-kal jobb, a review során 1080p-ben 4%-kal. Ehhez képest az Intel ábrája elég sok játékban előnyt mutat már. A DX9-es API-hoz a drivert legalábbis megcsinálták.

Talán indokolt lenne egy újramérés....

(Ez alapján még azért nincs ott [link] )Mindenesetre az irány

- hogy az Intel igyekszik a driver bütykölésével javítani a teljesítményt

- csökkenti az árat

jóPersze tudom, hogy az árcsökkentés azért lehet indokolt, merthogy állítólag az Intel ugyan leszállította a többmillió kártyát (A JPR jelentésre alapozva), azonban (a mindfactory számokra alapozva) látszólag nem veszik a vásárlók

-

Petykemano

veterán

válasz

huskydog17

#46038

üzenetére

huskydog17

#46038

üzenetére

Kellemetlen a csengése, mivel

- az amd volt a nagy támogatója, úttörője az explicit apiknak

- a játék valamilyen AMD támogatással készült.De nem mondanám nagyon gáznak. A polaris egy 6-7 éves termék, elég idős már ahhoz, hogy ez-az új dolog ne legyen vele kompatibilis.

A valódi probléma az, hogy ezalatt a 6-7 év alatt (kb tavaly év végéig) ebben a szegmensben stagnált a perf/$ mutató, így a polaris kártyák ma is nagy számban vannak használatban, nem cserélődtek le.Bár erre éppenséggel lehetne tekintettel is lenni, ha már AMds cím.

Vajon megfeledkeztek volna a legszélesebb penetrációval rendelkező kártyájukról?

Vagy lehet-e a támogatás felfüggesztésében szándékosság, tudatos átgondoltság: "vegyél újat, barátom"? Az AMD épp most készül a nagy volumenben gyártható navi33-mal piacot szerezni. (Állítólag) Lehet, hogy nem véletlen, hanem így jel, hogy "it is safe to upgrade now"? -

Petykemano

veterán

Az utolsó MindFactory GPU eladási adat, amiket találtam 2022 31. heti

[link]A 31. hét július vége lehetett. Az már Q3. Q3 már a bezuhant GPU eladásokról szólt.

A beszámoló szerint 3600db GPU-t adtak el a MF-nál.Ami nem kevesebb, mint

- a 29. heti 3470

- a 23. heti 2935

- a 17. heti 2825Az összetételben is mintha lenne némi elmozdulás a kifejezetten drágább felől a midrange felé.

Itt van egy 40. heti: [link]

4055 teljes eladási számmal.Van egy új gyűjtés, de nem annyira részletes [link]

Nvidia: 1065

AMD: 805

Total: 1870A megfogalmazás alapján ez még nem teljes hét, a hét egészére összejöhet a 4000.

Ez persze csupán egyetlen üzlet.

Mindenesetre érdekes, hogy ennek az üzletnek a forgalma nem csökkent. Sőt, megkockáztatom, hogy az alacsonyabb árak és a jobb készlet miatt talán még nőtt is. -

Petykemano

veterán

válasz

Petykemano

#45993

üzenetére

Petykemano

#45993

üzenetére

De másutt is ezt írják. Abban az értelemben, hogy kurrens kihasználtság. Sőt, azt is, hogy N7/N6 esetén 40% alá eshet. [link]

Eredetileg innen: [link]

Ez megmagyarázza, miért marad sokmindem N6-on az AMD-nél.

Amit még hozzá akartam tenni az az, hogy azt gondolnám, hogy a félvezetők iránti kereslet ilyen mértékű csökkenésével szerintem minden más komponens árának is idővel csökkennie kéne.

PCB, szubsztrát, VRM - Ezekre is mind visszaeshetett a kereslet. A legdrágább komponens talán egy gpuban a GDDR. De annak is csökkennie kéne. Egyrészt mivel a gpun és a konzolon kívül nem használja semmi. Előbbire biztosan súlyosan visszaesett a kereslet, utóbbira talán nem, vagy nem annyira, de a gpu kereslet negyedévente 13 millióról 6-ra esett vissza, PS5-ből meg most tartanak 30 milliónál 5 év alatt.

Egyedül a hűtő alapanyagai (réz és alumínium) Azok amelyek más iparágakban is használatos, de utoljára mikor méztem, Azok is visszakorrigáltak a csúcs árból.Az energia ára persze magas még és a megmunkálás biztosan sok energiát használ. De a gáz ára is lefelé tendál manapság.

A szállítási költség visszaállt.Egyedül az infláció miatt esetleg nagyobb mértékben növelt bérköltség marad meg. De egyrészt nem mindenhol akkora mértékű, mint nálunk. Euban 9.2% vllt tavaly. Tehát összessségében egy infláció körüli áremelkedés magyarázható lenne a bérköltségek emelkedésél.

Szerintem csökkennie kéne az áraknak.

-

Petykemano

veterán

Állítólag...

Míg korábban az 5nm-es gyártástechnológiára túljelentezés volt, addig most már kezd beesni a gyártókapacitás kihasználtsága 70% alá.

[link]Nem teljesen egyértelmű, hogy ez a kurrens kapacitásra vonatkozik-e visszamondások miatt, és a tsmc a következő hetekben allokálhat kedvezményes áron másoknak, vagy a következő 1-2 évre érvényes foglalásokra kell érteni.

-

Petykemano

veterán

válasz

Raggie

#45973

üzenetére

Raggie

#45973

üzenetére

Döbbenetes, hogy...

... mi is lehet itt a jelenség tulajdonképpen?Ilyen mennyiségben kerül felhelyezésre hibás CCD? Azt gondolnám a CCD-ket még rögzítés előtt tesztelik és válogatják működőképesség és képességek alapján. Máskülönben nem tudnák előre eldönteni, hogy mely CCD-k mennek desktopra és melyek EPYC vagy Threadripper felhasználásra.

Háááát.... ez nem valószínű...Ilyen mennyiségben helyeznének fel tudottan hibás CCD-t a kupak stabilizása érdekében?

De akkor az összesnek ilyennek kéne lennie, nem?

Háááát.... ez sem valószínű...Ilyen mennyiségben hibásodna meg rögzítés közben egy-egy CCD?

Ez ugye azt jelentené, hogy elég magas a meghibásodás aránya. És egy epyc esetén, ahol 13 chipletet helyeznek fel ez még hatványozottan érvényes.

vagy

Létezhet, hogy az AMD egyébként 2 működőképes CCD-vel szerelt példányok esetén tiltja le az egyik CCD-t? -

Petykemano

veterán

válasz

paprobert

#45965

üzenetére

paprobert

#45965

üzenetére

"De nem igazán értem, hogy miért még mindig költségeket számolunk, amikor az árak önkényesen vannak megszabva mindkét cég által."

Az, hogy az árakat a költségek indokolják-e leginkább abban a vitában (vagy ha esetleg nem is feltétlenül nevezhetjük két eltérő állásponton levő tábor közötti vitának, de mindenképpen nevezhetjük egy belső vívódásnak), hogy úgymond érdemes-e megvenni.Ha arra jutunk, hogy az árakat az elszabaduló gyártási és szállítási költségek indokolják, vagy legalábbis úgy értékeljük, hogy a megszadott ár, az kellően jó ár/érték arányt jelent, akkor hát nincs más lehetőség, ki kell csengetni a dellát.

Ha viszont arra jutunk, hogy az árakat - ahogy azt sejteted - nem a költségek, sokkal inkább valami növekvő profit-várakozás eléréséhez való piaci igazodás határozza meg, akkor - ha kényszer nincs - be lehet inteni és meg lehet várni, míg a piac láthatatlan keze lejjebb viszi az árakat.

Persze aztán innentől ez chicken game és lehet, hogy kitartanak a cégek.

-

Petykemano

veterán

válasz

Petykemano

#45925

üzenetére

Petykemano

#45925

üzenetére

Abu az Nvidia találgatósban újra elmondta, hogy milyen olcsó az N6. És hogy azért tartotta N6-on az AMD a Navi33-at, meg más budget termékeket, mert olcsó.

Azt a kérdést akartam neki feltenni, hogy akkor ugye lehet olcsó a Navi33? Mármint $400 alatti.

Persze az AMD találgatósban is felmerült már ez a kérdés és többen azzal csaptátok le, hogy álmodozás, hogy az árak visszacsökkenjenek a kriptóboom után.

Az Nvidia találgatósban megemlítésre került, hogy fless számolgatott is. Nyilván nem tudom sem megerősíteni, sem megcáfolni a számait. Nem is ez a célom.

Az jutott eszembe arra, hogy a Navi33 lehet-e olcsóbb, hogy "jójó, a wafer lehet, hogy olcsóbb, de hát ott a sok más költségtétel, a board, a hűtő, a VRAM, ami azért még relatíve drága - drága ahhoz, hogy a termék akármilyen wafer árral se lehessen olcsó."

És épp ezért ide írom és nem a két találgatós valamelyikbe, ahonnan a fenti info-morzsák származnak.

Mert a gondolatot továbbvive valahogy elképzelhetetlennek tartom, hogy miközben néhány negyedév alatt megfeleződött a dGPU kereslet, hogy ez ne legyen hatással az egyéb komponensek - board, hűtő, VRAM - árára. Persze nem feltétlenül azonnal.A másik megjegyzésem pedig az, hogy ha esetleg az összes komponens közül a wafer vált az olcsó tényezővé, akkor tessék nem ennyire spórolni a waferral. TEhát akkor nem azt kell csinálni, hogy egy 200mm2-es lapkát húzunk 250W-ig, hanem egy 250W-os kártyába teszünk egy alacsonyabb órajelen járatott (nem túlhúzott) 350mm2-es lapkát és máris ott a teljesítménytöbblet.

-

Petykemano

veterán

válasz