- D1Rect: Nagy "hülyétkapokazapróktól" topik

- gban: Ingyen kellene, de tegnapra

- sziku69: Szólánc.

- sziku69: Fűzzük össze a szavakat :)

- Luck Dragon: Asszociációs játék. :)

- MasterDeeJay: RAM gondolatok: Mennyi a minimum? DDR3 is jó?

- total90: SSD és HDD árak 2026-ban – most kell vásárolni, vagy várni 2028-ig?

- Elektromos rásegítésű kerékpárok

- Sub-ZeRo: Euro Truck Simulator 2 & American Truck Simulator 1 (esetleg 2 majd, ha lesz) :)

- eBay-es kütyük kis pénzért

Új hozzászólás Aktív témák

-

ezt nehéz megítélni anélkül, hogy belelátnánk, mennyi erőforrás megy a GameWorks-re. másrészt az elmúlt 2-3 évben nem nagyon történt olyan változás a játékok látványvilágában, amitől el lehetne ájulni, így kicsit öncélúnak tűnik a HW-lóverseny is - elég vicces, hogy 1-2 játékban kikapcsolod a AA-t és az AO-t, és hirtelen 3x annyi FPS-ed lesz. nyilván a GW ezt is hivatott "támogatni" a TXAA-val.

-

hszilard666

veterán

válasz

Malibutomi

#3096

üzenetére

Malibutomi

#3096

üzenetére

Naaaa... Tök ló az a topik!

A nem oda való embereket már kidobták a fórumról

A nem oda való embereket már kidobták a fórumról

-

Malibutomi

nagyúr

Töletek nem vártam volna hogy áthozzátok ide a 780off "szinvonalát"...

-

Asbee

veterán

Azt se felejtsd el, ők kötik magukat az elveikhez. Inkább maradjunk egy helyben legyen lassabb de ne buta chip. Picit magasabb órajel meg reméljük jobb hűtés, de ugyanúgy fogyaszt és kazán.

Erre váltani értelme nem lesz. Bízzunk benne a 390 és X majd tényleg mutat valamit, mert ez eddig kevés.

Erre váltani értelme nem lesz. Bízzunk benne a 390 és X majd tényleg mutat valamit, mert ez eddig kevés. -

kovsol

titán

Friss infók az AMD következő csúcskártyáiról

Én megfejtettem az AMD terveit! Azért nem változtatnak majd semmit éveken át, mert ezzel könnyíti a fejlesztők dolgát a tökéletes DX12 -re való optimalizálásnál. Így nem kell azzal vesződniük, hogy külön kell optimalizálni generációnként. Mivel low-level API-val a hardver sebessége kismértékben szól bele az eredménybe. Az optimalizálás számít.

-

Abu85

HÁZIGAZDA

válasz

FLATRONW

#3090

üzenetére

FLATRONW

#3090

üzenetére

Az teljesen világos, hogy van hova fejlődni, mert a hajszimuláció gyakorlati megvalósítása csak most indult. De a Hairworks egyrészt úgy kerül több erőforrásba, mint a TressFX, hogy nem csinálja meg az önárnyékot, nincs rajta semmilyen analitikai élsimítás, és spagettis az egész hatása sorrendtől független átlátszóság nélkül. Oké elfogadom, hogy az NVIDIA-nak ezeket nehéz beintegrálni a Hairworksbe, mert akkor nem lehetne gyorsan beépíteni a motorokba, de azt már nehéz lenyelni, hogy a minőséget eredményező tényezők nélkül is több ideig tart a feldolgozás, mint a TressFX-nél.

HBAO-nak mindig az volt a gondja, hogy rengeteg hamis árnyékot generált. Ezt sosem tudta levetkőzni, bár javult a helyzet. De nem miért nem lépünk. Ott az Obscurance Fields. -

FLATRONW

őstag

A Hairworks tényleg egy rakat f.s, de a TreesFX is csak a sz.r szintjén van.

A HBAO-ról pedig az a véleményem, hogy minőségben semmivel sem rosszabb, mint a HDAO. Az alap SSAO-hoz képest mindkét megoldás lényegesen jobb, de egymással szemben nincs ilyen különbség.

A különbség kb. annyi, hogy az egyik az egyik sarokba a másik meg a másik sarokba tesz egy apró árnyékot.

Például a Far Cry 4-ben használt Ubisoftos SSBC sem rosszabb ezektől, csak más. -

Laja333

őstag

válasz

Locutus

#3088

üzenetére

Locutus

#3088

üzenetére

Én is erre próbáltam kilyukadni. Mantle Apis játékok legalább jól optimalizáltak. Vagy ha nincsenek is jól optimalizálva, de lényegesen jobban futnak mint egy agyon optimalizált dx. Közben a minőségben sincs alatta. Szemben a gameworks csak halált hoz, és rettegést. Nincs párhuzam.

-

Abu85

HÁZIGAZDA

Nyilván az effekt koncepciójának komplexitása is számít. A HBAO+ esetében hozzá kell tenni, hogy már az NVIDIA és az AMD driverei is lecserélik a shadereket. Ez segít a sebességen, de a minőségétől nem dobod el magad.

[link] - Ebben van egy kapáló macska HairWorks-szel. Tisztán látszik, hogy hiányos az egész.

A GameWorks-re azt lehetne felvetni, hogy ha az NV nem ebbe ölné az erőforrásait, hanem segítené a fejlesztők egyéni igényeit, akkor sokkal jobb effektek születnének ugyanazokra a problémákra. Viszont az NV már nem akar a minőséggel és a sebességgel foglalkozni. Valószínű, hogy az elmúlt években rájöttek, hogy ez nem fontos a vásárlónak, ha már a felhasználóik 80+%-a felbontást sem tud önállóan állítani.

-

igen, ezeket nagyrészt tudom, ill. a második bekezdésben írtak nem mindegyik effektre igazak. a HBAO+-n és a TXAA-n (ami a legtöbb játékban felbukkan) nem látni ilyen minőségbeli korlátozást, és a HBAO+ sebességre is normális, legalábbis nVidia hardveren. HairWorksot nem láttam még élőben, de elhiszem, hogy nem sikerült jól, eléggé izzadtságszaga volt az egész sztorinak, olyan "én is tudok ilyet csinálni bmeg" jelleggel. ezekből nem szokott sok jó kisülni.

igazából pont az általad leírtak miatt nem értem a hisztit a GameWorks körül. kapsz néhány extra effektet a játékban, amik enélkül nem lennének benne. ha nem tetszenek, vagy túl sok erőforrást zabálnak, akkor egyszerűen nem használod őket.

-

Laja333

őstag

válasz

Locutus

#3082

üzenetére

Locutus

#3082

üzenetére

Azon kívül, hogy a Mantle api, a shitworks pedig egy csomag, Mantleben jó a teljesítmény és a minőség, crapworksben szar… ezeken kívül tényleg kísértetiesen hasonlít.

jah nem, mégse.

jah nem, mégse.

Az összes garbageworks játék hulladék, de egyik Mantle játék sem az.

Valamint Mantlenek nem az az egyetlen célja, hanem csak egy hozománya a gyors portolhatóság.Korán volt még?

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Abu85

HÁZIGAZDA

válasz

Locutus

#3082

üzenetére

Locutus

#3082

üzenetére

A Mantle-nek az a célja, hogy a fejlesztők igényeit kiszolgálja. Ha például Johan egyszer elköhögi magát, hogy neki kellene hozzáférés bizonyos GPU-n belüli regiszterekben tárolt adatokhoz, akkor a Microsoftnak ezt hiába mondja, elküldik a fenében, mert az igénye borzalmasan réteges és nem reprezentálja a tömeges igényt, így felesleges ilyen funkció a szabványba, de az AMD készséggel teljesíti az igényét, mert ezért csinálták az API-t.

Az, hogy a Mantle-t támogató motorok DX11 alatt is jól skálázódnak tulajdonképpen egy mellékterméke az iránynak. Azzal, hogy a fejlesztők megértették a low-level API-val a program oldali limitációkat, ezek kijavíthatóvá váltak. Ez olcsósítja a portolást, mert nem néznek hetekig ki a fejlesztők a fejükből, hogy mitől nem skálázódik a DX11 mód. -

Kísértetiesen hasonlít ugye a Mantlera, aminek ugye szintén az az egyetlen célja, hogy a fejlesztő gyorsabban és olcsóbban tudjon PC-re portolni. Ott sem jött be az évek alatt semmi abból, amit a PR bullshit még körített hozzá a világmegváltás reményében... De még a sok olcsó portolás se nagyon...

-

Abu85

HÁZIGAZDA

válasz

Malibutomi

#3073

üzenetére

Malibutomi

#3073

üzenetére

A GameWorks az nem förtelem minőség, hanem ennyit lehet egy ilyen koncepcióval kihozni. Az a baj, hogy a GameWorks úgy lett beharangozva, hogy extrém minőséget kínál ultragyorsan, meg úgy odabasz, hogy megnyalod a tíz ujjad. Ezt technikailag nem lehet megcsinálni a GameWorks middleware-rel, mert nem ad lehetőséget a fejlesztőnek, hogy optimalizálja a sebességet, és az NVIDIA-nak, hogy optimalizálja a minőséget.

Egy totális félreértés az, amiben a játékosok élnek, hogy a GameWorks célja a minőség és az optimalizálás. Nem, ennek a rendszernek a célja, hogy gyorsan beépíthető legyen xy effekt a játékokba. Szar lesz a minőség és a sebesség is, DE! pár nap alatt működik. Baromi gyorsan beépíthető és stabil. A minőség és a sebesség másodlagos. -

Abu85

HÁZIGAZDA

A GameWorks minőségileg és sebességben mindig elmaradott lesz. Két gond van:

A licencelő megkapja a middleware-t, és neki kell az effekt követelményeihez szabni a motort. Ettől még lehetne jó a rendszer, csak nyilvánvaló, hogy azért kell a GameWorks, hogy időt spóroljon meg. Az integrálás optimalizálásának hiányában mindig lassan fut majd az effekt minden hardveren.

A minőség pedig az NVIDIA problémája. Ha elkezd ezeknek az effekteknek minőséget adni, például a HairWorksnek analitikai AA, vagy önárnyékot, akkor nő annak az esélye, hogy a fejlesztő nem tudja majd beépíteni az adott motorba, mert rengeteg hibát fog generálni. Ezért az NVIDIA a minőséget szándékosan elveszi, hogy megmaradjon az egyszerű beépíthetőség. -

Laja333

őstag

válasz

huskydog17

#3076

üzenetére

huskydog17

#3076

üzenetére

Ma ezt találtam gdc 2015re. Érdekes, hogy AMD előadásban főleg dx12vel foglalkoznak.

-

huskydog17

addikt

"Például a Tiled Resources funkciót sok fejlesztő várta és senki sem épít rá ma."

Miért, a Farm51 dobta volna a DX11.2-t?

Amúgy most hallgattam végig Brad Wardell interjúját és több érdekes dolgot is mond. A low-level API-k leginkább stratégia és RPG játékok esetében mutatják ki a foguk fehérjét. A GDC-n olyan demót fognak mutatni, amely mellett a Star Swarm elavultnak fog tűnni, ezen felül az AMD egy nagy és őrült dologgal fog előállni.

Most már csak azt nem értem, hogy egy felhasználó honnan a fenéből veszi a 600k draw call-t? A hülyeséget sajnos más sajtó átvette. Itt mindössze egy Intel által készített DX12 demóról volt szó, ahol a MS új API-ja 60.000 rajzolási paranccsal működött, míg egy a DX9 kb 5.000 parancsot bír (a fent linkelt interjúban 29:12-től beszél erről). Ebből hogy a túróba csináltak 600k vs 6k draw call-t?

Nagyon várom a GDC-t, több nagy bejelentésre készülnek, én legfőképp az AMD őrült dobására vagyok kíváncsi. Abu, egy apró információmorzsád nincs erről véletlenül?

-

válasz

Malibutomi

#3073

üzenetére

Malibutomi

#3073

üzenetére

az lesz az igazi, ha külön fog megjelenni a GTA Va és a GTA Vn

amúgy a GameWorks-nek nincs semmi baja (ha azt nem számítom bajnak, hogy marhára nem érdekelnek az effektek, amik benne vannak

![;]](//cdn.rios.hu/dl/s/v1.gif) ), a minőség a kiadó keze munkáját "dícséri"...

), a minőség a kiadó keze munkáját "dícséri"... -

Malibutomi

nagyúr

-

nem volt valódi a cáfolat, mert egy szót sem szólt arról, hogy mi az oka az AMD DX12 és az nVidia DX12 közötti, a vártnál nagyobb differenciának.

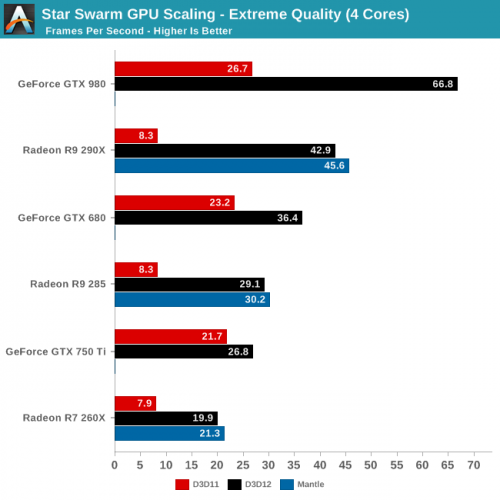

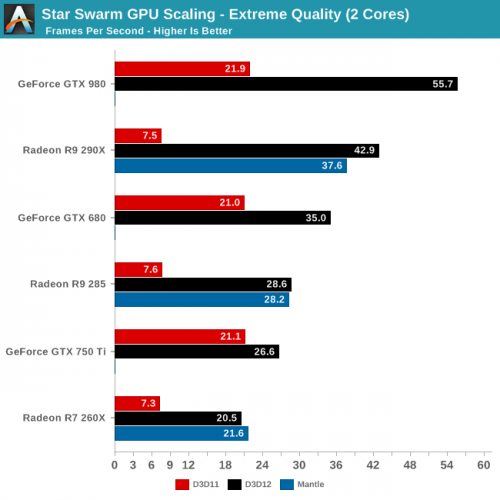

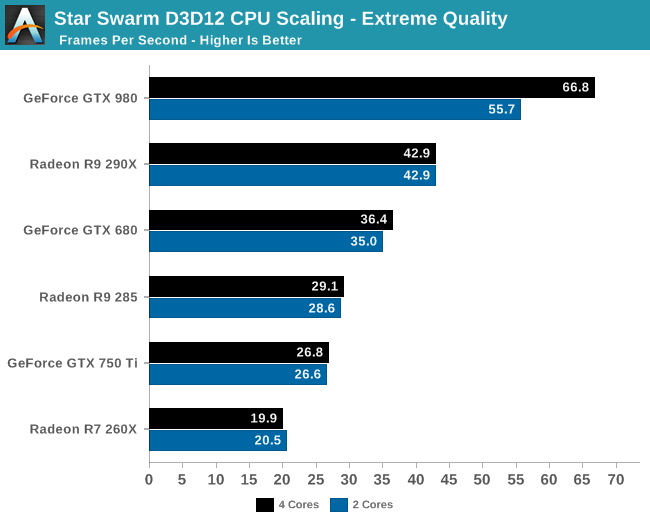

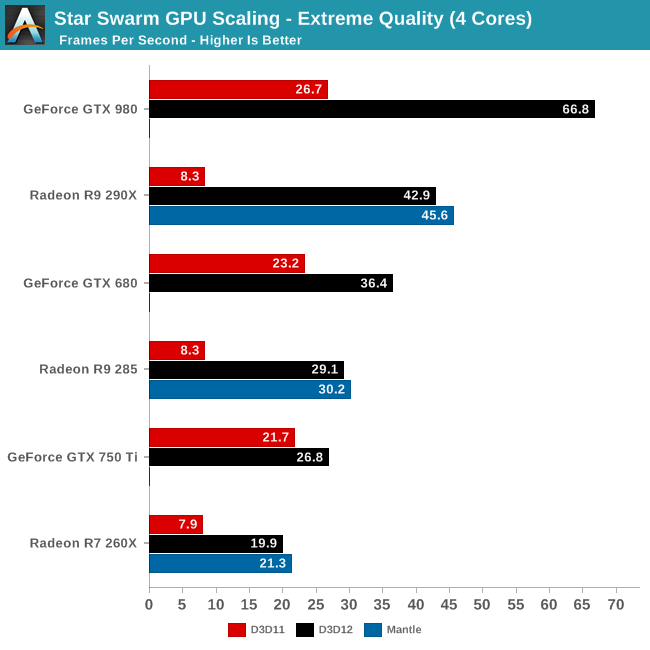

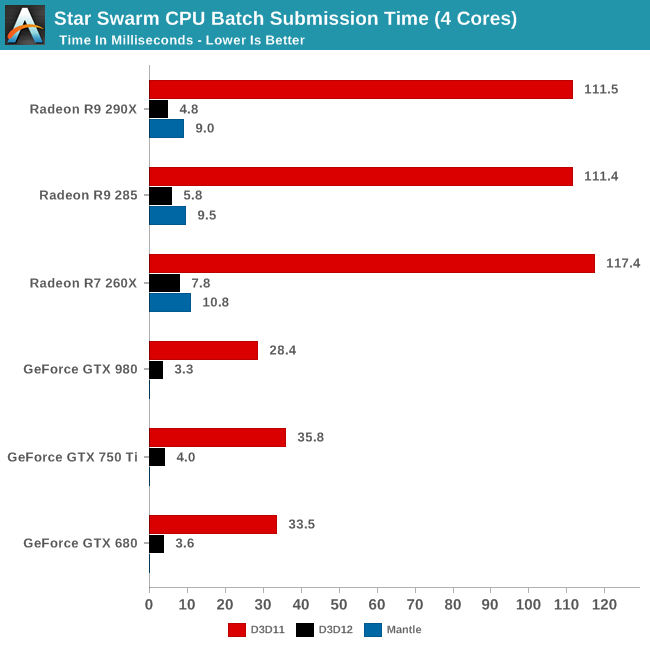

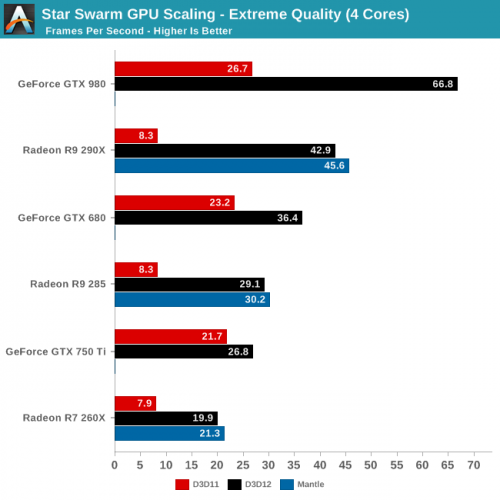

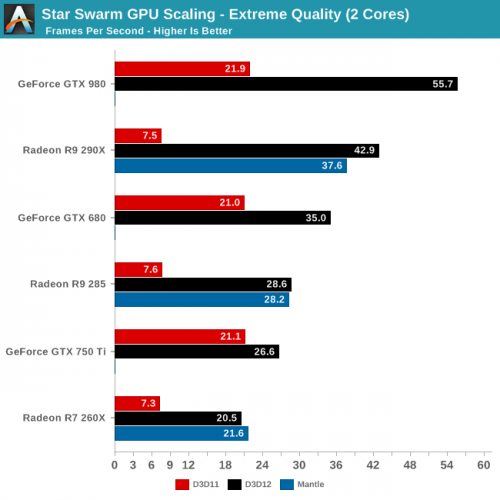

a grafikonokról az a véleményem, hogy a DX12 tesztek teljesen GPU-limitesek, kivéve a GTX 980-at, ami ennek megfelelően gyorsul is 2 mag és 4 mag között. a 290X-nél a Mantle azért gyorsabb, mint a DX12, mert feláldoztak némi CPU-erőforrást annak érdekében, hogy a GPU parancs-pufferén kisebb legyen a terhelés, így kicsit feljebb tolták a GPU-limitet.

-

Abu85

HÁZIGAZDA

Nem bűzlik semmi. Régi a kód. Az AMD-nek már nem kell a StarSwarm, így nem éri meg visszaírni bele a Nitrous fejlesztéseit. Valamilyen szempontból ez az egész egy üzlet. Az Oxide nem jókedvből fejleszti ezeket a programokat, hanem azért, mert fizetnek érte a gyártók, hogy meg tudják mutatni az új API-k, technikák képességeit. Viszont, ha egy gyártó valamit nem igényel, akkor felesleges vele foglalkozni, mert az Oxide emellett egy játékot is fejleszt, és oda is kell az erőforrás.

-

Abu85

HÁZIGAZDA

válasz

daveoff

#3052

üzenetére

daveoff

#3052

üzenetére

Nem érted mit írtam le. A Mantle használata csak akkor nem ajánlott, ha az adott fejlesztő mindent meg tud csinálni DX12-vel. De van számos dolog, amit DX12 nem támogat, míg a Mantle igen. Például a fedettségmintákat, amit ha egy analitikai élsimítás esetleg használ, akkor a DX12-n nem futtatható le ez az algoritmus. Például ilyen a Nitrousba épített új AA is. Teljes minőségben csak Mantle-ön működik, mert a DX12-ből hiányzik az a funkció, amivel fedettségmintákat lehetne szerezni.

Ha egy olyan eljárást igényel a program, amit a DX12 nem támogat, akkor mindenképp hozzá kell nyúlni a Mantle-höz. Ezért maradnak páran rajta. Viszont, ha mindenféle extravagáns, egyedi, csúcsszuper effekt vagy AA nem prioritás, akkor elég a DX12, mert az is megadja azt a grafikai minőséget, amit a fejlesztő elgondolt.(#3054) gbors: Azt mindenképp bele kell számolni, hogy az Oxide a világ két legjobb programozóját alkalmazza, tehát az, hogy ők a low-level API problémáival megbirkóznak az nem meglepő. Ha nem birkóznának meg a feladattal, akkor nagy gondban lennénk.

A görbét akkor lehetne megállapítani, ha a Mantle és a DX11 kód nem lenne egy éves, a DX11 deferred context ezért fagy ki, mert az új optimalizálást nem írták vissza a StarSwarmba, pedig ezt az NV megoldotta az elmúlt év őszén. Mint írtam, az AMD-t már nem érdekli a StarSwarm, tehát nem igénylik, hogy az új Mantle pathot visszaírják bele. Egy másik demóval akarnak kampányolni 2015-ben és annak a teljesítménye a fontos.(#3065) HSM: A submission time-ban az a jó, ha kisebb. Erre ráoptimalizált a Nitrous, csak ezt is vissza kell írni a StarSwarmba ahhoz, hogy ennek az eredménye látszódjon. De valszeg csökkentené ezt az időt a specifikus Mantle batch optimalizálás kikapcsolása is. Nem tudom, hogy ez aktív volt-e vagy sem.

-

HSM

félisten

Igen, lehetett látni, hogy a DX nem igazán rúg labdába, tehát technikai demonstrációnak (aminek készült) tökéltes volt.

Viszont benchmarknak használni így ez kb. olyan, mintha az egyik gyártónál egy évvel korábbi pre-béta driverrel teszteltetek volna, míg a másiknál a frissel. Azt ugye senki nem gondolja, hogy az egy hiteles teszt lenne. Ja, igen, és pre-pre.pre OS-en. No comment.

Ja, igen, és pre-pre.pre OS-en. No comment.

(#3064) gbors: Valódi cáfolat volt szvsz ez is, de ha nem győzött meg, érdekesség 2:

Neked nem fura, hogy az AMD nem gyorsult 2X annyi maggal? Nem is volt 100% a kihasználtsága a CPU-nak.

Ezzel szemben:

A mantle tesztből látszik, hogy nem GPU-limit volt így sem. Pedig elvileg Mantle alatt magasabb a submission time is.

Mi a véleményed erről? -

senki nem beszélt a Mantle-ről, a DX12-n van a hangsúly, a Mantle csak egy mellékes információ a tesztben. szerintem nagyon is megállja a helyét a következtetésem, de lehet (valódi) cáfolattal jönni

hogy az AMD-re alapból sokan fognak optimalizálni

ez pedig elméletben így van, de a gyakorlatban már most is látszik, hogy PC-re újra kell optimalizálni. nem mondom, hogy a konzol-hatás 0, de arról szó nincs, hogy sokkal nagyobb munka lenne nVidiára - sőt, attól tartok, hogy sőt

meg ugye nem csak konzolportok léteznek... -

Abu85

HÁZIGAZDA

A fejlesztők felelőssége megnő ez nem vitás. Nem véletlenül megy el arra az AMD partnerprogramja, hogy a programozóikat odarakják a partnerként szolgáló motorprogramozók mellé. A driver jelentősége nagyrészt megszűnik, mert a motorba épített vezérlés teljesítménye lesz a kulcs. Valószínű egyébként, hogy maga a terméktámogatási ciklus sem fog annyira változni. Azért költöznek a cégek programozói be a stúdiókba, hogy biztosítsák az optimalizálást a régebbi architektúrákra.

Én önmagában a top stúdióknál ezt nem látom gondnak. John Carmack már elment, de a piac "kitermelte" magának az új zseniket: Johan Andersson, Dan Baker, John Kloetzli, Josh Barczak, Kevin Floyer-Lea, Michael Bailey, Emil Persson, stb. Ezekben a programozókban lehet bízni, pláne addig, amíg a cégvezetéstől (EA, SEGA, Firaxis, Avalanche) dől a pénz a fejlesztésre. A gondot a kevésbé tehetős stúdiók jelentik, ahol nem mondom, hogy a szaktudás feltétlenül hiányzik, de a pénz mindenképp szűkös.(#3060) TTomax: A StarSwarm a tervezett feladatát most is ellátja. Megmutatja ma is, hogy a Nitrous képes 100k batcht nagy sebességgel kezelni low-level API-val. Ma is látszik minden gyártónál, hogy mennyit gyorsulnak az új API-kkal a rendszerek, függetlenül attól, hogy mennyire régi kódra épülnek az egyes leképzők. Ha az lenne a célja a tesztnek, hogy konzisztens eredményeket adjon és össze lehessen vele hasonlítani a VGA-kat, akkor nem két AI véletlenszerű csatáját látnád a képernyőn, hanem egy előre felvett jelenet visszajátszását, hogy minden mindig ugyanúgy történjen. Ilyenkor a lefuttatott tesztek eredményei nem 30, hanem 3 százalékos varianciát mutatnának csak.

A DX12 azért került bele a StarSwarmba, mert a Microsoft ezt demózni szeretné, ahogy az NV is. Az AMD a Mantle-t szeretné demózni, és nekik egy másik teszt készül. Ezekkel egyébként semmi gondja nincs az Oxide-nak. Üzletileg is teljesen elfogadható, hogy az MS és az NV elsődlegesen arra szeretné felhívni a figyelmet, hogy mennyivel jobb a DX12 hatékonysága a DX11-nél, csak az AMD-nek ez már nem elég. Ők már egy éve megmutatták a low-level irány egyik előnyét ebből a szempontból, más előnyökre szeretnének koncentrálni 2015-ben. -

Malibutomi

nagyúr

válasz

daveoff

#3052

üzenetére

daveoff

#3052

üzenetére

Ha visszakeresed a megjelenése utáni teszteket, akkor is írtuk páran, hogy nem lehet kártyákat összehasonlítani vele, mert túl eltérö eredményeket ad két futtatás között..

Az nem fura hogy több mint háromszor annyit kaptál mint a tesztben a 980 dx11-ben? Másfélszer annyit mint a 980 dx12 alatt. -

TTomax

félisten

Értjük tehát az utóbbi egy évben tök jó volt a teszt amíg a mantle előnyét kellett ajnározni,most már hirtelen fabatkát sem ért...most már "egy éves a kód", meg "hipokriták lettünk"...

-

Abu85

HÁZIGAZDA

Igen valószínű, hogy a hardverfejlesztések lassulni fognak. De legalábbis egy olyan modell mindenképp fontos lehet, hogy az egyes új architektúrákról jöjjön egy első fecske. Egy olyan termék, amelynek az üzleti sikere abszolút nem lényeges, viszont a fejlesztőknél legyen egy hardver arra vonatkozóan, hogy kezdjék el megtanulni a változásokat. Lásd a Radeon R9 285. Nem lényeges maga a termék, mert annyiba kerül, mint a 280 és kb. ugyanolyan gyors (jó picit gyorsabb és picit drágább a 285, de kb. egy szintre van rakva). Tehát igazából a terméknek nincs különösebb jelentősége kereskedelmi szinten, de a fejlesztőknek nagyon fontos, mert a Tongában alkalmazott architektúra lesz az új GPU-kban.

Ez modell azért is fontos, mert tényleg számolni kell azzal, hogy az új architektúraverzió lassulni fog, tehát ha készül egy olyan termék, amely mondjuk 20%-kal gyorsabb az elődjénél, akkor azt csak akkor szabad kiadni, amikor a legtöbb játékban, már ott van rá a low-level optimalizáció, tehát előre piacra kell dobni egy "fecskét", egy terméket, ami csak a fejlesztőknek szól, és kereskedelmi szinten nem számít, hogy mit teljesít.

Persze itt át kell majd értékelni sok dolgot. Például azt, hogy a nyers teljesítmény mellett bejön a képbe egy olyan tényező, hogy a szoftver jelentősen meghatározza a gyakorlati sebességet. Mai példát előhozva, simán tudsz venni 280-at és 285-öt. Úgy láttam Iponban van mindkettő, vagy más boltban, és kb. azonos áron ... +/- 5k forint. Átlagos gondolkodással megnézed, hogy a 280-nak 384 bites a busza, és 3 GB memóriája van, és ugye a tesztekben is kb. hasonlóan gyorsak, hát akkor legyen több memória. De egy átlagos felhasználónak fogalma sincs arról, hogy a Tonga mire képes. Például nemrég derült ki, hogy az egyedüli hardver a piacon, ami tud tile poolt, és a stateless compute hatékonysága is lényegesen jobb, mint a 280-nak. És itt jön az a tényező be, hogy ha a fejlesztők ezt kihasználják, márpedig a low-level API-k ezekre végre lehetőséget adnak, akkor a 280 lemarad, de nagyon.

Az is egy új dolog, hogy hajlamosak vagyunk a múltból kiindulni. Számos újítás került bele a DirectX 11.2-be és majd sok újítás lesz a DX 11.3-ban is. Például a Tiled Resources funkciót sok fejlesztő várta és senki sem épít rá ma. Ez nem azért van, mert rossz a funkció, ma is nagyon jó, csak korlátozottan használható, ha nem érhetik el közvetlenül a memóriát. Magát a motort úgy kell felépíteni, hogy a Tiled Resources funkciókhoz tervezni kelljen az egészet, erre még van middleware is, amit licencelni lehet és a végén tulajdonképpen kapsz egy funkcionálisan működő rendszert, aminek ugyanakkor a szoftveres oldali késleltetése akkora, hogy a gyakorlatban már nem tudsz vele programot szállítani PC-re. Erre mondta másfél éve Dan Baker, hogy tök jó funkciók vannak az API-kban, de nem tudsz egyikhez sem hozzányúlni, mert nagy késleltetést eredményez. Hiába van benne a tudás a hardverben és API-ban, ha az csak elméletben hangzik jól, de a gyakorlatban bevethetetlen. Ezen a teljes low-level irány nagyon sokat fog változtatni, mert közvetlenül hozzáférést ad a videomemóriához. A Tiled Resources funkciót el lehet dobni, nem kell middleware, és más dolog. Ott a videomemória és fel lehet rá építeni mindenkinek egy saját Tiled Resources technikát, magába a motorba. Innentől kezdve elkezdik használni a fejlesztők azokat a dolgokat, amelyek évek óta léteznek hardveres szinten, de eddig nem tudtak hozzányúlni, mert baromira nem jó az a programozási modell, hogy az API megengedi, hogy létrehoz és törölj puffereket, ráadásul óriási teljesítménybüntetés mellett. -

Laja333

őstag

Jaj gyerekek. Amikor a Mantle hozott egy szép teljesítmény javulást, akkor biztos kikapcsolták benne a simítást, meg egyéb trükkökkel érték el az eredményt. Most láttok egy pre-alfa tesztet dx12-ről, ahol jobb a 980, és gondolkodás nélkül elhiszitek, hogy ezt a teljesítményt ugyan olyan minőségben hozza. Ne legyetek már hülyék.

Hipokritákat nem csípem.

Hipokritákat nem csípem.

Ez a teszt még reprezentatív célra sem jó. Játéktesztek majd azok lesznek. -

HSM

félisten

"A teszt arra utal, hogy ez a görbe a Kepler és a Maxwell esetében meredekebben megy felfelé, mint a GCN esetében"

Szerintem ez a következtetésed hibás, mivel a Mantle egy évvel (!!!) öregebb kód a demóban... [link]

Arról nem is beszélve, hogy ahogy írod, még minden preprepre....

"...hogy a DX12-s játékokban az AMD-tulajok sokkal inkább rá lesznek utalva a kiadók jóindulatára, mint az nVidiások."

Ez pedig szerintem ott fog elvérezni teljesen függetlenül ettől a teszttől, hogy az AMD-re alapból sokan fognak optimalizálni, mivel a konzolokra feltétlen kell, így inkább az Nv-re optimalizálás lesz extra költség és szívesség. Ráadásul azt sem szabad alábecsülni, hogy a GCN-t ismerni fogják a konzolok és a dokumentációk révén a fejlesztők, Nv-nél ez is kérdőjel. -

Abu85

HÁZIGAZDA

Nem lesz itt lényeges változás a pénz elosztásában, de azt látni kell, hogy amíg a DX11-hez komoly pénz kellett a driverbe, addig a low-level API-knál erre nincs szükség. A GPU "vezérlésének" a 80%-át nem a gyártó fogja írni, hanem az adott szoftver programozója. Ennek a következménye az lesz, hogy a driverfejlesztés is az eddigi erőforrás töredékét igényli majd. Viszont ezeket a rendszerprogramozókat alkalmazni lehet más területen. Például elküldeni az egyes stúdiókhoz a vezető motorprogramozó mellé, hogy adjon neki a tanácsokat, ami fontos, mert mostantól a motorprogramozótól függ a hardver teljesítménye.

Anyagi szinten tehát nem lesz lényeges változás, csak máshogy kell befektetni ezeknek az alkalmazottaknak a tudását. -

nagyon érdekes ez a DX12 teszt - annak ellenére, hogy minden preprepre állapotú benne, néhány érdekes következtetést azért le lehet vonni belőle.

1. Abunak teljesen igaza van abban, hogy kritikus lesz a program oldali optimalizálás - ez nagyon jól látszik a 290X / 980, valamint a 285 / 750Ti viszonylatból.

2. Ez a teszt erősen arra utal, hogy az nVidia "buta" architektúrájára (mind a Maxwellre, mind a Keplerre) könnyebb optimalizálni, mint az "okos" GCN-re. Ez önmagában nem túl meglepő, nyilván komplexebb tudást nehezebb megfelelően kiaknázni - viszont az "nvidiaköcsögmertnemdokumentáljaazarchitektúrát" típusú érvelést a jövőben érdemes erős fenntartásokkal kezelni, mert egyáltalán nem biztos, hogy ez tényleg akkora probléma, legalábbis end user oldalon.

3. Az optimalizálás mértéke nagyban függ a ráfordított időtől - mindegyik architektúrára fel lehet rajzolni egy kb. görbét, hogy mennyi idő befektetésével milyen közel lehet jutni az ideális eredményhez. A teszt arra utal, hogy ez a görbe a Kepler és a Maxwell esetében meredekebben megy felfelé, mint a GCN esetében - cserébe valószínűsíthető, hogy az ideális pont a GCN esetében magasabban van.a fentiekből azt az (erősen tentatív) következtetést lehet levonni, hogy a DX12-s játékokban az AMD-tulajok sokkal inkább rá lesznek utalva a kiadók jóindulatára, mint az nVidiások. tekintve, hogy jelenleg az AMD-nek van több kiadó-partnere, ez a jelenlegi egyensúlyt talán nem fogja nagyon felborítani - viszont extrém szélsőségekre (mindkét irányban) nagyobb arányban számítanék, mint eddig.

-

daveoff

veterán

Ez meg egy 980, DX11-el........!!!!

De most már az is kiderült, hogy nem ér semmit ez a teszt, pedig eddig ez volt a nagy Mantle bizonyíték.

===========================================================

Oxide Games

Star Swarm Stress Test - ©2013

C:\Users\Dávid\Documents\Star Swarm\Output_15_02_07_0822.txt

Version 1.10

02/07/2015 08:22

============================================================= Hardware Configuration =================================

GPU: NVIDIA GeForce GTX 980

CPU: GenuineIntel

Intel(R) Core(TM) i7-3770K CPU @ 3.50GHz

Physical Cores: 4

Logical Cores: 8

Physical Memory: 17109540864

Allocatable Memory: 140737488224256

============================================================= Configuration ==========================================

API: DirectX

Scenario: ScenarioFollow.csv

User Input: Disabled

Resolution: 1920x1080

Fullscreen: True

GameCore Update: 16.6 ms

Bloom Quality: High

PointLight Quality: High

ToneCurve Quality: High

Glare Overdraw: 16

Shading Samples: 64

Shade Quality: Mid

Deferred Contexts (D3D11): Disabled

Small Batch Optimized (Mantle): Enabled

Temporal AA Duration: 16

Temporal AA Time Slice: 2

Detailed Frame Info: Off

============================================================= Results ================================================

Test Duration: 360 Seconds

Total Frames: 33233Average FPS: 92.31

Average Unit Count: 4770

Maximum Unit Count: 5972

Average Batches/MS: 1420.44

Maximum Batches/MS: 5914.99

Average Batch Count: 16669

Maximum Batch Count: 135445

===========================================================(#3051) hugo chávez: Ez az UP TO 45% a BF4-re vonatkozott, csak azt elfelejtették hozzáraknu, hogy ez egy APU, és egy 290X társaságában jött össze nekik. Abu is leírta, hogy a DX12 megjelenésével nem ajánlott a Mantle használata, akkor szerinted nem veszíti el a létjogosultságát?

-

hugo chávez

aktív tag

válasz

daveoff

#3019

üzenetére

daveoff

#3019

üzenetére

"Nálam ez a Mantle térítés verte ki a biztosítékot, akkor kezdett egyre ellenszenvesebb lenni az AMD. Up to 45% Faster......LOL"

Nem értem, mi olyan vicces ebben az "up to 45% faster"-ben...

Ahogy én látom a belinkelt tesztben, a GTX 980 DX11-es eredményeinél nemhogy 45, de egyenesen 70%-kal gyorsabb Mantle alatt az R9 290X. Vagy talán nem ugyanazt a tesztet nézzük?

Ahogy én látom a belinkelt tesztben, a GTX 980 DX11-es eredményeinél nemhogy 45, de egyenesen 70%-kal gyorsabb Mantle alatt az R9 290X. Vagy talán nem ugyanazt a tesztet nézzük?"Azt szerintem elkönyvelhetjük, hogy a Mantle 1000%, hogy elveszti a létjogosultságát, úgyhogy ennyit a AMD nagy jövő képéről."

Ezt sem értem. Pontosan miféle létjogosultságot veszített el? Hiszen a Mantle-nek soha nem volt célja, hogy egyeduralkodó legyen, ugyanis konkrétan a GCN-hez lett tervezve és, mint ilyen, gyártóspecifikus. Nem is tört efféle babérokra (a CUDA-val ellentétben, ugye...). A Mantle nagyon is betöltötte a feladatát, kiprovokálta a DX12-t és az OGL reformot. Innentől kezdve már csak annyi a dolga, hogy azon fejlesztőknek (és nem csak a játékfejlesztőknek), akiknek több kell, mint amit a DX12 tud nyújtani, legyen egy alternatívájuk, illetve, hogy ezáltal a DX12 további fejlesztésére legyen oka a Microsoftnak.

-

korion

senior tag

válasz

#35434496

#2531

üzenetére

#35434496

#2531

üzenetére

Nálam BF4 64 fős pályán 40 voltunk kb 40-60 fps(minimum) minden high,full hd!

i5 2500k van mellette!(XFX 290DD)

ellenben a rammokkal van vmi csak 1066 futnak (2000mhz Corsair )

(2000mhz Corsair )

és 98% környékén van a proci használat!szóval ,ha felhúzom a procit 3.9 ghz-4.1-re + beállítanám a ramokat 1866 cl9,akkor az 50 fps meglesz minimumba!(szerintem)

a NV970 98 ezer az R9 290 88 ezer forint!

láttam pár NV gépet és nem láttam különbséget..

sőt amikor "összemértük a pöxxünk"(3d mark és társai) teszteltük a gépeket egymás mellett,akkor ugyan azokkal a beállításokkal 3 % volt jobb egy 3770K 4.4ghz-GTX760 Asus oc,

Nekem 2500K 4.4 ghz-7870 MSI AB adtam neki tuningot min 200mhz ment mindenre!

de kb fele annyiba volt a gépem(a srácnak volt még egy ROG lap is a gépében) -

kovsol

titán

Azt értem, hogy miért is jó egy low level api, viszont azt még nem látom magam előtt, hogy gyakorlatban ez hogy fog elterjedni majd.

Viszont ha most mondjuk elkezdenek tegyük fel maxwellre optimalizálni, meg majd az új amd 3xx gpu-kra, akkor a piac egy nagyon kicsi részét fogják csak ezzel lefedni, mivel kétlem, hogy ezekből a kártyákból túl sok már a felhasználóknál a gépekben lenne rövid időn belül. Szerintem legtöbben még boldogan elvannak a Radeon HD7xxx és a GTX 6xx kártyákkal. Mire elterjed olyan számban az új architektúra, addigra meg jön majd megint egy újabb. És az NV és az AMD abba fogja tolni a pénzt, hogy az újakra fejlesszenek, de közben a felhasználok megint évek alatt fognak csak átállni az újra.

Persze adott a lehetőség, hogy optimalizáljanak akkor a régebbi kártyákra is. Viszont ez csak egy nyűg a fejlesztőknek. Minek optimalizáljanak majd x számú gpu architektúrára PC-n, mikor darabszámra lebontva az eladásokat alig hoz hasznot. Nem egyszerűbb akkor a 2 db konzolra optimalizálni amik között még nagy az átfedés is felépítésben, és tuti 5-6 vagy még több évig is fix hardverrel adott lesz a piacon, és a befektetett pénz az optimalizálásba itt bőségesen meg is térül ha lebontjuk eladott darabszámra. -

Asbee

veterán

A mantle egy bukás ahhoz képest ahogy beharangozták. Persze majd megint jön a magyarázat, hogy de majd majd... Te nagyon nem értetted meg daveoffot. Talán ha te is azért adtál volna 100+ ezreket vga-ra megjelenésnél mert megetted a rizsát, jelen esetben a mantlet, aztán semmi extra nem lett belőle, majd utána ha kezdeti árat nézzük, egy kicsit többért, egy jobb, gyorsabb kártyát kapsz, ami ráadásul az általad favorizált játékban dx11 alatt gyorsabb mint a másik mantle alatt, akkor kicsit másképpen tekintenél az egészre. Én rohadtul bíztam benne, első napos vétel volt vizezve a 290 aztán jöttek a csalódások...

Annyira bírom, hogy amd szemüvegen át annak kárára lehet csak a bétáról beszélni, fordítva nem. Úgy állítjátok, be hogy mintha az amd "fényéveket" fog gyorsulni a konkurencia meg marad ott ahol most van a béta-béta tesztel. Az gondolom fel sem merülhet, hogy ugyanez a különbség megmarad. Hát mért is merülhetne, hiszen nincsenek ígérgetések, magyarázkodások a másik oldalról.

Mikor fog végre az elő fordulni, hogyha valami nem kifejezetten amd-re van optimalizálva és béta-béta esetleg ott is teljesítenek valamit és nem kell mindig ugyanide vissza térni? Hogy majd driver, majd ilyen javítás, majd olyan jaívtás, aztán hoppá, csak odáig jutottunk mint a konkurencia. Sajnos évek óta ez megy. Ebből lett nekem is elegem és inkább oda kötöttem ki, amiről el lehet mondani, hogy szar, meg gyenge, meg eldobható, meg nem időtálló de mégis azt tapasztalom, hogy jobb, gyorsabb. Akkor miért foglalkozzak mással?

Az ilyen hardver sebessége kis mértékben szól bele dolog meg álomnak jó többnek nem. 21 században kapitalizmusban eleve megbukott, hogy majd évente fizetjük az új hardverre az alacsony szintű programozókat, vagy nem változtatunk évekig.

Nem akarok célozgatni, pár éve az is meg lett mondva vége a vga-k időszakának, jönnek az apu-k azok elegek lesznek mindenhez. Ma már poénként jó vissza emlékezni rá.

-

Habugi

addikt

Senki sem vitatta eddig se, hogy gyorsabb a GTX 980!

"Az egész úgy indult a buta maxwell mire képes. Olvass át mindent még egyszer.

"

"Pontosan, de mivel nem egyszereplős teszt volt 980ra, ottvan a mihez képest kérdése is, szemlátomást üzembe is lépett.

Én csak az alábbi kijelentésekre értettem a hordalék jelzőt:"Azt szerintem elkönyvelhetjük, hogy a Mantle 1000%, hogy elveszti a létjogosultságát, úgyhogy ennyit a AMD nagy jövő képéről. Nálam ez a Mantle térítés verte ki a biztosítékot, akkor kezdett egyre ellenszenvesebb lenni az AMD. Up to 45% Faster......LOL"

Na látod itt például már működött a mihez képest, daveoff máris levonta a számára legkézenfekvőbb következtetést a Mantle kapcsán.

Nem nézegetnénk most béta*béta DX12 teszteket, ha nem jött volna (még mindig nincs egy éve..

Nem nézegetnénk most béta*béta DX12 teszteket, ha nem jött volna (még mindig nincs egy éve..  ) a Mantle, daveoffnak speciel egyenesen ellenszenves az AMD, mert a Mantléval "kikényszerített" DX12 alatt gyorsabb lesz a 980asa, ezúton is gratulálok!

) a Mantle, daveoffnak speciel egyenesen ellenszenves az AMD, mert a Mantléval "kikényszerített" DX12 alatt gyorsabb lesz a 980asa, ezúton is gratulálok!

Itt a következő:

"Ja DX12 alatt,de nem DX11 vagy mantle alatt... szóval ennél a dx12 csak jobb lehet... a másik kettő már aligha..."

Aligha, ugyan már 280X-el is gyorsabb kiforrott driverrel/oprendszerrel, node na..

Megvan a lehetősége annak hogy tévedek, de szerintem TTomax itt a 290X mantle eredményeit nézte, nem a 260X-ét..

Szintén a kolléga tollából:

"És mindenki h@lyének nézett... nyugi,ez is meg lesz magyarázva hogy nem is optimalizálták a drivert erre a tesztre dxx11ben hiszen ott a mantle... igaz ott is kaptak egy fülest,de az már biztos azért mert bugos.

"

"Ittis megvan a lehetősége annak, hogy tévedek és a fülest valójában egy jó tippre/ötletre értette!!

Megint csak a Mantle kapcsán.., szerintem itt sem a 260X eredménye kapta a figyelme fókuszát..

Ezért bátorkodtam mérni egyet Mantléval a 3éves Tahitin és kijött a béta extravaganza létjogosultsága.., esetlegesen megfűszerezve azzal amit Abu is megemlített a nekem szánt válaszában.

Abban tökéletesen egyetértünk, hogy szemlátomást a Maxwell ebben a béta extravaganzában szépen teljesít DX12 alatt IS!

Remélem most már érted amit mondani szeretnék/szerettem volna..

-

Asbee

veterán

-

HSM

félisten

Arra volt a teszt demó (úgy látszik ez sajnálatos módon nem jött át a prezentációból), hogy a DX11 mekkora gát, és mennyivel többre képes egy alacsonyszintű API, pl. a Mantle, vagy az annak nyomán megalkotott DX12. Nem tudom, ez miért meglepő, hogy a DX12 is hozza a gyorsulást.

Majd ha nem csak erre lesz teszt, meg nem béta OS/Driver/Program, akkor lesz miről beszélni. De legalább már a buta Mexwell is tudja, amit mondjuk egy Hawaii már egy éve is tudott. Bármi más még csak arra jó, hogy szájkaratézzunk rajta.

Bármi más még csak arra jó, hogy szájkaratézzunk rajta. -

Asbee

veterán

Ez nem természetesség kérdése a 980 jobb kártya mint a 290X. Az hogy daveoff megosztotta a saját tapasztalatát azzal megint nem tudom mi a bajod. A többi erre az új tesztre, ha lehet így nevezni irányult. Az egész úgy indult a buta maxwell mire képes. Olvass át mindent még egyszer.

-

Habugi

addikt

Ebbe így ebben a formában nem mennék bele, annak a jelentőségét azért gondolom érzed, hogy most Win7 alatt Manteban nem kicsit jobbat megy a 280X mint a 290X a tesztben, a béta Win10re hozott béta AMD driverrel?

Ezért kérdeztem azt amit és úgy ahogy, két lehetőség van, vagy brutális lassulás lesz AMD oldalon aminek nincs reális magyarázata vagy ezt a teszt így ebben a formában köbgyök.

Ettől még az örül vagy tulajdonít jelentőséget neki aki akar, semmi közöm hozzá!

(#3041) Asbee:

Te nem olvasod amit írtok vagy már annyira természetessé vált, hogy észre sem veszed?

-

Asbee

veterán

-

TTomax

félisten

Persze akkor alkalmas volt amikor még csak DX11 volt... most már hirtelen nem az,sőt kétszer se adja ugyanazt... szép mese...Persze egy évig amíg a vörös (idéznélek)hordalék jött jó is volt ez a teszt...

Azért jó látni,hogy a tesztben a buta maxwell azonos fogyasztással 50%al jobb.. na az a nem semmi...

-

Habugi

addikt

Értem, köszönöm.

Pusztán azért kérdeztem/futattam le, mert a teszt VGA-kat hasonlít össze a béta extravaganza közben és ennek hatására itt is elkezdődött megint a "mennyit kap a 290X a GTX 980tól" hordalék áramlása.

Gyorsan lemértem, hogy a 280X-től is kap rendesen..

Akkor jól sejtettem, hogy fapfapra tökéletesen alkalmatlan, persze izlések és pofonok.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Asbee

veterán

-

Abu85

HÁZIGAZDA

Ez a teszt valójában nem arra készült, hogy VGA-kat lehessen összehasonlítani. Erre a teszt fejlesztője is felhívta korrábban a figyelmet. Maga a tesztnek a varianciája magas. Két egymas utáni futtatással is lehet 30% az eredményen között. Emellett az is számít, hogy az egyes pathokban éppen milyen optimalizálás aktív. Ez igazából egy belső engine teszt a fejlesztőknek, csak kiadták, hogy megmutassák a világnak, hogy nem kamuznak, amikor arról beszélnek, hogy a motorjuk 100k batcht lezavar 60 fps-sel.

-

Habugi

addikt

Ugyan tudom, hogy ez a teszt a béta oprendszer, béta API-jának, béta softver alatt történt béta driverekkel mért eredményeit listázza, de az imént megint letöltöttem az SW-t és Mantle+Extreme alatt ezt hozta Omegával:

===========================================================

Oxide Games

Star Swarm Stress Test - ©2013

C:\Users\XretsIm\Documents\Star Swarm\Output_15_02_07_0050.txt

Version 1.10

02/07/2015 00:50

============================================================= Hardware Configuration =================================

GPU: AMD Radeon R9 200 Series

CPU: AuthenticAMD

AMD FX(tm)-8320 Eight-Core Processor

Physical Cores: 4

Logical Cores: 8

Physical Memory: 8586989568

Allocatable Memory: 8796092891136

============================================================= Configuration ==========================================

API: Mantle

Scenario: ScenarioFollow.csv

User Input: Disabled

Resolution: 1920x1080

Fullscreen: True

GameCore Update: 16.6 ms

Bloom Quality: High

PointLight Quality: High

ToneCurve Quality: High

Glare Overdraw: 16

Shading Samples: 64

Shade Quality: Mid

Deferred Contexts (D3D11): Disabled

Small Batch Optimized (Mantle): Enabled

Temporal AA Duration: 16

Temporal AA Time Slice: 2

Detailed Frame Info: Off

============================================================= Results ================================================

Test Duration: 360 Seconds

Total Frames: 20943Average FPS: 58.17

Average Unit Count: 4399

Maximum Unit Count: 5648

Average Batches/MS: 918.88

Maximum Batches/MS: 3806.05

Average Batch Count: 17681

Maximum Batch Count: 140211

===========================================================Ez egy 280X..

RTS Modeban még nem néztem meg, de 13FPS-t rakott a 290X nyakába Followban...

Jól érzékelem a "béta extravaganza" értelmét vagy esetleg reális az, hogy a 290X (így az én 280X-em is..) még Mantle alatt is durva visszaesést fog produkálni a jövőben?

-

HSM

félisten

Köszi Abu85! A leírtak sokmindent megmagyaráznak.

-

Abu85

HÁZIGAZDA

A DX11 lehet jobb, mert nagyon régi a kód. A deferred context bekapcsolására szétfagyott. A Nitrousban ezt már javították, csak nem volt értelme berakni a StarSwarmba. A Mantle is fejlődött az elmúlt egy évben. Mivel ez csak egy teszt, amire eddig nem épített senki, nem volt értelme folyamatosan fejleszteni. Az Oxide számára fontosabb a fejlesztés alatt álló játékuk.

-

Abu85

HÁZIGAZDA

Ahogy többször is mondtam, low-level API-val a hardver sebessége kismértékben szól bele az eredménybe. Az optimalizálás számít.

Azt tudni kell, hogy a DX11 és Mantle kód egy évvel öregebb. De ez csak a StarSwarmra igaz, a Nitrousra nem, csak nem volt fontos frissíteni a StarSwarmot, mert az AMD a GDC-n egy másik demót mutat be. Az MS és az NV demózza a StarSwarmot. -

-

Asbee

veterán

Ez nem szájkarate, te mondtad, hogy a maxwell eldobható, nem időtálló, gyenge. Nem úgy néz ki, ha már egy béta 0. tesztben is ilyen. Ja hogy az ő szempontjából nem lehet így nézni, de a 290x szempontjából lehet úgy nézni. És ezzel nem azt mondom a 290x nem fog gyorsulni, csak a jövőképed a maxwellel már most megdölni látszik egy béta 0. tesztből.

-

daveoff

veterán

Azt szerintem elkönyvelhetjük, hogy a Mantle 1000%, hogy elveszti a létjogosultságát, úgyhogy ennyit a AMD nagy jövő képéről. Nálam ez a Mantle térítés verte ki a biztosítékot, akkor kezdett egyre ellenszenvesebb lenni az AMD. Up to 45% Faster......LOL

A 980-al egy messze kiegyensúlyozottabb kártyát kaptam, mint a 290X, minden téren. Mindkettőt megjelenéskor vettem, a ref 290X ~160k volt, a custom(MSI Gaming) 980 pedig ~180k, nekem a 20k különbség bőven megéri azt, hogy nincs semmilyen téren szenvedés a kártyával. Nincs semmi humbuk, meg majd egyszer jó lesz, hanem csak egyszerűen hozza amit kell, és ennyi.....

-

HSM

félisten

Windows 10-re melyiket is felesztik évek óta? Egyiket sem...

Komolyan ez egy PREVIEW, semmi sem végleges még benne kb. Arról sem tudunk még semmit, miért jobb annyival a CPU-teljesítménye a DX12-nek, mint a Mantle-nek. Ha jól értem, a CPU-kezeléshez is köze van.

Nem tudhatjuk, milyen előnyei vannak a Windows10-nek, DX12-nek, amit még akár nem építettek be se a DX12 driverbe, se a Mantle driverbe AMD-ék. Vagyis, itt már inkább magába a játék/teszt kódjába a fejlesztők. -

HSM

félisten

válasz

daveoff

#3009

üzenetére

daveoff

#3009

üzenetére

Maradjunk ennyiben:

"Windows 10 itself is still feature-incomplete, so what we’re looking at here today doesn’t even qualify as beta software. As a result today’s preview should be taken as just that: an early preview. There are still bugs, and performance and compatibility is subject to change" -

daveoff

veterán

Ez a buta Maxwell mikre nem képes......

The DirectX 12 Performance Preview: AMD, NVIDIA, & Star Swarm

-

mckay

aktív tag

Uhh, köszi!

Ez tök hihető, ki fogom próbálni!

Ha nem találom meg a madzagot, szerintem át lehet hidalni.

Bár az elgondolkodtató, hogy az alaplapomon hárm tüske van az SPDIF-nél:

Pin Description

1 VCC

2 SPDIF OUT

3 Ground

míg a képen látható madzag csak két eres, és a kártyán is látok egy két eres csatlakozási pontot.

Na majd kitalálom, kit kivel.

-

HSM

félisten

Régi Nv kártyákban nem volt hangeszköz HDMI-hez, és gyanús, hogy a kártyád gyári tartozékai között szerepel S/PDIF kábel.... Sanszosan az alaplapi SPDIF kimenetet kell rákötnöd a kártyára, akkor fogja tudni HDMI-n kiadni a hangot. Az AMD volt, aki jóval előbb bevezette ez a kábeles bohóckodás helyett, hogy hangeszközt tett a VGA-ra, és így nem kellett trükközni, és külön eszközként megjelent a HDMI-hang.

Mellesleg HDMI-n Nv-hez skszor kell driverben is állítgatni, ha teljes színskálát akarsz. Remélhetőleg megírják a fórumtársak a menetét, én sosem használtam.

-

mckay

aktív tag

...na ez most nagy off lesz talán, de nem találtam jobb helyet, ahol a kérdésemet feltehetném...

Sziasztok!

Vettem egy [nVidia 9500] kártyát.

Merhogy csak legyen már mese a tévében olyankor is, amikor nincs.

Vagyis a gépem TV-re kötéséhez, játék semmi.

De a HDMI-n nincs hang!

Nyilván a legfrissebb driver van fent, amit az nVidia oldaláról töltöttem le.

És nyilván gugliztam is, mielőtt segítséget kérnék, de nem találtam valódi megoldást!

Pedig sokan vannak vele így...

Igazából nem most vettem ezt a kártyát (használtan), hanem még tavasszal.

Már akkor sem sikerült a hang, de gondoltam, hogy talán az a bibi, hogy Win 8 alatt próbálkozok, no meg hogy korábban más kártyák (Radeon) is voltak a gépben, szóval valami registry-s elfajzásra gondoltam, s feladtam: került bele újra egy AMD, és azzal azonnal lett hang, szóval jó volt.

Most viszont újratelepítettem a gépet, immáron Win 7, és a lényeg, hogy az első pillanattól ez az nVidia kártya van benne. És mondanom sem kell, remekül működik, szép a képe, de...

Szóval fel akartam melegíteni az nVidia-s filmnézés dolgot, és lássak csodát, Win7 alatt sincs hang a HDMI-n! Szégyenszemre az alaplapi hangkimenetre kötött hangszórócskákkal tudtuk megnézni az első filmet az nVidia-val...

Srácok! Most akkor mi ez a szösz? Hogy lehet, hogy két darab, egyformán nem mai évjáratú, egyformán pár ezer forintos videókártya közül az nVidia nem ad hangot, míg az AMD meg igen???

Meg kéne oldani, mert azt az AMD-t elajándékoztam...

-

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Samsung Galaxy Watch8 és Watch8 Classic – lelkes hiperaktivitás

- Arc Raiders

- AMD Ryzen 9 / 7 / 5 9***(X) "Zen 5" (AM5)

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- Folyószámla, bankszámla, bankváltás, külföldi kártyahasználat

- gban: Ingyen kellene, de tegnapra

- "Krémes" kopogással és pajkos külsővel hódítana a Yunzii klaviatúrája

- Mobil flották

- Filmgyűjtés

- 3D nyomtatás

- További aktív témák...

- ÚJ Apple Airpods Pro 3 - www.stylebolt.hu - 1 Év Apple garancia - 27 százalékos Áfá-s száma !!!!

- ÁRGARANCIA!Épített KomPhone i5 14600KF 16/32/64GB RAM RTX 5070 12GB GAMER PC termékbeszámítással

- REFURBISHED - Lenovo ThinkPad 40AF Dock (DisplayLink)

- Eredeti Lenovo 90W szögletes (téglalap) notebook táp + kerek átalakító egyben eladó

- Beszámítás! VALVE INDEX virtuális valóság szemüveg garanciával hibátlan működéssel

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

A nem oda való embereket már kidobták a fórumról

A nem oda való embereket már kidobták a fórumról

jah nem, mégse.

jah nem, mégse.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Ja, igen, és pre-pre.pre OS-en. No comment.

Ja, igen, és pre-pre.pre OS-en. No comment.