- gerner1

- Luck Dragon: Asszociációs játék. :)

- eBay-es kütyük kis pénzért

- Elektromos rásegítésű kerékpárok

- Candy: IGPU dGPU passthrough, avagy a nem minden arany, amin megy a Furmark

- sziku69: Szólánc.

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- MasterDeeJay: Asus Q170M-C coffeetime mod!

- Sub-ZeRo: Euro Truck Simulator 2 & American Truck Simulator 1 (esetleg 2 majd, ha lesz) :)

- sziku69: Fűzzük össze a szavakat :)

Új hozzászólás Aktív témák

-

-

HSM

félisten

170W-ról 120W-ra csökkent a TDP a 7950-hez képest, illetve mások is azt mérték, hogy a 7950X3D igen takarékos lett, míg a 13900K elég lelkesen veszi magához az energiát...

Pl. [link] , ~500W helyett 280W Blender-t mértek a két CPU között. Hasonló arány lett a linkelt TPU tesztben is.

Pl. [link] , ~500W helyett 280W Blender-t mértek a két CPU között. Hasonló arány lett a linkelt TPU tesztben is.

Saját tapasztalatom, hogy már az 5600-as Ryzen is igen takarékos tudott lenni, ami a közvetlen előd és elég hasonló sok szempontból. Átmenetileg nem volt venti a toronyhűtőmön, visszavettem 50W limitre, hát elég emberes tempót villantott úgy is... De pl. Witcher3 alatt is 350W körül mutat a fogyasztásmérő egy alulfeszelt+tuningolt 6800XT-vel monitor nélkül.

De pl. Witcher3 alatt is 350W körül mutat a fogyasztásmérő egy alulfeszelt+tuningolt 6800XT-vel monitor nélkül.

-

HSM

félisten

válasz

GeryFlash

#46270

üzenetére

GeryFlash

#46270

üzenetére

Fele fogyasztásból mindezt [link] .

Ez azért nem piskóta, ráadásul az ütemező tévedésének is sokkal kisebb ára van a 7950X3D-n. Ha elrontja, csak szimplán nagyon gyors lesz.

Ez azért nem piskóta, ráadásul az ütemező tévedésének is sokkal kisebb ára van a 7950X3D-n. Ha elrontja, csak szimplán nagyon gyors lesz.

Szerintem egy nagyon jó productivity+gaming CPU lett.

Akinek meg csak gamingre kell, hamarosan jön a 7800X3D, annál már az ütemező sem fog tudni tévedni.

Akinek meg csak gamingre kell, hamarosan jön a 7800X3D, annál már az ütemező sem fog tudni tévedni.

-

Pipó

őstag

Vajon miért nem a 7800X3D-vel kezdték a bevezetést? Az még jól is elsülhetett volna. Olyan sok sikerélményük volt mostanság, hogy inkább túlkombinálták.

-

GeryFlash

veterán

válasz

Gyuri27

#46277

üzenetére

Gyuri27

#46277

üzenetére

,,Mint ahogy előttem irták. Ms feladatütemező. Ha az ms nem csinálja meg (ahogy a multkor se) akkor az amd-nek kell."

Oke az MS hibaja amit az AMD is javithat, akkor miert nem tette meg startig? Miert most dolgoznak a fixen es nem korabban, miert erte oket varatlanul hogy nem lesz jo a feladatutemezo.

Egyebkent leirtam, hogy en varom az uj chipset drivert/ 3D V-Cache Optimizert mert latok ra eselyt hogy az jelentos boost lesz, a problemam az hogy ezt miert nem lehetett starta. Igen, az Intel is benezte, a difi hogy ott nem volt mosdatas. -

Busterftw

nagyúr

válasz

Gyuri27

#46287

üzenetére

Gyuri27

#46287

üzenetére

Olvastam rola, hiszen mint irtam, launchkor Alder Lake-t vettem ahogy sokan masok is a forumon, ajanlom a topikot.

A gondot a DRM okozta, amit az Intel a Microsofttal es jatek keszitokkel megoldott.Ezen kivul senki nem varta a "drivert" mint a messiast es mosdatta az Intelt a tesztek alatt.

-

válasz

GeryFlash

#46268

üzenetére

GeryFlash

#46268

üzenetére

Szerintem energiahatékonységban nagyot lépett előre, sok potenciál van benne később akár lapos workstation akár NUC fronton is, Desktop vonalon meg egyértelműen a csúcsot képviseli. Nem kérdés ha kettő közül kellene választanom a 7950 lenne a befutó az Intellel szemben meg főleg.

Szerintem ebben most tényleg benne van a javítás és a későbbi gyorsulás lehetősége, mondjuk az tényleg érthetetlen, hogy miért kapkodtak így kiadni, ha driveres problémák vannak.Ár / értékben általában szerintem nem a csúcs CPU-k a legjobbak hanem az eggyel- kettővel alatta elhelyezkedők.

-

Gyuri27

félisten

válasz

GeryFlash

#46270

üzenetére

GeryFlash

#46270

üzenetére

Én 750 eurót látok. Itthon 370k.

A 7950X 610 euró. Itthon 240k.

[link] ez itt csak a k. Szép fogyasztás.

1440p-ben 13900k vs 7950x game diffi 6%.De amd köpködés helyett meg kellene várni a rendes teszteket. Rendes driverrel nyilván.

keIdor: az ms ütemezője az összes ryzennel vakon van kb. Igaz kékek kis nagy magjaival se tudott az elején mit kezdeni.

-

GeryFlash

veterán

Jelenleg ott vagyunk hogy nem hogy gyalazas nem lett de konkretan ugyanott van a 7950X3D mint a 13900KS, 5% difik vannak hol az egyiknek hol a masiknak a javara. Mindezt ugy hogy a 7950X3D 700 dollar a 13900KS meg 580 dollar. De legalabb a motherboard olcso az AMD-hez

Hihetetlen hogy 3D cache-sel, 2 szinttel jobb gyartastechnolgiaval is ennyire futja. Azert en meg bizok a szoftveres fixekben, mert ez nagyon elmaradt eddig minden varakozastol. -

GeryFlash

veterán

AMD Ryzen 9 7950X3D Benchmark + 7800X3D Simulated Results

,,A quick note. People are making the incorrect assumption that we didn't use the latest AMD chipset driver and 3D V-Cache Optimizer.... we did. AMD are aware of the performance related issues with the 7950X3D in some games and are working on a fix."

Csak egyszer sikerulne valamit jol kiadniuk

-

GeryFlash

veterán

válasz

Petykemano

#46264

üzenetére

Petykemano

#46264

üzenetére

Errol a chartrol osszesen ennyit kell tudni: [link]

Nem tudom mi a nagyobb problema, hogy semmihez nem erto de mindenhez hozzapofazo consultant g*cik ilyen preziket gyartanak, vagy inakbb az hogy az IT/Tech szaksajto ezeket kritika nelkul atveszi es spreadeli. -

Petykemano

veterán

válasz

Petykemano

#46263

üzenetére

Petykemano

#46263

üzenetére

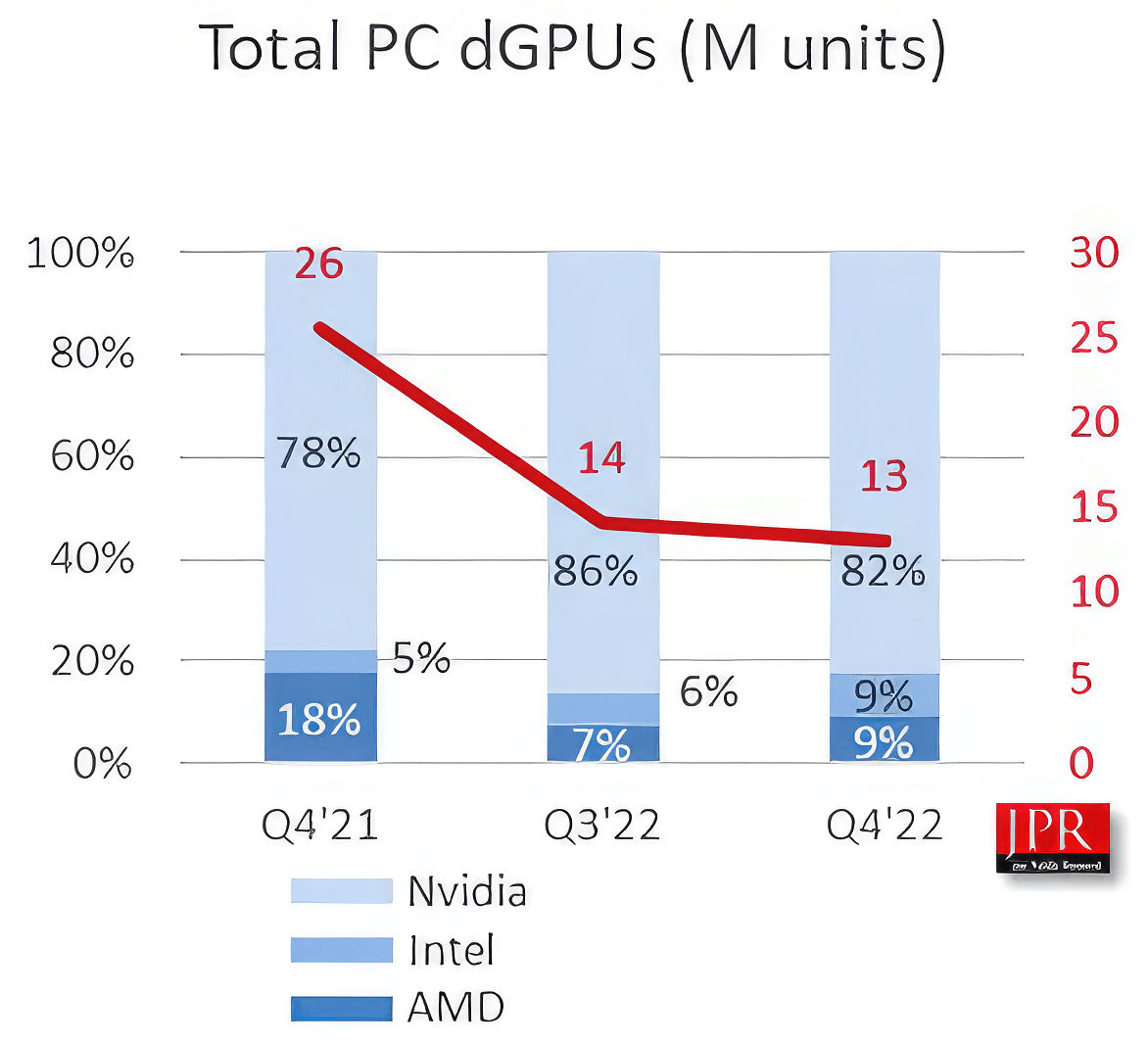

Ez még ide tartozik

Az valószínű, hogy az Intel nem a dobozos dGPU-k piacán szedi össze a 9%-os részesedést, hanem notebookokban, prebuilt gépekben.

Abu az AMD részesedésének visszaesését azzal magyarázta, hogy felhagytak a 14nm-es Polaris 14 gyártásával. De végső soron akkor nem igazán sikerült pótolni.

Így vagy úgy, de egyelőre úgy néz ki, hogy az Intel belépése valóban nem az Nvidia részesedésébe harapott bele, ahogy azt az alapján várni lehetett, hogy milyen gyakori az Intel+Nvidia kombináció, hanem az AMD részesedésébe. -

Petykemano

veterán

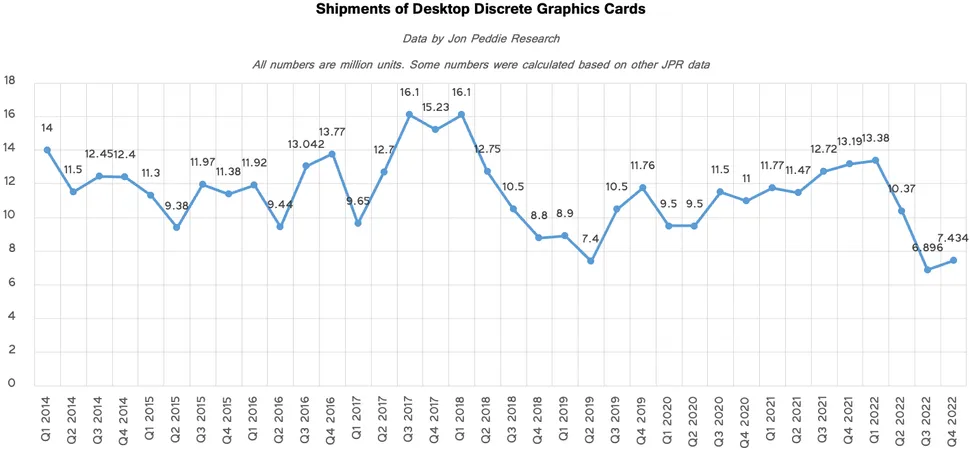

JPR (Jon Peddie)

Q4-re megállt a GPU eladások esése.

Persze tegyük hozzá:

- az összes elemzés szerint a mostanihoz képest decemberben még jobb árak voltak.

- ünnepi szezon volt. Az elmúlt évek legalacsonyabb volumenét produkáló ünnepi szezonja. Ehhez képest a Q1 20-25%-os visszaesést szokott produkálni. (Kivéve persze 2020-2021, amikor a kriptovalutáknak minden nap karácsony volt)Persze recesszió, infláció és szankció is van, de az elmúlt 8 év egészét tekintve szerintem kijelenthetjük, hogy nem volt igaz, hogy a GPU vásárlók zsebében van pénz és el is lehet kérni ugyanazért többet - mármint persze abban az értelemben, hogy piac jellegének, volumenének átalakulása nélkül.

Ez különösen a 2017 előtti időszakra érvényes, amihez képest a 2022Q3-Q4 a kb dupla mértékű áraival feleakkora volument produkált.

Itt gyorsan hozzá is teszem, hogy 2017 és 2018 természeten egy outlier, mert 2017 táján is volt kriptoboom, amit alacsony árak követtek. Máskülönben az Nvidia 2018-ban a Turinggal kezdte az áremelési ciklust, ami meg is látszott a volumenen, amit csak a 2019Q3-ban elérhetővé vált RDNA és arra válaszul kiadott Super széria által teremtett verseny pezsdített fel újra. -

HSM

félisten

válasz

Petykemano

#46259

üzenetére

Petykemano

#46259

üzenetére

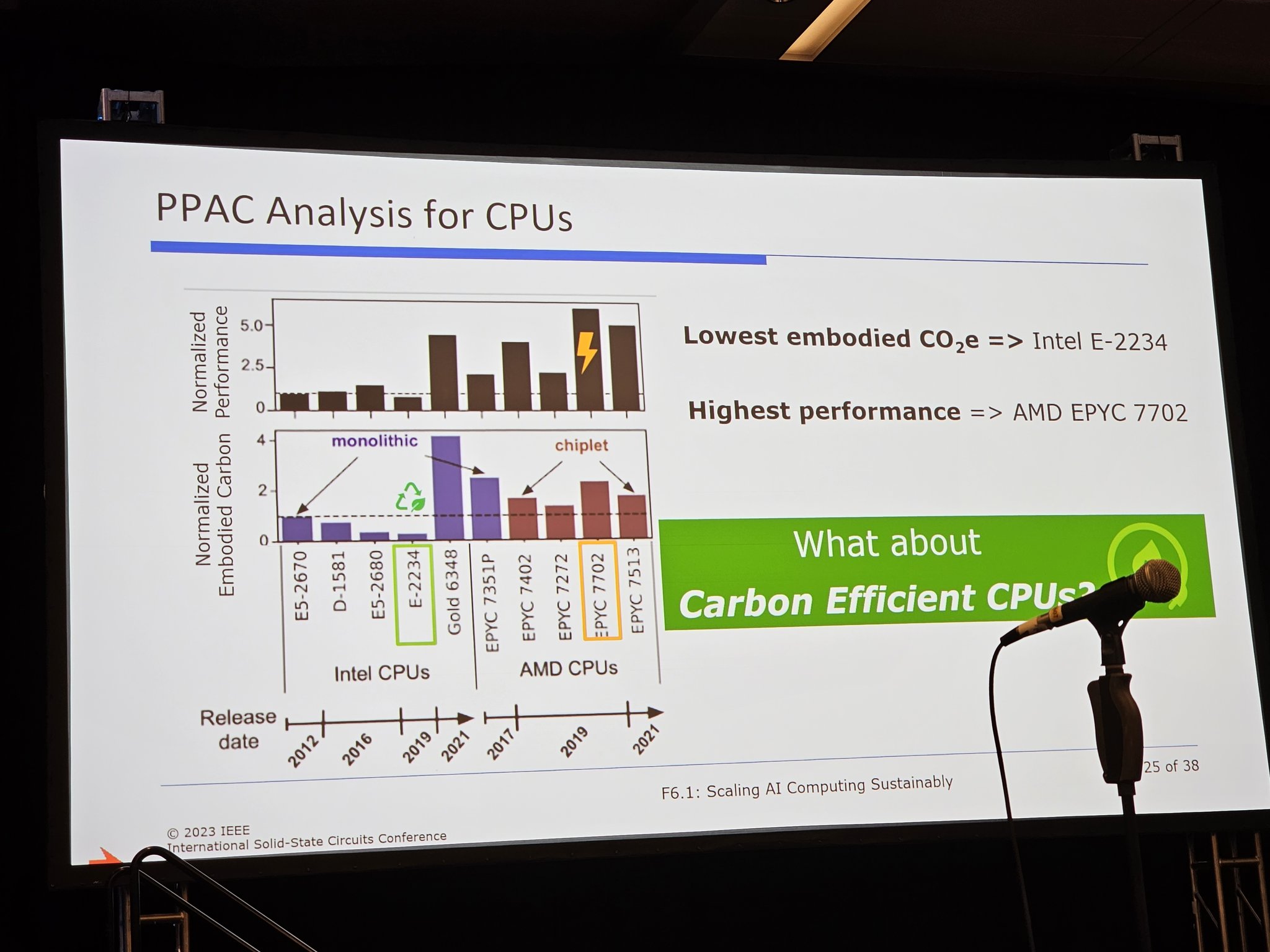

A dia szerzőjének oldaláról vetül fel a kérdés, miért éppen ezeket választotta ki, és miért emelte ki a csiplet kialakítást illetve a 2234-est és 7702-est?

Abból a szempontból értem, hogy ezek a legkisebb TCO2, és legnagyobb teljesítmény, de így úgy tűnik, mintha ezek minden további nélkül összehasonlíthatóak lennének...

Abból a szempontból értem, hogy ezek a legkisebb TCO2, és legnagyobb teljesítmény, de így úgy tűnik, mintha ezek minden további nélkül összehasonlíthatóak lennének...

Nem voltam ott az előadáson, így a továbbiakat passzolom. -

HSM

félisten

válasz

Petykemano

#46254

üzenetére

Petykemano

#46254

üzenetére

Köszönöm!

Megvannak a válaszaim... Tartottam tőle, hogy ezt fogom látni. Kicsit az a benyomásom, hogy a konklúzióhoz válogatták a résztvevőket... Lássuk a TCO2 bajnokot, egy négymagos CoffeeLake.

Lássuk a TCO2 bajnokot, egy négymagos CoffeeLake.

Igen, egy 71W-os, ehhez képest csigalassú 14nm+++++ CPU [link] 2019-et reprezentálva.

Igen, egy 71W-os, ehhez képest csigalassú 14nm+++++ CPU [link] 2019-et reprezentálva.

Ezzel persze nincs is az égvilágon semmi gond, a gond azzal van, hogy miért nem szerepel a konkurenciától bármi olyan CPU, ami ennek akár távolról is ellenfele lenne? Merthogy egy 128 sávos PCIE hubos 8 csatornás kőkemény szerver CPU, amiket melléraktak Epyc-eket többfélét is nyilvánvalóan egészen más karbonlábnyommal fog dolgozni, mint egy notebookokból szabadult mini-CPU, 16 sávos IO-val, 2 memória csatornával.

Egy reális ellenfél 2019-ből, ha már chiplet, egy 3900X/3950X lett volna, ami sajnos nem szerver, de ha már erőltetjük a megközelítést, akkor egy reálisabb ellenfél, az máris árnyaltabb képet mutat [link] , és ez a 3900X nagyon nem hatékony működésre volt ám optimalizálva....

Az is jól látszik, hogyha már méltó ellenfél, a 6348-as 'valódi szerver' felszereltségű Xeon hiába monolitikus, lényegesen nagyobb a lábnyoma, mint bármelyik chipletes megoldásnak.Én azt gondolom, hogy ebből az a konklúzió, hogy ezek a rengeteg PCIE sávos és memória csatornás monstrumok bizonyos metrikák szerint kevésbé hatékonyak lehetnek, mint egy nagyon minimalista IO-jú megoldás. Viszont nem véletlenül használnak sok területen ilyeneket, ha kell az IO is, akkor nem tudsz mit tenni. De mindenképpen hasznos, ha odafigyelnek a cégek a nagy adatparkok teljes környezeti lábnyomára, és ebbe az irányba is fejlődnek majd a cégek.

A chiplet megközelítés éppen emiatt "környezetbarát", alacsony ráfordítással akár többféle IO kiépítéssel is körítheted ugyanazt a CPU magot, ha van rá piaci igény. Az említett 3900X-ben ugyanazok a CCD-k, mint a szerver EPYC-ekben, csak kevesebb IO-t tartalmazó IOD-vel. Sőt, még a 15W-os notebook CPU-k alapja is ugyanaz a fabric, csak integrálva. Ez azért óriási megtakarítás sok szempontból a monolitikushoz képest, minden téren.

Ehhez képest minimális többlet fogyasztás csak az ár a fabric részéről, bár tény, hogy egy rengeteg CCD-s kiépítésnél a fabric már nagyságrendileg hasonlóan is fogyaszthat, mint maga a CPU, lásd pl. [link] .

Ehhez képest minimális többlet fogyasztás csak az ár a fabric részéről, bár tény, hogy egy rengeteg CCD-s kiépítésnél a fabric már nagyságrendileg hasonlóan is fogyaszthat, mint maga a CPU, lásd pl. [link] .

-

palfitom

félisten

válasz

VoltanIgor

#46255

üzenetére

VoltanIgor

#46255

üzenetére

Van olyan

-

palfitom

félisten

válasz

VoltanIgor

#46248

üzenetére

VoltanIgor

#46248

üzenetére

Egy 2013-as hsz-re reagáltál...

-

HSM

félisten

válasz

Busterftw

#46251

üzenetére

Busterftw

#46251

üzenetére

Logisztika... Rendkívül apró és könnyű dolgokról beszélünk, amiknek a szállítása így énszerintem eléggé környezetbarát. Ezzel szemben az előállításuk rendkívül energia és nyersanyag igényes legjobb tudomásom szerint. Így naívan azt gondolnám, pl. az AMD megközelítése, hogy igen magas kihozatallal gyárt picike CCD-ket friss gyártástechnológián és hozzá egy már nagyon erősen bejáratott technológián szintén magas kihozatallal IOD-t, nekem éppen rendkívül környezetbarátnak és költséghatékonynak tűnik.

Ezért is lennék kíváncsi, hogyan jutottak erre a konklúzióra.

-

HSM

félisten

válasz

Petykemano

#46249

üzenetére

Petykemano

#46249

üzenetére

A csipletes mitől lett rosszabb a monolitikusnál? Én éppen fordítva gondolnám, a monolitikus már a magasabb selejtarány miatt problémákba kellene ütközzön nagyobb csipeknél.

Persze, nyilván van egy sweet spot, 128 mindenképpen magot pazarlóbb összekötni, szinkronban tartani, mint mondjuk 8-at.

-

Petykemano

veterán

TCO2 - Total Cost of Karbonlábnyom

Elvileg a Meta állt elő egy "újfajta" (legalábbis eddig ritkán firtatott), zöld mutatóval, ami a környezezettudatosságot emeli egy olyan szintre azáltal, hogy a szerver infrastruktúra választásban nem csak az energiahatékonyságot és az számításhoz szükséges energia karbonlábnyomát, hanem már az adott szerver chip előállításához szükséges CO2 kibocsátást is figyelembe veszi.Ezen mutató alapján a kompakt monolitikus CPU-k a legkörnyezetbarátabbak, míg a chipletekből összeállított verziók pazarlók, környszezetszennyezők.

A "TCO2" egy új komolyan veendő irány, egy valóban fontos szempont, amely meghatározhatja a jövőt,

vagy ez szerver/cloud-mogulok új szeszélye, egy új, zöld buzzword, vegánság a techpiacon

vagy ez az új Intel marketing stratégia (ami aligha lehet, mert az utolsó két (?) termékkel ők is vastagon érintettek)

vagy valaki a Metánál próbálja ügyesen elsikálni az elhibázott választást?

vagy a Meta próbálja magát zöldre festeni? -

VoltanIgor

aktív tag

válasz

DroiDMester

#50

üzenetére

DroiDMester

#50

üzenetére

Az miért baj, hogy nem a saját gépével mér? Nem értem.

-

Devid_81

félisten

AMD chipset drivers feature special game optimizations for Ryzen 9 7000X3D CPUs

Most ez akkor megint kerdeseket hagy maga utan, akik teszteltek vajon ezzel az uj driverrel teszteltek vagy enelkul?

Ma jonnek ki a reviewk elvileg

-

Petykemano

veterán

Amd vs Nvidia driver problémák - számokban

[link]Tldw

Ha a professzionális felhasználást kivesszük a képből, Nvidia driver problémából összességében valamivel több van, azonban ha a problémákat lebontjuk súlyosság/megoldhatóság szerint, akkor az AMD esetén valamivel több a nagy hatású, megkerülhetetlen probléma, míg az Nvidia esetén a közepes hatású probléma előfordulási aránya nagyobb. Persze nagyságrendi különbség nincs.

A kutatás egyértelműen, számokkal támasztja alá, hogy az AMD driver ugyan valamivel több fejfájást okozhat, de az a percepció, hogy az "Nvidia driver egyszerűen csak jó, az AMD driver meg szar" nem megalapozott.Az AMD driver talán valami hasonló jelenség áldozata lehet, mint amit a covid vakcinák esetén lehetett megfigyelni: az Astrazeneca oltásról futótűzként terjedt, hogy vérrögképződést okozhat, ezért olcsósága ellenére hamar elfordultak tőle más oltóanyagok felé. Már akkor is felvetődött, hogy az ilyen hírek felfújása a konkurens oltóanyag beszállítók érdekében állhat. A versenyben maradt oltóanyagokról pedig még manapság is derülnek ki, hogy egyébként azok milyen súlyos, akár halálhoz vezető mellékhatásokkal járnak (pl szívizomgyulladás) Valójában tehát egyik sem kockázatmentes, de a pánikkeltéssel sikerült az egyik oltóanyagot teljesen lejáratni.

-

[link]

Google forítóval elég értelmes fordítás jön ki és egy érdekes cikk van mögötte.

Úgy látszik azért a hátérben elég komoly taktika folyik mindegyik cég részéről.

Intel a TSMC vel szemben több pénzt szeretne és támogatást."Az amerikai székhelyű Intel azzal érvel, hogy több támogatást kellene kapnia, mint a külföldi cégeknek, valamint megkérdőjelezi, hogy a TSMC amerikai gyára tovább működhet-e, ha Tajvan válságba kerül."

"Az arizonai gyárépítéssel kapcsolatban a szintén támogatásra váró TSMC hangsúlyozta, hogy nem hatékony pénzköltés, ha a cég székhelye alapján határozzák meg a kedvezményes politikák végrehajtását. A TSMC támogatást is kapott egy nagy ügyféltől, az Advanced Micro Devices (AMD) cégtől."

Tehát AMD támogatja TSMC-t ,Intel ellenzi, AMD kételkedik/ támadja az Intelt és kétségbe vonjak hogy egyáltalán valaha utol tudják e érni a TSMC.t és hogy ígérgetés megy a háttérben. A támogatásból felhúzott gyárak sem működnek az előírásokkal szemben állítólag üresen állnak az Intelnél.

Érdekes Dolgok vannak kialakulóban.

Ha itt még betámadják Intelt ez miatt és súlyos milliárdokat kell vagy visszafizetnie anélkül hogy tudna gyártatni, vagy gyárindításba beruházni és közben TSMC elhappolja az Inteltől remélt bérgyártási bevételeket és megrendeléseket az valóban már súlyos csapás lehet az elkövetkező évekre..

Nem tudom hogy fognak dönteni majd Intelnél, de vagy el kell indítaniuk a gyárakat amiket állami támogatásból építettek és ez még nem is elég mert versenyképesnek kell lenniük bérgyártás terén TSMC vel, ami hatalmas kiadás, vagy vissza kell fizetniük az államtól kapott pénzeket mert AMD és még több Cég már számonkérte hogy miért nem működnek a gyárak és miért állnak üresen, miközben a törvény kötelezné őket az azonnali gyártásra.

Ezzel szemben Intel még több állami támogatást és pénzt szeretne. -

[Half-Life 1: Ray Traced]

Akinek megvan Steamen, annak innen elérhető Githubon:[link]

természetesen nem egy csoda, 25 éves játék, de érdekes dolog látni így. -

FLATRONW

őstag

válasz

huskydog17

#46238

üzenetére

huskydog17

#46238

üzenetére

Ezt könnyen ki lehet deríteni.

Mindkét kártyán 8 GB VRAM van.

Ha a PCIe 4.0 x16 5700XT nem lassúl be a 3.0-ás alaplapban, akkor a 4.0 x8 6650-nek sem kell gondot okoznia a 4.0-ás alaplap.

Tehát meg kéne nézni, hogy teljesít az 5700xt 3.0-ás alaplapban.Ilyenkor tényleg csak a memóriasávszélesség lehet a gond. 280 vs. 448.

-

bozont

veterán

válasz

huskydog17

#46238

üzenetére

huskydog17

#46238

üzenetére

Úgy hogy a PCIe 4@8x=PCIe 3@16x sávszélesség terén.

Nyilván nem kizárt a dolog, de nekem akkor is furcsa. Egy teszt alapján még nem vonnám le a következtetést.

Mondjuk az sokkal furcsább, hogy mire kell ennek a játéknak 8+GB vram még 1080p-ben is.

-

huskydog17

addikt

válasz

bozont

#46237

üzenetére

bozont

#46237

üzenetére

Hogy jön ide a PCI-E 3.0? 5700XT is PCI-E 4.0-ban működik a tesztben.

Az, hogy elég kell, hogy legyen" semmit nem jelent, egyrészt az elmélet és a gyakorlat két különböző dolog, másrészt könnyen lehet hogy a motornak kell a 16 sáv, hogy optimálisan működjön VRAM hiány esetén. Ez nem az első ilyen eset.

Ha a játéknak kevés lenne a sávszél, akkor minden esetben rossz lenne a sebesség és nem csak akkor, ha elfogy a VRAM. Az 1% percentile értékek is azért zuhantak be annyira, mert a 8 sáv csak annyit bír. Felesleges mást belelátni, mint ami. Az RX 5700 XT-nél is elfogy a VRAM, de ott sokkal jobb az 1% érték, mert ott 16 sáv tudja pumpálni az adatokat 8 helyett.

Ez egy klasszikus VRAM hiány probléma, amint írtam nem az első eset amikor a 6600-as szériánál megbosszulja magát a 8 PCI-E sáv.2023-ban ne csodálkozzunk már azon, hogy VRAM hiány esetén kevés lehet a PCI-E 3.0 x16 tempó.

-

bozont

veterán

válasz

huskydog17

#46236

üzenetére

huskydog17

#46236

üzenetére

Ha az 5700XT-nek elég a pcie 3@16x akkor a 6650-hez is elég kell hogy legyen. [link]

Valami más fogy el a kártyánál. Lehet éppen memóriasávszél. A 6650XT 280GB/s, míg az 5700 XT 448 GB/s. -

huskydog17

addikt

válasz

Yutani

#46234

üzenetére

Yutani

#46234

üzenetére

Pedig szerintem teljesen logikus és nyilvánvaló, nem véletlen írja a CB szerkesztősége is ezt a probléma forrásának.

Minden VGA-t a tesztben PCI-E 4.0-n teszteltek. Minden VGA 16 PCI-E sávval rendelkezik kivéve a 6650-est. Ha a textúrákat visszaveszik, akkor a 6650-en is helyreáll a sebesség. Tipikus VRAM elfogy jelenség.

Ha ebben a játékban max grafikán akarsz játszani, akkor nagyon erősen ajánlott a 16 PCI-E sáv. Nem lenne gond a 6650-nek se, ha az AMD javította volna a memóriatömörítést. Ez már jónéhány generáció óta jobb a zöld oldalon, ez csak egy újabb példa rá.

Az RX 5700XT is pont azért gyorsabb picivel a 6650-nél, mert az 16 PCI-E sávot tud használni.

Mivel az AMD VRAM menedzsmentje kevésbé hatékony, mint a zöldeké, így a piros kártyák jobban rá vanna kényszerítve a PCI-E busz használatára. Egyszerűen ennek a motornak kell a 16 sáv.

Ha az általad említett 128 bit+Infinity Cache kombó lenne a bűnös, akkor nem állna helyre a sebesség a textúraminőség csökkentésével. Csakhogy ez esetben helyreáll a sebesség, mert egyszerűen max textúrákkal kifut a 8 GB-ból. -

Petykemano

veterán

válasz

Yutani

#46234

üzenetére

Yutani

#46234

üzenetére

Pedig a jelenség nagyon hasonlatos ahhoz, amit az 5500XT 4GB esetén lehetett látni.

Nem láttam ilyen gyártó és felbontásonkénti bontásban prezentált VRAM igény táblázattal, de élek a feltételezéssel, hogy a 8GB-ba épphogy nem fér bele. PIcit kilóg. A picit kilógást a PCIE még tudja kompenzálni, de mivel a PCIe lassabb a kellettnél, ezért a kompenzációs hatás is enyhe.

Ugyanez történt a 4GB az 5500XT esetén is, csak ott a 4GB volt ez a határ. -

Yutani

nagyúr

válasz

huskydog17

#46230

üzenetére

huskydog17

#46230

üzenetére

Pedig PCIe 4.0-án tesztelik az RX 6650 XT-t, mégis kevés neki a 8x sáv? Mivel az 5700 XT-t is alulteljesíti, lehet erre gondolni, de én inkább a 128-bit memória és az Infinity Cache körül nézelődnék.

-

proci985

MODERÁTOR

az. egyebkent utobbi hetekben nekem tobbszor is volt "the future is now, old man" erzesem.

sajnos nem birt hirertekkel, mondjuk ahogy nezem communityn belul se egyertelmu, hogy eppen mekkora ugras megy vegbe.

es akkor gondolj bele, hogy gpt3.5 is MS par honapja. kovetkezo visualstudio hiperurugras lesz workflow szempontbol.

Petykemano: enterprise cucc

-

[Microsoft and NVIDIA announce expansive new gaming deal]

Érdekes fordulat. Kíváncsi vagyok a következő generációs Xboxra( hardver alapjaira) mikor világítanak rá ,tekintve hogy 10 évre a COD jogait is engedték Nintendo platformra, ami Nvidia hardverre épül jelenleg.

Lehetséges lehet egy hardveres megállapodás is?

Ha így lenne akkor az Xbox , Nintendo + PC gamer piac egyben elég komoly biznisz lenne Nvidiának. -

huskydog17

addikt

Company of Heroes 3 - ComputerBase teszt

Ha szabad 1-2 észrevételt tenni a teszttel kapcsolatban:

1. a sebességgel semmi gond nincs, még egy sima RTX 3060-as is elegendő a 1080p max gafikához (60 fps). 1440p-ben egy RTX 3060Ti vagy Radeon RX 6700XT is elegendő, sőt egy ARC A770 is. A játékban kiválóan teljesít az Arc A770, ami hozza a 3060Ti tempóját. 4K felbontáshoz egy sima "öreg" RTX 3080 is elegendő.

2. VRAM igény is barátinak mondható: 1440p felbontásig elegendő a 8 GB, kivéve a Radeon RX 6600 szériát* (lásd 3. pont). 4K felbontáson 10 GB kell a max grafikához.

3. Radeon RX 6600 sorozat különösen rosszul teljesít ebben a játékban, aminek egyszerűen a felezett PCI-E sávok az oka. Már 1080p-ben is jelentősen le van maradva egy mezei 3060-tól, de 1440p-ben olyan durván összeomlik a sebesség a 8 PCI-E sáv miatt, hogy még az Arc A770 is bő 80%-al gyorsabb. Ez tehát egy újabb játék, ahol az AMD értelmetlen PCI-E sáv spórolása megbosszulta magát.

4. A játék nem tartalmaz se RT-t, se a három felskálázási eljárást (DLSS,FSR,XeSS), azaz teljes mértékben hagyományos alapokra épül (Essence Engine 5)

5. Frametime-okkal semmi probléma nincs és semmilyen random akadás sincsSzerintem elég korrekt PC verzió lett. Az viszont érdekelne - ez sajnos nincs megemlítve a linkelt cikkben -, hogy a 30 fps animációkat javították -e. Az Age of Empires 4-ben ugye ugyanez a motor van és ott kicsit ciki, hogy az épületek ha összedőlnek, akkor az az animáció csak 30 fps-el megy.

-

Petykemano

veterán

árak: [link]

eléggé stagnál minden. Továbbra is.

A nyár vége felé volt egy kis esés és ennyi.Ami csak azért érdekes, mert - ahogy a videoban is elhangzik - ha az új generáció tetejét úgy vezeted be, hogy a magasabb teljesítményért magasabb árat is kérsz, akkor az semmilyen nyomást nem fog helyezni a korábbi generációs / lejjebb levő termékek árazására.

És végülis ez látható.Ami csak azért érdekes, merthogy arról volt szó, hogy hát az Nvidia biztos azért szabott meg az Ampere kártyáknak ilyen magas árat, mert elképesztően nagy készletek terhelik (b. szerint ez nem igaz már, Abu szerint a készlet valószínűleg lapka formájában az Nvidia raktáraiban csücsül és a partnerek nem rendelik) amin először túl akarnának adni.

Vajon elégedettek lehetnek a mostani eladásokkal?

Azt gondolhatják, hogy sem régi terméket leárazva, sem új terméket nem föléárazva nincs értelme kiadni, mert úgyis mindenki megvásárolta már a maga kis GPU-ját és senki nem rohanna úgyse a boltba?Vajon mikor érhet véget az elvileg átmeneti "csak az Ampere készlet kifuttatásáig" tartó feláras időszak?

Vajon bődületesen sok még a készlet? vagy épp azért emelkedtek enyhén az árak decemberhez képest, mert fogyóban van? -

FLATRONW

őstag

válasz

huskydog17

#46222

üzenetére

huskydog17

#46222

üzenetére

Igaz, annak már jó néhány javítás megléte után kezdtem neki. Ha volt is valami baja megjelenéskor, akkor elég szépen kikupálták.

-

válasz

Petykemano

#46224

üzenetére

Petykemano

#46224

üzenetére

Ez messze tultmutat a gamer szegmensen. Szerintem ez nem is lehet kerdes.

-

Busterftw

nagyúr

-

Petykemano

veterán

válasz

Yutani

#46223

üzenetére

Yutani

#46223

üzenetére

Vajon

- ez a gémer community-t célozza amolyan extra feature-ökkel, vagy ez a gamer közösségen túlnyúló piacra, általános célra irányul?

- Ha utóbbi, akkor ehhez venned kell egy 100.000-500.000Ft-os videokártyát (vagy notebook esetén hasonló értéknövekedéssel kell kalkulálnod), vagy ez majd nemsokára a CPU-k részét képező IGP vagy más AI accelerator meg fogja oldani?

Vagy zárt rendszer lesz és ilyen feature-ökre rá lehet építeni egy Nvidia eszközbrandet? (lásd: Apple)

- És vajon hogy teszik teljesítményfüggővé? Másként megfogalmazva: milyen előnyök (vagy épp hátrányok) érhetnek ilyen felhasználási célok esetén kisebb vagy nagyobb teljesítményű kártya használata mellett? -

huskydog17

addikt

válasz

FLATRONW

#46219

üzenetére

FLATRONW

#46219

üzenetére

Azzal is voltak gondok megjelenéskor. Ott is sok akadás volt, ami erősen függött a CPU-tól, de legalább a VRAM igénye annyira alacsony, hogy még 4K-ban is elegendő a 6 GB.

Azt nem tudom, hogy azóta az akadásokat sikerült-e javítani. Amúgy érdekes módon a Days Gone is pont arra mutat rá, illetve bizonyítja, hogy a Hogwarts-nál valamit kegyetlenül elcsesztek a VRAM használatnál.#46220 b.: A DLSS-el is vannak gondok, sok az úgynevezett smearing jelenség, valószínűleg ez majd javítva lesz, vagy akit zavar, az ki tudja cserélni a DLSS verziót. Szerencsére ebben a címben van olyan jó a sebesség, hogy nem feltétlen szükséges a DLSS. Igen, FSR-ből sajnos csak az első generáció került bele, ezért olyan ocsmány a minősége.

-

-

válasz

huskydog17

#46218

üzenetére

huskydog17

#46218

üzenetére

rég tetszett ennyire játék, gyönyörű. A DLSS hihetetlenül jól sikerült a nagyfelbontású képek alapján. FSR-nek kell az új változat.

A 4090 40 % előnye a 4080 hoz elég durva. -

FLATRONW

őstag

válasz

huskydog17

#46218

üzenetére

huskydog17

#46218

üzenetére

Én még a Days Gone-ra emlékszem úgy, hogy nem volt vele semmi gond.

Pedig az is UE4 játék. -

huskydog17

addikt

Atomic Heart - ComputerBase teszt

Na tessék, lehet ezt jól is csinálni.

Nincs shader compilation és traversal stuttering, a performance kiváló, miközben az egyik valaha készült legszebb játék. Oh és a VRAM használatról annyit, hogy 8 GB még 4K max grafikához is elegendő. FullHD-hoz pedig 6 GB is elegendő.A játék készítői ezzel alaposan nevetségessé tették a Hogwarts játékot és annak készítőit technikai szempontból.

Ugyan az Atomic Hearts sem tökéletes, de a letöbb UE4 játékhoz viszonyítva ez bizony igen jól sikerült. Végre egy olyan csapat, akik tudják hogyan kell jól kezelni ezt az öreg UE4 motort és figyeltek is annak tipikus problémáira.

Remélem majd a DigitalFoundry is csinál videót hozzá! -

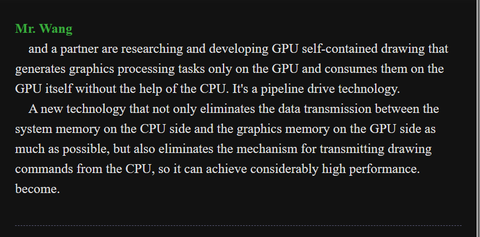

egy elég érdekes bejegyzés .: [link]

Ez egyébként nem csak nála hanem jensen egy régebbi nyilatkozatára utalva már a hírhedt coreteks traversal coprocessor-nál felmerült és a directstorage híreknél is már több emberkének megfordult a fejében hasonló, hogy maga a GPU egy PC-n belüli egyfajta

komplett játékkonzol szerepét töltse be. -

gejala

őstag

Na az ilyenek miatt nem frissítek semmilyen drivert Windows telepítés után, ha nincs gond. Geforce driverből évente egyszer teszek fel újat, egy olyat ami jónak tűnik reddit alapján. Kivéve ha valami hibába futok új játéknál, de ez szerencsére ritka.

Egyébként is ócska a legtöbb geforce release, a mostani 528 branch is. Évente két időszakban jönnek jók, aug vége-szept eleje meg dec vége-február, a többi mindig tiszta bug meg sebességcsökenés. -

-

válasz

Petykemano

#46199

üzenetére

Petykemano

#46199

üzenetére

Szerintem is egy kicsit rákanntattál erre a Discord dologra. Nincs ez elbagatelizálva csak nem értem mit látsz benne mert a Discord egy több éves program és eddig viszonylag hibátlanul működött az új verziójának frissitése után történt 25- 250 Mhz memória Vram órajel esés aamit - ismét kiemelve nem azért hogy elbagatelizáljam- csak kimérni lehetett, észrevenni nem igazán állítólag.[link]

Itt videón a 7000 ről 6800 ra zuhanó Vram freki és hozzá a megoldás [link]

igazából egy alkalmazás profil frissítéssel megoldották, [link]kb ilyen szintű " hiba" volt.

A hiba kijövetele után pár nappal Nvidia kiadott már egy valamilyen szintű megoldást [link] majd után a gyorsan egy profil javítást.

Az Amd driverek hiányát nem Nvidia fanok találmánya, nem ők találták ki hanem AMD kártya tulajdonosok hiányolják és a sajtó. ezt nem rajtuk, rajtunk kellene számon kérned.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Hobby elektronika

- World of Tanks - MMO

- Milyen billentyűzetet vegyek?

- Diablo II: Classic és Resurrected

- Ügyesen előzi meg a 12V-2x6 tápkonnektor leégését a Dell

- Router gondok

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- Kérsz egy pohár hardverbólét?

- Milyen TV-t vegyek?

- Banggood

- További aktív témák...

- AKCIÓ! HP EliteBook x360 830 G7 i5-10210U 16GB 512GB 1 év garancia

- FRISS ÁRU!!! Dell Latitude Precision Üzleti gépek, 2-in-1 gépek, 3-11. gen.

- Lenovo ThinkPad T14S Gen1 Ryzen5 4650U Refurbished - Garancia

- Xeon E5 1650 v3, 2680 v3, 2690 v3 processzorok

- DELL Precision 3430 SFF,i7-8700,8GB,256GB SSD,NVIDIA Quadro P620 VGA,Win11

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Elfelezni a fogyasztást azért vélhetőleg jócskán szerényebb tempó mellett lehetne.

Elfelezni a fogyasztást azért vélhetőleg jócskán szerényebb tempó mellett lehetne.

Pl.

Pl.  De pl. Witcher3 alatt is 350W körül mutat a fogyasztásmérő egy alulfeszelt+tuningolt 6800XT-vel monitor nélkül.

De pl. Witcher3 alatt is 350W körül mutat a fogyasztásmérő egy alulfeszelt+tuningolt 6800XT-vel monitor nélkül.

Abból a szempontból értem, hogy ezek a legkisebb TCO2, és legnagyobb teljesítmény, de így úgy tűnik, mintha ezek minden további nélkül összehasonlíthatóak lennének...

Abból a szempontból értem, hogy ezek a legkisebb TCO2, és legnagyobb teljesítmény, de így úgy tűnik, mintha ezek minden további nélkül összehasonlíthatóak lennének...

![;]](http://cdn.rios.hu/dl/s/v1.gif)