Hirdetés

- talmida: Változások 2. rész

- GoodSpeed: Mutasd magad topic!

- MasterDeeJay: RAM gondolatok: Mennyi a minimum? DDR3 is jó?

- aquark: Zsebszámológépek

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- Luck Dragon: Asszociációs játék. :)

- sziku69: Szólánc.

- sziku69: Fűzzük össze a szavakat :)

- GoodSpeed: Daikin FTXF35E / RXF35F Sensira 3,3 kW Inverteres klíma - a Sztori

- gban: Ingyen kellene, de tegnapra

Új hozzászólás Aktív témák

-

Devid_81

félisten

válasz

gainwardgs

#48297

üzenetére

gainwardgs

#48297

üzenetére

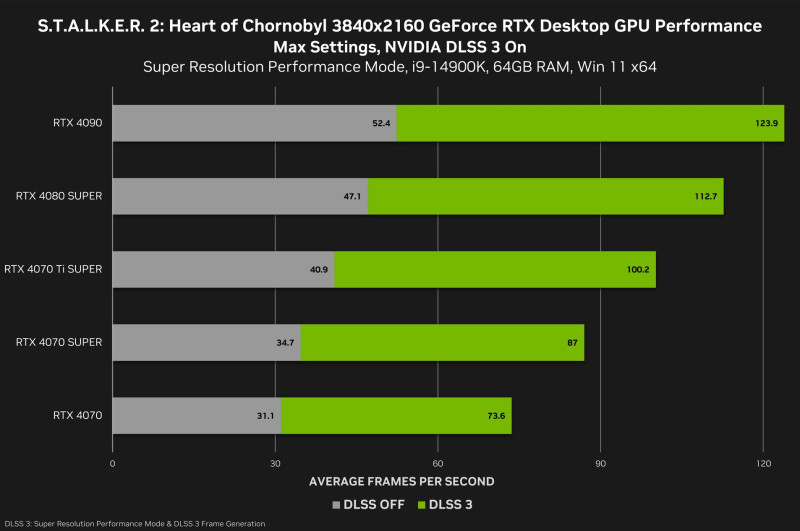

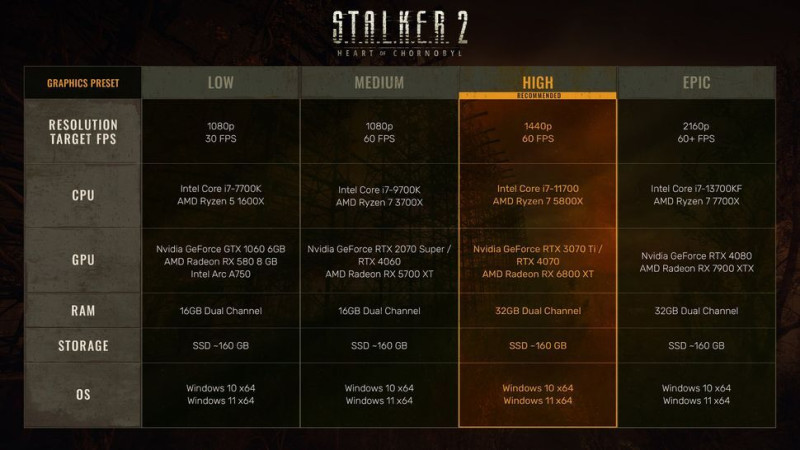

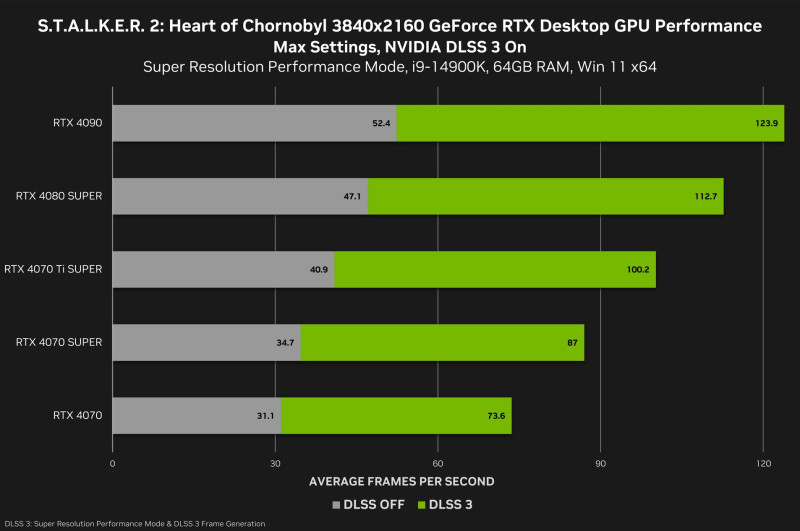

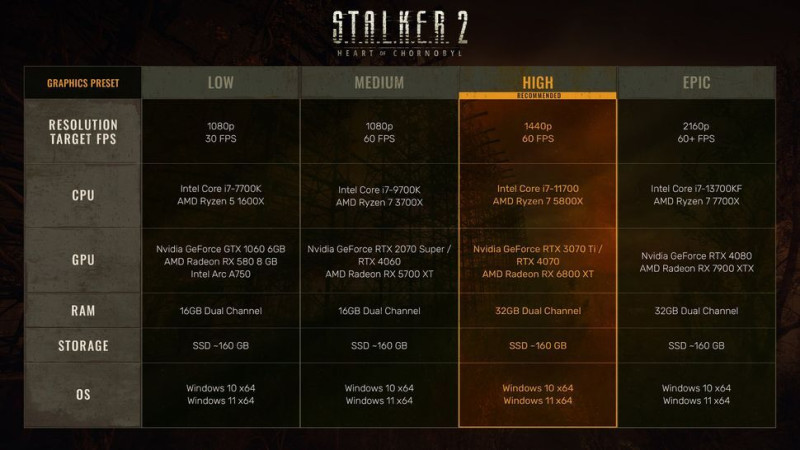

Mindenki megvarja hozza az 5090-et mert nem akarjak elhinni, hogy a 4090 csak 32fps-t tud 4K-ban nativban

-

gainwardgs

veterán

Na hun vannak a Stalker 2 böncsmárkok

-

proci985

MODERÁTOR

volt erre pelda korabban is egyebkent

anno a Diablo 2 Gliden futott jol voodoo2 / voodoo3 generacion biztos. aztan evekig a hardveres renderert el lehetett felejteni, mert tetulassu volt. ha jol emlekszem valahol (sok generacioval kesobb) talan a hd3870 / 8800gt volt, ami izombol megint elbirta a wrappert.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#48292

üzenetére

Yutani

#48292

üzenetére

Driverest. Ez úgy van, hogy az Intel kivette a fast path-okat a kontroll logikából, és ezzel azt is eldöntötték, hogy a DirectX 11-et emulálják, így nem készítenek rá támogatást. Na most ezzel az volt a baj, hogy iszonyatosan lassú volt. Konkrétan olyan címek nem futnak 30 fps-sel, amelyek amúgy mennek több éves IGP-ken. Erre hoztak egy korlátozottabb natív DirectX 11-es meghajtót, majd a fontosabb címeket elkezdték átrakni arra, de ott meg hiányzik a fast path a hardverből, így nem skálázódik jól a rendszer a legtöbb natívan támogatott játékban. Csak azok működnek jól, amelyek deferred contextre vannak írva, ebből meg ugye marha kevés van DirectX 11-en. Ezt viszont már sosem fogják másképp csinálni, mert a DX12 és a Vulkan felé megyünk, de a hardver és a szoftver hiányosságai miatt a retro gamingre nem ajánlott a rendszer, mert sosem tudhatod, hogy melyik emulált játékba futsz bele, és ott tényleg 3-6-9x lassabb lesz a sebesség, mint lehetne. Valahol viszont hasznos volt meglépni, mert rengeteg tranyót spórolnak vele, és mindössze kb. 100 játékra terveztek natív támogatást DirectX 11-hez, tehát sokkal olcsóbb karbantartani a meghajtót, mint például az AMD-nek és az NV-nek, akik minden DirectX 11-es játékot natívan futtatnak. Meg önmagában az emberek erről nem is tudnak, azt hiszik, hogy ha vesznek egy modern hardvert, akkor nem lesz majd baj a 2010-2015 környéki játékokkal. Hát lesz, ha emulálva fut éppen az adott régi cím.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#48290

üzenetére

paprobert

#48290

üzenetére

Az nem az összes cache.

Az Intel már az első Arcból kivette a fast path áramköröket a régi API-kra, ebből sokat spórolnak. Cserébe nagyon-nagyon lassan fut a DirectX 11-es játékok többsége. Ugyanezt az AMD és az NV is meg tudja majd tenni, de ennek ez az ára. Most még nem olyan gyorsak az IGP-k, hogy ez vállalható legyen. Ez egy nagyon paradox választás, mert azt hinnéd, hogy elég erős lesz a hardver a 10 éves játékokra, de azok azért gyorsak a GPU-kon, mert vannak különböző fast path áramkörök a kontroll logikában, plusz van rájuk natív támogatás.

-

paprobert

őstag

"Nem számolják bele a 8+8 MB cache-t, ami kell a működéshez."

A Guru3D feliratozott die shotján, ami alapján számoltam, szerepel egy méretes cache, bele lett számolva.

Látszódik hogy arányaiban több szilícium van cache-re költve a kékeknél, de ezek szerint minden más takarékosabb/hatékonyabb annyival, hogy az összméret mégis Xe2 előnyt hoz.

Köszi

-

Abu85

HÁZIGAZDA

válasz

paprobert

#48288

üzenetére

paprobert

#48288

üzenetére

Nem számolják bele a 8+8 MB cache-t, ami kell a működéshez. Erre van tervezve a GPU, hogy azok a cache-ek ott vannak. Az RDNA 3-hoz nem kell ekkora cache. Elég 2 MB.

Ezen fog változtatni az Xe4, hogy nem kell óriási cache, és nem kell lokalitási elvre optimalizálás, hogy működjön a dizájn. Emiatt közelebb kerül az egész ahhoz, ahogy az AMD és az NV GPU-k működnek.

A másik jelentős különbség az a GPU-k etetése. Az AMD és az NV még ma is beépíti azokat a fast path módszereket a hardverbe, amelyek szükségesek a DirectX 11-es címek gyors futtatásához. Az Intel ezeket már teljesen kihagyja. Emiatt sokkal egyszerűbb az Arc kontroll logikája, mert el lehet távolítani a specifikusan DirectX 11-re szabott adatutakat. Ennek az előnye, hogy kb. 90%-ot spórolnak kontrol logika szintjén a tranzisztorokkal. A hátránya, hogy régebbi API-kkal nem versenyképes a dizájn, és nagyon sok teljesítmény marad benne bizonyos alkalmazásokban. Ez amúgy előnye az Intelnek, hogy nekik nincs összehasonlítási alapjuk az Arc előttről. Nem fogják felróni nekik, hogy egy régebbi DirectX 11-es cím az új IGP-ken 3-6x lassabb, mint a régin. Az AMD-nek és az NV-nek ezt felrónák. Mert kb. ennyi lassulással kell ezen áramkörök nélkül számolni. Nem véletlen, hogy az Arc meghajtónál 200-300%-os gyorsulásokról voltak hírek egy-egy játéknál, amire írtak direkt támogatást. De kb. van több ezer DirectX 11-es cím, és ebből fehérlistás úgy 100-200. Tehát a többség még mindig emulálva fut.

-

paprobert

őstag

"Ezáltal nem kell sokkal nagyobb lapkaterületet használni egy adott teljesítményszint eléréséhez, ami az Intelnek egy elég nagy baja jelenleg"

Néhány hozzászólással ezelőtt pont ezt elemeztük. Az Alchemist-nél ez igaz volt, az Xe2 viszont úgy tűnik, elveri szilíciumtakarékosságban az RDNA3.5-öt, vagy legalább nagyon közel van egymáshoz a két friss mobil dizájn.

Erre van ötleted, hogy hogyan történhetett meg?

Az pedig nem jó ómen a jövőre nézve, hogy az RDNA hamarosan a datacenterrel újraegyesített egyenarchitektúrára fog váltani, nagy eséllyel a helytakarékosság a jelenleginél rosszabb lesz.

-

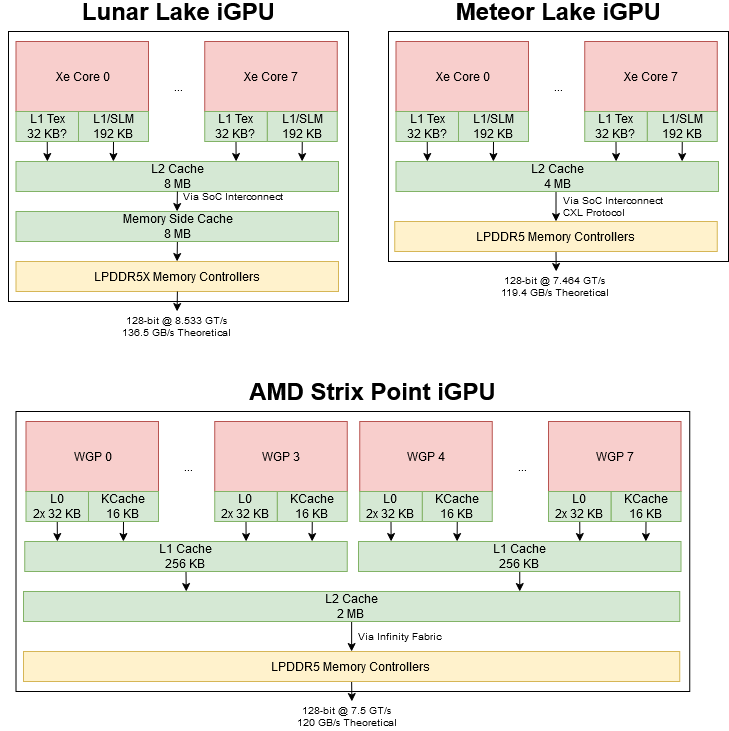

Abu85

HÁZIGAZDA

A cache-t a dizájn igényeihez tervezik. Szóval ez nem olyan egzakt dolog, hogy ha az egyikben ennyi van, akkor a másikba is kell. Az Intel azért épít sokkal több cache-t a dizájnba, mert sokkal kevesebb wave-vel dolgoznak, így nekik sokkal ritkább, hogy át tudják lapolni a memóriaelérés késleltetését. Az AMD dizájnja sokkal jobban reagál ezekre a helyzetekre.

Alapvetően ezért van az is, hogy bizonyos játékokban nagyon szar az Xe2, míg bizonyos játékokban nagyon jó. Általában ott jó, ahol a játék shaderei úgy vannak megírva, hogy van alkalmazva némi optimalizálás a lokalitási elvre. (szerencsére a legtöbb AAA cím már ilyen, mert van némi haszna mindegyik dizájnon) Ha nincs, akkor ott nagyon rosszul viselkedik az Xe2, mert hasztalanná válik benne a sok cache.

Az AMD-féle RDNA3 másképp működik, sokkal kevésbé érzékeny arra, hogy milyen optimalizálást alkalmaz egy shader, inkább csak az számít neki, hogy jó legyen a regiszternyomás, és ha az jó, akkor igazából a sebesség is jó. Az Xe2 legalább négy-öt külön tényezőre érzékeny még, és ha az egyik nem jó, akkor a sebesség sem lesz jó.Ez majd az Xe4-ben fog megváltozni, mert az már sokkal inkább hasonlítani fog azokhoz a GPU-dizájnokhoz, ahogyan tervez az AMD és az NVIDIA. Ezáltal nem kell sokkal nagyobb lapkaterületet használni egy adott teljesítményszint eléréséhez, ami az Intelnek egy elég nagy baja jelenleg, mert ki kell tömni a dizájnt cache-sel, hogy működjön, és akkor is csak akkor működik, ha a program erre van optimalizálva.

Pontosan ez volt például a gond a Starfield esetében. Annyira specifikusan csak a regiszternyomásra optimalizáltak, hogy az Arc sebességét máig nem tudták összerakni.

-

4264adam

nagyúr

Sziasztok!

Elméleti szösszenet futtatásra invisztálnék minden kedves topiklakót a G-sync / V-sync használata miatt.

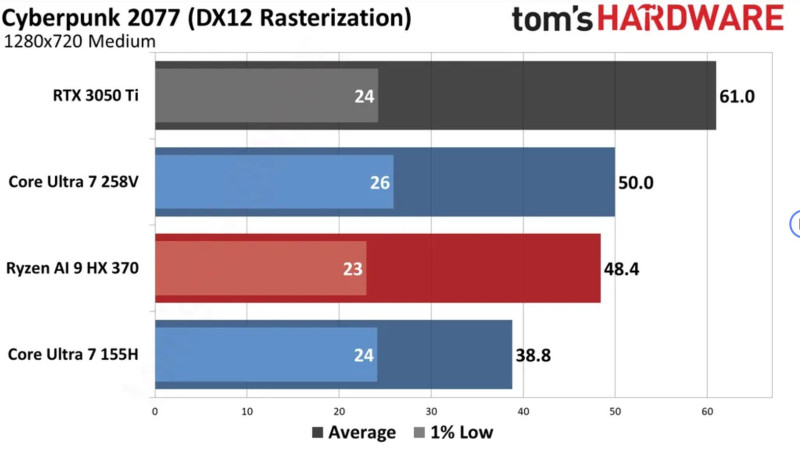

- Csak singleplayer címeket használok (Fallout 4 / Cyberpunk 2077 / Ghost of Tschusima / DOOM)

IPS --> VA csere történt ahol elég ügyes a motion handling kezelés. 180hz révén a következő jutott eszembe:

Eddigi G-sync kikapcsolás mert 50-90Hz között van a képfrissítés és helyette csak V-sync használta.

Melyik lehet kellemesebb a szemfáradás elkerülése végett:

1. eset:

-V-sync: OFF

- G-sync: On (50-90FPS tartományban) ilyenkor a montor ezen frissít

2. eset:

- G-sync: Off

- V-sync Global: On

Monitor fix 180Hz-en frissít és az FPS limit: 90. Max hz /2FPS Limit: CPU terhelés csökkentés, tartalék képzés --> kisebb droppolás nagyobb terhelésen

Próbáltam 2 OLED TV-t (LG A2 C2) de a stutter miatt menniük kellett. Egyszerűen az LCD az én szememnek való és a lassabb response time (ennek a reciproka a stutter érték). -

S_x96x_S

addikt

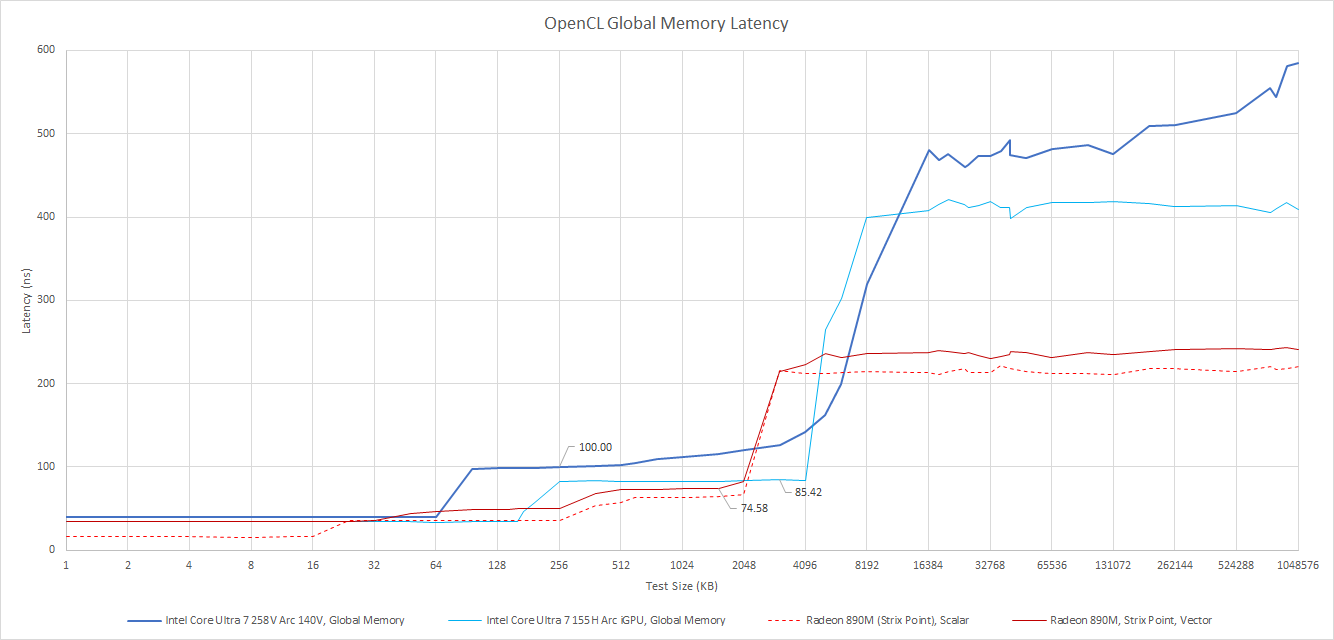

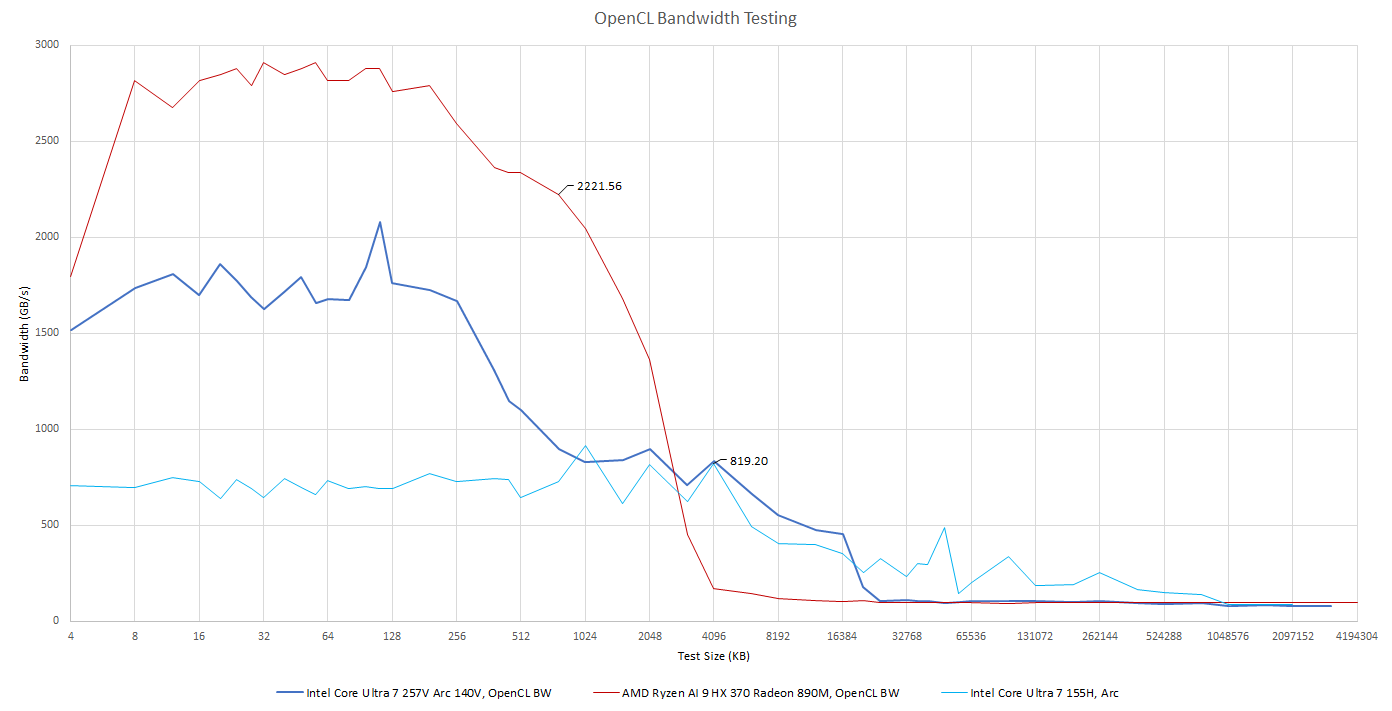

> Csak a képeket nézve a Strix Point a Lunar Lake-hez képest

> nagyon rosszul áll cache-ben minden szintena cache a latency alacsony tartása miatt van;

és az alapján már teljesen más következtetésre lehet jutni.

"Outside the Xe Core, Lunar Lake doubles L2 cache capacity to 8 MB. That’s the biggest L2 cache I’ve seen in a laptop iGPU so far. However, latency has substantially increased over Meteor Lake’s 4 MB L2. Lunar Lake also sees a weird uptick in latency well before the test approaches L2 cache capacity. It’s not address translation latency because testing with a 4 KB stride didn’t show a latency jump until 64 MB, implying a single thread has enough TLB capacity on hand to cover 64 MB."

"AMD’s Strix Point has a smaller but lower latency L2 cache. Even though the L2 is smaller, Strix Point has a lower latency penalty for accessing DRAM. On Lunar Lake and Meteor Lake, a GPU-side DRAM access has over 400 ns of latency. Strix Point’s iGPU can get data from DRAM in under 250 ns. Lunar Lake has a 8 MB memory side cache placed in front of the memory controller, but I can’t clearly measure its performance characteristics."

( via https://chipsandcheese.com/p/lunar-lakes-igpu-debut-of-intels )

-

S_x96x_S

addikt

válasz

paprobert

#48275

üzenetére

paprobert

#48275

üzenetére

> Azt tudom csak elképzelni, hogy az integrált RAM jótékonyan hat az arch

> kihasználtságára, és ettől kilő a teljesítmény a relatíve kis méretben.A lunarLake és az előző generáció között teljesen más tervezési filozófiát

és valószínüleg teljesen más tranzisztor könyvtárt használtak ( TSMC3 vs. INTEL4 )"""

George Cozma:

Again, back to the previous generation, you had a GPU, tile, an SOC tile, and an iGPU tile. On Lunar Lake, that’s now all been reintegrated on to a single die. What was the why move back to a more monolithic design for those parts of the design?

Arik Gihon:

Yeah. So it was a trade off, actually. When you start building the project, you start to think which transistor you want to put on which node. And since we have selected the entry, we could fit, more transistors into entry in one monolithic die. And the second is that it was an optimized die just for a specific segment.

You don’t need to stay for the entire family and up to desktops with that. And also, we could just put all of the transistors, all of the compute transistors, on the same die very close to the memory and therefore gain latency and gain performance. So you both gain good process for all of those as well as for the SoC components and the memory components, and closer to the memory.

George Cozma:

And so then sort of a follow-up to that, why did you leave the what you’re calling the platform controller die, as its own separate die? Was that because the stuff on that die doesn’t scale as well with newer nodes?

Arik Gihon:

It just didn’t need to scale. Those transistors are usually controllers for IOs. They can fit nicely into N6’s process, and the IOs are working there very good. So it was a nice partition.

"""

https://chipsandcheese.com/p/an-interview-with-intels-arik-gihon-about-lunar-lake-at-hot-chips-2024-------

Ami még érdekes lehet az Xe2 és az AMD-s tervezési eltérésekről:

"Lunar Lake’s iGPU: Debut of Intel’s Xe2 Architecture"

https://chipsandcheese.com/p/lunar-lakes-igpu-debut-of-intels

-

paprobert

őstag

válasz

S_x96x_S

#48274

üzenetére

S_x96x_S

#48274

üzenetére

"pl. a "Display Control Logic" - az NPU tól balra található - a 4E core alatt."

A Strix-nél meg a display controller és a display phy van külön.

Nyugodtan számold össze magadnak, +- pár százalékot biztos tévedek, mert 2 percet szántam rá.

A lényegen nem változtat, és felvetésem továbbra is megválaszolásra vár.Hogy lehet az, hogy az Xe1-RDNA2 összehasonlításban az Intel kétszer akkora mérettel tudta csak hozni ugyanazt a teljesítményt: A770(406mm2)-RX6600XT(237mm2), itt viszont jó eséllyel AMD hátrány van azonos méret mellett?

Az Xe2 prezentációból nem látszott semmi, ami utalna egy ilyen +100% körüli előrelépésre, ott csak perf/w-ról beszéltek.

Azt tudom csak elképzelni, hogy az integrált RAM jótékonyan hat az arch kihasználtságára, és ettől kilő a teljesítmény a relatíve kis méretben. -

S_x96x_S

addikt

válasz

paprobert

#48272

üzenetére

paprobert

#48272

üzenetére

> Lunar Lake 3nm:

> 140mm2 a compute tile, amiből a GPU 25%inkább ~ 33% körül lehet;

pl. a "Display Control Logic" - az NPU tól balra található - a 4E core alatt."Next to the NPU is the Xe2 Battlemage integrated GPU,

which, along with its display and media controller components,

occupies nearly one-third of the Compute tile's die area. "

https://www.guru3d.com/story/intel-lunar-lake-processor-architecture-die-and-pch-annotated/

> Strix Point 4nm:

> 232.5mm2 a teljes lapka, amiből a GPU 30%a reddit-en a strix-point - GPU -t 21% -ra becsülték.

"""

Using the best I can get as the subtraction of 2 rectangles (screenshot limitation), the CPU, GPU, and NPU consume 26%, 21%, and 7% of the die area.

4 RDNA3.5 work groups is 3.7% of the die area. The NPU compute is 2.9%.

""" -

Busterftw

nagyúr

válasz

Alogonomus

#48261

üzenetére

Alogonomus

#48261

üzenetére

Jó de ez nem újdonság, eddig is kb a többség azért drukkol az AMD-nek, hogy aztán Nvidiat vegyen olcsóbban.

-

paprobert

őstag

válasz

paprobert

#48259

üzenetére

paprobert

#48259

üzenetére

Számoltam die shotok alapján:

Lunar Lake 3nm:

140mm2 a compute tile, amiből a GPU 25%

azaz ~35mm2 a Battlemage GPU méreteStrix Point 4nm:

232.5mm2 a teljes lapka, amiből a GPU 30%

azaz ~70mm2 az RDNA3.5 GPU méreteHa nincs 100%-os sűrűségbeli ugrás a 4nm és a 3nm között (legjobb tudomásom szerint nincs), akkor az Xe2 átlépte az RDNA3.5-öt teljesítmény/lapkaméret metrikában.

Az Alchemist - RDNA2 összehasonlítást látva ez elég hihetetlennek hangzik, de ez jött ki gyors pixelszámolással.

-

S_x96x_S

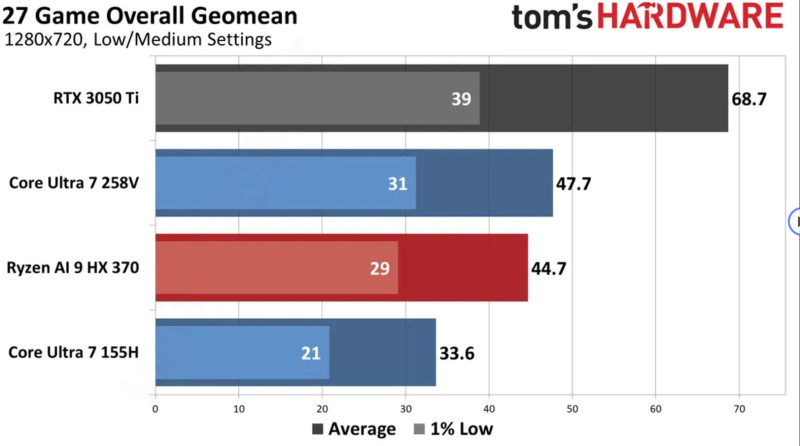

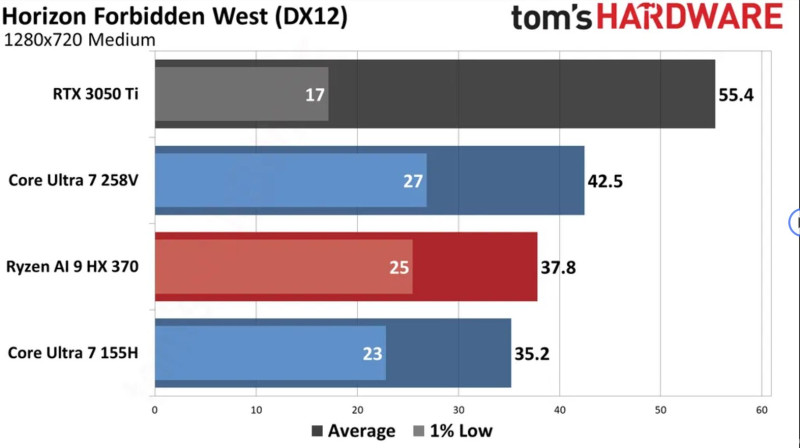

addikt

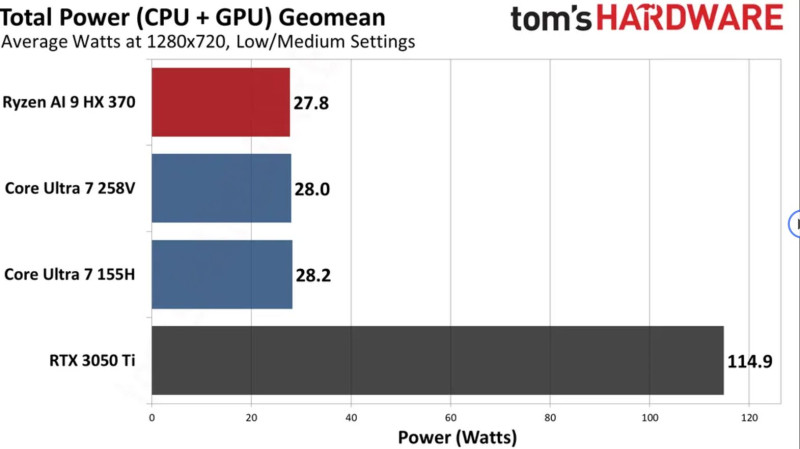

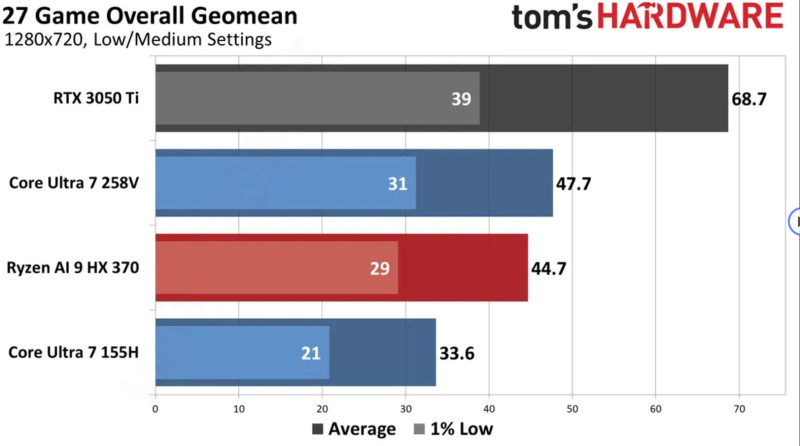

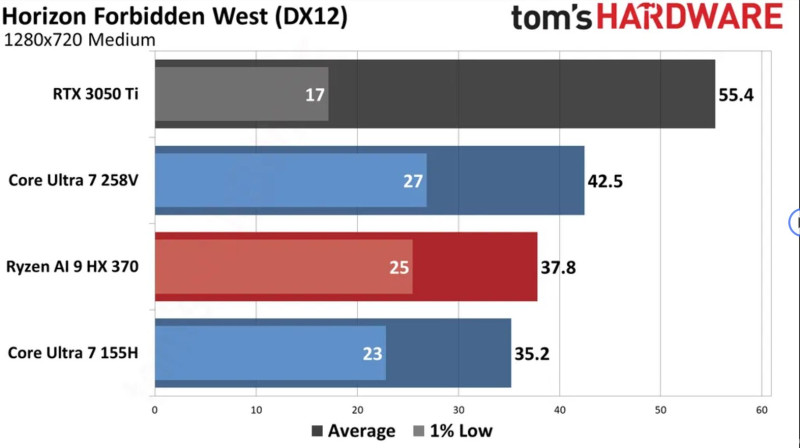

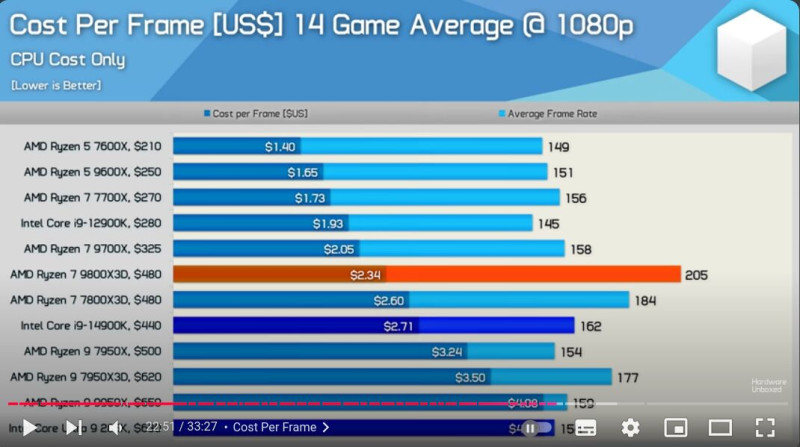

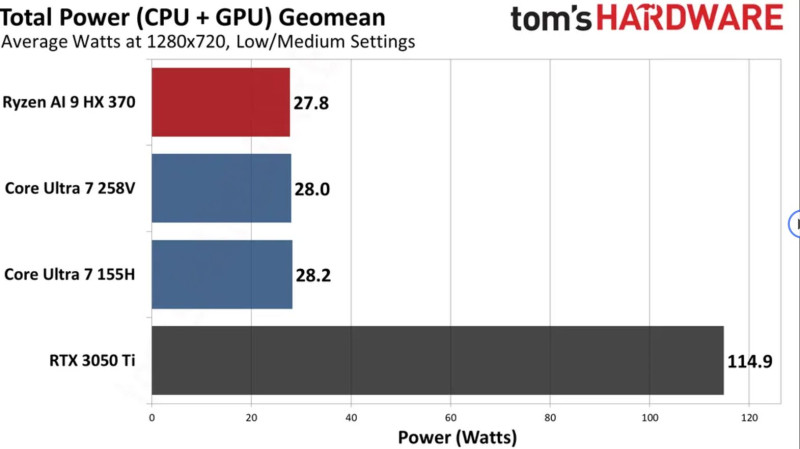

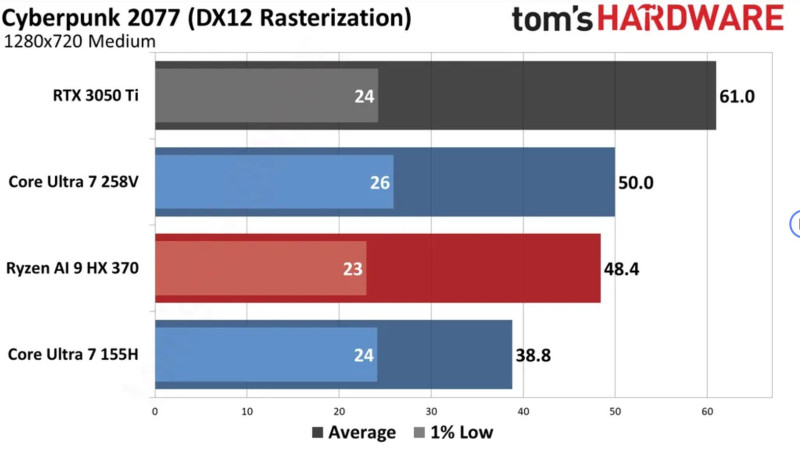

> Miért az RTx 3050 micsoda ,ha nem olcsó GPu megoldás?

az idézett cikk

"Intel takes down AMD in our integrated graphics battle royale — iGPUs are still nowhere near dedicated GPU levels but use much less power"

https://www.tomshardware.com/pc-components/gpus/intel-takes-down-amd-in-our-integrated-graphics-battle-royale

éppen azt fejtegeti, hogy az árához képest

- se teljesítményben

- se fogyasztásban

már nem annyira gazdaságos egy RTX3050;

Persze budget "RTX 3050" - laptop helyett RTX 3050 Ti -el teszteltek:

"We wanted that specifically, or the RTX 3050, just to see how a budget dedicated RTX GPU stands up to the latest integrated solutions."És a grafikonokat látva tényleg nem az a "true budget"

aminek minimális 4GB VRAM - lehet az oka;

ami manapság már nem sok mindenre elég:

"The Last of Us, Part 1, refused to run on the RTX 3050 Ti laptop, showing an "insufficient memory" error. We're not sure if that's purely from the 4GB of VRAM, or if it's the combination of VRAM and system RAM."

--

a cikkből:"""

And then look at the gaming laptop, which uses 39.2W on average for the CPU, and 77.3W on average for the RTX 3050 Ti. We suspect that with a slightly different and newer graphics solution, like the RTX 4050 laptop GPU, performance would be improved thanks to the additional VRAM, and the CPU and system RAM might also hold back the 3050 Ti. But it's still interesting to see just how big the gap is between the iGPU solutions and the dedicated GPU.

Nvidia GPUs can also run in lower power modes, though we did some limited testing with a 30W power limit and found that performance dropped substantially in that case, with the 3050 Ti often falling below the fastest iGPU solution. There's a good reason we never liked the RTX 3050 or 3050 Ti laptop GPUs. Beating a newer iGPU doesn't require much performance, really.

"""

A fogyasztás -

És ez a teljesítmény - 27 játék átlaga :

és pár random ( csersznyézgetve )

-

S_x96x_S

addikt

> RDNA3 (és azt ígérték, hogy 50%-kal jobb lesz).

Pontosabban "up to 50%"

![;]](//cdn.rios.hu/dl/s/v1.gif) -ot ígértek "per watt".

-ot ígértek "per watt"."Experience up to 50% greater performance per watt with AMD RDNA 3, compared to the previous generation AMD RDNA 2."

és az apró betűnél:

"Based on AMD labs testing in November 2022, on a system configured with a Radeon RX 7900 XTX GPU, driver 31.0.14000.24040, AMD Ryzen 9 5900X CPU, 32GB DDR4-3200MHz, ROG CROSSHAIR VIII HERO (WI-FI) motherboard, set to 300W TBP, on Win10 Pro, versus a similarly configured test system with a 300W Radeon 6900 XT GPU and driver 31.0.12019.16007, measuring FPS performance in select titles. Performance per watt is calculated using the manufacturers’ stated total board power (TBP) of the AMD GPUs listed herein. System manufacturers may vary configurations, yielding different results. RX-816."

( https://www.amd.com/en/technologies/rdna.html ) -

S_x96x_S

addikt

válasz

bertapet11

#48250

üzenetére

bertapet11

#48250

üzenetére

> de cserébe gyorsabb is

a verseny jó;

és most már az Intel is szorongatja "budget gpu" fronton az nvidiát,

és emiatt se lesz olcsó nVidia megoldás a jövőben --> mert gazdaságilag nincs értelme.a hivatkozott cikkből:

".... , budget gaming solutions are clearly in sight. Perhaps that's why we haven't really seen any true budget GPU solutions from Nvidia for several years, with the least expensive models often adding several hundred dollars to the price of a PC or laptop."

( via )Persze, hogyha lesz az nVidiának saját desktop-os chipje, ( arm-windows )

akkor ez megváltozhat - és jöhetnek a budget nVidiás megoldások. -

fLeSs

nagyúr

válasz

Alogonomus

#48261

üzenetére

Alogonomus

#48261

üzenetére

Ez a te elképzelésed hacsak nem tudsz vmi érdemi bizonyítékot mutatni ami igazolja, hogy az NV kifejezetten az RDNA3-as kártyák miatt jött ki a Superekkel.

Nekem is van egy elméletem: az RTX4000-esek rosszul fogytak, mert drágák voltak a teljesítményükhöz képest és mert infláció (emberek inkább kajára költöttek) volt és mert az RTX3000-esek is elég jók voltak szinte mindenre.

És ez nem jelenti azt, hogy az AMD-hoz tódultak volna a vevők, mert akkor ennek lett volna nyoma a piaci részesedési adatokban. Egyszerűen az emberek elhalasztották a vásárlást.

A 4070 Ti->Super és a 4080->Super kijövetele között egy év telt el, ha az RDNA3 miatt kellett volna Superesíteni akkor nem várnak egy évet. Szerintem. -

válasz

Alogonomus

#48251

üzenetére

Alogonomus

#48251

üzenetére

Ezeket feltételezed,de konkrétan nem tudod. Olyan érvekkel jössz amire nincs rálátásod se tudásod mi mennyibe kerül nekik vagy mennyi hasznot hoz vagy visz el a gyártásból adódóan.

Ha van akkor kérlek ossz meg velünk egy táblázatot . -

Alogonomus

őstag

"mert attól nekem és másnak nem lett jobb"

A chipletes RDNA3 nélkül a Super kártyák nem érkeztek volna 10-25%-kal kedvezőbb ár/érték aránnyal, ahogy a korábbi generációs Ti és Super kártyák sem képviseltek megjelenésükkor érdemben kedvezőbb ár/érték arányt. Az olcsóbban gyártható chipletes RDNA3-ra válaszként jelentek meg olyan áron a Lovelace Super kártyák.

-

paprobert

őstag

válasz

Alogonomus

#48251

üzenetére

Alogonomus

#48251

üzenetére

A versenyképesség elemzéséhez keresztkérdés, hogy a méretekről tudunk bármit?

A nagyon hasonló teljesítmény mekkora szilícium-ráfordítással jött az Intel és az AMD esetében?

-

Jacek

veterán

válasz

Alogonomus

#48254

üzenetére

Alogonomus

#48254

üzenetére

Pedig az, lényegében az egy balek, egyetlen gyártó akinek a kezében van minden jó iGPU/APU--hoz erre megy a tilitoli hígfos...

Megnézném az NV x86 licencel 1-2 év fejlesztés után

-

fLeSs

nagyúr

válasz

Alogonomus

#48248

üzenetére

Alogonomus

#48248

üzenetére

Végfelhasználóként a nm-ek nem érdekelnek.

Ez kb. olyan átfordítva a túloldalra, mint amikor az RDNA3-ban chipletre váltott az AMD és mindenki mennyire örült hogy az hűdejó. Sztem a kutyát nem érdekli, mert attól nekem és másnak nem lett jobb (vagyis olcsóbb, vagy kevesebbet fogyasztó, vagy bármi pozitívum), csak az AMD-nek lett jobb (bár még ez is kétséges). Sőt, ha javításról van szó akkor a chipletes kártyák nagyobb %-ban javíthatatlanok (mint anno a Vegák).Egyébként meg semmi sem garantálja, hogy ha az AMD átáll majd 3 nm-re akkor majd nagy ugrás lesz lásd RDNA3 ami egy sz@r lett pedig ott is 7-ről 5-re váltottak (és azt ígérték, hogy 50%-kal jobb lesz).

-

Raymond

titán

válasz

Alogonomus

#48254

üzenetére

Alogonomus

#48254

üzenetére

A levezetesed nem bizonyit semmit, az csak egy AMD-pozitiv wishful thinking ha mar valahogy belyegezni kellene. Se az eredeti se ez a hozzaszolas nem valtoztat azon hogy az Intel utolerte az AMD-t iGPU teljesitmenyben.

-

Alogonomus

őstag

válasz

Raymond

#48253

üzenetére

Raymond

#48253

üzenetére

A diskura eredetileg onnan indult, hogy az AMD mekkora balek, hogy az Intel utolérte iGPU teljesítményben. A levezetésem pedig azt bizonyította, hogy az AMD lényegesen jelentősebb haszonkulccsal adhatja el az Intel processzoraival lényegében azonos teljesítményű processzorait, vagyis nem balek volt az AMD, hanem a haszonkulcsra gyúrt.

Az már csak extra nyereség, hogy a sokkal bővebb 5/4 nm-es gyártókapacitásnak köszönhetően valószínűleg az Intel 3 nm-t használó processzorainál több processzor legyártására van lehetősége az AMD-nek. Persze összes legyártott darabszámban az Intel marad a csúcson az IFS gyártósorairól lekerülő belépő szintű Celeron és Pentium Gold, valamint a szintén gyártásban tartott 2 és 4 magos Raptor Lake processzoroknak köszönhetően. -

Raymond

titán

válasz

Alogonomus

#48251

üzenetére

Alogonomus

#48251

üzenetére

Amit engem mint konzumert teljesen hidegen hagy es jelentosege itt a sebessegrol szolo diskuraban sincs.

-

Alogonomus

őstag

válasz

bertapet11

#48250

üzenetére

bertapet11

#48250

üzenetére

Egyenként végignézve a játékeredményeket komoly szórás mutatkozik meg a helyezésekben, szóval az átlag nagyon megtévesztő képet mutat. Mint a dVGA-k esetén, úgy az iGPU-k esetén is az adott játéktól függ, hogy mi a sorrend.

-

-

Raymond

titán

válasz

Alogonomus

#48248

üzenetére

Alogonomus

#48248

üzenetére

"az Intel minimum egy fél generációval modernebb és drágább"

Marmint hol/kinek dragabb? Mert a konzumereket ez erdekli csak:

890M

140V

Itt meg nem ugy nez ki hogy dragabb lenne az Intel.

-

Alogonomus

őstag

Most is kihagyod azt a lényeges információt a teljes képből, hogy az Intel minimum egy fél generációval modernebb és drágább - főleg Gelsinger bakiját követően - node felhasználásával tudott felzárkózni az AMD mögé az asztali és laptop vonalon.

A TSMC állítása szerint a 3 nm 10-15 %-kal nagyobb teljesítményt nyújt az 5 nm-hez képest. Az AMD által használt 4 nm, ami az 5 nm halfnode, az akkor nagyjából 10 % "benthagyott" teljesítményt jelenthet ahhoz képest, mint ha az AMD is átváltott volna 3 nm-re az asztali és laptop vonalon, ahogy azt a Turin kapcsán meg is tette.

Szóval a friss AMD és Intel processzorok eredményeinek összevetésekor hozzá kell kalkulálni, hogy az AMD fél generációval gyengébb technológiával versenyez, és úgy is minimum egálban van az Intel termékével.

Olyan, mint ha az egyik "autóban" 76-os benzin lenne, a másikban pedig V-Power, és úgy teljesítenének majdnem azonosan a versenypályán. -

Devid_81

félisten

AMD evek ota b.z/skodik az integralt videokkal.

Ha Intel nem fejlesztene ra sztem meg mindig a 8 CU Vega lenne a csucs

Mar regesregen 16 CU RDNA-nal kellene jarniuk beleponel is.

De majd jovore jon a 40CU, majd kb 2db laposban lesz elerheto 9 honap csuszassal Januari release utan...

Business as usual. -

fLeSs

nagyúr

Végülis az Intel csinált már rosszabbat is, szal akkor az AMD is legyen kötsög.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Igazából nem érdekel, hogy ez a két cég hogy nyírja egymást, az már inkább , hogy az AMD intVGA-s blamázsa (amit itt látni) mennyire ugyanaz mint amit az Intel csinált a CPU-kkal a múlt évtizedben. Szépen lassan, nyugisan, elkényelmesedve fejlesztgettek és közben a másik meg beérte.

De sztem ez a helyzet nem fog sokáig tartani, mert ha a következő Lake-nél már nem lesz integrálva a memória mint ezen a Lunar Lake-en, akkor az intVGA is lassabb lesz. -

-

fLeSs

nagyúr

válasz

bertapet11

#48233

üzenetére

bertapet11

#48233

üzenetére

Ebben az anyagban a lényeg az a grafikon, amelyiken látszik, hogy FSR/AFMF nélkül (vagyis natívban) az Intel beérte az AMD-t. A többi egy nagy tökönlövés az AMD-nek és a vásárlók megtévesztése a kamu fps-ekkel nyomulni.

Eléggé kiveri nálam a biztosítékot ez a marketinganyag, az NV is csinált ilyen az Ada kártyákkal, de az NV-től nem is vártunk mást és ők legalább csak a saját előző generációjukkal hasonlították össze az RTX 4000-eket.

Az AMD-nél pánik lehet, hogy az Intel beérte őket az évtizednyi APU-s tökölődésük után és most próbálkoznak mindennel. -

S_x96x_S

addikt

válasz

bertapet11

#48233

üzenetére

bertapet11

#48233

üzenetére

Az Intel egyre versenyképesebb;

és van egy táblázat is a cikkben: AMD Claims Its Ryzen AI 300 APUs Demolish Intel Lunar Lake in Gaming Performance, Over 2x Uplift With FSR 3 In AAA Titles

AMD Claims Its Ryzen AI 300 APUs Demolish Intel Lunar Lake in Gaming Performance, Over 2x Uplift With FSR 3 In AAA Titles -

bertapet11

tag

-

Devid_81

félisten

válasz

gainwardgs

#48230

üzenetére

gainwardgs

#48230

üzenetére

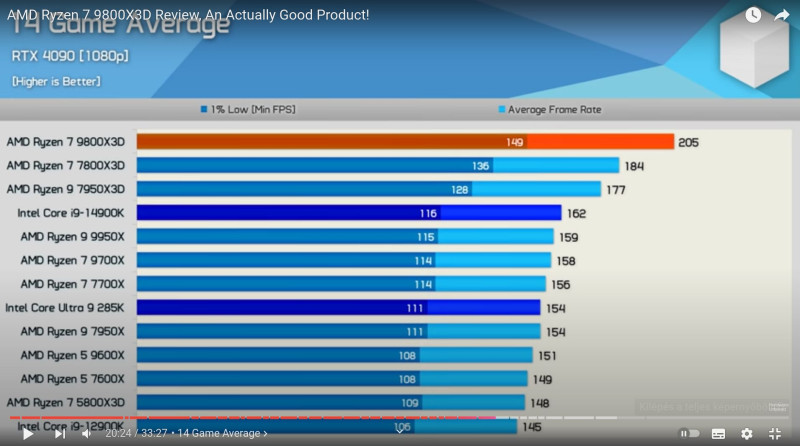

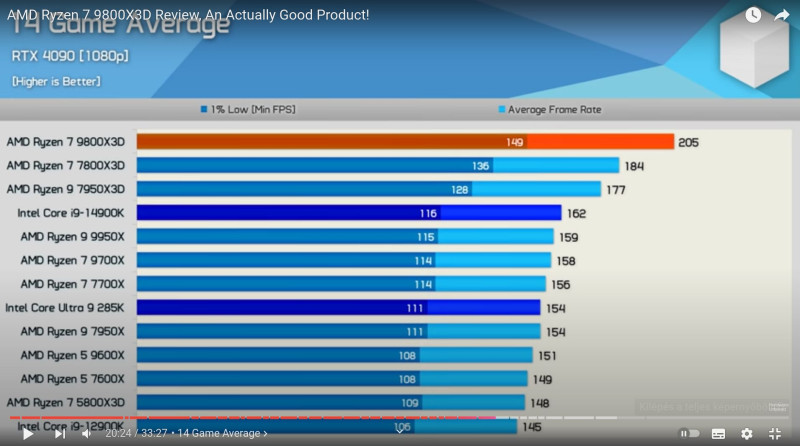

Gyanitom, hogy 9800X3D-vel jobb lesz picit.

Nekem gyanus, hogy 4080S 4090 kozott szinte nulla elteres van nativban.

CPU limitre tippelek.

Ettol fuggetlenul kah, elertunk a generacio vegehez, egyszeruen "kinottuk" a lehetosegeket.1080p mellett meg teljesen ugytunik nekem, hogy cpu limitbe utkozik a jatek.

-

Devid_81

félisten

válasz

gainwardgs

#48226

üzenetére

gainwardgs

#48226

üzenetére

Ezert nem kell a 4K-t eroltetni, hacsak nincs a usernek penz nyomdaja a garazsban.

Minden generacio vegere eljutunk ide, hogy nem eleg mar a high-end 4K-ra -

gainwardgs

veterán

válasz

gainwardgs

#48225

üzenetére

gainwardgs

#48225

üzenetére

Megint csak a Dlss3

-

gainwardgs

veterán

-

Devid_81

félisten

Leaker teases Intel Arc “Battlemage” desktop update next month

Hatha egy RTX 4070 Super szintet megutnek vegre.

-

DudeHUN

őstag

-

hokuszpk

nagyúr

nemtom minek tornaznanak ezzel, ha akarjak a firmware levon 15 fokot a kifele jelentett homersekletbol oszt jonapot.

* plane ugy, hogy elvileg mar a Zen1 -ben volt 20 hodioda ; a Zen5 -ben se lehet sokkal kevesebb ; de akkor hova lehet azon a pici lapkan ugy atcsoportositani, hogy mégis pont úgy mérjen, hogy jólegyen ? -

-

S_x96x_S

addikt

válasz

huskydog17

#48207

üzenetére

huskydog17

#48207

üzenetére

> Ha elolvasnád a két tesztet, talán rájönnél mekkora marhaságokat hordasz össze

> és miért nincs köze a témához az általad felhozott dolgoknak.mert miért is ?

A két teszt egyáltalán nem vizsgálta az eltérés okát, és magyarázatot se próbált adni.

Én mint egy lehetséges okként adtam meg az eltérő optimalizációt.Egyes Digital foundry tesztek az esetleges minőség különbséget is próbálták ellenőrizni, ami itt egyáltalán nem történt meg.

-

Devid_81

félisten

Huvosebb lett magasabb fogyasztas mellett is.

Magasabb orajel, szintetikusban is sokat lepett elo es jatekokban is van egy ~10% elorelepes.

Persze ertem en, hogy ez keves, en is tobbet vartam meg anno a Zen5 megjelenes elott az egesz uj generaciotol.Az uj Intelhez kepest jatekokban konkretan egy teljes generacios elorelepes, ha mas nem

-

X2N

őstag

válasz

FollowTheORI

#48206

üzenetére

FollowTheORI

#48206

üzenetére

5-10% -al jobb mint a 7800X3D, én legalább 15%-ot vártam volna, különben meg mi értelme van ennek a processzornak? Mire ment el 2 év? Megfordították a chipletet? Minek? Nem lett sokkal jobb...

-

Jacek

veterán

válasz

Busterftw

#48205

üzenetére

Busterftw

#48205

üzenetére

De arról van szó hogy az outlaws kikapcsolhatatlanul butitja a texturákat, az nem felbontás. Na azt hogy hasonlítod össze?

Ha nem tudod lockolni és az egyik kártyán high a másikon médium a textura.

Vagyis erről ment az eszmecsere hetekkel ezelőtt, ha lehet lockolni vagy akármi nem szoltam. -

-

Busterftw

nagyúr

válasz

S_x96x_S

#48204

üzenetére

S_x96x_S

#48204

üzenetére

Kivéve, hogy a tesztekben fix beállításokat használtak és a Dynamic Resolution Scaling ki volt kapcsolva.

Gyengébb teljesítménynél inkább arról beszélnek, hogy RT alatt az RDNA3 nem teljesít jól, még az RDNA2 mellett sem.

Ahogy egyre több játék használ már low grafikán RT-t, több ilyen eredményt fogunk látni. -

S_x96x_S

addikt

válasz

huskydog17

#48203

üzenetére

huskydog17

#48203

üzenetére

azért írtam, mert szerintem meg fontos

- mindkettő (VRAM, Szponzoráció)> A VRAM témát kár volt ide keverni, kevered a szezont a fazonnal.

Adaptive grafikai optimalizáció már nem újdonság,

amikor a játék dinamikusan beállítja a textúra minőségét

és egyéb grafikai beállításokat, hogy illeszkedjen a VRAM-hoz ( 8GB vs. 12GB vs 16 GB ) , megelőzve ezzel a komoly teljesítménycsökkenést.Hogy ezt ki lehessen zárni, nem árt hasonló VRAM mennyiséggel tesztelni és nem úgy ahogy te javasoltad. ( 12gb vs. 16gb )

-

huskydog17

addikt

-

S_x96x_S

addikt

> Vicc, többet fogyaszt mint a 7800X3D és alig gyorsabb...

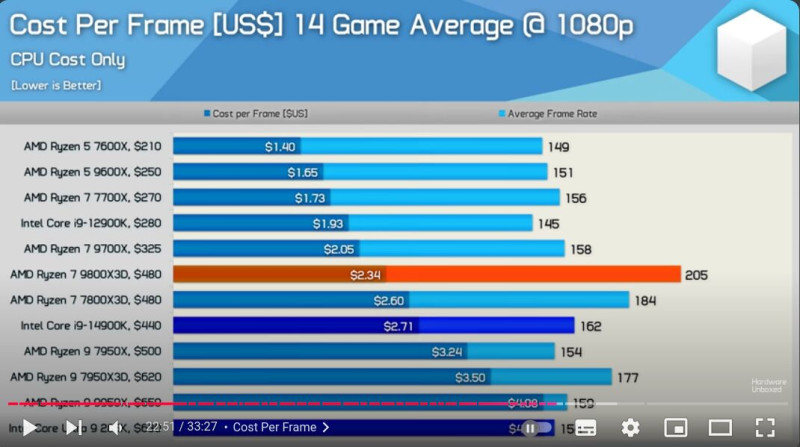

A HU - "kivételesen" meg van vele elégedve.

https://youtu.be/BcYixjMMHFk?t=1224

https://youtu.be/BcYixjMMHFk?t=1224

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- EA Sports WRC '23

- Azonnali informatikai kérdések órája

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- OLED monitor topic

- Apple MacBook

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- Szeged és környéke adok-veszek-beszélgetek

- Folyószámla, bankszámla, bankváltás, külföldi kártyahasználat

- Projektor topic

- További aktív témák...

- Honor X6 /4/64GB / Kártyafüggetlen / 12Hó Garancia

- MacOS 26! UTOLSÓ GEN iMac 27" 5K i7-10700K 64GB RAM 512GB NVMe Radeon Pro 5700 XT 16GB gar

- Xiaomi Redmi 13 128GB, Kártyafüggetlen, 1 Év Garanciával

- ÁRGARANCIA!Épített KomPhone i5 12400F 32/64GB RAM RTX 5070 12GB GAMER PC termékbeszámítással

- Apple iPad Pro 12,9 (3. generáció) 64GB Wi-Fi + Cellular használt, karcmentes

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif) -ot ígértek "per watt".

-ot ígértek "per watt".