- eBay-es kütyük kis pénzért

- sziku69: Fűzzük össze a szavakat :)

- Brogyi: CTEK akkumulátor töltő és másolatai

- norbx: IRC a 90-es évek és a 2000-es évek elején

- Luck Dragon: Asszociációs játék. :)

- sziku69: Szólánc.

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- Mr Dini: Mindent a StreamSharkról!

- Geri Bátyó: Régi VGA, HDMI és a felbontás

- gerner1

Új hozzászólás Aktív témák

-

Steve_Brown

senior tag

Egyébként ez már nem az a szint ami hivatalos publikációban is megjelenhetne?

-

pengwin

addikt

Megláttam az oldalválasztó legördülő listát, és örültem, hogy épp tegnap forgattam pivot-ba a 27" monitoromat.

Hihetetlen mennyi munkád mehetett bele, nagyon szépen köszönjük!

-

Stüsziteszt

újonc

Csak azért vártam eddig, hogy én legyek a 110-edik hozzászóló. (Valójában lusta vagyok és kissé lassú.

)

)

Ha már hozzászóltam hozzá nem értő ismeretlenként az igp-s cikkhez, akkor most is. Ahogy akkor is írtam, 2004-ben kezdtem el 3d játékok futtatására alkalmas gépen gémelgetni. Vagyis pont felöleli a cikk 2004-től szinte napjainkig azt az időszakot, amit én is, idézőjelben, jobban ismerek. Csak én roppant nagy kihagyásokkal mélyedtem a témába , mivel a mai napig összesen 7 különböző videókártya fordult meg nálam.

Fantasztikus méretű és tartalmú cikk, erre csak igazi profi képes!

20 év! Nem semmi. 2004-ben és még később is, kézbe fogva lapozgathattam a Gamestar, PC Guru, és más magazinokat is. És bontogathattam a cd mellékleteket. Persze gamer újságot is elég rapszódikusan vettem, nem lettem gyűjtő.

És csak olyan videókártya fordult meg a kezemben, amit használtam is, mivel nem vagyok profi tesztelő. (Van ugyan egy nyilvános youtube csatornám, Alex Tesztpilóta néven, kemény 7 feliratkozóval, de a minősége miatt csak erős idegzetűeknek ajánlanám. Sajnos időm, energiám és eszközparkom nem elégséges a mai profi videók világában.)

És akkor most egy kicsit nosztalgiázom az elmúlt húsz év fölött.

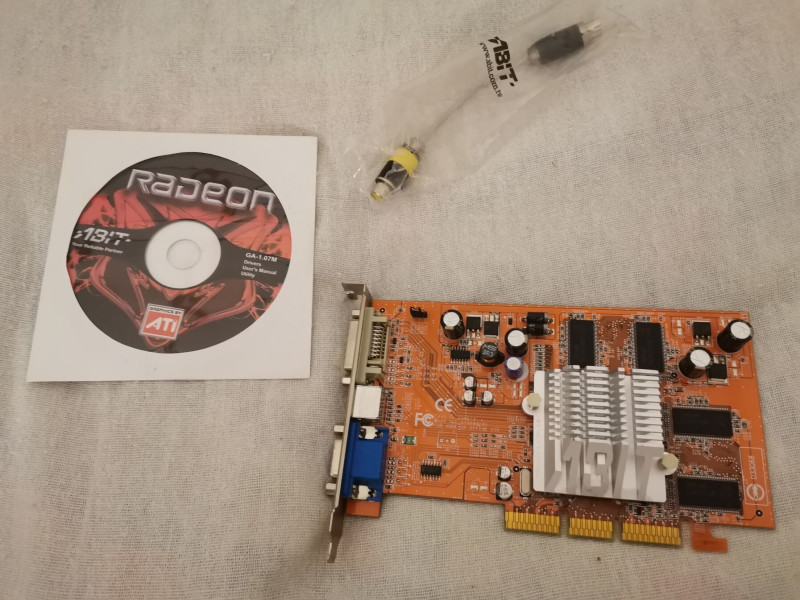

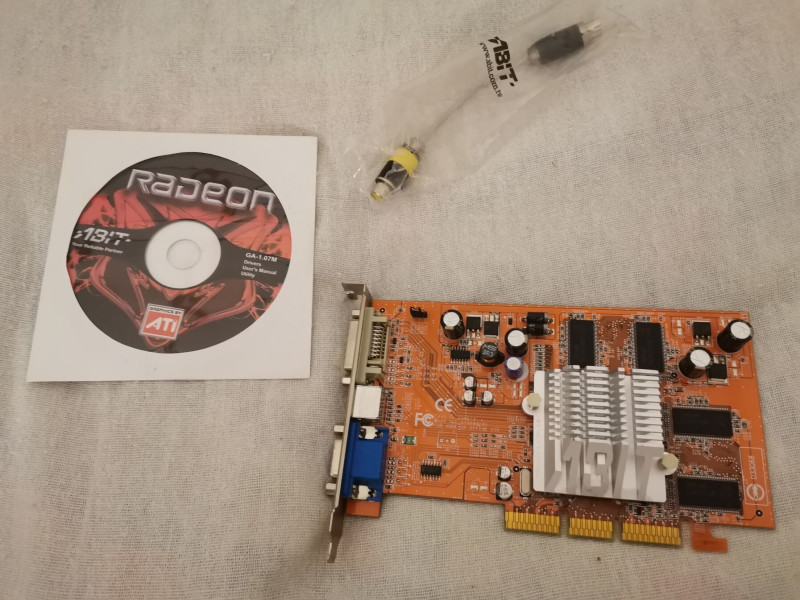

Az első kártyát 2005-ben vásároltam, mikor már közel egy éve gyötörtem az alaplapi videókártyát. Pro Savage 3? akármi vagy ilyesmi: pl. a Phantom Menace c. játékkal.) Ez volt az

Ati Radeon 9250. Erről írtam az igp-s cikkhez írt hozzászólásban, hogy pakolta fel Zombi Robin arcára a húst, vagy hogy nőttek kerekek a versenyautókra. (Lásd a nevem alatti -nem sokkal hevésbé szószátyár- bejegyzést.)

Az én példányomat nem reklámozták gamer kiadásként (ahogy Gai az agp-s cikkben írt róla) Már csak ezt is bizonyítandó, álljon itt két sztárfotó a dobozról, és a belevalókról, magáról a kártyáról: (ha már ez volt életem első dedikált kártyája):

Ezután elhatároztam, hogy öt évig nem veszek új vga-t. Hogy miért? Megijedtem az új függőségtől, és a várható költségektől (újabb és újabb játékok, újabb és újabb kártyák, az örök körforgás; ennek a veszélyes mélységeit max a vallás rovatban tudnám bővebben ecsetelni.

Érdekes volt látni a cikkben, hogy ez alatt az idő alatt hány kártya váltotta egymást, amiről lila gőzöm sem volt.

Az öt év leteltével aztán 2010-ben mohón megvásároltam az AH 3450 felségjelzésű kártyát. Ami a dobozán feltüntetett adatok alapján persze a

HD 3450 volt. Ahogy a doboz hátulján kiderül. (De több fotó már nem lesz, szerintem a fönti is már túl sok egy hozzászólásban.

Ezt követően egy költözés során 2013-ban (tehát röpke 9 év után) vásároltam egy új „gémer” konfigurációt. Az idézőjel nem véletlen. Gamer PC-nek neveztetett, új gép volt, pofásan nézett ki, de ami benne dohogott egy Amd Athlon X4 740 proci alatt, egy

GT 640 volt. Ez is szerepel a szerző egyik nagy gpu-s cikkében. Már-már ráismertem, de rájöttem, nálam egy másik példány volt. Ezt cseréltem aztán egy

GTX 750 Ti kártyára, ami nálam megint csak élményszámba ment. Ahhoz hasonlítanám, mikor Csubbakkának végre sikerül úgy ejteni a gépházba a csavarkulcsot, amitől a Millennium Falcon végre hiperűr sebességre tud kapcsolni. A Remember Me egyszerre (majdnem) max beállításokkal tudott futni 1080p-ben, szinte szárnyaló fps-ekkel. A

A

GTX 1050 Ti volt a következő a sorban, érezhető különbséggel, de nem ugrásszerű mértékben, talán az Athlon X4 is visszafogta. Ezt valamelyest egy új i5 7600-as új konfiguráció orvosolta.

Ebbe a konfigurációba került később egy

GTX 1650 Super, amelyet a fentiek közül a legjobb vételnek tartok ár/érték tekintetben. Jó 30%-kal erősebb mint a sima GTX 1650. Mára már teljesen eltűnt a piacról. 55 ezerért vettem újonnan, a sima 1650-eket is 60+ ezrekért kínálják manapság. Nyilván a használt piac kedvezőbb lehet. Biztos egy GTX 1660 jobb választás lett volna, de én ezt választottam. (Ki tudja, talán azért, mert Super . Futott még a jelenlegi Ryzen 7 5700G procis konfigurációban, de nemrég lecseréltem egy

. Futott még a jelenlegi Ryzen 7 5700G procis konfigurációban, de nemrég lecseréltem egy

RTX 4060-ra, belépvén ezzel a Raytracing világába. Hogy ez mitől nagy durranás, vagy sem, mit tesz hozzá a grafikához, vagy sem, milyen szintű kártyától érzékelhető, vagy sem, arról egy külön mélyfilozófiai értekezést lehetne írni. Azért a 4000-res széria szerintem már megállja a helyét. Különösen a DLSS tekintetében.

Ami a különböző évek játékait illeti, hogy nekem mi volt meg ezek közül, és mi nem, külön fejezet lenne. PL. mostanában vásároltam meg egy 2015-ös játékot (Mad Max). Ritkán szereztem be valamit a megjelenés pillanatában, az egyetlen kivétel erre a Jedi Fallen Order. A folytatás beszerzése eddig még elmaradt.

A kártyák tekintetében nagyjából GTX 980-tól fölfelé vagyok leginkább képben, onnantól kezdve vagyok jobban képben. És 2013-tól valahogy Geforce oldalra kerültem. (De nincs mögötte valamilyen fanatikus elköteleződés :)) Nyilván ismerősek AMD oldalról az RX-ek, a Vega kártyák,stb. Ekkortájt böngészgettem relatíve értőbben a kínálatot.

Ahogy a föntiekből látható, rendszerint a belépő színt tájékán mocorgok. De érdekfeszítő olvasni a kártyák színes palettájáról!

Félelmetes méretű és alaposságú cikk, köszönet és respect illeti! :) -

FoLey-v

addikt

Teszt nagyon jó lett köszönjük!

AMD RX 5700 XT tulajként örülök,hogy bekerült. Azért nemrossz teljesítmény tőle. Máig nincs olyan kártya használtan 90k alatt amire érdemes cserélnem (Sosem költök rá sokat). Talán 6700XT ha még egy kicsit esik le az ára.

Mesh Shader hiány azért fájjó. Az RT meg nem mozgósít engem.

-

Shing

őstag

Szép kis írás, de még nem mentem át rajta tisztességesen. Érdekes időszak ez az egész évtized (sőt, már több), sokkal tovább bírják a GPU-k, ez látszik abban is, hogy egészen a HD5000/GTX400 kártyák elfuttatnak lényegében mai játékokat (jó persze nem valami jól)... Régen ez elképzelhetetlen volt, el sem indult volna egy játék pár év után.

Nekem HD6870 volt sokáig. Még a Battlefield 1-t beta kipróbáltam rajta és szépen bírta. A Rise of the Tomb Raider-t full kitoltam rajta.

Egy dolgot nem szeretek az AMD-től, hogy hamar abbahagyják a driver supportot. Valamit biztos, hogy ér még, legalább egy minimális optimalizáció/bug fixing. Én úgy éreztem, hogy a HD5000/6000 szériától egy picit hamarabb szabadultak meg mint kellett volna.

Míg az nVidia megcsinált egy DX12 supportot is a GTX400/500 kártyákhoz. Persze minimális, de ha nem csinálják meg, senki nem mond semmit, nem volt elvárt szerintem.

A GCN kártyák is olyan csoda összetettek voltak, a csúcs verziók teljesítményben is bírták még a címeket. Erre elvágják a támogatást... GTX600 széria még most is kapott, legalább security update-t.

-

Volt rengeteg AGP-s kártya az első nagycikkemben, aztán a legerősebb AGP-s kártya témáját ebben a cikkben is kiveséztem, így már újabb AGP-s cikket nem tervezek csinálni.

-

Gondolkodtam rajta, hogy ezek a régebbi szériák is szerepeljenek a cikkben, de az már nagyon overkill lett volna

Nameg akkor még egy külön AGP rendszer is kellett volna, ráadásul ezek a kártyák mára már beszerezhetetlenek, vagy horror árat kérnek értük. De utólag kicsit bánom, hogy nem mondjuk GF256/Radeon7200-tól indítottam ezt a cikket...

Nameg akkor még egy külön AGP rendszer is kellett volna, ráadásul ezek a kártyák mára már beszerezhetetlenek, vagy horror árat kérnek értük. De utólag kicsit bánom, hogy nem mondjuk GF256/Radeon7200-tól indítottam ezt a cikket... -

Soderes

senior tag

Kb. a cikk felénél tartok.

Egy kis story time, ha megengeditek.

2001-ben az ATI a 8500-al leadott már egy figyelmeztető lövést a Nvidia felé, de senki nem vette komolyan. A korabeli sajtó (akkoriban CHIP előfizető voltam) tesztjei szerint nem sokkal maradt el Geforce 3 Ti 200 teljesítményétől.

A baráti körömben mindenki lenézte az ATI-t és mindenkinek Nvidiaja volt. Még nekem is. "Nem fogja sose elérni a Geforce-ok szintjét." "A játékokat Nvidiara írják. "Szar a driverre."stb ezt mondogatták.

És teljes joggal mondhatták ezt. A Geforce 3 keményen odavert.

Azóta is a best ever Nvidia kártya számomra a Geforce 3 TI 500.

Kb. 2 évvel később mikor kijött a FX széria és 9xxx ATI-k. A haverok közül elkezdett mindenki ATI-t venni. Mindegy hogy mi csak ATI legyen. 9200SE, 9250 az is jó.

Nagyon vicces volt a szitu, hogy milyen gyorsan dobták a meggyőződésüket.

Húztam is evvel őket sűrűn.

-

M0ng00se

őstag

köszi a cikket, jó volt látni, hogy a régi kártyák meddig bírták a gyűrődést. sok kártya ismerős, csak "kis" időeltolódással kerültek hozzám:

AGP NVIDIA 6600GT - 2013 - Öregecske főgépemet tuningoltam maxra S478-cas P4 procival és az említett leadtek 6600gt 20th anniversary edition videokártyával, nagy előrelépés volt a geforce fx5900xt és a radeon 9600 után

HD 6850 - 2014\2015 - Első normálisnak mondható videokártyám akkor már az első általam épített FM2 platformon. Megváltás volt az IGP használata után ez a kártya, 1366x768-cas felbontásban minden futkosott jó fps-sel szép grafikával. 2015-ben vettem hozzá mégegyet és használtam egy ideig crossfire-ben.

HD 7950 - 2015 - Megépült anno az FX-szes gép, de a csoda kb 2 napig tartott, mert az alaplap és a proci is elhalálozott, pedig a videokártya akkor is állat volt, minden futott rajta azon rövid idő alatt. Az írásból is kiderült, hogy igazából ez volt anno a legjobb befektetés, ha valaki ilyet vett, mert több és után is használható fps-eket tudott kinyomni magából.

GTX 280 - 2015 - Mivel downgrade-eltem kisebb konfigra az előző platform halála miatt, downgrade-eltem a videokártyát is, mivel kb csak CS GO-val játszottam. Ekkoriban egy megrángatott 3 magos Atholnnal használtam, jól kiegészítették egymást, cs is jól futott és kb csak ez volt a lényeg.

GTX 560 Ti - 2016 - az előző karit eladtam, visszaváltottam egy hd6850-re aztán az megdöglött, és gondoltam most kipróbálok valami mást, és az egy gtx 560 ti kari lett, arctic accelero III hűtéssel. Amúgy jó kis kari volt, az előbb említett felbontásban futkosott rajta minden, és a hűtőnek hála hűvös is maradt.

HD 7850 - 2017 - egy barátomtól jó áron tudtam megvenni a karit, szóval az előző nvidia-t eladtam, a sapphire HD 7850-et meg megvettem. ehhez szerintem már procilimitem volt, xeon e5450 pörgött a gépben megráncigálva 4,16ghz-re, de nem volt rossz a teljesítmény így sem, köszönhető a még mindig kis felbontásnak

GTX 1060 3GB - 2018 - mivel előző kártya megint elhalálozott, és nem volt nagyon épkézláb döntés a piacon a bányászláz miatt, ezért egy mezítlábas palit kártyára esett a választás. Ekkor már újraépült az FX konfig, 5GHz-cen ketyegett a fx8350, ahhoz kb pariban volt a kártya, de nem volt mindig kihajtva. A felbontás is megnőtt fullhd-re, de a 3GB kb mindenhova elég volt.

RX590 sapphire nitro+ special edition - 2019 - ez igazából nem volt feltétlen ésszerű váltás, de jó áron hozzá tudtam jutni egy új kártyához, szóval kipróbáltam. nagy előrelépés nem volt, egy kicsit erősebb volt a 1060-nál, cserébe 8gb ram volt rajta és sokkal többet evett

RX5700 referencia - 2019 - itt megépült az első AM4 konfigom, de nem volt hosszú életű. a cpu eléggé anti-tuningos volt, ami nekem nagy érvágás, mert szeretem buzerálni, ráadásul sokat a videokártyán sem tudtam húzni, plusz micro stutter-elt erősen, amire nem tudtam gyógymódot szóval kb 2 hónaposan meg is váltam tőle.

2020-ban az rx5700 után APU-ztam egy ideig a Ryzen 3400G-vel, aztán talán egy ideig gtx 1060 6gb kari volt nálam, majd egy gt 1050ti, erre emlékszem, hogy már elég gyengusz volt akkor is számomra. majd kis ideig visszatért hozzám az RX590 újra.

RTX 3060 - 2021 - A bányászláz idején az rx590 új árának a háromszorosáért tudtam eladni, szóval megléptem ezt, majd újra APU-ztam újra egy R7 4750G-vel, majd attól megváltam, jött az R5 5600X majd mellé a jelenlegi kártyám is, egy Palit RTX 3060 kari. Megint csak a bányászláz alatt sikerült kártyát vennem, szinte már tradíció, de igazából ebben tényleg még mindig annyi kraft van, hogy nem tervezem lecserélni. FullHD 144fps mindenhol megvan, ha meg nem, akkor 1-2 olyan effektet kikapcsolok amit amúgy sem látok. A hetekben vettem rá egy arctic accelero iv hűtést ami neccesen de pont ráment, szóval most szinte ki van maxolva a kari. még a hűtés vásárlása előtt gondolkodtam a cserén, mert kis összeg rádobásával lehetne egy rtx 3060ti vagy 3070 is, de egyrészt oda már lehet kevés lenne a cpu, de másrészt meg tök elég még ez a kari.

Voltak még régi agp karijaim, radeon 9600pro (meg nem pro is), geforce 6200, régebbről savage 4 de az okádék.

az irományhoz még annyit fűznék, hogy szerintem a driverek nem mindig voltak a helyzet magaslatán, szerintem ha mindig az aktuális év driver-ével teszteltél volna, akkor amd fronton jobb számok jöttek volna ki, de persze tudom, hogy ez kvázi kivitelezhetetlen, így is végtelen időbe kerülhetett letesztelni az összes címet, aztán megírni, képeket szerkeszteni stb, extra durva.

tudom, hogy kiemelted, hogy egymás ellen harcoltak a kártyák, hanem csak az architektúrák, de szerintem jobb lett volna mindig párban lévő kártyákat tesztelni, esetleg még úgy is, hogy azok nem az adott év legerősebb modeljei.

a játékteszteknél pedig szerintem jobb lett volna mindegyik kártyánál azonos beállításokkal tesztelni, vagy legalább dx szinten (dx9 kártyáknak egy beállítás, dx10-nek stb), de tudom , hogy kiemelted miért is így mérted.

munkában töltött unalmasabb óráimat volt mivel töltenem

-

myckey

veterán

Az ta q va é let

GRANDE !

-

Kansas

addikt

Igen, a HDMI CEC be van kapcsolva, jól is működik pl. a PS5-tel, ebben a hónapban ha minden jól megy összerakom a retró PC-konzolt, remélem azzal is jól fog menni(igaz, arra vagy SteamOS megy, vagy Debian Steammel és Protonnal, nem Windows - ugyebár a régebbi Win-eket már nem támogatja a Steam, ODD pedig nem lesz benne így a lemezes játékok is kiesnek).

Azért ha bármikor "megszáll az ihlet" és esetleg eszedbe jut valami, ne tartsd magadben, jöhet akár privátban

-

-

Kansas

addikt

Arra esetleg nincs megoldásod, hogy a TV-t(LG C2) hogy tudnám úgy a PC-re kötni, hogy amikor a TV-n nem a PC-ről jövő bemenet van beállítva, a PC ne érzékelje bekapcsolt kijelzőként?

Nyilván az én problémám a tiédnek pont az ellentettje, nem használok kijelző-duplikálást, hanem kiterjesztek, és elvárom, hogy ha egy monitort lekapcsolok, vagy a TV-t másik bemenetre kapcsolom, akkor oda ne akarjon ablakot, ikont, vagy bármit tenni a Windows - ezért is van mindkét monitorom DP-re kötve. Sajnos a TV-n nincs DP, ha lenne, azt használnám. -

Mert nincs a kártyámon 2 db HDMI

A TV-re ugye eleve csak HDMI mehet, a monitort meg szintén csak HDMI-ről vagyok hajlandó hajtani a DP fentebb már említett "ha kikapcsolod megszűnik létezni" viselkedése miatt. Plusz így nem függök semmilyen SW-es beállítástól, a két kijelző mindig szinkronban van, bármilyen kártyára van kötve, bármikor (akár BIOS-ban is - nem mint ha kellene, csak egy példa)

A TV-re ugye eleve csak HDMI mehet, a monitort meg szintén csak HDMI-ről vagyok hajlandó hajtani a DP fentebb már említett "ha kikapcsolod megszűnik létezni" viselkedése miatt. Plusz így nem függök semmilyen SW-es beállítástól, a két kijelző mindig szinkronban van, bármilyen kártyára van kötve, bármikor (akár BIOS-ban is - nem mint ha kellene, csak egy példa) -

hapakj

őstag

Így van. Windows 10 minden monitorkonfiguráció és felbontáshoz külön eltárolja az ikon layout-ot s mindig visszaállítja. Ezt mindig szerettem Windows 10-ben s nem is volt vele problémám. S szintén ha windows-ban Win + P-vel váltok monitort, akkor azok szépen lekapcsolnak.

-

FLATRONW

őstag

Nekem DP-n van a 1080p-s monitor, és HDMI-n a 720p-TV.

Amikor átváltok TV-re, akkor automatikusan (alvó mód) kikapcsol a monitor.

Mivel a TV kisebb felbontású, ott más lesz az ikonok elrendezése.

Viszont amikor visszatérek monitorra, akkor ott úgy jelennek meg, ahogy korábban voltak. -

hapakj

őstag

Esküszöm, abszolút furákat tapasztalsz. Nekem nem tűnik el a monitor, mint hw ha lekapcsolom.

BTW még ha lehúzok monitorokat akkor sem csesz szét semmi ikon beállítás. Igaz csak az egyik monitoron vannak ikonjaim. Nyitva lévő ablakokat nyilván átpakolja, mert megszűnik egy felület. De a kikapcsolt monitoron simán ott maradnak az ablakok.

Most már kiváncsi vagyok, pontosan milyen Windows-t és monitorokat használsz

-

Na a DP a másik amit gyűlölök

méghozzá amiatt a viselkedése miatt, hogy ha a DP-s monitort kikapcsolod (NEM lehúzod a kábelt csak simán kikapcsolod) akkor a windows számára az a monitor megszűnik létezni, és nekiáll szétcseszni a teljes display configot, átrendezni az ablakokat, ikonokat, mindent. Mivel mint írtam én rendszeresen lekapcsolom a monitort, ha éppen filmet nézek a TV-n, ezért számomra kizárólag a HDMI jöhet szóba, mert az ilyet nem csinál. HDMI-ből meg általában csak 1 db van egy kártyán, ezért kell a splitter. Az utóbbi 12 évben így használom, és tökéletesen bevált.

méghozzá amiatt a viselkedése miatt, hogy ha a DP-s monitort kikapcsolod (NEM lehúzod a kábelt csak simán kikapcsolod) akkor a windows számára az a monitor megszűnik létezni, és nekiáll szétcseszni a teljes display configot, átrendezni az ablakokat, ikonokat, mindent. Mivel mint írtam én rendszeresen lekapcsolom a monitort, ha éppen filmet nézek a TV-n, ezért számomra kizárólag a HDMI jöhet szóba, mert az ilyet nem csinál. HDMI-ből meg általában csak 1 db van egy kártyán, ezért kell a splitter. Az utóbbi 12 évben így használom, és tökéletesen bevált. -

hapakj

őstag

Hát el tudom képzelni, hogy a HDMI Splitter miatt vagy a rendszeres lehúzogatás miatt néha valami alaphelyzetbe áll, de ezt nem feltétlen fognám a Windows hibájának. Fixen bekötött monitorokkal ilyet sose tapasztaltam (én mondjuk display portot használok)

Utóbbi időbe egyébként kötöttem fel és le rendszeresen 3.-nak egy sima FullHD tv-t HDMI-n igaz az Intel IGP-re, de ott sem tapasztaltam semmit, hogy a Hz, vagy a Scaling megbolondult volna.

Nekem a HDMI Splitter a gyanús, hogy valamiért néha 60hz-es kijelzőt reportal a Windows felé,

-

A szinkronba kötés pontosan azt jelenti ahogy hangzik: a kimenet szét van osztva egy hardware-es HDMI splitterrel a monitor és a TV között. Egy időben mehet akár mindkettő is, anélkül, hogy a windows két kijelzőnek látná, de persze csak az egyiket szoktam használni: filmnézésre a TV-t, minden másra a monitort. Hogy mitől csapja vissza néha 60 Hz-re, azt nem tudom. Van egy másodlagos monitorom is, az 60 Hz-es, lehet hogy amiatt. Azt néha lehúzom, néha visszadugom. Lehet, hogy amikor visszadugsz egy 60 Hz-est, akkor mindent 60-ra állít. Őszintén szólva nem nagyon érdekel, mert számomra annyira észrevehetetlen a 60 és 120 Hz közötti különbség, hogy mostanában már arra sem veszem a fáradságot, hogy visszaállítsam 60-ról 120-ra.

-

gV

őstag

köszi, gratula, minden elismerésem.

köszi, gratula, minden elismerésem.

amit számomra egyértelművé tett, nem véletlenül tartottam meg 2018-ig a GTX 680-at, 1080p-re jó volt. a 2016-os Doomnál is annyit kellett csak tennem, hogy OGL-ben játszottam. kár a Keplerért, az elnyújtott generációváltásért, hogy sose lett összemérve a GTX 580/780 Ti, hogy 2 GCN generációval kellett megharcolnia. 2012-ben a nagy Keplertől leesett volna mindenki álla.

RTX 2080 tapasztalatom szerint jó RT-re (CP2077, Quake 2 RTX, Portal RTX, Alan Wake 2 kompromisszumosan PT-re is), de azt belátom ehhez kell a PC-vel párhuzamos konzol használatom is ahol PS3 esetén nem ritka a 20-on kevés fps. am lenne egy hiba az RTX 2080-nak 2944 US-e van (13. oldal). -

hapakj

őstag

Hát eléggé furcsállom, amiket GAI leírt. Azt elhiszem hogy nem mindenkit hat meg a magas képfrissítés, bár szerintem a VRR mindenképp hasznos.

De én semmi olyasmivel nem találkoztam, ami ő említett. Nekem két monitor WQHD / 144H és 4k / 60Hz van a gépre kötve (legújabb Win 10) minden probléma nélkül

Nekem sose vált vissza 144Hz-ről a monitor. Ha visszaváltana azonnal észrevenném. Nem tudom mit jelent, hogy szinkronba van kötve a TV-vel, lehet az okoz problémát. Játékoknál sem gond ez a dual setup aktív monitorok mellett is teljesen jól mennek GSynckel a játékok a 144Hz-es monitoron.

Részemről a Windows UI skálázása sem volt sose förtelmes 7 éve használom, azóta valszeg javult (hallottam egyébként olyanokat, hogy Radeonnal szarabb) Ha kell küldök screenshotokat.

Mindkét monitorom 27". Az 1440P-s 100% scalingen van a 4k pedig 175% scalingen. Ebből leginkább azt veszem észre, hogy a 4k monitoron sokkal élesebb és jobban néz ki minden. Annyi van összesen, hogy ha egy ablak egyszerre két monitoron van akkor attól függően melyik irányból huzzúk át vagy nagyobb vagy kisebb lesz, de ekkora monitorok mellett kb sose usecase, hogy egy ablak két monitoron legyen. Régi alkalmazásoknál persze előfordulhatnak minimális anomáliák, de hogy annyira förtermelmes legyen, hogy ne élvezzem emiatt a high DPI-t az túlzás.

Nomeg ahogy láttam 3060Ti-od van. Részemről az közel sem egy FullHD / 60Hz kártya. Persze új játékokban igen, de pár évesekben simán meg tudna hajtani egy WQHD / 144Hz monitort. 1080 Ti-om szerintem hasonló teljesítményű, s ráadásul a tiedben még DLSS is van

-

Talon1111

csendes tag

válasz

cintula187

#83

üzenetére

cintula187

#83

üzenetére

Az biztos, Én, már lassan a játéktelepítéstől ódzkodok. Nagy köszönet, a munkáért, én is szívesen olvasom az ilyen írásokat.

Ritkán építettem magamnak "GAMER" gépet, de akkor jól jöttek az ilyen írások, a jó ár/érték arányú alkatrészek kiválasztásához.

Ritkán építettem magamnak "GAMER" gépet, de akkor jól jöttek az ilyen írások, a jó ár/érték arányú alkatrészek kiválasztásához. -

cintula187

addikt

Azért ezt így össezszedni félelmetesen sok munkának tűnik.

-

Hidd el, nem mindenkinek okoz wow érzést a magas frissítés. Én kipróbáltam, és szinte észre se veszem. Most egy 240 Hz-re képes Full HD monitorom van, amit 120 Hz-en használok mert szinkronba van kötve a TV-vel ami szintén ennyit tud. A Windows rendszertelen időközönként önhatalmúlag visszacsapja 60 Hz-re, és ilyenkor baromi sokára veszem csak észre, hogy valami nem stimmel

A 60 és 120 Hz közötti különbség számomra szinte észrevehetetlen, a 240-et pedig ki se próbáltam, tök fölösleges.

A 60 és 120 Hz közötti különbség számomra szinte észrevehetetlen, a 240-et pedig ki se próbáltam, tök fölösleges.A 4K-val szintén úgy vagyok hogy kipróbáltam, aztán álltam is vissza Full HD-ra. Játékokban szép a 4K, de minden másban számomra undorító a Windows förtelmes UI skálázása miatt. Próbáltam azt is, hogy 4K kijelzőn a Windows desktop Full HD-ban menjen. Naívan azt hittem, hogy akkor 4 fizikai pixelre fog jutni 1 megjelenített pixel, így nincs elcsúszás, és tűéles lesz a kép. Hát egy fenét, skálázgatja (= szarrá mossa) a képet a monitor önhatalmúlag, és ez nem kikapcsolható. Szóval én maradok Full HD-n és az se lenne katasztrófa ha csak 60Hz lenne. Az viszont örvendetes, hogy ehhez egyre kisebb kategóriájú GPU-ra lesz szükségem

-

hapakj

őstag

Hát, sajnálom, de én pl Doom Eternal miatt vettem. Egyszerűen idegelt, hogy az 1080 Ti-om még 4k felbontáson is lazán 100FPS+ produkált és én semmit se láthatok belőle

Szóval berendeltem egyet és nagyon jó. Telefonon abszolút nem tudok mit kezdeni ezzel a 120Hz hisztivel, de még a Windows UI is sokkal kellemesebb smoothabb 144Hz-en.De a Doom Eternalban az hogy mindenre tudsz reagálni, mintha sokkal több részletett látnál, nagyon jó. S a VRR miatt a 40-60fps tartomány is sokkal jobb, hiába "csak" 40 fps, egy nem VRR-es monitoron darabos vagy tearinges lesz, de ha synckel sokkal kevésbé zavaró és folyamatosabb a látvány. Szinte kitolja a VGA képességeit. Pl Read Dead Redemption 2 High beállításokon hiába ment csak a 40-60 fps tartományban, egyáltalán nem volt zavaró

Szóval én abszolút ajánlom, hogy monitoron ne spóroljon az ember. Se DPI, se Hz tekintetében. Mégiscsak a legnagyobb infó impulzus egy PC-ből

-

hapakj

őstag

hja, a jó monitorok nem olcsóak.

Én vettem egy 4k 60hz monitort még 7 éve ~140 000-ért.

Majd egy WQHD G-Sync 144Hz monitort 4 éve ~180 000-ért.Most gondolnám, hogy egyesíteném a kettőt és lenne egy 4k 144Hz, de ha már szeretnék bele értelmesen használható HDR-t akkor már fél millió forint. hogy mivan?

Amúgy volt nálam egy MacBook Pro az annak 120Hz-es 1600 nit-es kijelzőjével, s a Geforce Now-val lehet rá streamelni a játékokat akár magas képfrissítéssel HDR-ben is s hát valami brutál jó élmény. Iszonyat jól néztek ki Doom Eternalban a tűz, szikrák, lövések, robbanások egy 1600 nites HDR panelon.

-

Az RT és a 4K igényli a teljesítményt, viszont a játékos nem feltétlen igényli az RT-t és a 4K-t

720p és 1080p között a legtöbb játékban hatalmas az ugrás, 1080p és 2160p között nem állítom, hogy elhanyagolható, de korántsem akkora. Persze nyilván ha ingyen lenne, akkor átállnék 4K-ra, de nemhogy >500k FT-ot nem szánnék rá, még 100k-t se nagyon. RT-vel hasonló a helyzet.

720p és 1080p között a legtöbb játékban hatalmas az ugrás, 1080p és 2160p között nem állítom, hogy elhanyagolható, de korántsem akkora. Persze nyilván ha ingyen lenne, akkor átállnék 4K-ra, de nemhogy >500k FT-ot nem szánnék rá, még 100k-t se nagyon. RT-vel hasonló a helyzet. -

Yutani

nagyúr

Én 3060 Ti-vel vagyok el, ráadásul nem is játszom mostanában, bár van egy csomó régebbi jó játék, amit be kellene pótolni (RDR2, Falloutok, Control, Alien Isolation, stb). Ráadásul csak fHD@60Hz-en tolom, mert nekem az is pont megfelel, de ahogy nézem, WHQD-n vagy 4k-n is lehetne próbálkozni RT nélkül. Pláne, ha van DLSS.

Egyébként lehet idézőjelbe tenni a muszájt, de az RT és a 4k együtt mégis igényli a nagyobb teljesítményt a grafikus kártyáktól. Ahogy anno (legalábbis nekem) sokáig standard 1024*768-ról felléptünk fHD-re. Mondjuk RT nélkül már talán a felső középkategóriás kártyák is megállják a helyüket (ha nem fogy el a vram), de igazán szép és életszerű a fénykezelés csak RT-vel lesz.

-

Hát, a "muszáj"-jal vitatkoznék. Jelenleg egy 6 éves Tier4-es kártyát használok (GTX 1650), és ha 8GB VRAM lenne rajta, akkor minden is elmenne rajta. Nyilván nem 4K-ban (nem érdekel) és nem RT-vel (kipróbálás jelleggel érdekel), de normális minőségben - nagyon meglepődtem, hogy a Plague Tale - Requiem milyen szépen ment rajta fullHD-ben, közepes beállításokkal, asszem a textúrákat le kellett vegyen a VRAM miatt.

Ha most vennék egy RTX 4050-et (4060 néven árulják![;]](//cdn.rios.hu/dl/s/v1.gif) ) vagy egy RX 7600-at, akkor megint egy Tier4 kártyával huszárkodhatnék évekig.

) vagy egy RX 7600-at, akkor megint egy Tier4 kártyával huszárkodhatnék évekig. -

rumkola

nagyúr

Térdre csirkék! ITT AZ ISTEN!

Köszönjük szépen! -

-

Igen, ez a lelassult fejlődés nekem is szemet szúrt, de sztem GPU fronton még nem is annyira látványos, mint CPU fronton. Ott aztán tényleg semmi fejlődés nincs. És nem csak az Intel szenvedése miatt, mert a tesztkonfigban szereplő i7-9700 helyett a teszt idejére a napi használós gépemben egy Ryzen 7700x-et használtam. Egyáltalán nem adott nekem szinte semmi extrát, de mellette még egy kazán is volt az i7-hez képest, és a batár nagy Dark Rock Pro 4 hűtőmet úgy túráztatta terhelés hatására, mint az i7 sose. A teszt végeztével ment is vissza szépen használósnak az i7-9700, a Ryzent meg eladtam. 5 éves proci, és tökéletesen elég nekem mindenre.

-

Ha jol remlik, a HD 2xxx sorozat idejen tortent, hogy az AMD kolcsonkert nehany mernokot a Transmetatol, mert hiaba volt jo a hardver, egyszeruen nem tudtak rendesen munkara birni szoftveres oldalrol.

-

Na, végigjutottam rajta. Achievement unlocked

Az utolsó két generációban nagy meglepetések nem voltak, 6, ill. 4 év alatt nem igazán mozdult semmilyen irányba a relatív erősorrend.Ami az egész cikkből nagyon jól lejön - mindenféle számszerű növekedések (GFlops, $$$, W, GB - ja ez nem

![;]](//cdn.rios.hu/dl/s/v1.gif) ) lelassult a fejlődés. A 2013-es játékokban a 2008-as kártyák már igencsak kínlódnak sok esetben (jópárban jelen sem voltak), míg a 2023-as tesztekben a 2018-as kártyák elég komfortosan érzik magukat. Ez mondjuk nem feltétlen baj.

) lelassult a fejlődés. A 2013-es játékokban a 2008-as kártyák már igencsak kínlódnak sok esetben (jópárban jelen sem voltak), míg a 2023-as tesztekben a 2018-as kártyák elég komfortosan érzik magukat. Ez mondjuk nem feltétlen baj.Még egyszer nagy gratuláció a cikkhez, igazi landmark mű, még biztosan sokszor előveszem

-

zseko

veterán

Szép adag. Azt hiszem eltart majd egy darabig átolvasni

Sajnálom szegény lektort/korrektort, akinek ezt át kellett nézni, lehet nem volt őszinte a mosolya

-

Atyavilag, valahol megjarna Neked egy szobor

-

Fury X, nálam volt pár féle (Mi8, Duo). Alulfeszelve szárnyat, ugyan úgy a vega56/64 is ilyen volt.

HBM ram érdekes jelenség. Nekem az a gyanúm hogy a túl széles busz több overheadel is jár ami játékoknál nem ideális. Lásd 4-6-8 csatornás platformok, ott a sávszél dögivel, elérési idő kicsivel nagyobb de maga a cpu nem skálázódik annyira jól játékok alatt ha tesztelgetjük több kevesebb csatornával bár ott valószínű az IMC csatornák közötti kommunkációja okozhatja nem tudom.

Ugyanakkor AI-nak meg bányászatra rohadt jó a nagy sávszél.

980Ti-m is volt egy GPU hibás, így arról nem tudok érdemben nyilatkozni viszont a nagy GM200 volt nálam Tesla M40 rohadt jó kártya, 12Gb ram miatt meg időtállóbb volt mint a FuryX.

Ha a Fury kapott volna 8Gb vramot és optimalizálták volna akkor lett volna ütőképes...ja bocs ez lett a vega. -

A Fury X indulásakor 4K-ban kb. egyformán ment a 980Ti-vel, WQHD-ben már elkezdett lemaradni, és fullHD-ben inkább félúton volt a 980 és a 980Ti között. Nem volt annyira rossz ajánlat akkor, csak sajnos a 4K-hoz elég gyorsan kevés lett a 4GB VRAM.

A HBM részben azért kellett, mert kevesebbet fogyasztott - GDDR5-tel még vagy 20-30W ráment volna az amúgy is brutális étvágyra. Meg lehet, hogy pipecleanerként is használták a későbbi professzionális kártyákhoz A sávszél vszleg elég lett volna, már csak azért is, mert a Fury X kapcsán az a pletyka ment, hogy alacsonyabb lett a használható memória-órajel a tervezettnél, és ez a megnövekedett késleltetés miatt betett a teljesítménynek.

A sávszél vszleg elég lett volna, már csak azért is, mert a Fury X kapcsán az a pletyka ment, hogy alacsonyabb lett a használható memória-órajel a tervezettnél, és ez a megnövekedett késleltetés miatt betett a teljesítménynek. -

A Fury-val nem az volt a baj, hogy gyenge, hanem hogy a 980Ti árán adták a sima 980-al versenyképes kártyát

Ráadásul csak ref dizájn létezett belőle vízhűtővel vagy apró méretben. Oda lehetett volna adni az AIB gyártóknak hogy alkossanak belőle valamit, csak akkor nem menőzhettek volna vele, hogy "a mi csúcskártyánk ITX méretű"

Ráadásul csak ref dizájn létezett belőle vízhűtővel vagy apró méretben. Oda lehetett volna adni az AIB gyártóknak hogy alkossanak belőle valamit, csak akkor nem menőzhettek volna vele, hogy "a mi csúcskártyánk ITX méretű"  amire vsz nem volt túl nagy igény már akkoriban se. (tudom volt sima Fury amiből volt custom változat, de az még a Fury X-nél és a Nano-nál is sokkal ritkább).

amire vsz nem volt túl nagy igény már akkoriban se. (tudom volt sima Fury amiből volt custom változat, de az még a Fury X-nél és a Nano-nál is sokkal ritkább).A másik, hogy vajon tényleg szükség volt a méregdrága HBM-re ahhoz a kártyához? Vajon sima GDDR5-el (akár 512 bit mellett mint a 290X) nem lett volna elég a ram sávszél neki?

-

Maxwell és Pascal (Maxwell 2.0) vs GCN3, GCN4 és GCN5.

Először is, remek ötlet volt a GTX 980 és a Fury Nano párosítása, egy 980 Ti VS Fury X meccset teljesen elvitt volna a memóriakülönbség. Így meg látni, hogy a GCN 3-as iterációja relatíve versenyképes a Maxwellel, az évek előrehaladtával kismértékben lassul, de 2021-ig teljesen rendben van, és akkor már a Fury Nano is a 7. évét tapossa.

A Pascal és a két utolsó GCN-generáció viszonylatában pont fordított a helyzet, itt a GCN-ek jönnek fel kis mértékben, ahogy telnek az évek. Viszont mindkét GCN-kártya megindul lefelé 2023-ban, ami problémás - bár az architektúrák 2016-17-esek, maguk a modellek 2018 végén és 2019 elején jelentek meg, így a hasznos élettartamuk csak 4 év - szerintem ez már határeset. -

Hát, egyrészt azt gondolom, hogy 2018-ra már csak kellett volna felbukkanni olyan játékoknak, amik beleférnek a "modern DX12" kategóriába.

Másrészt a Keplerben nagyon gyenge volt a backend, ill. az ütemezők alul voltak méretezve, így a névleges ALU-teljesítmény kihasználhatósága erősen kérdéses volt. A harmatgyenge 960 időnként a 780-at kóstolgatta, szóval nem értem, a 290X miért nem lépett el. -

donatx

újonc

Gigantikus respekt, ez nem kevés idő, pénz, energia és elhivatottság volt így összerakni. Én mindig ár/érték alapján vásároltam, így mindenféle gpu megfordult nálam, szép nosztalgia tripet jártam be, ezúton is köszi

-

kisza25

félisten

Köszönöm a cikket! Hatalmas gratula, még nem olvastam végig, de igyekszem

-

hapakj

őstag

Nem bogoztam végig az eredményeket, de GCN1 meg GCN2 valószínűleg csak modern DX12 játékokban kellene jobbnak lenni mint a Kepler. DX11 alatt szerintem architektúrálisan semmi előnye nincs.

Aszinkron compute vagy bindless rendering esetén húzhat el, ezek ugye DX11 pedig nincsenek -

Kepler vs GCN1 és GCN2: eddig ez az összevetés a legnagyobb meglepetés. Óriási elhúzásokra számítottam a 7970-től és különösen a 290X-től, ehhez képest 2018-ig kb. 0 architektúrából fakadó előrelépést mutat a GCN - akkor meg már 5 éves a 290X is.

A GTX 680 látványosan szenved egyes játékokban a 2GB VRAM miatt (gondolom, ezért is kapott ki ebben a tesztben már az első évben), de összesítésben igazán komolyan csak akkor esik vissza, amikor már elkezdtek nem futni a tesztelt játékok a Kepler kártyákon. Szóval a GTX 680 rosszabb vételnek bizonyult már 2 éves távon is, mint a 7970, de ennek fő oka a sóher memória, nem pedig az architektúra. Meglepő. -

Hát, 15 év távlatában bogozgassa a die shotokat az, akinek két anyja van

Arról az AMD-t lenne érdemes megkérdezni, hogy miért pont 5, az volt az állítás, hogy az adott kor shaderjeihez ez volt a legjobb. Nyilván azért tértek át egy generáció erejéig VLIW4-re, mert ezt a feltételezést a gyakorlat igazolta

Arról az AMD-t lenne érdemes megkérdezni, hogy miért pont 5, az volt az állítás, hogy az adott kor shaderjeihez ez volt a legjobb. Nyilván azért tértek át egy generáció erejéig VLIW4-re, mert ezt a feltételezést a gyakorlat igazolta ![;]](//cdn.rios.hu/dl/s/v1.gif)

-

hapakj

őstag

Elvileg azért, mert az AMD 5-széles vektor ALU-ja kb. annyi helyet foglalt a chipben

Biztosan így is volt![;]](//cdn.rios.hu/dl/s/v1.gif)

wtf, 5 széles? az kb mikor jó shadereknél? Azért annyi, hogy legjobb kihasználtság esetén is 1 felesleges legyen?

Azért annyi, hogy legjobb kihasználtság esetén is 1 felesleges legyen?  még float8-nál és float 16-nál sem segít

még float8-nál és float 16-nál sem segít

Ez továbbra is úgy tűnik, hogy egy 5 széles helyet 2 skalárral jobban jártak volna. -

Igazából SIMT architektúráknál nem is értem miért lenne jó, ha a feldolgozók vektorosak skalár helyett

Elvileg azért, mert az AMD 5-széles vektor ALU-ja kb. annyi helyet foglalt a chipben, mint az NVIDIA 1 db stream processzora. Persze az NVIDIA SP dupla órajelen járt, a VLIW5 meg már jónak számított 60%-os kihasználtsággal, tehát akkora előny eleve nem volt, aztán a driveres támogatás kihullásával meg már semmi vagy kevesebb.

-

Lord Myn

őstag

Nem semmi meló lehetett ezt megcsinálni/megírni...

Csak szőrszálhasogatásként 1-2 megjegyzés, amit olvasás közben észrevettem:

A GTA V hiába 2013-as, a PC-s verzió 2015 tavaszán jelent meg, szóval már mások voltak akkor az aktuális kártyák (nv 9xx széria/Radeon Rx300). Emlékszem én is a 970-esemhez kaptam játék bundle-ben a Witcher 3-mal és a Batman AK-val együtt (ezzel a 3 játékkal az egy jó vétel volt

).

).A Life is Strange True Colors tud Ray Tracing-et (RT Shadows), csak DX12-ben kell elindítani, mert alapból DX11-ben indul.

Az Uncharted 4 PC-s verziója már 2022-ben megjelent, nem 2023-as eresztés.

-

hapakj

őstag

De itt voltam, csak szerintem regem még nem volt. lol. hát hja compiler oldalról az autovektorizáció az egy bonyolult feladat, nomeg ugye ha a kód alapján nem is lehetséges akkor lehetetlen

Igazából SIMT architektúráknál nem is értem miért lenne jó, ha a feldolgozók vektorosak skalár helyett

-

Én anno viszonylag hamar váltottam fullhd-ra, de azóta is maradtam azon. De nem a játékok miatt (persze az is öröm, hogy ez a felbontás ma már olcsón kihajtható), hanem mert egyszerűen egy desktop monitornak szerintem fölösleges nagyobb felbontás 24” méretig. Egyszer próbáltam egy 4K-s monitort, pár hét után eladtam, és visszaálltam fullhd-ra. A játékok jól néztek ki rajta, de a windows felbontás skálázása annyira borzalmas volt, hogy több nyűgöt okozott, mint örömet.

-

Yutani

nagyúr

Mondjuk a tesztet elnézve lehetett már játszani abban a felbontásban is, de kihajtásához felsőkategóriás kártya kellett. Mint most a 4k. Én mivel mindig a középkategóriára lőttem, nem volt indíttatásom váltani. Aztán persze megtörtént, és nekem most a fHD az, ami annó az 1024x768 volt. Most meg már pláne nem lövök a 400-500k-s felső kategóriára.

-

válasz

Armagedown

#43

üzenetére

Armagedown

#43

üzenetére

Bocs de nem volt energiám 400 játék nyűgjeit egyesével managelgetni

Ahol eszembe jutott, és egy egyszerű Google kereséssel értelmesen és könnyen megoldható módot találtam rá, ott megcsináltam. A véleményem az, hogy ilyen korlátoknak PC-n egyáltalán nem szabadna léteznie, vagy pedig a játék saját menüjéből inaktiválhatónak kéne lennie (ahogy pl a GTA5-ben meg is tették, aztán az RDR2-ben megint kivették az "Ignore suggested limits" opciót)

Ahol eszembe jutott, és egy egyszerű Google kereséssel értelmesen és könnyen megoldható módot találtam rá, ott megcsináltam. A véleményem az, hogy ilyen korlátoknak PC-n egyáltalán nem szabadna léteznie, vagy pedig a játék saját menüjéből inaktiválhatónak kéne lennie (ahogy pl a GTA5-ben meg is tették, aztán az RDR2-ben megint kivették az "Ignore suggested limits" opciót) -

Azért régen is voltak 1600x1200-as felbontású batár CRT-k meg LCD-k, az már majdnem full hd

Aki csúcskártyát vett, joggal várhatta el, hogy ki tudja hajtani ezeket. Ugyanígy az AA: ha az adott generáció legerősebb kártyáját veszem meg, akkor elvárom, hogy működjön jól vele. Nameg minél inkább GPU limites körülményeket akartam teremteni. Ha megvolt a 30 fps, azt már játszhatónak minősítettem

Aki csúcskártyát vett, joggal várhatta el, hogy ki tudja hajtani ezeket. Ugyanígy az AA: ha az adott generáció legerősebb kártyáját veszem meg, akkor elvárom, hogy működjön jól vele. Nameg minél inkább GPU limites körülményeket akartam teremteni. Ha megvolt a 30 fps, azt már játszhatónak minősítettem

-

Yutani

nagyúr

Még csak a 26. oldalnál tartok, de két megjegyzésem már van:

1. Én elég későn, 2012-ben váltottam 1024x768@100Hz/CRT-ről fHD LCD monitorra (amit mai napig használok), így nekem rettentő idegen, hogy már 2004-2005-ben erőltetve van a fHD és egyéb magas felbontások. Én ezen kártyák egy részét használtam annó, és 1024x768-ban muzsikáltak jól, de ez az eredményeken látszik is, sokszor nincs meg a már valamennyire játszható sebesség a játékokban (<45-50FPS).

2. Az RV670 esetén fele FPS-eket látunk az NV kártyához képest (noha nem direkt összehasonlítás a cikk célja, tudom). Ez egyrészt azért van, mert a 3870 lassabb eleve, de a fontosabb, hogy az AA köztudottan megeszi az RV670-et, itt pedig 4xAA van alkalmazva eleve magas felbontásban. Ezt a "hibát" az AMD javította az RV770-ben.

Ettől függetlenül persze emelem kalapom, kolléga!

-

Utolsó DX10 generáció, ill. az első két DX11-es páros kapcsán: eléggé durva, hogy míg az 5870 úgy teljesített, ahogy a korabeli tesztek alapján várni lehetett, a 4890 és a 6970 jelentősen alulmúlta korábbi önmagát - lehetséges, hogy a későbbi driverekből kikerültek korábban meglévő optimalizációk?

Mindhárom összevetésre jellemző, hogy a Terascale architektúra állítólagos technológiai előnye sehol nem jelenik meg - mire megjelenne, addigra az addig is viszonylag szűk tartományra fókuszáló driveres támogatás teljesen kiesik a kártyák alól, meg amúgy is értékelhetetlen a teljestményük.@GAI, az 560Ti és az 580 pixel kitöltés számai sztem nem jók, nem adja ki az órajel x ROP képlet őket.

-

hapakj

őstag

válasz

Armagedown

#31

üzenetére

Armagedown

#31

üzenetére

Egyébként hasonló lehet Windows 10 és WDDM 1.x-es kártyák esetén is. Windows 10 már a WDDM 2.x-re építkezik s ha egy videókártyához csak 1.x-es driver van, akkor bizonyos funkciók emulálva lesznek.

Szóval a DX10-es kártyák már nem biztos, hogy maxot hoznak Win 10 alatt

-

válasz

Armagedown

#31

üzenetére

Armagedown

#31

üzenetére

XP-vel nem akartam már szenvedni, és az időtállóság része a modern OS-en való működés is

-

hapakj

őstag

válasz

Armagedown

#31

üzenetére

Armagedown

#31

üzenetére

Igen ez így van, ha egy DX9-es kártya WDDM driverrel van hajtva XPDM helyett, akkor tényleg lassabban működnek. DX9-es kártyák nem tudnak mindent, ami a WDDM-hez kell ezért az OS CPU-ból emulál funkciókat, illetve XPDM-en keresztül jóval vékonyabb az OS réteg a videókártyához.

Windows Vista és 7 még támogatja elvileg az XPDM drivereket. Érdekes lenne egy olyan összehasonlítás, hogy ugyanaz a kártya hogy teljesít XPDM és WDDM driverével. -

Armagedown

őstag

Hatalmas munka lehetett ezt megcsinálni.

Én úgy tapasztaltam, hogy a DX9es kártyák XPvel a leggyorsabbak, újabb Windowsal lassulnak.

Lehet, hogy jobb lett volna azzal lefuttatni a dx9es játékokat, illetve nem kellett volna eröltetni a widescreen felbontásokat 2007 előtti játékoknál, amikor abban az időben nem is volt még elterjedve. -

Valamivagyok

tag

Azt a telibegcvjufjvjvfcj!!!

Szép darab lett, mindig élmény olvasni az írásaidat! Ezzel el leszek egy darabig.

Szép darab lett, mindig élmény olvasni az írásaidat! Ezzel el leszek egy darabig.

-

Yutani

nagyúr

Hát itt végképp elgurult a gyógyszer, kolléga!

Gratulálok!

Gratulálok!

-

Hát ez biza' überepic lett, szerintem az eddigi grande írásaidat is túlszárnyalja

Olyan mennyiségű információ van benne, hogy nagyon lassan haladok az elolvasásával / befogadásával / feldolgozásával - egyelőre a két DX9-es és az első DX10-es generáció eredményeit sikerült processzálnom, de már itt is vannak meglepetések. Nagyon viccesnek tartom, hogy az első DX10 generációs Radeon sokat hangoztatott architektúrás előnye hosszas szenvedés után végül csak kijön - csak éppen 3-4 évvel azután, hogy az adott generáció kártyái már totális irrelevanciába süllyedtek

Hatalmas köszönet, hogy ezt összeraktad

Még jelentkezem

Még jelentkezem

-

A 2900XT-t én is sajnálom hogy nem került be, de beszerezhetetlen... 2900Pro vs 8800GTS320-at terveztem betenni, de a 2900Pro-m is megdöglött

A 6800GS-nél írtam hogy miért ez lett: a nagyobb modellek (GT és Ultra) nem mennek "modern" alaplapban (1st gen core i szériától fölfele). Core2-es konfiggal meg nem akartam szórakozni

Az 560Ti kényszerből került be, mert a GTX480-nak nem láttam értelmét ha 580 is van a cikkben, hiszen majdnem ugyanaz a két kártya. Eleve az 5870-et se akartam betenni, eredetileg úgy terveztem, hogy elég lesz a 6970 de aztán meggyőztek, hogy be kéne tenni az 5870-et is, és akkor annak kellett valamilyen párt találni. A 9800gtx helyett meg nem akartam 9600GT-t betenni, mert az milyen snassz már

Az 560Ti kényszerből került be, mert a GTX480-nak nem láttam értelmét ha 580 is van a cikkben, hiszen majdnem ugyanaz a két kártya. Eleve az 5870-et se akartam betenni, eredetileg úgy terveztem, hogy elég lesz a 6970 de aztán meggyőztek, hogy be kéne tenni az 5870-et is, és akkor annak kellett valamilyen párt találni. A 9800gtx helyett meg nem akartam 9600GT-t betenni, mert az milyen snassz már

Az XP konfigon én is gondolkoztam, mert akkor már ugye AGP konfig is lett volna, és le lehetett volna menni egészen kb GF256 vs Radeon7200-ig

meg években kb 2000-ig. De ez a cikk így is olyan hatalmas lett, hogy az már tényleg overkill lett volna.

meg években kb 2000-ig. De ez a cikk így is olyan hatalmas lett, hogy az már tényleg overkill lett volna. -

envagyok

veterán

Köszönjük ezt a 20 évet felölelő írást, iszonyat munka van benne.

Pár párosítást én máshogy csináltam volna, pl 6800gs, gtx560ti, 9800gtx, meg hiányzik a hd2900xt de lehet nem releváns az eredmény szempontjából, illetve mindenképp jó lett volna az AMD Opengl miatt betenni egy Windows XP konfigot 2004-2006 környékére.

De ez semmit se von le a cikk értékéből, több játékot találtam benne, amitől nem is tudtam.

-

Solten

őstag

Te jo eg...

-

iday

aktív tag

Úristen, very big!

-

Kansas

addikt

Ember, le a kalappal! Nem semmi meló lehetett!

Ezt jó ideig fogom mazsolázgatni... -

hapakj

őstag

válasz

MasterDeeJay

#20

üzenetére

MasterDeeJay

#20

üzenetére

Igen, ezzel egyetértek és tényleg probléma. Jó kis multimediás kártya a pascalos GT 1030, ajánlottam is ismerősnek.

De ha a kepleres változatnak csak kína a piac, akkor valszeg el se jutott ide. Esetleg nem is merték volna forgalmazni megtévesztés miatt. -

hapakj

őstag

Köszi. Egy autós játékból kinézem, hogy igényelte a Cube Map Array feature-t az enviroment probeok miatt

GFXBench Car Chase-ben is pont ez a helyzet. De egyébként más technológia limitációk is lehetnek.

GFXBench Car Chase-ben is pont ez a helyzet. De egyébként más technológia limitációk is lehetnek.

Én most azzal szembesültem, hogy SM2.0-s és SM3.0-s (DX9) kártyákhoz a shadereket DX11-ben a DX10-es SM4.0 speciális profiljaival kell fordítani, de utána teljesen jól megy, mint pl ps_4_0_level_9_1, vs_4_0_level_9_1. Windows Vistan amúgy, amin nincs alapból DX11 Nah ez a mindfuck

Nah ez a mindfuck  De nem adom fel amíg a VkQuake 2 nem indul el Geforce FX-en

De nem adom fel amíg a VkQuake 2 nem indul el Geforce FX-en

-

-

hapakj

őstag

válasz

MasterDeeJay

#16

üzenetére

MasterDeeJay

#16

üzenetére

Hát sejtettem, hogy Kína, de egyébként ez gáz. Reméljük ide nem jutott el

a pascalos GT 1030 vagy 1.5x erősebb mint ez a Kepler. Bár mondjuk a GK107 sem rossz. Laptopban van nekem SLI-be, elég jól vitte a dolgokat. Az az időszak amikor még az SLI működgetett

-

hapakj

őstag

válasz

MasterDeeJay

#16

üzenetére

MasterDeeJay

#16

üzenetére

Hát igen az gáz, ha random webshopok hülyeségeket irogatnak

Én itt gyártó weboldalára meg termék dobozra gondoltam.

Én itt gyártó weboldalára meg termék dobozra gondoltam.

A Vista-s 1.0 WDDM elvileg csak akkor támogat több adaptert ha ugyanazzal a driverrel működnek, különben letiltja az egyik vezérlőt. Lehet ezért nem sikerül befele üzemelnem FX 5200-at mert csak WDDM 1.0-s drivere van és van egy integrált intel IGP az alaplapon

Igazából Windows 8 óta már kell dx-es hw-es gyorsítás a Windows-nak. Ha nem lenne meg, akkor elkezdi WARP-pal CPU-ból számolni. Látható, hogy Win 11 elindulgat régi hw-eken is de eléggé dobálják kifele a régi cuccok támogatását. Simán el tudom képzelni, hogy a sokadik verzió csak WDDM 2.0 driverrel és dx12 "támogató" kártyával indul majd csak el. -

GT730-ra dx12-őt ír amazon. [link]

Korábbi windowsokkal ilyen nem volt azaz talán win7-nek az areohoz kellhetett dx9 de azon kívül nem emlékszem ilyenre.

Vista és 7-es elment XP driverekkel azaz igazából akár milyen dx7-8-9-stb kártya jó volt.

Win10 nek volt a minimum a dx9, wddm.

Win11-nek pedig elvileg dx12 gyakorlatilag meg wddm driverrel ugyan úgy dx9-es kártya. Habár legutóbb használtam NVS450-est win11-hez és kékhalálozott ha a második gpu is aktív volt rajta. Szóval ott valamit azért variáltak de ott sem a dx-el hanem a wddmnél a túl alacsony verziós (vistás) nem teljesen stabil.Kepleres 1030-ast csináltam régen egy 640-est moddolva, talán retró topikban meg van valahol. Kínában volt leginkább amikor kevés volt a GPU. Azt gondoltam hogy fake, de 1030-as drivere rámegy, pontosabban az inf-ben külön van kepleres 1030-as szóval nem fake és valódi nvidia kreálmány.

na megtaláltam az enyémet

Itt a GPU-Z-nek fake-t kellene írnia, de nem írja mert a driver is elfogadta gt1030-asnak.

A gond az hogy szoftveresen meg kepler már nem támogatott így hiába pascal számozása van az új driverekbe már nincs benne a kepleres 1030-as.

-

A Tesla 2.0 nem tud DX10.1-et, helyesebben csak a GT220 és a GT240 tud papíron, a nagyobbak nem, de a gyakorlatban ha jól emlékszem ezzel a két kis kártyával sem sikerült beizzítanom anno. DX12 papíron a Fermi-től van elvileg, de a gyakorlatban nem működött vele semmi, ami DX12-t igényel. A Kepleren már mentek a korai DX12 játékok, de az is csak 11_0 tehát a modernebb játékok nem mennek vele. AMD fronton az első GCN-től fölfele van feature level 11_1. Volt olyan játék, ami Kepleren nem ment, de a HD 7970-en igen.

-

hapakj

őstag

válasz

MasterDeeJay

#10

üzenetére

MasterDeeJay

#10

üzenetére

Oké ez világos, meg tényleg gáz, hja én is túlképzett vagyok

BTW szerintem leginkább a GTX 600 és 700 szériában volt kavarás, ott voltak vegyesen Fermik / Keplerek meg Maxwell 1.0-k. GTX 900 már desktop fonton egy kivételével Maxwell 2.0

[link] - ezt a kártyát milyen piacra szánták?

Látott már valaki ilyet egyáltalán?

Látott már valaki ilyet egyáltalán?De egyébként ugyan ez volt DX11-el is, csak ott valahogy nem lett ekkora hangja. Ugyanis DX9-ig visszamenőleg minden kártyán működhet a DX11, szóval ott szerintem a teljesítmény és feature szórás még dúrvább. Gondolom azért nem lett semmi belőle, mert nem igazán készült DX11-es runtime-ot használó játék, ami DX9 hw-en futott volna.

S épp ezért nem igazán lesz új DX egyelőre, mert a runtime inkább sw technológia dolog, nem pedig hw-es képességeket mutat. Jelenleg nincs ok egy új API-t bevezetni, mert a DX12 is modern és kényelmesen elférnek benne az új featureök.

-

hapakj

őstag

Szerintem Tesla 2.0 már tudja a FL_10_1-et.

Egyébként létezik olyan FL 11_0, 11_1 kártya amire DX 12 van nyomva? Mindegyik a Windows 10 és DX12 megjelenése előtt jött ki, legalábbis nvidia oldalán. Windows 10-el egyidőben a Maxwell 2 jött ki, ami azért már elég jól támogatja a DX12 hw-es képességeket.

Valószínűleg az MS döntése is volt, hogy az FL_11_0 / FL_11_1 kártyák is DX 12 "képesek" legyen, hogy legyen a Win 10 mögött platform.

-

válasz

MasterDeeJay

#10

üzenetére

MasterDeeJay

#10

üzenetére

Voltak kavarások régen is... DX8 vs 8.1 (SM1.1, SM1.4). Aztán a DX9-nél a 9a, 9b, 9c... A DX10-nél a 10.1 amit csak az AMD támogatott. A 11-nél nem rémlik ilyen. De ez a DX12 a legrosszabb user szemmel, mert tényleg minimum 5 féle kártya létezik... feature level 11_0, 11_1, 12_0, 12_1, 12_2... és mindnek a dobozára az lesz matricázva, hogy DX12 kompatibilis. És akkor az "RT-t tud vagy nem tud, ha tud akkor mennyire tud" kérdéskörről még nem is beszéltünk. Már rég DX13-nál kéne tartani minimum.

-

Nekem már nem bonyolult mivel beleástam magam eléggé de átlag user nem fogja érteni miért megy vagy miért nem a játéka.

Konkrét példával ott a Cyberpunk, Kepleren ment amikor kijött de már akkor volt rajta dx11-es parancssori kapcsoló. Aztán fejlesztők később ezt kivették de futott továbbra is a játék majd később úgy gondolták hogy meghúzzák a határokat azzal hogy mesterségesen tiltják a 12_11.0 kártyákon való futást miközben a kártyák továbbra is tudják futtatni ha ezt a limitációt kivesszük.

User mit lát ebből:

GTX Titan kártyája (fullos kepler 6gb vrammal) futtatja a játékot, majd dx12 only lesz a játék és továbbra is megy neki, örül, aztán bejön a feature level limitáció és nem indul neki többé. Pedig héé hát dx12-es a kártya vagy nem?

Tehát azzal van a bajom hogy minden dx11-es nvidia kártya (amdnél meg ahogy tudom gcn-estől) támogat dx12 apit, de nem minden dx12-es apinak megfelelő kátyán mennek dx12 apis játékok legtöbbször szoftveres limit miatt.

Másik pl Intel Arc széria dx12 api only volt aztán mégsem ment rajta minden lásd Starfield (ami szintén dx12_11-es) nesze neked oda vissza kompatibilitás, és ugyan ennél a szériánál vulkan apival van átírva a dx11 és alatti támogatás.

Tehát nvidia megkeverte rendesen az eredetileg dx11-es kártyáival, és továbbmegyek az átnevezősdivel is, pl a gtx960m az ugyan maxwell de első gen és az 750ti ami kepler lenne de mégsem az, gtx920m meg kepler...aztán gt730 meg fermi is lehet...ugyan így van GT1030-as is kepler. [link] (igen nvidia drivere szerint is van)

AMD ugyan így megkevert mindent GCN-eket is rakosgatta össze vissza számozásban ott még talán nagyobb a káosz mint nvidiánál.

Összefoglalva mi is a káosz:

DX11-es kártyák támogatnak DX12-es API-t de nem minden DX12-es játék indul el rajtuk.

Videókártyák számozása nem tükrözi a feature level szintjét. Nem állítható egyértelműen hogy egy széria ezt és ezt támogatja. -

hapakj

őstag

válasz

MasterDeeJay

#5

üzenetére

MasterDeeJay

#5

üzenetére

Igazából nem értem mi olyan bonyolult. DX11, DX12 az API, a Feature level pedig hogy mire képes a kártya. A 960M vagy 750 Ti ugye Maxwell v1, ami már egészen jó dx12 implementációt támogat. Szerintem kb a leglényegesebb dolog kb a resource binding fejlettsége, ami a bindless renderinghez kell s ebben Maxwell 1 már legmagasabb szinten van.

A Fermikre és Keplerek volt kissé ráerőszakolva a DX12, de azokon is jól mennek az alapfunkciók.

BTW én most DX11-ezek egy Geforce FX 5200-ason Windows Vistán

-

xtremist

őstag

Azta! Nagyon komoly munka áll mögötte, igazi hiánypótló, gratulálok, és örülök hogy nem kellett rá várni sokat!

-

Soderes

senior tag

B*szd meg!

Evvel történelmet írtál!

Esős napokon majd elolvasom.

Milyen hosszú ez? Mint egy Mikszáth kötet.Kemény kötésbe nem jelenik meg esetleg.

-

válasz

MasterDeeJay

#5

üzenetére

MasterDeeJay

#5

üzenetére

A DX12 véleményem szerint egy totális katyvasz, és user szemszögből teljesen átláthatatlan, hogy melyik kártya mit támogat, és melyik játék mit igényel. Már rég DX13-nál vagy inkább 14-nél kellene tartani, de a Microsoft szerint jól van így

-

Pár érdekesség:

Cypberpunk 2077 fut dx11-es nvidia kártyákon (dx hackel), én is egy 960m-en játszom vele ami egy 750ti maxwell első szériája. Dx12(feature level 11) Frame gen is megy szintén hackel.

Kepleren sőt Fermi is ugyan ezen támogatású.

https://nvidia.custhelp.com/app/answers/detail/a_id/3711/~/which-nvidia-gpus-will-support-dx12%3F

El ne felejtsük hogy az eredeti kiadás is GTX780-at írt minimumnak.

Hozzáteszem nyilván egy 750ti teljesítményű kártya alatt már igencsak a játszhatóság határát súrolja. Azaz oké ennél gyengébben már olyan szinten ronda a játék hogy nem éri meg elindítani sem.

Tudom totál furcsa hogy egy elvileg egy tizenx éves kártya is dx12-es de hivatalosan is az.

Tudom totál furcsa hogy egy elvileg egy tizenx éves kártya is dx12-es de hivatalosan is az.

Persze ez örök vita hogy nvidia így gondolja aztán fejlesztők meg szívnak vele és pont ez miatt lett limitálva hogy ne fusson dx11 feature levelen a játék.

Tehát külön kell választani azt hogy egy játék DX12-t követel meg azaz akkor a DX12 feature level 12-re gondolunk alapból pedig maga a DX12 sokkal több szint ennél.Ugyan így Raytracing is sokrétű lehet, az elvileg RT motorral nem rendelkező nvidia kártyák is tudnak RT-t futtatni, példának Volta GPU ami a GTX1xxx és RTX2xxx között jött ki mégis tud futtatni nyers erejéből normális teljesítményű Raytracing-et.

-

Aztaaaaaa....nyálcsorgatós smiley.....

Mentve az örök kedvencekbe!

Ez munka! -

-

oriic

HÁZIGAZDA

Amikor az oldalválasztó listája nem fér ki egy oldalra.

Új hozzászólás Aktív témák

- PCI Express 7.0 – Brutális sebesség, de minek?

- Arc Raiders

- PayPal

- Ügyesen előzi meg a 12V-2x6 tápkonnektor leégését a Dell

- Motorolaj, hajtóműolaj, hűtőfolyadék, adalékok és szűrők topikja

- Építő/felújító topik

- Kínai és egyéb olcsó órák topikja

- Itt a Galaxy S26 széria: az Ultra fejlődött, a másik kettő alig

- WoW avagy World of Warcraft -=MMORPG=-

- Okoslámpával vinne fényt az OpenAI a sötétségbe

- További aktív témák...

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

)

)

. Futott még a jelenlegi Ryzen 7 5700G procis konfigurációban, de nemrég lecseréltem egy

. Futott még a jelenlegi Ryzen 7 5700G procis konfigurációban, de nemrég lecseréltem egy

méghozzá amiatt a viselkedése miatt, hogy ha a DP-s monitort kikapcsolod (NEM lehúzod a kábelt csak simán kikapcsolod) akkor a windows számára az a monitor megszűnik létezni, és nekiáll szétcseszni a teljes display configot, átrendezni az ablakokat, ikonokat, mindent. Mivel mint írtam én rendszeresen lekapcsolom a monitort, ha éppen filmet nézek a TV-n, ezért számomra kizárólag a HDMI jöhet szóba, mert az ilyet nem csinál. HDMI-ből meg általában csak 1 db van egy kártyán, ezért kell a splitter. Az utóbbi 12 évben így használom, és tökéletesen bevált.

méghozzá amiatt a viselkedése miatt, hogy ha a DP-s monitort kikapcsolod (NEM lehúzod a kábelt csak simán kikapcsolod) akkor a windows számára az a monitor megszűnik létezni, és nekiáll szétcseszni a teljes display configot, átrendezni az ablakokat, ikonokat, mindent. Mivel mint írtam én rendszeresen lekapcsolom a monitort, ha éppen filmet nézek a TV-n, ezért számomra kizárólag a HDMI jöhet szóba, mert az ilyet nem csinál. HDMI-ből meg általában csak 1 db van egy kártyán, ezért kell a splitter. Az utóbbi 12 évben így használom, és tökéletesen bevált.

![;]](http://cdn.rios.hu/dl/s/v1.gif) ) vagy egy RX 7600-at, akkor megint egy Tier4 kártyával huszárkodhatnék évekig.

) vagy egy RX 7600-at, akkor megint egy Tier4 kártyával huszárkodhatnék évekig.

Tudom totál furcsa hogy egy elvileg egy tizenx éves kártya is dx12-es de hivatalosan is az.

Tudom totál furcsa hogy egy elvileg egy tizenx éves kártya is dx12-es de hivatalosan is az.