Hirdetés

- bb0t: Ikea PAX gardrób és a pokol logisztikája

- GoodSpeed: A RAM-válság és annak lehetséges hatásai

- Luck Dragon: Asszociációs játék. :)

- GoodSpeed: Márkaváltás sok-sok év után

- Sub-ZeRo: Euro Truck Simulator 2 & American Truck Simulator 1 (esetleg 2 majd, ha lesz) :)

- sziku69: Fűzzük össze a szavakat :)

- ldave: New Game Blitz - 2025

- Real Racing 3 - Freemium csoda

- Gurulunk, WAZE?!

- Brogyi: CTEK akkumulátor töltő és másolatai

Új hozzászólás Aktív témák

-

#45185024

törölt tag

-

Raggie

őstag

-

Abu85

HÁZIGAZDA

válasz

Ren Hoek

#27392

üzenetére

Ren Hoek

#27392

üzenetére

Lehet viccesnek is felfogni, hogy ez mennyire az AMD-nek kedvez, de valójában a PC-nek ez eléggé nagy baj is. Nem a kedvezés, mert az API működésében vannak olyan részek, amelyek valamelyik architektúrának mindig kedveznek. Ez kivédhetetlen, amikor valami általános megoldással szeretnének előállni a szabványalkotók. Ugyanakkor ezek mind megbeszéléssel születtek meg, tehát az AMD, az Intel és az NV is elfogadott bizonyos kompromisszumokat. És összességében így "a gép kidobott egy DX12-t és egy Vulkánt", amivel nagyjából minden érintett elégedett most. És ez általános elégedettség, például a DX12-ben vannak pontok (root signature modell, fast pathok kizárása), amelyek az NV-t igen hátrányosan érintik, de a legrosszabb esetben is korrigálható pontokról van szó, csak nem sokan korrigálják azt, tehát végeredményben ugyanott vannak, de legalább nem dönti be a sebességet.

A wave intrinsics ennél sokkal durvább. Nem is igazán érthető, hogy miképp lesz ez elfogadva. Valószínűleg a Microsoft azt mondta az Intelnek és az NV-nek, hogy ez ilyen lesz és vagy támogatjátok vagy viszlát. Ez már önmagában egy hatalmas probléma, meg kellett volna beszélni, hogy az egyes hardverek mire képesek, és azok alapján kialakítani egy közös pontot a függvényeknek. Mert most hiába hozol global ordered append csoportot két függvénnyel, ha csak a GCN-ben van megfelelő belső memória a wave-ek sorrendfüggő feldolgozására. A többi hardver rá van kényszerítve, hogy a VRAM-ot használják, vagyis chipen kívülre kell viszi a munkát, és ez sosem egy sebességbajnok megoldás. Ezzel igazából a fejlesztők végül nem nyernek sokat, mert tök jó, hogy kaptak egy szabványos megoldást a konzoloknál elérhető fícsőrökre, de ugyanúgy kellenek majd alternatív shaderek az NV és az Intel GPU-kra, mint eddig. Csak annyit nyert a piac, hogy az alternatív shaderek az AMD GPU-kra már nem kellenek, de most tényleg erről szólna egy szabvány? -

Abu85

HÁZIGAZDA

válasz

Ren Hoek

#27366

üzenetére

Ren Hoek

#27366

üzenetére

A konzolos uralom onnantól számít problémásnak a konkurenseknek, ha a szabványalkotók nem a piac érdekeit nézik, hanem a konzolét. Eddig szerencsére ez nem állt elő, de a wave intrinsics a shader modell 6.0-ban eléggé gázos lesz az Intelnek és az NV-nek.

Eddig csak az történt, hogy az AMD-re lehetett hozni opcionálisan konzolos optimalizálást. De ez nem volt szabványos. A Vulkan sokkal általánosabban fejlődik. Például a SPIR-V ballott nem csak GCN-re mappelhető hatékonyan, ellentétben a DXIL verzióval, ami 64 bites maszkkal tér vissza, és milyen véletlen, hogy a GCN 64 bites skalár regisztert használ. Ebből egy éven belül simán lesznek gondok. A Vulkan egyébként nagyon jó PC centrikus megoldásokkal próbál operálni, csak a Khronos lassan halad.

(#27367) Zsébernardo: Mindkettő fontos, de a termékek között is van kritikus fontosságú. Idén ez a Naples, illetve a Scorpio SoC. A többi nem kritikus.

(#27368) TTomax: A konzol az AMD-nek jelenleg évi ~1,5 milliard dollár közötti bevételt jelent. Ezért fontosak ezek a fix megrendelések. Eves szinten ezek tíz milliós fix eladások.

(#27371) imi123: A PS5 messze van. Lehet amúgy egy még gyorsabb PS4 verziót terveztetni az AMD-vel PS4 Pro Plus neven mondjuk. De ezek folyamatosan csúsztatják az új generáció érkezését, mert a fejlesztőknek ki kell termelni a generációra vonatkozó befektetést. A köztes hardver egyébként nem tűnik már rossz elgondolásnak, mert pont annyi időt dob ra az aktuális generációra, amivel elhúzható a valódi frissítés 2023-ig. Ezzel jó pár extra évet nyernek a partnerek, így nagyobb befektetésekkel operálhatnak.

-

-

Abu85

HÁZIGAZDA

válasz

Ren Hoek

#26810

üzenetére

Ren Hoek

#26810

üzenetére

Szerintem mindenképpen a Vulkan lesz az elterjedtebb, mintsem a DX12. Alapvetően nincs nagy különbség a két API között. Persze apró eltérések miatt fel lehet hozni mindkettő mellett a pró/kontra érveket, de nem tud sokkal többet a DX12. Ami igazi érv mellette az a multi-GPU és az executeindirect. A HLSL shaderek megléte nyilván ma fontos, de a SPIR-V nyílt rendszer, a DXIL is az lesz, tehát igen egyszerű lesz ezeket használva GLSL shadert küldeni DX12-re, vagy HLSL-t Vulkan API-ra. Az új platformok nyíltsága tulajdonképpen lehetővé teszi azt, hogy a magas szintű nyelv igazából ne számítson. Abban írja meg a fejlesztő a shadert, amiben akarja, aztán a nyílt rendszert kihasználva keres vagy ír egy fordítót, ami abból SPIR-V vagy DXIL kódot generál. Ez a jövőben egyáltalán nem lesz probléma. Ma még az a D3BC zártsága miatt, de ez az IR úgyis kuka lesz.

A Vulkan pedig kiegészíthető multi-GPU-val, multidraw indirecttel, akár bindless modellel, tehát végeredményben egyedül a platformfüggetlenség marad meg, mint előny. A többségnek ez sokkal jobban fog számítani, mint annak a kevés csúcstechnikával dolgozó stúdiónak/kiadónak, akiknek amúgy tényleg érnek is valamit a DX12 gyors és amúgy tényleg csúcs fejlesztései. Nem mellesleg nagyon nagy érv még a Vulkan mellett, hogy tényleg úgy építette fel a Khronos, hogy gyártófüggetlen legyen, míg a Microsoft a DX12-t láthatóan GCN-re csinálta az Xbox One miatt, és különböző fallback módok vannak a többi hardverre, ami ugyan nem követel eltérő kódot, de ezek implementációja jobban eszi a processzort, mint a GCN-é. Az Intel is egy brute force fejlesztéssel húzta be magát a legjobb szintekre, ami közel sem hatékony, de volt tranyóbudget bőven rá. Például más ilyet nem tud megjátszani. Ellenben a Vulkan jelenleg rendkívül igazságos az eltérő gyártók hardvereivel, ha lehet ilyet mondani.

-

huskydog17

addikt

válasz

Ren Hoek

#26810

üzenetére

Ren Hoek

#26810

üzenetére

Nem, nem fog, legalábbis az elkövetkező néhány évben biztosan nem, ugyanis még jó néhány játék érkezni fog Vulkan támogatással, arról nem is beszélve, hogy a Unity Engine 5.6-os verziójában is lesz Vulkan támogatás.

Vulkan-hoz hatványozottan nagyobb támogatás volt, mint ami valaha volt Mantle-höz. -

Yutani

nagyúr

válasz

Ren Hoek

#26214

üzenetére

Ren Hoek

#26214

üzenetére

Én az idsoft RAGE játékának megatextúrázásán láttam a különbséget, amikor kipróbáltam SSD-s gépen is. HDD-s gépen forduláskor (a bárka bejáratánál, a játék kezdő lokációján) lehetett látni, ahogy rakja ki a textúrát, de SSD-s gépnél ebből semmi nem látszott. Nekem ez tűnt fel, de aztán lehet, hogy sok rendszermemóriával ezt ki lehet védeni, nem tudom.

-

HSM

félisten

válasz

Ren Hoek

#26214

üzenetére

Ren Hoek

#26214

üzenetére

"nem kértek SSD-t, és használhatatlan kb az újabb SSD-s géphez képest."

Ez meg megint a másik véglet durva eltúlzása... Egy normális HDD-s alrendszerrel is el lehet jó sebességet érni megfelelően használva. Nyilván jobb az SSD, meg hülyebiztosabb, de el lehet lenni HDD-vel is. -

HSM

félisten

válasz

Ren Hoek

#26195

üzenetére

Ren Hoek

#26195

üzenetére

A Crysis 3 azon a pályán épp ilyen pedig.

(#26196) Szaby59: Mivel régi játék a Crysis 3 már a régi driverben is elég jól volt optmializálva. Az OS váltásnak se volt semmi köze a DX11 címekhez.

(#26197) Attix82: Nem látod a képeket, amiket linkeltem, hogy kihasználja a játék?

43 FPS van 36 helyett, ha 4 helyett mind a 6 mag aktív.

43 FPS van 36 helyett, ha 4 helyett mind a 6 mag aktív. -

-

#00137984

törölt tag

válasz

Ren Hoek

#26036

üzenetére

Ren Hoek

#26036

üzenetére

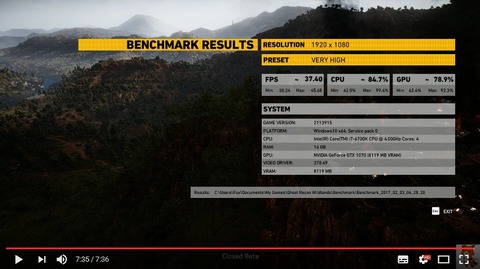

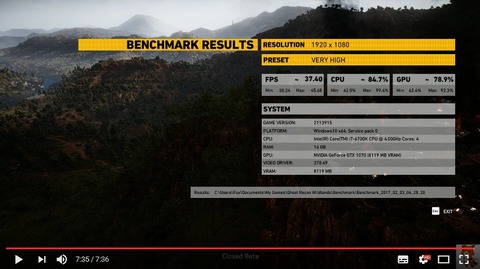

Ghost Recon Wildlands gépigénye láttán már egy RX 480-485 cserének sem láttnám az értelmét.

Az R9 390X tulajoknál talán valamivel jobban fog menni ez a játék, mert ott egy erősebb GPU mellé 64 ROP és 512bit memóriabusz van jókora sávszéllességgel (384 GB/s). Ja persze ezért van az a jó magas fogyasztása... Most még tart a Zárt Bétatesztelés, de egy GTX 1070 szintén alaposan meg tud izzadni a játékban. Egy kis optimalizálás még szükséges lehet, meg egy Day One Patch. Aztán majd érkezik hamarosan a Mass Effect Andromeda. Ezeknél a játékoknál ha esetleg CPU limitem alakulna ki helyenként az i5 4690K procival, akkor egy erős videókártyával a 75 FPS visszaesik nálam 60 FPS-re. Na bumm...

Az R9 390X tulajoknál talán valamivel jobban fog menni ez a játék, mert ott egy erősebb GPU mellé 64 ROP és 512bit memóriabusz van jókora sávszéllességgel (384 GB/s). Ja persze ezért van az a jó magas fogyasztása... Most még tart a Zárt Bétatesztelés, de egy GTX 1070 szintén alaposan meg tud izzadni a játékban. Egy kis optimalizálás még szükséges lehet, meg egy Day One Patch. Aztán majd érkezik hamarosan a Mass Effect Andromeda. Ezeknél a játékoknál ha esetleg CPU limitem alakulna ki helyenként az i5 4690K procival, akkor egy erős videókártyával a 75 FPS visszaesik nálam 60 FPS-re. Na bumm...  RX 480 8GB meg még a 45-50 FPS-t is egy erőssen tuningolt i7 procival lesz képes kihozni magából (CPU igényesebb az AMD videókártya). Szerinted most milyen írányba tudok hirtelen továbbfejleszteni, amikor a VEGA vagy egyéb életképes AMD videókártya még sehol. Ez van...

RX 480 8GB meg még a 45-50 FPS-t is egy erőssen tuningolt i7 procival lesz képes kihozni magából (CPU igényesebb az AMD videókártya). Szerinted most milyen írányba tudok hirtelen továbbfejleszteni, amikor a VEGA vagy egyéb életképes AMD videókártya még sehol. Ez van...

-

HSM

félisten

válasz

Ren Hoek

#25513

üzenetére

Ren Hoek

#25513

üzenetére

Ha a gyártói fanatizmus téma esetleg célzás lett volna nekem, arra csupán annyit tudok mondani, hogy részemről csupán a számítógépes játékok jövője, ami révén ezt vagy azt gondolom a cégekről. És ez sem fanatizmuson, hanem tényeken alapul.

Ha neked olyan speciális igényeid vannak, amikhez most ez volt a jó kártya az príma, nekem semmi bajom a racionális döntésekkel. Nem emiatt néz úgy ki ma a piac, ahogy.

(#25515) Zsébernardo: Nekem nem a tulajokkal van bajom, hanem hogyha valótlanságok vannak leírva. Valamiért engem zavar. Ilyen vagyok. Írja bárki is.

"Szerintem igy kellett volna egyből kiadni az RX 400 szériás videókártyákat"

Az a gond, hogy azért lehetséges a kiadás után fél, egy évvel jobb verziót kihozni, mert addig összegyűlik elég tapasztalat finomítani a gyártást, és egy új revízióval magasabb órajeleket elérni. Ezt nem tudták volna a startkor megtenni sajnos.

Egyébként a Polaris Refresh-ről is inkább lebeszélnélek, hacsak nem valami GDDR5X-es vadállat lesz óriási (~1500Mhz) körüli órajelekkel, amit kétlek, akkor csak ablakon kidobott pénz lenne ismét részedről. Ha jól tudom, a jelenlegi MSI 470-ed egy elég jó 470, amin normális TDP keret is van beállítva, és emiatt elég jól tartja az órajeleit. Többre mennél egy kis processzor tuninggal, ami ráadásul ingyen is van, csak idő, és utánaolvasás, vagy ha tuningolni nem akarnál, akkor egy i7 4790K-ra váltással, esetleg ha félrerakod a pénzt a Vega megjelenésére. Ezek előrelépések lehetnének...

Ezek előrelépések lehetnének... -

Zeratul

addikt

válasz

Ren Hoek

#25510

üzenetére

Ren Hoek

#25510

üzenetére

Bírom az ilyen önjelölt IT megmondó embereket, akik a gyártási technológiáról halvány fogalommal nem rendezve osztják az észt hogy egy sokmilliárd tranyóból álló chipet hogy kell gyártani. A polarisnak volt vagy 7 revíziója mire piacra került és így is nagyon szór a fogyasztásban a végtermék. Nagyon "bölcs" dolog lett volna a 2X akkora chipet ráereszteni az először használt 14 nano technológiára, ja hogy 20-30 % lett volna működőképes az önjelölt "mérnököket" soha nem érdekelte.

Példádra visszatérve: Senki nem fogott Kalasnyikovot a tarkódhoz hogy eladd a 970-ed és RX480-t végy, tudni lehetett hogy mit tud.

-

HSM

félisten

válasz

Ren Hoek

#25510

üzenetére

Ren Hoek

#25510

üzenetére

Igazából az egész érvelésed erről szól. A keserűségedről, hogy drágán kellett 1070-et venned, amit a konkurencia hiányára fogsz. Magadat győzködöd, hogy jó ötlet volt abba tenni ennyi lóvét. Így viszont semmi értelme veled erről beszélni, mert úgyis erről fog szólni minden.

Te és a 1070. Akkor miért nem örülsz, hogy tartani fogja az árát? ......

Te és a 1070. Akkor miért nem örülsz, hogy tartani fogja az árát? ...... -

válasz

Ren Hoek

#25504

üzenetére

Ren Hoek

#25504

üzenetére

"Ellenben egy 14 nm-es GCN3-at akár simán megvettek volna jó áron 490 néven. Kit érdekel hányas GCN?"

Erre a mondatra reagáltam.

Biztos lehetsz benne, hogy menne az átnevezős duma.

Amúgy a 390X-nél kaptunk +4giga Vram-ot, és +5-8% teljesítményt az előző szériához képest, illetve a tavalyi játékokban már akár többet is. Ettől még java részt átnevezés volt, ebben egyetértünk.

-

HSM

félisten

válasz

Ren Hoek

#25502

üzenetére

Ren Hoek

#25502

üzenetére

Nem arattak volna. Egyszerűen oda kevés, amit hozni tudtak volna. A rossz, már megjeelnés előtt elbukott alternatívát meg mindek piacra dobni?

Ezért is kell a Vega az áttervezett frontendjével, és hatékonyabb CU-jaival. Azzal versenybe kerülnek majd ismét.

Ezért is kell a Vega az áttervezett frontendjével, és hatékonyabb CU-jaival. Azzal versenybe kerülnek majd ismét.  Addig meg azzal kell beérni, ami van. Ez teljesen korrekt stratégia. Nem húznak le egy rakás pénzzel egy félkész motyóért, hogy egy év múlva újra lehúzhassanak.

Addig meg azzal kell beérni, ami van. Ez teljesen korrekt stratégia. Nem húznak le egy rakás pénzzel egy félkész motyóért, hogy egy év múlva újra lehúzhassanak.(#25504) Ren Hoek: Ja, tényleg nem gáz, hogy a különböző 115x foglalatokba már lassan a 7. generációban adják el ugyanazt átcímkézve.

Kicsit se. A 7 éves húzott hatmagos HEDT procim éppen beéri egy friss Skylake i7, de azt is meg kell tuningolni, hogy lehagyja egy picit. Vicc. De már tovább mentek, mert a friss Kaby Lake már Skylake magokat használ, tehát még annyit se léptek előre, mint eddig.

Kicsit se. A 7 éves húzott hatmagos HEDT procim éppen beéri egy friss Skylake i7, de azt is meg kell tuningolni, hogy lehagyja egy picit. Vicc. De már tovább mentek, mert a friss Kaby Lake már Skylake magokat használ, tehát még annyit se léptek előre, mint eddig.

Egy 390X Polaris-osításnak lett volna értelme, de nem számítod bele sehol, hogy sok pénzt és humán erőfforrást vont volna el a Vega elől, ami hosszabb tvon lehet rosszabb verzió lett volna.

-

válasz

Ren Hoek

#25501

üzenetére

Ren Hoek

#25501

üzenetére

Ha így lett volna, akkor meg menne most a "fúj, megint egy átnevezés - köcsögök megint lehúznak egy bőrt rólunk" műsor.

16' a közép kategória éve volt, mert ezt tudták erre az évre előállítani.

17' a felső kategória éve lesz, mert most készül el.Szerintem ennyi. Azt, hogy miért hagynak üresen 1 évig egy termék kategóriát nem a mérnökök döntik el, a sokat dicsért vezetőség, a marketingesek, és nem utolsó sorban az anyagi lehetőségek a döntőek.

-

HSM

félisten

válasz

Ren Hoek

#25492

üzenetére

Ren Hoek

#25492

üzenetére

Mi a gamer igény? Minél szebb játék + minél több FPS, +igényeseknek minél kisebb input lag. Namost, ezek sokszor nehezen férnek meg egymás mellett. Az AMD a low-level API-kban látta, hogyan lehet a játékosoknak szebb, gyorsabb, és kisebb input lagú játékokat és ehhez hardvert adni.

Ehhez képest az Nv gondolt egy nagyot, és inkább apait-anyait beleadott, hogy a DX11-ben, akár nagyobb input laggal, de a lehető legtöbb FPS-t kipréseljék.

Mint írtam, mindkét elképzelés kockázatos volt, nem tudom, ezen mit nem lehet érteni. Az AMD nagyobb reformot tervezett, és rajtuk kívülálló okokból nem jött be. A vicc, hogy éppen az Nv, aki inkább kicsit félretette a játékosok igényeit a sajátjaival szemben. Érdekes aspektus, nem?

Igen, hiba a fél piacot termék nélkül hagyni. (Kevesebb mint a fele, jóval, de mind1 most.) Ugyanakkor ha nem tudnak most oda terméket hozni gazdaságosan, akkor nem tudnak. Nyilván az erőforrásaik is komolyan megsínylették az elmúlt éveket. Ők nem dobálhatnak égbe világba csipeket, mint a zöldek, rengeteg pénz csak egy lapkát is elstartolni.... Nyilván a P10, P11-el is azt a réteget célozták meg, ahol a legjobbnak ítélték az esélyeiket jó terméket letenni az asztalra.

-

HSM

félisten

válasz

Ren Hoek

#25474

üzenetére

Ren Hoek

#25474

üzenetére

"és állandóan validáljuk piaci szempontból az igényeket"

Na, ezaz amit egy GPU architektúránál NEM tudsz megtenni. Ugyanis a GPU fejlesztés elején már a fő dolgok, mint pl. leginkább az architektúra kvázi kőbe vésődnek, és a piaci szempontból követés itt gyakorlatilag azt jelenti, hogy mindig csak újratervezik a GPU-t, ami azt jelenti, hogy sosem lenne belőle termék. Finomítani persze tudsz megjelenés előtt, mondjuk legyen benne 3072 shader (ami eredetileg a Hawaii-ba került), vagy elég lesz az magasabb órajellel és kihozatallal 2816-nak. De olyat már nem tudsz, hogy hoppá, nem úgy jön a DX12, ahogy kéne, akkor gyorsan csináljunk valami egyszerűbb DX11 optimized dizájnt.

Ugyanis a GPU fejlesztés elején már a fő dolgok, mint pl. leginkább az architektúra kvázi kőbe vésődnek, és a piaci szempontból követés itt gyakorlatilag azt jelenti, hogy mindig csak újratervezik a GPU-t, ami azt jelenti, hogy sosem lenne belőle termék. Finomítani persze tudsz megjelenés előtt, mondjuk legyen benne 3072 shader (ami eredetileg a Hawaii-ba került), vagy elég lesz az magasabb órajellel és kihozatallal 2816-nak. De olyat már nem tudsz, hogy hoppá, nem úgy jön a DX12, ahogy kéne, akkor gyorsan csináljunk valami egyszerűbb DX11 optimized dizájnt.

Ami a Fiji shrinket illeti, akkor kérlek vess erre ismét egy pillantást: [link]

Jó, ha 10%-al elmegy a Fiji a 390X-től. Így mi értelme ebbe locsolni a pénzt? Lenne egy atomdrága nagy GPU, ami nem úgy teljesítene, mint amennyibe kerülne. Na, azt nyírná ki a legkönnyebben a GTX1070 minden szempontból. Legjobb esetben lenne 30%-al gyorsabb az ősöreg 390X-nél 14nm-en. Ez iszonyat kevés lenne.

Lenne egy atomdrága nagy GPU, ami nem úgy teljesítene, mint amennyibe kerülne. Na, azt nyírná ki a legkönnyebben a GTX1070 minden szempontból. Legjobb esetben lenne 30%-al gyorsabb az ősöreg 390X-nél 14nm-en. Ez iszonyat kevés lenne.

Ami jó lehetne 1070 verőnek, az egy 384bites, 3000 shader körüli Polaris, 64 ROP-al. Ezt reális költségen lehetne gyártani is. Fölötte meg ismét befigyelnének a skálázódási gondok. Szóval nem biztos, hogy baj, hogy ezt kihagyták, ha fél éven belül jön a Vega.

Ezt reális költségen lehetne gyártani is. Fölötte meg ismét befigyelnének a skálázódási gondok. Szóval nem biztos, hogy baj, hogy ezt kihagyták, ha fél éven belül jön a Vega.(#25475) Zeratul: Nem is vettem meg őket, míg ilyen áraik voltak.

65K-ért már kis keserű szájízzel megfelelt a 7870, bár nem bántam meg, hogy cseréltem a butított Tahitire.

65K-ért már kis keserű szájízzel megfelelt a 7870, bár nem bántam meg, hogy cseréltem a butított Tahitire.

(#25476) schawo: Az AMD nem. Viszont nekem mint itt élőnek igencsak korlátozza a mozgásterem VGA cserélgetés terén. Ez van.

-

Zeratul

addikt

válasz

Ren Hoek

#25437

üzenetére

Ren Hoek

#25437

üzenetére

Tudom meg vagy sértődve hogy nem kaptál 470 árában 1080Ti teljesítményt, de el kell keserítselek nem is fogsz soha.

Nézzük a tényeket.

Fijit nem lehetett kihozni 8GB memóriával mert a HBM technológia akkor ennyi tudott.

GCN4 vs GCN 3. A GCN 4 újításai erősen érződnek a szarul és főleg nV barát játékokon.

A GCN5 pedig egy teljesen új memória alrendszere lehetővé teszi az eddig csak a CPUkra jellemző hatékony memória kezelést, illetve hogy APU-nak nem kelljen 1 chipből állnia hanem elég legyen az on die azaz egy processzor lapkán történő elhelyezést illetve az eddig szűkös memória keretet is eliminálja. -

HSM

félisten

válasz

Ren Hoek

#25450

üzenetére

Ren Hoek

#25450

üzenetére

Szép és jó az a történeted a cégedről, de azt is számold bele, hogy egy GPU tervezés elkezdése és a késztermék között kb. 4 év eltelik.

Márpedig ez óriási idő az informatikában.

Márpedig ez óriási idő az informatikában.Azért írtam a legutóbbi hosszú posztomban, hogy vakon kellett mindkét gyártónak tippelnie, és a zöldek tippelték meg jobban a piac alakulását. Ugyanúgy megégethették volna magukat ők is a taktikájukkal csúnyán.

-

HSM

félisten

válasz

Ren Hoek

#25443

üzenetére

Ren Hoek

#25443

üzenetére

Pont ez a lényeg. Bár nem sokkal több, de a Pascal sem csak egy Die-shrink.

A 480 pedig igencsak korrekt cumó, tudásban messze az összes többi piacon lévő cucc felett áll. Sanszosan viszont a régóta csak pofozgatott frontend nem bírt volna el egy lényegesen erősebb verziót.

"A következő fél évben még az is Pascalt fog venni, aki gyűlöli az NV-t, mint a sz.rt."

Senki nem szorít pisztolyt a homlokuknak, hogy váltsanak. Én piszok jól elvagyok a 290X "őskártyámmal". Kiegyensúlyozott, bika erős cucc, és minden lényeges technológiát tökéletesen támogat.Én semmi mantrát nem mondtam, se azt, hogy direkt "kivár". Egyszerűen csak azt mondtam, hogy nem dob piacra mégegy Fury-t, ami skálázódási gondokkkal küszködne. Szó se róla, jó kártya volt az, csak nem nyújtott annyit, mint amire a 4096 shader és piszokgyors memória alapján az ember számított volna.

A legfontosabb két területre hoztak most GPU-t. A P11-et belépő játékos gépekbe, illetve notebookokba, a P10-et pedig asztali ár/érték sweet spotnak. Egyikre se lehet panasz, szvsz.

(#25454) Pepeeeee: No, és ha már megemlítetted a shader modellt, azért azt is látni érdemes, hogy egyetlen shader model 6-ra felkészített kártyacsalád van legjobb tudomásom szerint, ami ma kapható a piacon, és az pedig a Polarisok.

-

keIdor

titán

válasz

Ren Hoek

#25437

üzenetére

Ren Hoek

#25437

üzenetére

A legjobb lenne két projekt, párhuzamos fejlesztéssel, erre viszont gondolom nincs pénz. Egy ilyen 14nm Fiji is sok mérnököt és pénzt elvinne. Nincsenek akkora tartalékai, mint egy nVidiának vagy Intelnek, ezt a részét meg tudom érteni. Meg ott van a Ryzen, fél évtizednyi lemaradást kellett behozni.

Félre ne értsd, nem védeni akarom őket, de nem nagy cég az AMD, és anyagilag sem állnak jól.

Persze hogy miért jutottak ide, az is megérne egy beszélgetést... -

Malibutomi

nagyúr

válasz

Ren Hoek

#25437

üzenetére

Ren Hoek

#25437

üzenetére

Na azzal aztan vegleg elkaszaltak volna magukat, hogy az NV hozza a Pascalt 16nm-en, a szerencsetlen AMD-nek meg megint csak atnevezes sikerult.

A Fiji soha nem volt remekelo GPU, az elodje a Hawaii sokkal kiegyensulyozottabb.(#25440) core i7

Volta majd 2018-ban valamikor. -

HSM

félisten

válasz

Ren Hoek

#25264

üzenetére

Ren Hoek

#25264

üzenetére

Ez nem az a pálya...

Ide feleannyi proci sem kell.... Itt nekem olyan 50FPS-em volt így beállítva kinn az esőben, 50% körüli processzorhasználattal, GPU-limit nélkül azzal az említett konfiggal, beállítással.

Jól megjegyeztem azt a pályát, mert valamiért sokkal jobban megharapta a VGA-t, mint a játék többi része. Az akkori driverrel nem annyira szerette a 290-em, emiatt jópárat teszteltem ott is. -

#00137984

törölt tag

válasz

Ren Hoek

#25256

üzenetére

Ren Hoek

#25256

üzenetére

Neked szintén i5 van a gépben és szerinted is jobb egy GTX 1070 videókártyával játszani. Vagyis a teljesitményed javult egy ilyen váltás után. Nekem meg alig-alig érezhető javulás történt. Kifogást emeltem ez ellen és még csak meg sem próbáltam nagyon szóba hozni a GTX 1070-et, de máris a magas elvárások miatt lettem megróvásba minősitve. Tényleg jobban szeretek 60 FPS teljesitménnyel játszani, de ezért visszaveszek a grafikai beállitásokból. Ja, de mennyire is gondoltak ott AMD oldalon. Nekem ez néhol már túl soknak tünik, és egy R9 380 után többet reméltem emelni ezen. Most már kiváncsiságból csak megnéznék egy GTX 1070 teljesitményszintet elérő AMD VEGA videókártyát ebben az i5 konfigomban. Mármint mit mutatna grafikában és teljesitményben.

-

Yutani

nagyúr

válasz

Ren Hoek

#25237

üzenetére

Ren Hoek

#25237

üzenetére

150-200K között kb ez az amit még átlag emberek is kitudnak perkálni.

Szerinted a magyar átlagember ezt ki tudja perkálni? Nem tudom, hol élsz, de eléggé el vagy tévedve. Egyetlen embert sem ismerek, aki ennyit kifizetne egy VGA kártyáért. Bár lehet, hogy én nem ismerek átlagembereket.

-

Abu85

HÁZIGAZDA

válasz

Ren Hoek

#25213

üzenetére

Ren Hoek

#25213

üzenetére

A Deus Ex: MD-benben +10-15%-ot jelent. A méréseket pedig láthatod: [link] - egyébként, ha levonod a 10-15%-ot, akkor nagyjából a normál DX12-es helyükre kerülnek a Radeonok.

A BF1-ben kevésbé van használva az AGS4, így ott inkább 6-7% körül nyernek. A többi játékban (Doom, Hitman) is finomabb a felhasználási forma.

-

Abu85

HÁZIGAZDA

válasz

Ren Hoek

#25201

üzenetére

Ren Hoek

#25201

üzenetére

Most is kihasználják a fejlesztők az AGS4-et, sőt van már AGS5 is. Tehát a Volta érkezése itt lényegtelen. A funkció elérhetősége a lényeges. A szabvány csupán annyit segít, hogy ha arra van leportolva a funkció, akkor amint megérkezik a Volta az is tudja futtatni a gyorsabb kódutat. Nyilván ez egy lényeges szempont a fejlesztő oldalán. Az AGS itt csak egy menekülőút addig, amíg nincs szabványos megoldás.

(#25207) Szaby59: Mert konzolba pötyögni tilos. Játszani lehet, ott van a gép mellett egy ember, aki figyel, hogy ne csinálj olyat, amit nem szabad.

-

-

Habugi

addikt

válasz

Ren Hoek

#25118

üzenetére

Ren Hoek

#25118

üzenetére

Pedig ez a hamvaiból sem mászik ki..

Játékos bázis valószínűsíthető potenciális TXP tulajok száma nagy-nagy jóindulattal ~5%, valamelyest párhuzamra hozható az erre való igényszinttel is, ami nagyjából egyenlő lesz a 4K kijelző tulajok számával is.

Mean 0%

Median -0%

Ámbár amit cyberkind írt az már egy jóval erősebb érv lehet.

-

HSM

félisten

válasz

Ren Hoek

#25117

üzenetére

Ren Hoek

#25117

üzenetére

Hatalmas szerencse, hogy durván 24"-ig bőven elég a FHD, 32"-ig pedig az 1440P. ("Szerencsére" elég tökéletlen látószervünk van.) Márpedig azért 32" már elég tisztességes mammut egy íróasztalon. Persze, értem én a luxus igényeket, hogy valaki az ágyban fekve akarja tolni az 50"-os fél autó árán vett óriás vackon fél méterről is tűéles képpel, de szvsz ezt erős túlzás "középkategóriának" beállítani.

-

Ren Hoek

veterán

válasz

Ren Hoek

#25117

üzenetére

Ren Hoek

#25117

üzenetére

Csak hogy ne a számat tépjem, kivettem pár random kártyát:

Titan P Perf summary:100% Titan P

76% 1080

63% 1070

47% 390X

18% R7 370 / 950Mean: 60%

(de totál értelmetlen, úgyhogy offoljuk ... meg az összes kártya kéne stb...) ... max azt szemlélteti, mennyire elhúzott a csúcskategória...

... meg az összes kártya kéne stb...) ... max azt szemlélteti, mennyire elhúzott a csúcskategória... -

#00137984

törölt tag

válasz

Ren Hoek

#25081

üzenetére

Ren Hoek

#25081

üzenetére

GTX 1070-et nem veszek, ezt most már kivárom a VEGA videókártyák megjelenéséig. Középkategória ott is lesz és majd egy tipussal még nagyobbat veszek és akkor nem lesz csalódás. Várjunk csak, mintha eddig is ezt tettem volna...

Szóval most muszályból kénytelen leszek egy jóféle 8GB-os videókártyát venni, igy átlépve a bűvős 100ezres határt.

Szóval most muszályból kénytelen leszek egy jóféle 8GB-os videókártyát venni, igy átlépve a bűvős 100ezres határt. -

->Raizen<-

veterán

válasz

Ren Hoek

#25081

üzenetére

Ren Hoek

#25081

üzenetére

Tökkéletesen elvagyok egy gtx 970-el FHD-ban. És még élsimítás is belefér igen sok kimaxolt játék mellé. Egyedül a forza horizon 3-nak kell high preset, mert a max egy gtx 1080-at is majdnem megfektet persze nem látványosabb semmivel! Így is rohadt jó érzés belehuppanni a lamborghinimbe ausztráliába, valami hasonló vadat álmodtam, akkor is egy aventadort vezettem.

-

#00137984

törölt tag

válasz

Ren Hoek

#25057

üzenetére

Ren Hoek

#25057

üzenetére

2010-ben nem voltak még ilyen korcs játékok vagy a videókártyákat méretezték okosan a játékokhoz.

Mindegy is, mert akkor még egy húzásra végigjátszottam őket és közben nem találkoztam ilyen lassulásokkal meg grafikai bugokkal, ami mostanság egy-két alkalommal engem is megtalált. Akkor az 1GB VRAM elég volt egy játékhoz és az 1024 Shader után pöpecnek érezted a gépet. Egymás után pörögtek át a játékok a gépen. Most meg...

Mindegy is, mert akkor még egy húzásra végigjátszottam őket és közben nem találkoztam ilyen lassulásokkal meg grafikai bugokkal, ami mostanság egy-két alkalommal engem is megtalált. Akkor az 1GB VRAM elég volt egy játékhoz és az 1024 Shader után pöpecnek érezted a gépet. Egymás után pörögtek át a játékok a gépen. Most meg...  Évente új videókártya és ezen ciklusok felénél már elfogyott a craft a videókártyából, de a következő széria még igen messze van és felsőkategóriás videókártyákra meg ilyen rövid időszakokra sajnálom a lét. Meg szerintem nem is jár ezeknek több anyagi támogatás, mert azért teszik ezt meg a játékosokkal mert nem lázadoznak ez ellen. Én megtehetem, hogy évente 85-90ezres videókártyát használjak a gépben, de a néhány éves játékokban is közepesnél valamivel erősebbek, akkor a friss megjelenések esetében mire számithatok... Gyenguszka grafikai beállitás egy 4GB-os videókártyán és némelyik videókártyára meg a 8GB amúgy is felesleges volna, nem táltosodik meg attól a néhány + FPS-től. VEGA videókártyára majd 8GB videómemóriát választok én is, oda már talán kihasználja majd a GPU. Mindezek ellenére én megint elmondtam a véleményem és ezek után megint engem kritizálnak itt a szókimondásom miatt. Nektek tényleg 125ezres 8GB-os középkategória kell és 16GB-os felső és aki nem költ 85ezret évente egy videókártyára az ne is tudjon majd játszani csak alacsony felbontásban...

Évente új videókártya és ezen ciklusok felénél már elfogyott a craft a videókártyából, de a következő széria még igen messze van és felsőkategóriás videókártyákra meg ilyen rövid időszakokra sajnálom a lét. Meg szerintem nem is jár ezeknek több anyagi támogatás, mert azért teszik ezt meg a játékosokkal mert nem lázadoznak ez ellen. Én megtehetem, hogy évente 85-90ezres videókártyát használjak a gépben, de a néhány éves játékokban is közepesnél valamivel erősebbek, akkor a friss megjelenések esetében mire számithatok... Gyenguszka grafikai beállitás egy 4GB-os videókártyán és némelyik videókártyára meg a 8GB amúgy is felesleges volna, nem táltosodik meg attól a néhány + FPS-től. VEGA videókártyára majd 8GB videómemóriát választok én is, oda már talán kihasználja majd a GPU. Mindezek ellenére én megint elmondtam a véleményem és ezek után megint engem kritizálnak itt a szókimondásom miatt. Nektek tényleg 125ezres 8GB-os középkategória kell és 16GB-os felső és aki nem költ 85ezret évente egy videókártyára az ne is tudjon majd játszani csak alacsony felbontásban...  Hát szépen vagyunk, mert hogy lesz itt 4K játék meg akár 1440P, ha még FullHD-n sincs minden rendben és nem biztositott a nyugodt játékom. Köszönöm itt egyeseknek, hogy zavarhattam.

Hát szépen vagyunk, mert hogy lesz itt 4K játék meg akár 1440P, ha még FullHD-n sincs minden rendben és nem biztositott a nyugodt játékom. Köszönöm itt egyeseknek, hogy zavarhattam.

-

HSM

félisten

válasz

Ren Hoek

#25057

üzenetére

Ren Hoek

#25057

üzenetére

Én boldog vagyok a 290X-emmel is FHD-n. Pedig fele anniba sem került, mint egy GTX1070....

"6 évre rá szinte mértani pontossággal ugyan ezt kapod"

És még csak nem is igaz. 6 éve 50K-ért még PWM-es szabályzású, lassúcska panelos IPS járt ennyiért, hagyományos háttérvilágítással. (U2311) Ehhez képest már a 3 évvel ezelőtt vett ilyen kategóriás monitorom is már flicker-free, LED háttérvilágításos, és masszívan láthatóan gyorsabb a panel az elődjénél (most P2414H-m van, előtte U2312hm volt). Manapság meg már Freeesync is kezd felbukkanni bennük, és a 60hz+ is... Bár a specifikációk kb. egyeznek, mégis jól érzékelhetően kellemesebb az újabb. -

#85552128

törölt tag

válasz

Ren Hoek

#24837

üzenetére

Ren Hoek

#24837

üzenetére

A polaris megjelenésének negyedévében pont, hogy részesedést vesztettek. Amit nyertek az mind a régebbi kártyákkal történt még Q1-Q2-ben.

(#24838) gyiku: Meg azt se, hogy a nagy VR hype után az ASW supportot a Polarison kívül semmi nem kapta még meg, a maxwell2, pascal pedig tudja októbertől...

-

Petykemano

veterán

válasz

Ren Hoek

#24826

üzenetére

Ren Hoek

#24826

üzenetére

Ne felejtsd el, hogy a pascal sokkal kevésbé sávszélesség érzékeny, mint a gcn. Az nvidia ilyen szempontból jó döntést hozotttl, hogy rop igényes architektúrát épített, aminek számát, hatékonyságát és fogyasztását Kézben tudja tartani. Ellenben a memóriával: a fury is s hbm miatt csúszott, és vélhetően most is a hbmre kell várni. A gddr5 fogyasztása egekben, a gddr5x meg lehet, hogy készlethiányos és drága volt.

De a lényeg, hogy úgy tűnik, az nvidia könnyebben főzött Zrt a rendelkezésre álló memóriakínálatból.Nem tudom, hogy vajon a polaris mennyivel lett volna drágább, ha hagyományos hbm memóriával látják el, mint a furyt. De valószínűleg a frekvencia se jött össze, de ha összejött volna, akkor ugyanúgy kevés lett volna, mint most a furyn. Ettől eltekintve a polaris 10 gyönyörű lett volna normális frekvencián normális fogyasztással hbm-mel. Volt egy ilyen pletyka, hogy úgy is képzelték, csak az élet közbeszólt.

Nem tudom, mennyi idő lehet egy kész architektúrát mutálni. De legkésőbb akkor elkezdték készíteni a polaris12-t és a p10Xt2-t, Amikor nyilvánvalóvá vált, hogy csúszik a hbm2.

Bár abu azt mondta, az AMD nem fog gddr5x-es kártyát készíteni, azért bízzunk benne, hogy ha ezek érkeznek, gddr5x-szel érkeznek. Egy p10-nél másfélszer nagyobb 384bit gddr5x-És kártya szépen mutatna. Úgy vélem 320mm^2-be beleférne.

Ugyanakkor kérdés, hogy mit tudna ez felmutatni? Csak egy 1070-et befogó kártya nem elég. Annál többet kell nyújtani és olcsóban, különben nem fogja megvenni a közönség. Szerintem ezért nehéz ügy. -

-

Raggie

őstag

válasz

Ren Hoek

#24756

üzenetére

Ren Hoek

#24756

üzenetére

Még mindig a PC-s teljesítményekből indulunk ki. Ez hiba.

Amikor a konzolok potenciáljának lehetőségeiről beszélünk, akkor a Kojima és a csúcs Sony stúdiók játékait kellene alapul venni. Ezek szoktak jellemzően olyan álleejtős grafikát/játékélményt/innovációkat hozni a játékokba, amikről mindenki csak a következő utáni generációban számított volna. Miért?

Mert ezek a fejlesztők veszik a fáradságot, hogy a végletekig optimalizálják a kódjaikat a célhardverre, sőt nem is optimalizálják, hanem eleve arra írják!

Ez a nagy előnye a konzolnak, és ez az amit kihasználva a VR és a 4K létrejöhet jóvel előbb, mint a PC-n.Sajnos ezt most a konzolos játékoknál sem látom mostanság(itt is csak adják kifelé a félkész játékokat hama-hama). De ez volna az út ami az élvezhető 4K és VR élményhez vezet szerintem.

Persze elérkezik ez a PC-re is valamikor de szerintem csakis a konzolok után. Akkora előny, hogy van egy két-három-négy féle fix konfigurációval rendelkező hatalmas bázis, hogy sokkal inkább fognak erre tízszer jobban optimalizálni, mint a PCs GTX Titan-ra. -

Solymi81

aktív tag

válasz

Ren Hoek

#24756

üzenetére

Ren Hoek

#24756

üzenetére

Miért ne? A többi termékből is van többféle. Szerintem ha látnak benne lehetőséget, technikailag megoldható, akkor simán lehet több kategória a konzoloknál is.

Megfelelő tartalommal és szolgáltatásokkal el fogják tudni adni.

Az irány az látszik, azt szeretnék, hogy a konzol legyen az otthoni szórakoztatás központi eleme, azt használd ha játszani akarsz, zenét hallgatni, streamelni, tv-t nézni, stb.A 4K-t már nyomják egy ideje, a VR-t is elkezdték, szóval innentől csak idő kérdése.

Külföldi Samsung reklámok nagyon nyomjá a Galaxy telefonokat VR-rel karácsonyi ajándéknak.

Ugyanaz lesz mint a 3D-vel, boldog-boldogtalan venni fogja. -

Solymi81

aktív tag

válasz

Ren Hoek

#24750

üzenetére

Ren Hoek

#24750

üzenetére

Csak óvatosan ezekkel a kívánságokkal, még a végén beválik aztán majd azért megy majd a sírás, hogy az AMD monopolhelyzetben van.

Itt van két érdekesebb rövid cikk, egyik 2013-ból, másik 2016-ból, amikben az Nvidia és AMD konzolokban való szerepléséről van szó.

Biztos van részletesebb is, de ezek is jók.Azt nem szabad elfelejteni, hogy ezek a gyártók nem csak a jelennek gyártanak, hanem próbálják kitalálni, felvázolni mi lesz a következő ill. azutáni lépcsőfok is. Amint látható az AMD egyrészt kényszerűségből, másrészt saját döntésük okán egy másik utat választottak mint az Nvidia.

Ez annak idején nem igen jött be, de ez nem jelenti azt, hogy később nem jönnek ki jól belőle és nem az Nvidia kerül rosszabb helyzetbe.Nem hiába él még a cég, ha nem lenne megfelelő és bíztató elképzelésük, tervük, koncepciójuk a jövőre nézve, már rég lehúzhatták volna a rolót. A befektetők se buták, tisztában vannak vele, hogy a nyreséghez dolgokhoz kellhet egy 5-10 éves fejlődési ciklus. Emellet pedig rengeteg dolognak is passzolnia kell a piacon.

A 4K tévék és VR szemüvegek megjelenése jó alkalom lehet a konzolgyártóknak, hogy a megfelelő tartalmakkal és a szolgáltatások integrálásával központi szerepet kapjanak az otthoni szórakoztatásban (játék, filmnézés, streamelés, zenehallgatás, stb. ami már jelenleg is megvan, de mégjobban lehetne integrálni).

-

Petykemano

veterán

válasz

Ren Hoek

#24750

üzenetére

Ren Hoek

#24750

üzenetére

20-30%-os részesedés mellett köhögő Kepler és Maxwell kártyával rendelkezők közül van honnan vásárlónak jönnie, aki Doomozni akar. Underdogként nem feltétlenül saját vásárlóit kell az új kártya megvásárlásáról meggyőzni.

De valószínűleg egy kimagaslóan jó Vega teljesítménye sem lenne erre elegendő. Merthogy ugye a vásárlások többsége nem azon múlik, hogy épp melyik gyártó terméke hogy szerepel a benchmarkokban.

-

válasz

Ren Hoek

#24731

üzenetére

Ren Hoek

#24731

üzenetére

Szerintem nem ennyire vészes a helyzet. Az előző két széria sajnos a hatalmas fogyasztás miatt sok embert elrettentett. Az RX széria ezen óriásit javított, kell még egy felsőkategória, ami remélhetőleg a következő negyedévben befut. Sokan várnak jelenleg is a vásárlással, igaz? Vagy megvetted már a 1070-et?

Aztán kell még egy kártya a 460 és a 470 közé, mert ott nagy az űr, amit a 1050ti ki is használ.Késett az AMD ez tény, de én úgy látom, hogy most eltalálták és a jövő év első fele még sokat hozhat a konyhára nekik, ha nem egy Fury szerű dolgok hoznak megint.

-

#85552128

törölt tag

-

Petykemano

veterán

válasz

Ren Hoek

#24364

üzenetére

Ren Hoek

#24364

üzenetére

Szerintem Ma már a dx12-t kell nézni. Mármint egy új csúcskártya esetén. Jó persze aki pont ma vesz, men nézheti a dx11-et is. De régi dx11 játékokat új dx11-ben esetleg gyengébb kártya is pengén el fog vinni.

Szerintem olyan nagyot nem kell varázsolni.

Ámít számolgattam vs fury x:

+12% architektúra

+20% órajel (1050->1266)

+6% többlet memóriasávszélességből nyerhető teljesítmény

summa +42%Ez a polaris technológiai szintje fiji paraméterekkel szűk nadrágban (64rop, 2csatornás memvezérlő)

Ez lett volna kihozható 250w-bólLehet, hogy tényleg kár lett volna beleölni a pénzt

Napvilágra kerültek azonban olyan pletykák. Amelyek a cba 10-nek 12tflops számítási kapacitást jósoltak. Ha ezt változatlan shader mennyiséggel éri el (a fijihez képest), akkor ahhoz 1500MHz körüli órajelre van szükség, ami mintegy 20%-kal magasabb, mint a poláris szintje.

Ezen kívül konkrétan a p10-re mondják, hogy bandwidtg starving. Abu meg azt állítja, hogy a gcn szűk keresztmetszete a memóriasávszélesség. Felteszem lehet ennek alapja, ha azt nézzük, hogy ki az új memória techonlógiák szekértolója.

Ha nem spórolnak a hábéemekkel, akkor még abból is csurranhat-cseppenhet.Az is köztudott, hogy milyen mértékben volt kiegyensúlyozatlan architektúra a fiji: összességében alig teljesített jobban, mint a 390X. Remélhetőleg az ilyen jellegű problémákat az utasítás-előbetöltés nevű okosságok orvosolhatják.

És szintén remélhetőleg a poláris energiahatékonyságán is sikerül javítani az eltelt 1 évben.

Szóval amit számolgattam 40% a fijihez képest, az szerintem az alja, a minimum.

De van mégegy mankó arra nézve, hogy mit fog tudni az érkező Vega : ez pedig kiolvasható a hamarosan érkező 1080Ti paramétereiből.

Hogy ez mennyibe fog kerülni? Jóég tudja. Versenyképes Áron lesz. Ami azt jelenti, hogy nem lehet majd féláron megkapni.

Viszont azt gondolom, hogy az 1070 konkurenciája a Vega 11 lesz. 7tlops, ami kicsit kevesebb, mint a már most is közel 1070 szinten levő Fury x.

Ami legalább ennyire érdekes, hogy mivel készül az nvidia?

-

válasz

Ren Hoek

#24305

üzenetére

Ren Hoek

#24305

üzenetére

Légyszi linkelj valamit, ami szerint brutális grafika meg általános mindenhol hatalmas gyorsulás lesz az új API-któl. Ez csak primitív hozzállás szülte félreértések miatt van, ezért megy ez értelmetlen károgás meg hiszt hogy süllyed a színvonal.

Az AotS-nál csak a felületet kapargatod, annak a techdemo-jellegű játéknak pont az a lényege, hogy rengeteg egységgel képes futni millió effekttel, anélkül, hogy az API komolyan korlátozná. Maga a játék engem sem érdekel, s szerintem se szép, de nem károgok ezért, mert tudom, hogy nem erre gyúrták ki.

-

schwartz

addikt

válasz

Ren Hoek

#24305

üzenetére

Ren Hoek

#24305

üzenetére

és csak berakja az NV kártyát és játszik. (Vagy AMDt ha lenne)

Vegyel mar egy ezernyocvanat azt csok. Ha lenne AMD, akkor is ezernyocvanat szeretnel, csak olcsobban. Arverseny felsohazban meg nem lesz. Azota sirsz, hogy eladtad a 970-ed, meg a Polaris debutalasa elott. (benezted, ezen tovabb kell lepni)

-

válasz

Ren Hoek

#24284

üzenetére

Ren Hoek

#24284

üzenetére

Ehhez a demóhoz szoftver sem ártana. Lehet nem véletlenül nincs, mivel komoly kutatások kellenenének ahhoz, hogy egy ilyen komplex alkalmazást összedobjanak, már ha egyáltalán most van ár erő.

Ezt az egész minden explicit apis forradalmat olyan szinten félreértetitek, hogy hihetetlen. Nem lesz holnap tánc meg zárcsökkentés, és nem kell rohanni a boltba az áemdé kártyákért. Ez az egész legfőképp a fejlesztés megkönnyítéséről szól, ami a felhasználóknak közvetetten előnyös.

A Cudára az AMD már válaszolt, elkészítette a saját fordítóját, amivel könnyen lehetséges a CUDA programokat futtathatóvá tenni a Radeonokon. Ez elég nagy pofon az NV-nek.

-

proci985

MODERÁTOR

válasz

Ren Hoek

#24302

üzenetére

Ren Hoek

#24302

üzenetére

IGP megmentette a diplomát

Elso diplomamunka felenel kiszedtem a masodik videokartyat... aztan miutan leadtam aludtam egy napot, visszaraktam a helyere a masodikat es ugy mar az akkori csucsnal kb 10-20%al jobb teljesitmeny eleg volt arra, hogy a Crysis3 szepen menjen 5760x1080 mediumon, levezeteskepp.

-

-

#16729600

törölt tag

válasz

Ren Hoek

#24284

üzenetére

Ren Hoek

#24284

üzenetére

Nekem ez nagyon tetszett, néhány helyen " ...sokszor beszoptam már, sokáig védtem, hittem benne, olvastam párthű kiskatonaként szorgosan a fórumot, tech cikkeket stb... a sokszoros csalódás beleég az emberbe. Újra egységsugarú "hülye" leszek, aki beteszi a gépbe a motyót és játszik." már már Arthur Miller : Az ügynök halála mélységű, jót nevettem rajta, ( jó értelemben ) .

Teljesen igazad van, csak jót tesz, hogy felébredtél végre a szugerációs transzállapotból.

Teljesen igazad van, csak jót tesz, hogy felébredtél végre a szugerációs transzállapotból.

-

válasz

Ren Hoek

#24213

üzenetére

Ren Hoek

#24213

üzenetére

A júzerek nem a fogyasztás miatt vették a Maxwell-t, hanem azért, mert az NV volt jobb. Az egységsugarú vásárlónak nem sok fogalma van arról, hogy mit vesz, max a dobozon lévő dolgokat látja meg a marketinget, jobb esetben benchmarkokban lévő fps-eket. PH!-n is a tesztek utolsó oldalának van messze a legtöbb oldalletöltése.

Az a baj, hogy a legtöbben túl naivan vagy türelmetlenül állnak ehhez hozzá. Nem azonnal varázsütésre lesz ebből egy halom teljesítmény. Ezért hülyeség csak ezt figyelembe véve AMD-t választani. Másrészt amíg NV-re is optimalizálnak, addig nem is lesz nagy különbség. Harmadrészt pedig még a nagy oldalak se tudnak normálisan mérni, ugye az új apik alatt nem használhatók a régi benchmark toolok, így az eredmény pontatlan lesz. De a tendencia látható, általában NV-n lassul az új API, míg AMD-n gyorsul. Jelenleg még lehet választani a régi API-t, viszont amint a Windows 10 elterjed, nem fognak többé DX11-re fejleszteni.

Nekem a Frostbite 3 2013-ban áll leejtős volt (a BF4 pár órás "játékélménye" más kevésbé

![;]](//cdn.rios.hu/dl/s/v1.gif) ), pedig az csak DX11. Azóta meg nem igazán van hova fejlődni. Vagyis lenne, csak ott az uncanny valley, s emiatt sokkal nehezebb a feladat, mint régen, amikor még közelébe sem voltunk ennek a rejtélyes völgynek. Pl ott a DoF, ami egy tökjó effekt, de csomóan kikapcsolják, mert zavaró, túl reális. Így próbáljanak reális grafikát csinálni. Semmisejó, a játékosnak fogalma nincs, hogy pontosan mit akar, csak legyen jobb. Legyen tánc. Meg zárcsökkentés.

), pedig az csak DX11. Azóta meg nem igazán van hova fejlődni. Vagyis lenne, csak ott az uncanny valley, s emiatt sokkal nehezebb a feladat, mint régen, amikor még közelébe sem voltunk ennek a rejtélyes völgynek. Pl ott a DoF, ami egy tökjó effekt, de csomóan kikapcsolják, mert zavaró, túl reális. Így próbáljanak reális grafikát csinálni. Semmisejó, a játékosnak fogalma nincs, hogy pontosan mit akar, csak legyen jobb. Legyen tánc. Meg zárcsökkentés. -

válasz

Ren Hoek

#24209

üzenetére

Ren Hoek

#24209

üzenetére

Miért lenne volna tévút? Az kimaradt, hogy az első két GCN generáció elég nagy pofon volt a Ferminek meg a Keplernek, a két új konzol erre épít, új apikat hozott?

Ekkora probléma lenne, hogy a Maxwell óta +30% fogyasztás? Bezzeg a Fermi idején ez senkit sem érdekelt. A GCN ugyanazt tudja, ugyanazon az áron, más különbség nincs a tudást leszámítva, ami az új apik alatt ad egy kis boostot. Annyi probléma van, hogy jelenleg épp nincs kártyájuk a felsőkategóriában, mert megcsúszott a Vega. De ebből arra következtetni, hogy a GCN hülye ötlet volt, az egy baromság.

És mire írod az API-t, ha nincs hardver? Mantle-t is úgy kellett letuszkolni az MS torkán, hogy kiadja a DX12-t. Aztán most meg a GPUOpen / AGS megy ugyanígy a SM 6.0-ért. Hogy lehetne másképp, konkrétan?

-

HSM

félisten

válasz

Ren Hoek

#24200

üzenetére

Ren Hoek

#24200

üzenetére

Legjobb tudomásom szerint már a GCN-el egy időben kopogtattak egy explicit API prototípussal a m$-nál....

Persze, hogy lassan indult el a vonat, de ugyanez lett volna a tempó, ha 2012-ben hozzák ki, csak akkor mára már nyakig ülnénk az azt kihasználó játékokban.

(#24201) TTomax: Pontosan ez történt, így utólag látjuk. De miért nem lett a korábbi gyakorlatnak megfelelően, időben bevezetve a villany? Erről meséltem az elmúlt posztokban....

(#24202) cyberkind: Villany nélkül a polírozott gyertya persze, hogy jobb.

(#24203) TTomax: A korábbi menetrendek mellett nem sokkal a GCN bemutatkozása után jönnie kellett volna hozzá megfelelő API-nak... Itt azért akadnak furcsaságok. Nyilván nem azért öltek bele időt, energiát a korábbi egyszerű architektúrájukból hogy egy bonyolultabbat csináljanak, hogy utána elvesszék a versenyt a megnövő fogyasztás miatt, kihasználatlanul hagyva, amit beépítettek....

(#24204) Loha: A DX9 kb. 4 évig futott, és 3 verziót élt meg ezalatt.

A DX10 pedig 3 évet, és közben 1 frissítést kapott. Ehhez képest a DX11 2009 óta van, 6 év telt el, komolyabb belső változások nélkül....

A DX10 pedig 3 évet, és közben 1 frissítést kapott. Ehhez képest a DX11 2009 óta van, 6 év telt el, komolyabb belső változások nélkül....

Teljesen időszerű lett volna 2012-13 körnéykén kihozni az utódját.... -

HSM

félisten

válasz

Ren Hoek

#24183

üzenetére

Ren Hoek

#24183

üzenetére

Igen, cak ez nagyon nem ennyire egyszerű. Itt több év egy termék fejlesztési ciklusa, és nehezen jósolható a jövő alakulása. Az AMD szépen fejlesztett, szvsz jogosan feltételezve, hogy a technika nem hátrafelé indul el... Aztán elindult mégis hátrafele. Itt szvsz nem mérnöki/sales vonalon kell keresni az okokat, hanem ott, hogy vajon miért késett ennyit egy modernebb API. No, meg meggondolni, ezzel ki járt jól, és ki rosszul.

"Eddig a felhasználókat semmiféle kár nem érte emiatt"

Egészen biztos vagy te ebben? Szerintem önmagában a zöld/kék monopólium, amihez erősen hozzásegített a beragadt DX11 már jelentős károkat okozott a felhasználóknak. Persze, ezt most annyira nem érezzük, mert szépen lassan lett adagolva minden, megszoktuk... De gondold csak végig.... -

válasz

Ren Hoek

#24183

üzenetére

Ren Hoek

#24183

üzenetére

Ugyanezt írtam a 24174 hsz-ban, csak egyszerűbben.

A feltételezhető jövő eljövetelehez kellett 3-4 év, és addigra önmaguktól találtak/kidolgoztak jobb megoldásokat.Ellenben a feleslegesen bonyolult ès kihasználatlan erőforrásaikból származó többletfogyasztás és melegedés miatt évekig kapták az ívet a felhasználók egy részétől.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- ThinkPad (NEM IdeaPad)

- Amit látnod kell 80’ – 90’ évek, egész estét betöltő mozi filmjei.

- TCL LCD és LED TV-k

- Azonnali játékos kérdések órája

- Milyen okostelefont vegyek?

- Stratégiai biztonsággal védekeznek a dráguló memóriák ellen a gyártók

- Mibe tegyem a megtakarításaimat?

- Projektor topic

- Milyen RAM-ot vegyek?

- Router gondok

- További aktív témák...

- Xiaomi 14T Pro 5G 512GB, Kártyafüggetlen, 1 Év Garanciával

- Hutt C6 ablaktisztító robot / 12 hó jótállás

- HIBÁTLAN iPhone 13 mini 128GB Starlight -1 ÉV GARANCIA - Kártyafüggetlen, MS3828, 100% Akksi

- HP ProBook 650 G8 Intel i5-1145G7 15GB 512GB magyarbill 1 év garancia

- Dell XPS 13 9370 - 9380 UHD touch, 16GB RAM, 256-512GB SSD, jó akku, szép állapot, számla, garancia

Állásajánlatok

Cég: ATW Internet Kft.

Város: Budapest

Cég: BroadBit Hungary Kft.

Város: Budakeszi

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Az R9 390X tulajoknál talán valamivel jobban fog menni ez a játék, mert ott egy erősebb GPU mellé 64 ROP és 512bit memóriabusz van jókora sávszéllességgel (384 GB/s). Ja persze ezért van az a jó magas fogyasztása... Most még tart a Zárt Bétatesztelés, de egy GTX 1070 szintén alaposan meg tud izzadni a játékban. Egy kis optimalizálás még szükséges lehet, meg egy Day One Patch. Aztán majd érkezik hamarosan a Mass Effect Andromeda. Ezeknél a játékoknál ha esetleg CPU limitem alakulna ki helyenként az i5 4690K procival, akkor egy erős videókártyával a 75 FPS visszaesik nálam 60 FPS-re. Na bumm...

Az R9 390X tulajoknál talán valamivel jobban fog menni ez a játék, mert ott egy erősebb GPU mellé 64 ROP és 512bit memóriabusz van jókora sávszéllességgel (384 GB/s). Ja persze ezért van az a jó magas fogyasztása... Most még tart a Zárt Bétatesztelés, de egy GTX 1070 szintén alaposan meg tud izzadni a játékban. Egy kis optimalizálás még szükséges lehet, meg egy Day One Patch. Aztán majd érkezik hamarosan a Mass Effect Andromeda. Ezeknél a játékoknál ha esetleg CPU limitem alakulna ki helyenként az i5 4690K procival, akkor egy erős videókártyával a 75 FPS visszaesik nálam 60 FPS-re. Na bumm...

Kicsit se. A 7 éves húzott hatmagos HEDT procim éppen beéri egy friss Skylake i7, de azt is meg kell tuningolni, hogy lehagyja egy picit. Vicc. De már tovább mentek, mert a friss Kaby Lake már Skylake magokat használ, tehát még annyit se léptek előre, mint eddig.

Kicsit se. A 7 éves húzott hatmagos HEDT procim éppen beéri egy friss Skylake i7, de azt is meg kell tuningolni, hogy lehagyja egy picit. Vicc. De már tovább mentek, mert a friss Kaby Lake már Skylake magokat használ, tehát még annyit se léptek előre, mint eddig.

Ugyanis a GPU fejlesztés elején már a fő dolgok, mint pl. leginkább az architektúra kvázi kőbe vésődnek, és a piaci szempontból követés itt gyakorlatilag azt jelenti, hogy mindig csak újratervezik a GPU-t, ami azt jelenti, hogy sosem lenne belőle termék. Finomítani persze tudsz megjelenés előtt, mondjuk legyen benne 3072 shader (ami eredetileg a Hawaii-ba került), vagy elég lesz az magasabb órajellel és kihozatallal 2816-nak. De olyat már nem tudsz, hogy hoppá, nem úgy jön a DX12, ahogy kéne, akkor gyorsan csináljunk valami egyszerűbb DX11 optimized dizájnt.

Ugyanis a GPU fejlesztés elején már a fő dolgok, mint pl. leginkább az architektúra kvázi kőbe vésődnek, és a piaci szempontból követés itt gyakorlatilag azt jelenti, hogy mindig csak újratervezik a GPU-t, ami azt jelenti, hogy sosem lenne belőle termék. Finomítani persze tudsz megjelenés előtt, mondjuk legyen benne 3072 shader (ami eredetileg a Hawaii-ba került), vagy elég lesz az magasabb órajellel és kihozatallal 2816-nak. De olyat már nem tudsz, hogy hoppá, nem úgy jön a DX12, ahogy kéne, akkor gyorsan csináljunk valami egyszerűbb DX11 optimized dizájnt.