Hirdetés

- sziku69: Fűzzük össze a szavakat :)

- vrob: Próbálkozás 386 alaplap újraélesztésre

- weiss: Autó költségek

- GoodSpeed: Te hány éves vagy?

- Luck Dragon: Asszociációs játék. :)

- Luck Dragon: Alza kuponok – aktuális kedvezmények, tippek és tapasztalatok (külön igényre)

- Magga: PLEX: multimédia az egész lakásban

- sziku69: Szólánc.

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- Geri Bátyó: Agglegénykonyha különkiadás – Bors

Aktív témák

-

rocket

nagyúr

válasz

jodamester

#2098

üzenetére

jodamester

#2098

üzenetére

Far Cry2, STALKER Clear Sky, Spore biztos nem

-

rocket

nagyúr

Az eleg sokatmondo, hogy minden tesztoldal hasznalja a jatekot, tehat akkor vehetjuk meghatarozo benchmarknak, a masik meg ugye ahogy fentebb irtak full HD alatt szinte ez az egyetlen jatek ami nem megy max. beallitas mellett, meg szurok nelkul se elvezheto framekkel, szoval akkor igen fontos lesz a felhasznaloknak tobbsegenek amit ott latnak majd teljesitmenyben.

-

jodamester

tag

Aha...mindenesetre én jól elvagyok a kis 8800as karimmal és 22es monitorral. Ha elérhető lenne az új széria, akkor sem ruháznék be. (jelenleg csak a crysis kedvéért). Írnátok pár idén megjelenő erőforrásigényes játékcímet, mert nekem most nem ugrik be semmi.(?) Köszi!

-

rocket

nagyúr

válasz

Dare2Live

#2094

üzenetére

Dare2Live

#2094

üzenetére

Mindig van legalabb 1 jatek ami segit az uj hardver eladasokban, mikozben a tobbihez kozepkategorias kartya is eleg, az erem masik oldala pedig a Unreal3 es a Source engine amik felhasznalo baratabbak a teljesitmenyukkel.

Nem csoda sokan techdemonak nevezik a Crysist, van benne valami, hogy bizonyos erdekek hoztak letre

-

Dare2Live

félisten

válasz

janos666

#2092

üzenetére

janos666

#2092

üzenetére

Akkor ment az Oblivion mánia.... fél világ nyomta éjjelnappal.

éshát az 1950XTX ami Oblivionban agyonverte 7900GTXet tudott ennyit.

[link]

Jelenleg a Cryis ami ennyire megfingatja a jelenlegi csúcs karikat csakhát az közel se lett akkora siker....szerk: rocket: sztem steamen elég jól fel lehet mérni, hogy a gamer társadalom mit használ. 15%van 1440 és flötte, és azért 4870nek még ezekben a régiokba se kell majd szégyenkeznie. de majd meglátjuk.

btw anno 8800GTX nem 499$en nyitott? (180Kn?)

-

rocket

nagyúr

válasz

jodamester

#2090

üzenetére

jodamester

#2090

üzenetére

Enthusiast userek mar full HD-ban jatszogatnak minimum, es ott van azert Crysisen kivul is jatek amikhez elkene egy kis kakao, osszel meg jonnek majd jatekok amikhez szinten nem art majd, de ettol fuggetlenul a highend meg mindig csak igen kis szelete a piacnak, inkabb presztizs es marketing erteke van, foleg ugye az atlag felhasznaloknal, akik latjak X ceg kartyaja a legjobb, es vesznek valamit a sajat arkategoriajukban ettol a cegtol, kozben lehet a konkurencianal van jobb ami a felteteleiknek megfelelne.

Crysis korul meg mindig igen nagy hype van a felhasznalok tobbsegenel, igy fontos lesz majd, melyik kartya, hogy szerepel benne.

-

janos666

nagyúr

válasz

jodamester

#2090

üzenetére

jodamester

#2090

üzenetére

De idén is jönnek játékok. Kellett akkora kártya mint a 8800GTX mikor kijött? Ma már kell azért a nagyobb nevekhez egy hasonlóan gyors kártya 1680+, 4x AA, 16xAF? (ha nem is GTX de egy GT azért elkell ehhez) Ha lesz ilyen kártya jön majd játék is ami használja valamire.

Amit rocket hsz-ei "balancolni hivatottak" azok is éppoly, vagy méginkább légbőlkapott elméletek. Ily módon tényleg értelmetlen ez a vita amit folytatunk, nade nem csak azok szeretik ezt akik alapvetően nvpártiként ülnek itt, azok is akikkel beszélnek velük erről...

-

R.Zoli

őstag

válasz

jodamester

#2090

üzenetére

jodamester

#2090

üzenetére

És a crysis is csak azért mert enyhén szólva is gyengén lett megírva...

-

jodamester

tag

Valóban szükség lenne ilyen nagy teljesítményű vga-kra? Jelenleg a Crysis-en kívül talán nincs is olyan játék ami gyilkolja a vasat (legalább is 1680 felbontásig).

-

Syde

tag

Megértem, hogy balanszírozni próbálsz, de hozzászolásaid többsége erőltetett provokáció szakmai tartalom mögé bújtatva.

Másfelöl olybá tűnik, hogy egy néhány hozzászolásod motivációs alapja nem más, mint személyes frusztráció. Ebből adódóan a hitelességed több, mint megkérdőjelezhető.

üdv,

Syde -

rocket

nagyúr

Jatekok tobbsege AFR-t hasznal DUAL GPU kartyaknal.

Amit linkeltel tesztet abban is van hol nem gyorsabb mint az ultra, minimum framek nincsenek feltuntetve amiben a jelenlegi dual GPU megoldasoknal jelenetosen alacsonyabbak, megha az atlag nagyobb akkor is mint a single GPU kartyaknal.Ebben a tesztben, atlagban a X2 nagyabol 8800ultra szint 4xaa 16x af mellett (ezzel tesztelnek legtobb helyen. ezt hasznaljak a legtobben), szoval az AFR es a CF/SLI meg mindig zsakutca, persze ha nincs jobb, akkor nem tudnak mit tenni ezt kell lenyomni az emberek torkan, es biztos lesz akinek sikerul

Az ATi-t R700 kapcsan az mentheti meg, ha legalabb megosztott memoriat hasznalna az R700, de ennek nyoma egyelore nincs, hogy bekovetkezne, remelhetoleg van meg valami utokartya a kezukben az R700 kapcsan, kulonben G80-hoz hasonlo idok jonnek, azert az eleg nagy blama lenne ha G80/R600 esete ismetlodne meg, ami az ATI eseteben most raadasul 2 GPU-s kartya lenne, es csak a GTX260 ellen lenne valami keresnivaloja (ha lehet egyatalan egy olyan megoldast annak nevezni ami X jatekban 100+80% teljesitmeny nyujt, Y-ban meg 100%+30%-ot).

Szerintem nehany embernel tul nagyok az elvarasok az R700 kapcsan, semmilyen realis alapja nincs a GTX280 vero R700-nak, valoszinuleg lesz nehany cherry picked beallitas/felbontas ahol gyorsabb lehet, de nagy atlagban nem hiszem eselye lesz, persze volt mar, hogy tevedtem

-

wolfman

veterán

válasz

Dare2Live

#2083

üzenetére

Dare2Live

#2083

üzenetére

Jól látom hogy az nVidia logo a Crysis nano suit felületű hátteren domborít? Olyan mintha azt hírdetnék, hogy "Ez a játék csak nVidia kártyákkal megy jól!" Na mindegy.

Amúgy meg, ha jól számolom még 2 hónap mire a bejövő vidkarik ára elindul lefelé. Addig mit csináljak? Előszedem a régi játékokat.

Az a gond, hogy a személyes kasszámat picit elszámoltam, és szűkösen tudok sztem majd csak venni vidkarit. Nyugtassatok meg hogy nem lesz ez olyan drága!

Az a gond, hogy a személyes kasszámat picit elszámoltam, és szűkösen tudok sztem majd csak venni vidkarit. Nyugtassatok meg hogy nem lesz ez olyan drága!

-

Dare2Live

félisten

és tuti lehet mutatni pletykát ahol az RV770XT gyorsabb mint a GT280.

ennyit a pletykákrol.deha már pletyi akkor van vmi ami biztosabb: ha annyi tranzisztor és 512bit lesz benne mint amiröl pletyiznek akkor a mag gyártása k* drága lesz. A nyák gyártása k* drága lesz. és ha ez igaz akkor szép darab lesz a végeredmény:

[link]nembaj majd kivágom a házam elejét mert ez máshogy nem fog beférni. Meg a tápcsatikat is hosszabítani kell, hogy elérjenek a kari végéig.

Ami tuti, nemsokra meglátjuk mekkora a 100K fölötti vga kari piac mert annál olcsobban NV-GT meglepne ha lenne. Főleg úgy, hogy a 85%+is (steam szerint) 1280*1024ben játszik ahova már elnézést de crysis kivtelével egy 8800GT/3870 bőven elég. Az tuti, nekik elég lesz az új ATI még az új Battlefieldhez is. piac 15%án lehet gyözedelmeskedik majd NV, pletyid szerint.

-

rocket

nagyúr

-

rocket

nagyúr

Dehogynem tragedia, CF AFR = zero, altalaban az ujabb jatekokban vannak gondjai allandoan, kit erdekel Far Cry alatt tokeletesen skalazodik, ha az ujonnan kijovo jatekokban 30% sincs.

Almodban mukodik jobban , sok esetben meg a 9800GTX szintjet se hozza a HD3870X2, hala a csodalatos AFR modnak, es akkor meg a micro stutteringrol nem is beszeltunk amit az AFR megoldasok magukkal hordoznak.

, sok esetben meg a 9800GTX szintjet se hozza a HD3870X2, hala a csodalatos AFR modnak, es akkor meg a micro stutteringrol nem is beszeltunk amit az AFR megoldasok magukkal hordoznak. -

m4rc!

őstag

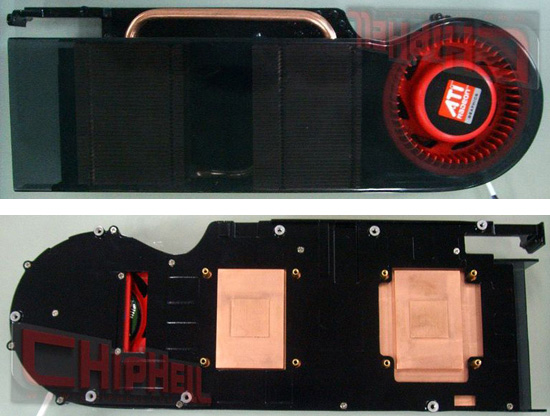

Pár régi/új kép a hűtésekről:

Az X2 ez alapján tuti 2 külön GPU-ból fog állni...

-

R.Zoli

őstag

válasz

leviske

#2071

üzenetére

leviske

#2071

üzenetére

hogy az X2 nem fogja beelőzni a GTX 280-at????

hogy az X2 nem fogja beelőzni a GTX 280-at????

Naeztmeghogyafrancbagondolod

Ha az Inq igazat ír akkor még simábban fogja beelőzni mint korábban gondoltuk,mert nem képes akkora órajelre a GTX 280 mint NV gondolta...Ultra változat? 300 watt fogyasztással és talán lesz 2 chip a 2 millió legyártottból ami képes a ref. clock felett mennni 15%-kal???

A 4870 X2-nek legalább 25%kal gyorsabbnak kellene lennie mint a GTX 280-nak...

A 4870 X2-nek legalább 25%kal gyorsabbnak kellene lennie mint a GTX 280-nak...Egyébkét pedig mint is profitált az AMD a natív 4 magos procijából???? Lelen pillanatban semit és a konkurenciához képest is semmit... Mire versenyképes lehetne a natív 4 magos addigra az Intelnek is lesz, szerintem egy nagyon buta lépés volt a natív 4 mag és frankón versenyképtelenné is tette az AMD-t desktop fronton...

-

Dare2Live

félisten

azért nem hinném, hogy az NVt nagyon félteni kellene, az elmúlt 2évben ők voltak a toppon, kifolyika pénz a seggük alól, és mint eddig majd jól/mégjobban lefizetik a játékgyártókat, hogy csináljanak/rakjanak be olyan kodot a játékokba ami miatt ATIn szarul fut.

már látom ahogy sorra jönnek ki a patchek(új gamek) és látjuk ahogy az ATI karikon feleződik az FPS és lámlám, milyen versenyképes máris az NV.

-

leviske

veterán

Én még mindíg nem mernék mérget venni arra, hogy a X2 beelőzi a GTX280-at...ha mégis megteszi, akkor még mindíg kijöhet egy "Ultra" változat. Egy GX2 teljesen versenyképtelen volna. Ha véletlenül 800$-ért tudnák kiadni, akkor elindulna a leejtön a 280-as ára és vele párhuzamosan a 260-asé...Aminek értelme volna, az egy frissített GT200, de akkor olyan szinten frissíteniük kéne, mint annó a G80-at a G92-vel.

Szvsz. ebből a helyzetből is látszik, hogy a GT200 tervezésekor az nV egyenesen le***ta a desktop piacot...

Am. előző hsz-ban nem értettem egyet az Opetron féle hasonlattal.

Az AMD a későbbiekben profitálni fog abból, hogy kitudott adni egy natív 4magos procit, míg a GT200-ból az nV semmit nem fog később profitálni... A GT200 vs. R700 esetet én inkább a Pentium vs. Core2 esetéhez tudnám hasonlítani.

Az AMD a későbbiekben profitálni fog abból, hogy kitudott adni egy natív 4magos procit, míg a GT200-ból az nV semmit nem fog később profitálni... A GT200 vs. R700 esetet én inkább a Pentium vs. Core2 esetéhez tudnám hasonlítani.

-

R.Zoli

őstag

Pontosan...

A legnagyobb pofont ott érzem az NV számára ,hogy a 4870 X2 olcsóbb és gyorsabb lesz mint a GTX 280... És az NV nem fog tudni erre semmit sem lépni....Alaposan vissza kellene venniük a GTX 260 órajeleit is ahhoz ,hogy 2 GPU-s változatot tudjanak belőle előállítani... Pont annyival kellene visszavenni amennyivel erősebb lesz a 4870 X2 ,ergo ha nagyon downclockolnák a GTX260-at akkor lehetne belőle 2 GPU-s kártya, iszonyatos összegért, kb. 4870 X2 szintű fogyasztással,arról nem is beszélve ,hogy milyen nyák kellene ahhoz amin 2 darab 512 bites memo interface-es GPU-van...Egyszerűen azért nem lesz értelme a terméknek mert versenyképtelen...Ahogy az egész GT200 széria versenyképtelen a rossz kihozatal, magas fogyasztás és a bonyolult nyák miatt...

-

leviske

veterán

válasz

Foglalt név

#2068

üzenetére

Foglalt név

#2068

üzenetére

Most jelenleg Júni 16. és 18.-át hallani.

Szvsz. valószinűbb a 16....

Szvsz. valószinűbb a 16....

-

Foglalt név

addikt

Látom az első hsz nem frissül, lehet végülis tudni, hogy mikor lesz megjelenés?

-

Crytek

nagyúr

Nvidia GTX 260 -> $449

Nvidia GTX 280 -> $600+Ati 4850 -> $269

Ati 4870 -> $349Hát nemtudom az árak azt mutatják baromi nagy teljesítmény különbségnek kéne lenni.Kiváncsian várom az első teszteket!

-

BloodyEddie

őstag

válasz

PepeDon

#2061

üzenetére

PepeDon

#2061

üzenetére

Oda már én beküldtem

R.Zoli: Az AMD egyre feljebb halad, el se tudom képzelni mi lesz a 45 nm-es generációnál.. Csak meg kell nézni a Radeon 2k szériát, nagy bukás volt, de a 3k már elindult egy jó irányba, amit szerintem a 4-es fog továbbvinni. Nv oldalon a 8as széria szép és jó, de a 9es mi volt? Semmi lényeges újítás, (8800gt-t leszámítva, kellett az ellenfél a 3870-nek) de kerestek vele szépen. Nem azt mondom h rosszak a kártyák, mert jók lettek, de ez nem az az előrelépés, amit sztem a többség elvárt. Ne értsetek félre, nem vagyok antiNv, most is ilyen vga-m van és elégedett vagyok vele, de nem értek egyet ezzel a politikával, ahogy kihasználják a piaci előnyüket.

-

R.Zoli

őstag

Jah megjegyezném ,hogy amilyen gyenge most a dollár egy GTX 280 100K lenne, ha rászámítjuk ,hogy hozzánk drágábban ér el akkor sem több 110K-nál...

Egy 4870 X2 pedig olyan 95K környékén lesz nálunk, míg a 4870 pedig olyan 60K alatt lesz valamivel...

Persze nyílván az induló árak ennél magasabbak lesznek mert minden újdoságra ráverik a plusz hasznot ha egyből megveheted valahol de 1 hónappal a megjelens után ezeknek az áraknak kellene realizálódniuk...

Ha figyelembe vesszük ,hogy az NV már így is nyomott árakkal jön mert máshogy abszolut esélytelen lesz az Ati ellen...Viszont az Ati már előre jelezte ezekből az árakból még tud tovább engedni...

Egymás mellé állítva a termékeket:

GTX260 vs. 4870 = a GTX 260 szerintem olyan 25%-kal lesz gyorsabb viszont többet eszik és sokkal drágább lesz...A két kártya között úgy lesz 20-25K különbség ,hogy az Ati nyereségesen tudja árulni a kártyáit az NV pedig örül ha kártyánként nullszaldós tud maradni...

GTX280 vs. 4870X2 =A 4870 X2 szerintem olyan 25%-kal lesz gyorsabb, olyan 40 wattal fog többet fogyasztani és kb. egy jó huszassal olcsóbb lesz... (aztán majd jönnek a játékokban az NV féle csalások ,hogy az a 25-30% előny néha elolvadjon...hányok tőlük...)

Szerintem az NV ott nézte be nagyon ahol az AMD az opteronnal natív maggal az Intel féle 2x2 mag egybekozással szemben... Ugyan ez az eset... Az Ati csinált két "lassabb" chipet és egy nyákra pakolta őket az NV meg elkövette a legnagyobb ökörséget amit lehetett, egy eleve rossz kihozatali aránnyal rendelkező G92-ből csinált egy még nagyobb DIE méretű és még nagyobb selejtaránnyal rendelkező terméket amivel abszolut bukó lesz az Ati-hoz képest...

Az Ati pedig szépen okosan kivár 45 nanoig és ott majd szépen egybetokoz két chipet közös memokontorrelrrel...Ez okos lépés volt, most érzem azt ,hogy az AMD/Ati páros tanult a korábbi saját hibáiból és olyat lépett ami ésszerű volt...NV feldobta a labdát a GT200 féle monszrum chippel az AMD pedig leütötte...

A tévedés jogát fenntartom

-

R.Zoli

őstag

válasz

Bundás22

#2060

üzenetére

Bundás22

#2060

üzenetére

Azt írja ,hogy nagyon csúnyán ki fog kapni a 4870X2-től a GTX 280... Namost a cikk arra is utal ,hogy még az 1 Teraflopsot sem éri el a legnagyobb GTX280...Ez azért kicsit furcsa lenne... Ettől függetlenül én is azt érzem ,hogy a 4870 X2 keresztbe le fogja nyelni ezt a kártyát... Bár szerintem a 4870 X2 250 watt feletti fogyasztással fog rendelkezni... Szerintem olyan 275 wattos TDP-vel fog jönni... Ebben jobb lesz a GTX 280...

-

Abu85

HÁZIGAZDA

válasz

ulveczkii

#2051

üzenetére

ulveczkii

#2051

üzenetére

Ez annyira nem tragédia. A Catalyst 8.3-tól új CF rutinok vannak, és erősen az AFR-t erőltetik. Az MCM R700-hoz nem tökéletes ez az elgondolás, oda Threaded rendering elvű rutín kellene a hatékony működéshez. Az AMD most jobb ha a biztosra megy, a HD3870x2 egyre jobban működik, badarság lenne ilyen körülmények közt bevezetni egy új elgondolást amiről nagyon kevés tapasztalat van.

-

leviske

veterán

válasz

janos666

#2054

üzenetére

janos666

#2054

üzenetére

Az X2-esek hűtése szinte ugyan az, csak a 48-asból kiáll egy jó nagy rézcső...

A 70-es hűtése már jobban aggaszt...

Ha összehasonlítom az XT hűtésével, akkor maximum optikailag tűnik nagyobbnak, a matrica miatt...

Ha összehasonlítom az XT hűtésével, akkor maximum optikailag tűnik nagyobbnak, a matrica miatt...  29XT (érdemes 65%-ra állítani a nagyítást) és a már linkelt 4870

29XT (érdemes 65%-ra állítani a nagyítást) és a már linkelt 4870

(#2058): Már több helyen olvastam 16.-át és hihetőbb is volna...elvégre, ha 18.-án érkeznek, akkor a GTX280/60-al együtt debütálnak...

Két nap pedig már semmit sem számít.

-

janos666

nagyúr

válasz

illusiON

#2057

üzenetére

illusiON

#2057

üzenetére

Elvileg Júni 18-tól boltokban lesz a 4850, akár még magyarországon is találhatsz már rá egy hétre. A 4870-et először el akarták tolni hó végére, aztán most megint azt állítják egyszerre jönnek, lehet azt is be lehet majd szerezni itthon is, lehet vastagon július lesz már mire itthon kapható lesz.

-

illusiON

őstag

válasz

BloodyEddie

#2055

üzenetére

BloodyEddie

#2055

üzenetére

''Printed Circuit Board, PCB''

mikor fog jönni ez a kártyasorozat, kiderült már mikor kerül magyarországra is?

pf, beelőztek

-

7600GT

senior tag

válasz

BloodyEddie

#2055

üzenetére

BloodyEddie

#2055

üzenetére

Anyák? mothers

Amúgy PCB.

Amúgy PCB. -

BloodyEddie

őstag

Kis off:

hogy van a nyák angolul?

-

janos666

nagyúr

válasz

leviske

#2053

üzenetére

leviske

#2053

üzenetére

Szerintem szimlán csak úgy számoltak hogy minél olcsóbban kihozzák a hűtés témát, nem az volt a gond hogy ne lett volna idejük törni a fejüket, mert hűtés helyett CPU-t tervezett ugyanaz az egyén, vagy ne szakadt volna le egy kis pénz erre is. (mert akkor nem is lett volna másféle prototipus...) Direkt ilyet akartak.

Egyébként meg szerintem egész biztató az a 4870-es hűtő így képről. Ha a gyártók rányomnak egy szép nagy matricát akár még esztétikus is lehet, de amúgy szép nagy légkavarója van, ránézésre nagyobb mint a mostani kártyámé, lehet nem lesz az túl hangos. Ha meg igen lecsavarozom a fedelét ér rákötözünk egy 9cm-es zalman ventit a bordára.

Amúgy szerintem nem korai, a konkurencia nyákja és hűtése is rég közkincs fénykép és CAD formában is. (utóbbin amúgy nagyon meglepődtem hogy előbb volt CAD-ből renderelt mint kamerás kép...) 4870 nyákot még máig nem láttam.

Szerk: Jobban megnézve amúgy ez még nyugodtan lehet az ami a régi képeken volt, csak most nem átlalátszó a burkolat, de ugyanúgy beszűkül és attól hogy nem látjuk nézhet ki ugyanúgy a bordázat és a hőcsövek elrendezése.

-

leviske

veterán

válasz

ulveczkii

#2051

üzenetére

ulveczkii

#2051

üzenetére

Érdekes, hogy ilyen hamar kiszivárgtott, hogy milyen hűtést kap...

Viszont nem csodálkozom rajta, hogy nem tudtak előrukkolni azzal a fejlesztéssel, ami a pletykákban szerepelt.

Viszont nem csodálkozom rajta, hogy nem tudtak előrukkolni azzal a fejlesztéssel, ami a pletykákban szerepelt.  Jelenleg fontosabb nekik a Fusion fejlesztése...és akkor még ott van nekik a Shanghai és a Hydra tervezési költsége is.

Jelenleg fontosabb nekik a Fusion fejlesztése...és akkor még ott van nekik a Shanghai és a Hydra tervezési költsége is.

-

ulveczkii

tag

link

A legfelső hűtőmegoldásból az körbonalazódik hogy az r700 két különálló chip lesz

-

marcias

őstag

Köszi a (számomra is) érthető választ.

Eszerint nem egy teljesen új dologról van szó, hanem (gyanítom a rendelkezésre álló mind nagyobb számítási kapacitást kihasználva) ezt a technológiát tervezik majd szélesebb körben (árnyékok, tökröződések, ahogy mondtad) felhasználni.

Eszerint nem egy teljesen új dologról van szó, hanem (gyanítom a rendelkezésre álló mind nagyobb számítási kapacitást kihasználva) ezt a technológiát tervezik majd szélesebb körben (árnyékok, tökröződések, ahogy mondtad) felhasználni.

Azért is kérdeztem ezt, mert kocsit olyan érzésem támadt, hogy az RV7x0 sorozat, és úgy általában az Ati növekvő nyomása a techológiai fejlesztésre (Dx10.1, Dx11) arra ösztönzi az nVidiát, hogy latba vessen ő is valamit, hogy ne köpködjék a fejlődés hátráltatójaként, de mivel nyilván nem fogja az Ati által követett utat választani, hiszen akkor idegen területre merészkedne, ezért valamilyen más csapásirányt jelöl ki annak érdekében, hogy az Ati ne tudja elcsábítani új techológiáival a fejlesztőket, és megint csak 2. lehessen.

Bocsi hogy kicsit hosszú mondat lett

-

Drizzt

nagyúr

válasz

marcias

#2045

üzenetére

marcias

#2045

üzenetére

Raytracing. Ez nem egy kifejezetten új dolog, lehet régebbiis, mint az, amit a mai videokártyák használnak, de ennek megvan az oka: roppantul számításigényes. A raytracing alapelve az az, hogy elhelyezel egy téglalapot a térbe, amit meg kívánsz jeleníteni, majd felbontod annyi sorra, s oszlopra, amekkora felbontású képet akarsz készíteni. A téglalap egyik oldalán kijelölsz egy pontot, s abból minden egyes ilyen pontjára a téglalapnak kiküldesz egy sugarat(szóval ez a téglalap gyakorlatilag olyan, mintha a képernyőd lenne elhelyezve a virtuális térben, s ami előtte van, az lesz a monitorodon.). A sugár gyakorlatilag csak egy egyszerű egyenes. Minden objektumra ami a térben van, meg kell nézni, metszi-e az egyenest, vagy nem. Ha van metsző objektum, akkor a legközelebbit ki kell választani, s innen további sugarakat lehet még kiküldeni. Raytracingnél további sugarakat két kitüntetett irányba, a törési és a tükörirányba kell továbbküldeni, s ugyanúgy kiszámolni a legközelebbi metszéspontot, stb. Az eljárásnál árnyékok készíthetők, illetve teljesen valós tükröződések, s átlátszóságok. A végtelen tükrözések miatti végtelen ciklus ellen szokás megadni egy rekurziós mélységet, ez maximálja, hogy hány fény visszaverődést/törést veszünk figyelembe(különben amúgy végtelen ciklusba kerülne egy raytracer, nameg már a 10. tükröződés is tuti jóval kisebb lesz egy pixelnél). Mivel azonban minden pixelre függetlenül kell elvégezni a számításokat, így nagyon lassú az inkrementális képszintézishez képest, aminek az az ötlete, hogy minél több korábbi eredményt felhasználjunk a számítás során. Például kiszámítunk valamit a háromszögháló háromszögeinek csúcspontjaiban, s azt a tulajdonságot a köztes(a háromszög belső pontjaiban) pontokban a grafikus hardver interpolációval megadja. Ezen kívül ott van még a vágás, takarás, depth-test, s csomó minden, amivel meg lehet takarítani sok-sok felesleges számítást. Hátrány, hogy poligonhálóval kell dolgozni, előny a sebesség, s mint az látható, nagyon sok dolgot ügyes trükökkel meg tudtak csinálni. Tükröződésektől kezdve az árnyékokig, bucka leképezésig, blabla. Raytarcingnél ha egy gömböt akarsz kirajzolni, az tényleg gömb lesz, míg inkrementálisnál egy közelítő háromszögháló.

Amúgy nem sok elképzelésem van az Ati által felvázolt jövőről.

A globális illuminációról nem nagyon merek nyilatkozni, úgy tudom, hogy nagyon hasonlít a raytarcinghez, csak nem a pixelen látható sugarakból indul ki, hanem a fényforrásokból indítunk sugarakat. Ahhoz, hogy ebből kép legyen, még sokkal több számítás kell. Az Ati-féle Cubemap alapú megoldás nem tudom hogyan is működik, majd valamikor utánanézek már...

A globális illuminációról nem nagyon merek nyilatkozni, úgy tudom, hogy nagyon hasonlít a raytarcinghez, csak nem a pixelen látható sugarakból indul ki, hanem a fényforrásokból indítunk sugarakat. Ahhoz, hogy ebből kép legyen, még sokkal több számítás kell. Az Ati-féle Cubemap alapú megoldás nem tudom hogyan is működik, majd valamikor utánanézek már...Abu: A dx9 alapú Cubemappinggal miért nem csinálnak Gi-t, vagy miben tudna az kevesebbet? Vagy csinálnak?

-

Bundás22

őstag

válasz

BloodyEddie

#2042

üzenetére

BloodyEddie

#2042

üzenetére

Last we heard, RV770 has 480 shader processors, not 800, but there are also some stories(mendemondák) going around that there might be some substance to the rumors(pletykák) of RV770 having 800 shader processors. Only 480 of them would be for the graphics though, while the remaining 320 is for physics. We can't confirm this so take it with a pinch of salt(nem tudjuk megerősíteni, tehát fenntartással).

sztem ez nem igaz, pletyka

-

BloodyEddie

őstag

válasz

#57018880

#2041

üzenetére

#57018880

#2041

üzenetére

Ati középkategóriás áron akarja lealázni a mostani csúcskategóriát

kis olvasnivaló

"RV770 having 800 shader processors. Only 480 of them would be for the graphics though, while the remaining 320 is for physics." Lehet h ez csak nekem újdonság, de ezekszerint így lesz fizikai számolás az RV770be építve? -

Crytek

nagyúr

válasz

BloodyEddie

#2038

üzenetére

BloodyEddie

#2038

üzenetére

"Én azt fogom megvenni, amelyik gyártó jobb kártyát kínál kedvezőbb áron."

Akkor atid lesz

Nvidia 100 fölött lesz ati emg max 80 ezer.

Nvidia 100 fölött lesz ati emg max 80 ezer. -

R.Zoli

őstag

na ez eddig ok is...DE az AMD és Intel már évek óta rajta van a témán....Namost az NV még csak most indul be ezen a téren...Ergo mire elindul nála egy RT project addigra kb. 3 éves lemaradásban van az Intel és AMD-hez képest...Arról nem is beszélve ,hogy processzor tervezési tapasztalata nulla míg a másik két szereplőt nem kell firtatni...

-

BloodyEddie

őstag

válasz

#57018880

#2037

üzenetére

#57018880

#2037

üzenetére

Én azt fogom megvenni, amelyik gyártó jobb kártyát kínál kedvezőbb áron. Sose voltam nagy Ati rajongó, de őszintén szólva remélem össze tudja szedni magát az AMD, nem lesz így jó ha az nV fog kiskirálykodni.

Az nV most mire játszik? Nem tesznek új technológiát a kártyáikba (pl. dx10.1), mert "véletlenül" nem használják a játékok. Eddig oké, de majd ha elterjed, berakják ők is, és vegyek új vga-t? Na ne, inkább Ati, ha picit gyengébb is, de az a sok cucc amit belepakolnak, még hasznos lesz majd..

-

#57018880

törölt tag

válasz

leviske

#2036

üzenetére

leviske

#2036

üzenetére

"...bár ki tudja, hogy kinek, ki a nagyobb ellensége?! /ATi+nV>Intel/ATi+Intel>nV/Intel+nV>ATi/?/'

Szerintem a vezetok egyutt bekesen mojito koktelt szurcsolnek a yakuzzi-ban es azon rohogik ki a belsoszerveiket ,hogy mikent oli egymast a sok * zold, voros es (legyen mondjuk Intel) kek fanatic a kulonbozo forumokon. A szinekbol elofordulhat keverek is nyilvan .

. En megvarom a teszteket , amikben kiderul ,hogy mit tudnak az atik jatekok alatt ,ha jobbak mint az NV nem keredes ,ha 10% -al lesz atlag lemaradva szinten ati lesz (HD4870) ...80%-ban NV kari volt/..van a gepemben ,de az NV tegyunk ketszer annyi cuccot egy nyak-ra strategiaja mar nem bejovos , csakugy mint a 3 way SLI meg a 2*2 core sux.

-

leviske

veterán

válasz

janos666

#2025

üzenetére

janos666

#2025

üzenetére

Szerintem még most fejezzük be az el sem kezdett flame-et.

Szerintem te is tisztában vagy vele, hogy nem kimondottan erre a dologra gondoltam, hanem összességében a játékfejlesztők lefizetéséért.

A GT200-ról senki sem állította, hogy kilép a piacról, hanem azt, hogy nem desktop-ra van tervezve. És ez erősen arra enged következtetni, hogy már nem csak a vga piacon akar jelen lenni.

Ezzel pedig tudomásom szerint semmivel nem gyorsítja, vagy lassítja a piacot, hogy felvásárolta... senki nem tudja jobban megmondani, hogy milyen hardver kell a ray tracing-hez, mint maga a "kitalálója".

Ez kb. ugyan az, mint a AMD/MS páros, csak itt nem volt szó felvásárlásról...

Az ATi-t pedig nem írtam el...

Az nV-t nem érzem igazi ellenfélnek. Míg az ATi és az Intel fejlesztésekkel tud egymás ellen harcolni, az nV csak azzal tudna versenybe szállni, hogy a kártyáira optimalizáltat.

MOD: senki félre ne értsen. Nem örülnék, ha az nV kivonulna a piacról (bár erre esély sincs még egy jó 8-10 évig), mert akkor hajlamos lenne az ATi is elszálni az árakkal. És ellenségem ellensége a barátom... bár ki tudja, hogy kinek, ki a nagyobb ellensége?!

/ATi+nV>Intel/ATi+Intel>nV/Intel+nV>ATi/?

/ATi+nV>Intel/ATi+Intel>nV/Intel+nV>ATi/? -

Tomate

veterán

válasz

janos666

#2025

üzenetére

janos666

#2025

üzenetére

Ajánlom figyelmedbe

Tudom, hogy lesz*rod de azért átnézhetnéd, hogy legalább mit nem vagy hajlandó használni!

Ennél átfogóbb írás nincs a j;ly-ről az tuti! -

PepeDon

tag

válasz

janos666

#2025

üzenetére

janos666

#2025

üzenetére

Tudom egyszer már kifejtetted, hogy számodra felesleges a j és az ly, de kérlek inkább ne írj ide semmit (főleg ne az nvidiával kapcsolatba). Rossz olvasni. Felylesztés majd lefordultam a székről. Az az érdekes, hogy megmagyaráztad, hogy neked felesleges, de mégis hol ezt, hol azt a j-t téveszted (tehát te se tudod melyik 1 j lenne neked a megfelelő). Akkor inkább használ mindenütt j-t.

-

Drizzt

nagyúr

Közben ott volt még az is, hogy a hibrid megoldást támogatják: nagyrészt szokásos inkrementális képszintézis, s néhol a jeleneten belül raytracing. Mondjuk pontosan nem tudom hogy akarják ezt skálázhatóan megoldani, de biztos ezért vették meg a céget. A neve alapján főleg valószínűsíthető.

-

keIdor

titán

Ez most kb. olyan, hogy van három testvérpár, a legnagyobb az Intel, a középső az Nvidia a legkisebb meg az AMD.

Az Nvidia most kedvére verheti, ütheti, kinevetheti az AMD-t, mert gyenge és kisebb náluk, de csoda, hogy ugyanezt csinálják az Intellel is, akik nagyobbat, gazdagabbak és erősebbek, mint ők... jó bátor az Nvidia, kikezd a "nagytesó"-val is. Csak nehogy oltári nagy pofáraesés legyen ebből.

Csak nehogy oltári nagy pofáraesés legyen ebből. -

Tomate

veterán

A múlt hónap folyamán az Nvidia elnök-vezérigazgatója, Jen-Hsun Huang kinevette az Intelt, amiért az el volt ragadtatva a ray tracing által kínált lehetőségektől.

Erre:

A legfrissebb információk szerint az Nvidia a korábbi véleményének megfelelően cselekedett a minap és felvásárolta a ray-tracing szoftvermegoldásokkal foglalkozó vállalatot, a RayScale-t.

Kineveti, lenézi, majd megveszi? Nem értem...

-

KisBundi

őstag

válasz

leviske

#2024

üzenetére

leviske

#2024

üzenetére

Igazság szerint az nVidia az csinál amit akar mert tele van lével (nem vagyok nVidia párti). Az AMD kicsit kevesebb kerettel rendelkezik az ATi felvásárlása miatt, bár szerintem ha összeszedik magukat az AMD/ATi kettős bizony még nagyon oda fog vágni az nV-nak.

Ilyen szempontból az nV csal mert jobb anyagi helyzetéből kifolyólag felvásárol mindent hogy később ő tudjon dirigálni. Lásd egyre több játékfejlesztő cég áll az nV mellé ezért jobban futnak a játékok nV karikon amiből következik a még több lé. Ez egy ördögi kör és az AMD-nek igen csak össze kell magát szednie, bár az új GPU hallatán erre meg van minden esélyük.

-

janos666

nagyúr

válasz

leviske

#2024

üzenetére

leviske

#2024

üzenetére

Nem értem miért perelné be az AMD az nv-t azért mert felvásárol egy tőle független céget és ezzel még monopol helyzetre se lép semmilyen téren. 1000 más oka lenne rá, de ez most gyenge érv lenne.

Viszont most jöhetnek azok akik szerint az nvidia a GT-200al kilép a VGA piacról, mert bele se mer vágni a sugárkövetésbe. Ez a lépés nem népp erre utal. Vagy ez is csak egy nagy megtévesztés az összeesküvésben, mi?

Másrészt mikor nem erőlteteti hanem lassítja a felylődést az nv akkor az a baj (legalábbis látszólag, hogy gyakorlatban ténylegesen is vesztünk-e valamit az jó kérdés de sose tudjuk meg), mikor belevág valamibe amit a nagy kedvencek eddig csodálatra méltó módon felylesztgetnek akkor az is baj?

Más: Elírtad, azt akartad hogy lesz ellenfele az nv-nek, nem az ATI-nak...

-

leviske

veterán

válasz

littlelion21

#2022

üzenetére

littlelion21

#2022

üzenetére

Számomra érthetetlen az AMD... - ha már az Opera perelheti a MS-ot, hogy mer böngészőt rakni az operációsrendszerébe, ha az EU perelheti ugyszintén a MS-ot a WMP/IE/stb miatt- nem értem, miért nem fordul a versenyhivatalhoz.

Az ilyen szánalmas férgek, mint az nV nem méltók az IT piacra.

Meg lehet nézni az AMD vs. Intel kűzdelmet: Intel is elviselte, mikor a Pentiumokat verte az AMD... nem fordult ilyen eszközökhöz, mint az nV. És jelen pillanatban fordítva sincs így, pedig az AMD mögött áll a Microsoft.

Meg lehet nézni az AMD vs. Intel kűzdelmet: Intel is elviselte, mikor a Pentiumokat verte az AMD... nem fordult ilyen eszközökhöz, mint az nV. És jelen pillanatban fordítva sincs így, pedig az AMD mögött áll a Microsoft.

Alig várom, hogy megjelenjenek az Intel VGA-k. Nem azért, mert váltani akarok, hanem végre lesz egy méltó ellenfele az ATi-nak.

De már ez nagyon off lett, elnézést kérek.

-

dr.radon

csendes tag

válasz

littlelion21

#2022

üzenetére

littlelion21

#2022

üzenetére

Nekünk jó lesz. Minől többen foglalkoznak vele, annál gyorsabb lesz a fejlődés, és ki tudja, talán 2-3 év múlva tényleg élethűek lesznek a gamék. Remélem a fizika és az AI is toppon lesz addigra.

-

littlelion21

addikt

Erről vmi vélemény...?

-

válasz

BloodyEddie

#2014

üzenetére

BloodyEddie

#2014

üzenetére

tápot vehetsz mindentől függetlenül.

4 hét és itt lesznek a tesztek, akkor még mindig vehetsz 88GT-t, ha úgy alakul

-

leviske

veterán

Ezt annó én is kérdeztem...

Az a gond, hogy egy olyan kétmagos, mint pl: a Core 2 Duo, nem volna két fillér. És kihozatalban is kb. ott lenne, mint a GT200 tehát a többmagos GPU egyelőre még várat magára.

Az a gond, hogy egy olyan kétmagos, mint pl: a Core 2 Duo, nem volna két fillér. És kihozatalban is kb. ott lenne, mint a GT200 tehát a többmagos GPU egyelőre még várat magára.Nem hinném, hogy az előtt lenne többmagos GPU, mielőtt már ellepik a Larrabee/Fusion féle megoldások a piacot, az pedig nem most lesz.

Az után meg már felesleges lesz...

Az után meg már felesleges lesz...

Ha pedig olyanra gondolsz, mint a Core 2 Quad, akkor elviekben kb. olyan lesz a R700, tehát két RV770 egy tokozás alatt és, ha jól emlékszem, akkor HT3-mal fognak kommunikálni, de ez nem biztos.

-

janos666

nagyúr

válasz

BloodyEddie

#2018

üzenetére

BloodyEddie

#2018

üzenetére

Szerintem élvezd ki az érettségi szünetet, ha egyetemre mész ott legfeljebb vizsgaidőszakban lesz még hasonló lazulás. (biztos sokan ellenkezően vélekednek, de ahol én vagyok ott a vizsgaidőszak a pihenőidő)

Viszont várd meg a kártyát, ha rögtön megjelenés után veszed magasabb áron mint amennyiért később kapnád meg akkor is jobban megérheti egy 4850-es mint egy 8800GT. És ennyi erővel mindíg lehet várni a következő árcsökkenést és akár sose vegyél gépet. Főleg ha nyáron érsz rá játszani akkor ne az érdekeljen hogy télen mennyibe fog kerülni a kártya, hisz neked télen fele annyit se ér ha alig használod.

Ezért fogok én is sorbanállni amint kijön a 4870, mert nyáron használnám, ősszel már alig. -

BloodyEddie

őstag

válasz

TomBoy1986

#2016

üzenetére

TomBoy1986

#2016

üzenetére

Igazad van

Még vár rám 12 kidolgozandó német szóbeli tétel..

Még vár rám 12 kidolgozandó német szóbeli tétel..

Ha minden igaz, be fogom tudni szerezni a kártyát, kiskert átugorva (persze NEM kamionról potyogtatóst..) De még így sem szánnék rá 40-45k-nál többet, valamiből azért élni is kell.

(persze NEM kamionról potyogtatóst..) De még így sem szánnék rá 40-45k-nál többet, valamiből azért élni is kell. -

rocket

nagyúr

válasz

TomBoy1986

#2016

üzenetére

TomBoy1986

#2016

üzenetére

Szerintem a fo piacokon eppen kovetkezo nyari szezon, nem igazan az a tipikus VGA vasarlasi szezon, szoval ha igyse lesz eleg RV770-re epulo kartya, az eleg kinos lesz chimpzillajeknak

-

TomBoy1986

veterán

válasz

BloodyEddie

#2014

üzenetére

BloodyEddie

#2014

üzenetére

Elég nagy a várható kereslet rá, mivel megbolygatja az állóvizet... szerintem mindenképp várd meg, legalább nem cseszed el az érettségit

A 3870-et lassan lehetett kapni (kb. 1 hónappal a megjelenés után), a 3850-et viszont szinte azonnal, igaz korlátozott példányszámban és drágábban. -

Hakuoro

aktív tag

GT200 folds 3 times faster than RV670

Ha RV770 2x gyorsabb mint az RV670 akkor kb 50%-al lehet gyorsabb a GT200 a 4870-nél. Bár ez a folding@home kliens még valószínűleg optimalizálatlan. Talán nem a legjobb viszonyítási alap, de ha ez igaz a R700 verni fogja a GT200-at. (legalábbis ebben a progiban) -

BloodyEddie

őstag

Persze h fontos az ár/teljesítmény, de a mostani gépem tápja megadta magát és addig nem igazán tudok mit csinálni

Júliusig biztosan nem fogok várni, és a számítástechnikában sajnos nincs tökéletes időpont a vásárlásra..

Júliusig biztosan nem fogok várni, és a számítástechnikában sajnos nincs tökéletes időpont a vásárlásra..Mikorra ér be Magyarországra? Ha nem csúszik sokat, inkább várok, jún. 18 körül úgyis érettségi..

-

válasz

BloodyEddie

#2012

üzenetére

BloodyEddie

#2012

üzenetére

ha tényleg megjelenik június 18-án, akkor július közepe-vége előtt nemigen lesz érdemes megvenni (legalábbis ha az ár/teljesítmény viszony fontos). én megvárnám a helyedben legalább a megjelenést a tesztekkel.

-

BloodyEddie

őstag

Megéri most várni erre? Nem vagyok se Geforce, se Ati párti.. Most vagyok gépvásárlás előtt, eddig egy 8800 Gt-t néztem ki, de ez a 4850 GDDR3-al jónak tűnik.. Mikorra fut be kis hazánkba? Szerintetek mennyiért fogják vesztegetni

-

schwartz

addikt

Tipikus kelet europai felfogas. Szorjuk a penzt s majd a bank hatha felejt. Ja bocs, itt mindenki milliomos...

-

dr.radon

csendes tag

válasz

janos666

#2008

üzenetére

janos666

#2008

üzenetére

Hmm... azt írtam volna, hogy érdekli? Nem greenpeaces hsz volt te paranoid.

3,2-re húztam a 2140-esem és a 3850-esem sem gyári órajelekkel megy. Plussz bömböl a 5.1-es hangrendszerem. Szerinted ezek után a sötétben célzom meg a wc kagylót?

Ha meg élvezeti cikknek tekinted a benzint meg az áramot, akkor kellemes szipuzást, meg élvezetes konnektációt kívánok a hálózathoz.

-

válasz

tzsolesz

#2006

üzenetére

tzsolesz

#2006

üzenetére

nem ez van a dolog hátterében. a monolit chipes megoldások már nagyon erősen feszegetik azokat a határokat, ameddig bármennyire is költséghatékonyan gyárthatóak, el kell már indulni abba az irányba, hogy több, függetlenül gyártható szilikondarabkából álljon össze egy GPU. amit most látsz, azok szinte csak az első komolyabb szárnypróbálgatások - évek kellenek ahhoz, hogy ez a dolog beérjen. de ha már a technológia adott, bármennyire is éretlen, akkor nyilván használni fogják az Ultra High End kategóriában.

-

janos666

nagyúr

válasz

dr.radon

#2007

üzenetére

dr.radon

#2007

üzenetére

Úgy látom meggazdagodnék egy USB-re köthető, statisztikát vezető szoftverrel támogatott fogyasztásmérővel.

Akinek 3 24"-os monitorja meg crossfire rendszere van szerinted érdekli ha ez havi 2000 (de akkor sokat mondtam) forinttal többet teker az órán mint egy átlagos csúcskonfig? Mi ez a villanyóra mánia? Ti tényleg sötétben hugyoztok mert féltek felkapcsolni az energiatakarékos izzót? Az áram ugyanúgy egy élvezeti cikk mint a benzin (vagy akár egy üdítőital), azt is megveszed pedig folyton csak emelik...

Az áram ugyanúgy egy élvezeti cikk mint a benzin (vagy akár egy üdítőital), azt is megveszed pedig folyton csak emelik...

-

-

tzsolesz

nagyúr

Hali. Teljesen lelombozódtam, a sok GPU/SLI/CF megoldások hallatán. Valóban szükség van ilyen VGA összeállításokra a mai játékokhoz? 4xGX2-es, meg 3X88GT? Ez szörnyű, ez milyen felbontáshoz kell? Ja, és egy ilyen konfigot milyen proci képes meghajtani? A tápról már nem is beszéle, biztos kettő is kell a házba, egy jól megrángatott extreme-el.

Én elhiszem, hogy vannak fanatikusak, de ez akkor már túlzásnak hangzik, plussz 10-15fps miatt ennyi pénzt kiadni. Ja és lemerem fogadni hogy egy olyan ember aki 3x88GT, meg hasonló konfigokat kreál, az sokszor nem a játékkal tölti az idejét, hanem folyton tuningol, mér, tuningol, mér, és így tovább. Szerintem csak kevés olyan ember van, aki valóban arra használja amire kellene. Minthogy szétosztogatná nekünk a felesleges karikat.

Ja és én nem mondom ezzel, hogy ha annyi lóvém lenne, nem raknék össze én is egy hasonló konfigot, bár nem sok mindenre tudnám használni a 19"LCD-en.

-

janos666

nagyúr

De mire lenne jó ha ugyanúgy csak crossfireben/SLI-ben menne? Gondolj a CPU-kra, ott is nem csak egybetokozzák hanem egy chipben van 2-3-4 mag és mégis támogatnia kell az OS-nek is, de ami gyakorlatban fő probléma hogy a programot is többszálúra kell hozzá megírni hogy ne csak dísznek legyen ott a töbi mag az első mellé.

Én nem annyira örülök a crossfires/SLI-s megoldásoknak, míg csak 3DMark rekordokat döntögetni kell meg annak aki 2240-es felbontásban játszik addig oké, de nem szeretném ha általános dolog lenne hogy kettessével vásároljuk a VGA-kat, meg hogy 2-4 chip van egy nyákon, mert nem olyan hatékony/kopatibilis dolog mint 1 GPU. És így is úgyis gyorsítani kell a magokat/GPU-kat is, nem lehetne játszani hogy idén 2, jövőre négy, aztán 8 GPU-t rakunk egy nyákra és kész a fejlesztés.CPU-nál jó dolog hogy már nem csak egyetlen szálon fut minden háttérben cammogó és előtérben futó erőforrásigényes program, de egy GPU-ba most is több mint 100 shderproci van...

-

leviske

veterán

válasz

ulveczkii

#1999

üzenetére

ulveczkii

#1999

üzenetére

Engem meglepne, ha 1000SP-vel jönne ki az következő generációs GPU. Ennyi erővel a RV770 is jöhetett volna 800-al.

Lehet, hogy rosszul gondolom, de ha az eddigi logikát veszem alapul, akkor valószinűleg megint 1,5x-ös lesz a gyorsulás, tehát olyan ~640SP várható a RV870-től és ~1200 az R800-tól... Ennek az ellenkezőjét, mi szerint 1000SP lesz, csak akkor tudnám elhinni, ha az R8-as sorozat már DX11-hez készülne és a DX11 megkívánná a 1000SP-t.

(#2001) OkosTibiKing : Nem hiszem, hogy eröltetnének egy X3-ast, vagy X4-est, mikor még az X2 alá sem tudnak rendes driver támogatást nyujtani.

Talán, miután a CFX 250%-os gyorsulást tud felmutatni 4 kártya esetén... talán akkor érdemes lesz az ATi-nak X3-ason, vagy X4-esen gondolkodni.

Talán, miután a CFX 250%-os gyorsulást tud felmutatni 4 kártya esetén... talán akkor érdemes lesz az ATi-nak X3-ason, vagy X4-esen gondolkodni.  (Szvsz)

(Szvsz)

Aktív témák

- Apple asztali gépek

- Kormányok / autós szimulátorok topikja

- Úgy állhat le a 16 GB-os GeForce RTX 5060 Ti gyártása, hogy közben nem áll le

- A legrosszabb CPU-k – az ExtremeTech szerint

- Bambu Lab 3D nyomtatók

- Házimozi haladó szinten

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Counter-Strike: Global Offensive (CS:GO) / Counter-Strike 2 (CS2)

- Két generációval korábbi GeForce gyártása indulhat újra

- Bekeményítenek az ügyfelekkel szemben a memóriagyártók

- További aktív témák...

- ÁRGARANCIA!Épített KomPhone Ryzen 7 9800X3D 64GB RAM RTX 5080 16GB GAMER PC termékbeszámítással

- BESZÁMÍTÁS! Acer Predator Helios Neo 16 PHN16 notebook-i9 13900HX 16GB DDR5 1TB SSD RTX 4060 8GB W11

- HIBÁTLAN iPhone 12 Pro 256GB Graphite - 1 ÉV GARANCIA - Kártyafüggetlen, MS3283

- Apple iPhone 15 Pro Max 256 GB White Titanium 1 év Garancia Beszámítás Házhozszállítás

- Apple Mac Studio M2 Ultra 24 magos CPU, 60 magos GPU, 64GB RAM, 1024GB SSD

Állásajánlatok

Cég: Laptopszaki Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

, sok esetben meg a 9800GTX szintjet se hozza a HD3870X2, hala a csodalatos AFR modnak, es akkor meg a micro stutteringrol nem is beszeltunk amit az AFR megoldasok magukkal hordoznak.

, sok esetben meg a 9800GTX szintjet se hozza a HD3870X2, hala a csodalatos AFR modnak, es akkor meg a micro stutteringrol nem is beszeltunk amit az AFR megoldasok magukkal hordoznak.

Bar a tobbi kozott is van meg erdekes dolog. Pl az 1. es 3.-nal az a fogantyu azert van mert 2ora intenziv jatek utan vasalonak is jo lesz a kari?

Bar a tobbi kozott is van meg erdekes dolog. Pl az 1. es 3.-nal az a fogantyu azert van mert 2ora intenziv jatek utan vasalonak is jo lesz a kari?

hogy az X2 nem fogja beelőzni a GTX 280-at????

hogy az X2 nem fogja beelőzni a GTX 280-at????

Ha összehasonlítom az XT hűtésével, akkor maximum optikailag tűnik nagyobbnak, a matrica miatt...

Ha összehasonlítom az XT hűtésével, akkor maximum optikailag tűnik nagyobbnak, a matrica miatt...