- f(x)=exp(x): A laposföld elmebaj: Vissza a jövőbe!

- gban: Ingyen kellene, de tegnapra

- Geri Bátyó: Megint tahó voltam – SZEMÉLYISÉGFEJLŐDÉS

- Luck Dragon: Asszociációs játék. :)

- sziku69: Fűzzük össze a szavakat :)

- Argos: Adjátok vissza a netet! - szeretnék elaludni!

- ubyegon2: Airfryer XL XXL forrólevegős sütő gyakorlati tanácsok, ötletek, receptek

- sziku69: Szólánc.

- weiss: Logi MX Master 3S FW NEM frissítés

- btz: Internet fejlesztés országosan!

Hirdetés

Új hozzászólás Aktív témák

-

PuMbA

titán

Csakhogy a hivatalos rendszer követelményben sehol sincs 8 mag leírva. 2db CPU-t adtak meg amiknek épp 8 magja van

Ezért írtam azt, hogy a cikkíró jól kinézte magának a 8 magot és beírta a cikk címébe, aminek épp semmi értelme, mert az AMD Ryzen 7 1800X is 8 magos, de az nem elég a játéknak.

Ezért írtam azt, hogy a cikkíró jól kinézte magának a 8 magot és beírta a cikk címébe, aminek épp semmi értelme, mert az AMD Ryzen 7 1800X is 8 magos, de az nem elég a játéknak.Busterftw:

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Petykemano

veterán

Röviden : ebben egyelőre nem hiszek.

Szerintem ami megoldható.x86-ből "little" magként az az a tier (direkt nem teljesítményt mondtam), ami az A77-A78, stb képviselt. Az X1-X2 innen lépett el.

A Tremontról azt írták, hogy natív X86, hogy energiát spóroljon. Nem tudom elég-e vagy' van-e lejjebb.

Mindenesetre egy A55 vonal még a mobilokhoz hiányzik. De az arm irányából a notebookokat érő támadás visszaverésére elég lehet.

-

Abu85

HÁZIGAZDA

A Samsung 7 nm-es node-ja is jó, csak ugyanúgy drága, mint a TSMC-é.

5 nm-en inkább a TSMC tűnik kiemelkedően jónak. A többiek azzal küzdenek, hogy ilyen csíkszélességen már erőteljesebben kell alkalmazni az EUV-t, és erre egyszerűen nem készültek fel. A TSMC ott nyert baromira sokat, hogy nem várta meg az ASML pelluláit, hanem csinált magának, és ezzel hatalmas előnyre tett szert az EUV node-ok tekintetében. A Samsung itt hibázott, mert nem terveztek maguknak pellulát, hanem vártak az ASML-ét. A TSMC-vel most az ipar legalább 3-4 évig nem tud majd mit kezdeni, mert ugyan a gyártási problémákat lassan megoldja mindenki, de a TSMC már meg is oldotta, és így már nagy mennyiségben rendelhetik az EUV-s eszközöket. Az Intel itt a futottak még kategória, mert ők még egyetlen EUV-s gyártósort sem üzemeltetnek tömeggyártás szintjén, ellentétben a Samsunggal és a TSMC-vel. Tehát lesz egy rakás munkájuk a problémák megoldásával, de ezen a TSMC és a Samsung akkorra már rég túl lesz. Ettől függetlenül az Intel az IDM 2.0 miatt olcsón adhatja a wafert, amit az NV ki is használhat, de ez annyit is ér, mert ettől még 1-2 évvel lesznek a Samsung és a TSMC gyártási eljárásai mögött.

Az a gond az Intelnél, hogy nagyon jó dolgokat beszélnek magukról, de valójában meg sem közelítik jelenleg azt, amit a TSMC vagy éppen a Samsung tud biztosítani tömeggyártás szintjén. És a kulcsszó itt a tömeggyártás. Azért nyeri a TSMC és a Samsung a megrendelőket, mert nekik nem csak papíron működik a legmodernebb gyártástechnológiájuk. Nézd csak meg mit tud az Intel 10 nm-es node-ja az Ice Lake-SP-ben. Alig van megvásárolható új Xeon. Nem azért, mert nem gyártják, hanem azért, mert akkora lapkaméretben iszonyatosan sok selejtjük lesz. Pont ezért viszik a GPU-s projekteket bérgyártóhoz, pontosan tudják, hogy nagyon messze vannak a TSMC és a Samsung 7 nm-es node-jaitól. Ha nem így lenne, akkor házon belül gyártanának. Emiatt sem nagyon látom reálisnak, hogy az NV-t ez érdekelheti. Lehet, hogy van olyan olcsón kínált wafer, ami mellett megéri, de a technológiai előny a Samsungnál és a TSMC-nél van, és egy darabig még ott is marad. Az Intel is leghamarabb 5 nm-re ígérte a versenyképességet, ami a szokásos optimizmussal van kirántva.

-

Petykemano

veterán

Biztosan lesz ilyen.

Én valószínűnek tartom, hogy sem a zen4-ből sem az RDNA3-ból nem fog kimaradni a PCIE fölötti memóriakoherencia megvalósítása.

Szabványosan ez a CXL. Azt nem tudom, hogy IF-ot meg tudják-e valósítani úgy, hogy a szabványos PCIE csatlakozásokat és elektronikát használjákViszont a Raphael kódnevű fejlesztéshez az RDNA2 van feltüntetve.

Azért nem zárnám ki, hogy azért akkor és történetesen egyszerre jelennek meg, mert akkora lesz az AMD-nek kapacitása 5nm-re.

Lehet persze, hogy nem az lesz az első hozzáférés, de az első publikus. Tavaly nyáron volt pletyka arról, hogy az AMD 20000 wpm 5nm-es kapacitást foglalt. Az AMD két exascale szuperszámítógépben is benne van. Tehát azért nem zárnám ki, Genoa+CDNA2 azért pár nagy partnernek elérhető lesz 1-2 negyedévvel korábban is, míg mi fogyasztjuk a 7nm-es termékeket. -

Petykemano

veterán

> Szerintem Piacot akarnak, nem nyereséget egyelőre

Piacot akarnak - szerintem a szoftveres környezetüknek, nem a hardvernek.

Ez persze a lényegen nem változtat.> egyelőre azonban úgy néz ki új AMD GPU TSMC által 2022 Q4 ben tud jönni

Amúgy nehéz elhinni, hogy a következő néhány hónapban még jön az N23, majd biztos vmikor az N24 is - akkora már a Navi21 1 éves lesz - és aztán utána 1 évig semmi.

Persze ha így is mindent eladnak...

De épp ezért azt gondolnám, hogy a Navik kapcsán is lehet ugrás az N6-ra kihasználandó a nagyobb tranzisztorsűrűséget 15%-kal több eladást produkálhatnak. -

GeryFlash

veterán

Azert az komoly lenne ha az Intel jobb perf/wattot hozna Intel 10nm-en mint az Nvidia a Szarszung 8nm-en. Es nem az Nvidia sara lenne, tokeletesen arazna be az ocska Shitsung gyartosort, ahogy az most latszik a Snapdragon 888-nal is, soha nem volt meg ekkora a difi Snapi es Apple SOC kozott.

-

Petykemano

veterán

AdoredTV a pályafutását úgy kezdte, hogy nyilvánosan elérhető, mások által publikált információk alapján próbált spekulálni, következtetni. Ezeket általában senki nem kéri számon olyan keményen, hiszen bárki által elérhető információkból okoskodni bárki tud. Mindenki tisztában van vele, hogy az csupán egy vélemény.

AdoredTV-t szerintem az különbözteti meg a többi leakertől, hogy nem csak publikálta az általa talált vagy neki eljuttatott információkat, hanem a kezdeti szokását megtartva próbált spekulálni, következtetéseket levonni.

Én nem néztem át, hogy melyik "leaker"-nek pontosan milyen állításait vették szemügyre. És nem is kívánom magam beleásni. Viszont pár AdoredTV hozzászólás szembejött, amiben kritizálta a neki tulajdonított állítások összeállításának minőségét.

Pl:

Elhangzott:

"If the consoles are pulling 250W while gaming, Nvidia knows the RDNA2 on the desktop will be a furnace"

Ebből kivonatolt állítás:

"RDNA2 on desktop will be a furnace"

Ítélet:

false

[link]Én értem a logikát. Ha valaki azt mondja, hogy ha "ha elborul az ég, akkor esni fog", és végül nem borul el az ég, akkor az illető tévedett azzal kapcsolatban , hogy esni fog-e.

Pl:

Elhangzott:

"Zen X is a thing"

Ebbol kivonatolt állítás

zen X is a thing associated with zen 2

Ítélet:

false

[link]Szóval mert nem hamar következett be, már hamis állítás. AdoredTV nyilván csak kitalálta és sőt, talán az AMD-nek is csak onnan jött a Milan-X, illetve Vermeer-X elnevezés, ahogy mostanában a precíz és alapos leakerek nevezték ezt a fejlesztést.

Pl:

Elhangzott:

"If you have a 6C/12T part, you may as well make a 6C/6C part"

Ebbol kivonatolt állítás:

lesz 6C/6T sku

Ítélet:

false

[link]Nekem nem tűnik fair-nek minden egyes feltételes módban elhangzott mondatot végül igaztalannak bizonyuló "leaknek", vagy állításnak felfogni.

Amúgy a munkásságának csak egy részét képezték a szivárogtatott információk publikációja. A statisztikai és hírelemzői alapokon nyugvó "leleplező" videói szerintem hiányoznak a tech-közéletből.

-

Petykemano

veterán

> Szerintem alapvető lesz az Intel alacsonyabb árazása de ha van eszük nem most adják ki a

> kártyáikat AMD nézve még a 499$ alatti árazást sem tartom elképzelhetetlennek akár 399

> is 3070 teljesítménnyel.Nem teljesen értelek.

Ha most kiadnák a 3070-nek ekvivalens kártyát $399-ért, akkor az diszruptív lenne. (Tételezzük fel, hogy a bányászat által támasztott keresleti többlet lecsengett)

Ezt én is elvárnám és még akkor is jó lenne, ha csak akkor húzhatnád be a "kedvezményt", ha intel procit veszel mellé. (Figyelembe véve, hogy most a 6 magosok között inkább az intel procik olcsóbbak)De ha ez nem most, hanem kábé jövő év elején történik, az szerintem már nem lesz olyan egetrengető. Továbbra is tételezzük fel, hogy nincs bányászati keresleti többlet - akkor 9 hónap múlva amúgyis elvárt lenne, hogy a most még $480-499-ért adott ~3070 ára inkább már a $400 körül keringjen. Ez általában azért nagyjából be is szokott következni, a keresleti boom előtt az 5700/X ára is alacsonyabb volt már 10-20%-kal, mint rajtkor.

Egyébként abban igazad van, hogy a következő generációs konzol nagyon érdekes lesz.

Hogy az mikor lesz, az érdekes kérdés. Nem vagyok róla meggyőződve, hogy ez a konzolgeneráció is ki fog bírni 7 évet. mindenesetre következő körben lesz már 3 cpu+gpu alternativa -

tisztelturam

aktív tag

Pedig sajnos nem értelmetlen, hanem addig valós dolog amíg a bitcoin át nem áll majd energiazabáló bányász megoldásról másra.

Értem én hogy a technologia nem áll meg ,de itt tegye már fel a kezét aki leginkább a játék miatt akarna venni VGA-t. Vagy ha itt már mindenki csak bányászik akkor elnézést és nem szóltam. -

tisztelturam

aktív tag

Csak érteném mire fel ez a nagy "hurráhangulat" már most?

Ha ez a 3070-3080 szint igaz, akkor akár ha 200$ is lenne nem mindegy? A papír elbírná akár a 50$-os címkét is ha ugye nem jut hozzá aki játszani akarja majd megvenni.. Szóval az ár már kb 1.5 éve csak "fajlagos" Ez az intel VGA arra lesz jó hogy nézegessük a teszteket a neten majd a bányában használják őket, aki meg esetleg játékra tud majd szerezni azt a többiek a válukon viszik körbe a városban főleg ha "valós" áron és nem dupla-tripla áron szerezte -

Petykemano

veterán

Elvileg TSMC 6nm-en készül majd.

Kíváncsi lennék,

- vajon nagy volumenben gyártják- majd?

Ez nyilván rögtön az első hónapokban már látni fogjuk (vagy épp nem) a steam surveyben és/vagy a JPR riportban. Bár a volumen nagyobb részét biztosan mobil termékek teszik ki. Ha Elsőre nem is sikerül elvinni a perf/w koronát, azért talán 5-10-ot el lehet vinni a tortából 2-3 negyedév leforgása alatt. (Persze árukapcsolással többet is)

- és ha számmottevő volument gyártanak, akkor vajon azt ki elől veszik el? Látjuk, az AMD hogy küzd a waferért, és még Így is mennyivel kevesebbet tud eladni, mint az nvidia...Két megérzésem van

1.) Nem lesz különösebb árverseny, az Intel nem fog megmenteni minket. Szépen beáll a sorba és árukapcsolással fogja megoldani az eladásait. Közepes csalódás lesz: technológiailag középszerű, de első próbálkozásra elmegy, árban meg "meh", de legalább örüljünk, hogy bővült a kínálat.2.) Lesz ott még nagy kalamajka.

Bármilyen furán hangzik is, de szerintem a Samsung problémája az, hogy nem volt eddig olyan partnere, amelyik elég nagy volumenben gyártott volna high performance terméket. (Talán a samsungnak kellett volna felvásárolnia a GF-t)

Ebben az nvidia fog segíteni és ha nem pattan le az nvidia a következő körben akkor szerintem azt fogjuk taoasztalni, hogy javulnak a Samsung nodejai.Ha az Intel gpu sikeres, akkor viszont megeshet, hogy kiszorítja az AMD gpukat és az AMD kénytelen lesz a.gpu gyártást átvinni a samsunghoz.

-

Petykemano

veterán

Amellett, hogy az Elsőre 3080 behúzása hihetetlennek tűnik, azt is nézni kell, hogy ezt legkorábban 2021Q4 bejelentés és 2022Q1 elérhetőség mellett mondják. Addigra a 3080 már közel másfél éve lesz a piacon és azt várjuk majd, hogy 2-3 negyedéven belül 2.2-2.5x teljesítménybeli ugrást hajtanak végre (az nvidia és az amd)

A hatás ennél persze nagyobb lehet. Normál körülmények között addigra mindenki bávásárolt és már 10-15%-os akciókkal kéne kínálni a kártyákat. De mivel a kurrens generációból alig jutott játékosoknak, sokáig nagy lehet a kereslet. Sőt, ha addig még kitart az, hogy a gpukat 3x áron lehet kapni, és ezen enyhít az Intel szériája, akkor sokan fognak nagyon örülni.

-

Abu85

HÁZIGAZDA

A VRS-t többféleképpen lehet használni. Van neki egy Tier_1-es és egy Tier_2-es szintje. Ebben a játékban a Tier_1 van csak kihasználva, abban nincs sok lehetőség, ellenben fut az Intel IGP-in. És ez azoknál fontos, mert sokat jelent ám az előny. A Tier_2-es szint viszont nem fut az Intel IGP-ken (ilyen van egyébként a Gears 5-ben). Na most a Tier_2-es szintre lehet olyan megoldást csinálni, ami úgy növeli a teljesítményt, hogy nem csökkenti a képminőséget, de a Tier_1-es szint túl limitált ehhez. Az új RE-ben az lehetett a döntő, hogy a motor eleve marha gyors, ergo sokkal jobban számított, hogy az Intel IGP-i kapjanak egy kis boostot, minthogy a VGA-k 100 fps helyett 110-zel menjenek. Véleményem szerinte teljesen érthető döntés ez most.

-

gV

őstag

persze megérte beemelni a DX12U-ba csak azért nézd meg a TPU-s teszten, ha kicsit bele nagyítasz már látszik elég sokat ront a minőségen (pl. kanapé és alatta a csempe), nekem a VRS még mindig csak a 3DM-ban mutat jól (ellentétben az RT-vel és DLSS-el azok játékokban is rendben vannak).

-

AsakuraDave

őstag

RT GI, REFLECTION > RT SHADOW

De úgy eszméletlen szinten sokkal többet nyújt a másik két RT effekt és nem nem AMD miatt mert azokon "csak" RT SHADOW támogatott címek vannak én pl Cyberbe se kapcsolom be annyival is több FPS mivel látványba nem hoz semmit csak ha tényleg AZT figyelem míg a GI, Reflection eléggé szembetűnő változást nyújt.

De úgy eszméletlen szinten sokkal többet nyújt a másik két RT effekt és nem nem AMD miatt mert azokon "csak" RT SHADOW támogatott címek vannak én pl Cyberbe se kapcsolom be annyival is több FPS mivel látványba nem hoz semmit csak ha tényleg AZT figyelem míg a GI, Reflection eléggé szembetűnő változást nyújt. -

Abu85

HÁZIGAZDA

Érdekes. A Godfall esetében nem voltál ennyire kibékülve azzal, hogy messzire lőtték a sugarakat. Akkor baj volt vele. Most már megbékéltél ezzel is? Mert őszintén szólva szerintem, és tényleg csak szerintem, a Godfall pont elképesztően sokat profitálnak az Intel megoldásából. Gigabájtokban mérhető memóriát spórolnának vele, miközben a képminőség semmit sem romlana.

-

Abu85

HÁZIGAZDA

Tehát teljesen jó, hogy egy eljárás 3-7 GB VRAM-ot el tud pazarolni a semmiért? Oké, nincs több kérdésem.

Az a baj, hogy ez nem gyártói vita. Minden VGA be tudja szopni a 3-7 GB-os extra VRAM használatot, és az ezzel járó extra terhelést, méghozzá csak azért, mert szar a rendszer. És ha megnéznéd azt az előadást, akkor meg is értenéd, hogy miért. De ha azért nem vagy hajlandó megnézni, mert az Intel csinálta, akkor úgy alakítasz ki véleményt, hogy az API problémáit nem ismered.

Megjegyzem, az NV-nek is pont ugyanaz a véleménye, mint az Intelnek és az AMD-nek. A DXR aktuális állapota híg fos, mert őket is pont ugyanúgy érinti az extrém pazarló memóriahasználata, mint az Intelt és az AMD-t. Sőt, a GDDR6X miatt őket jobban érinti.

-

Abu85

HÁZIGAZDA

Sokkal olcsóbban lehet jobb GI-t csinálni. Lásd az Unreal Engine 5 Lumen megoldását. Annak van szüksége RT-s GI-ra, aki nem elég okos, hogy ezt a problémát az erőforrások töredékéből megoldja. Nem viccből nem használnak ilyet a modern motorok. Sokat zabál, és az alternatíváknál nem jobb. De persze, ha az erőforrásokat akarod pazarolni, akkor hajrá.

Pedig érdekelhetne, mert egészen jól elmondja az Intel, hogy miért fos most az RT. Csak egyszer nézd meg, és meg fogod érteni, hogy nem a hardver az oka, hanem az a pazarló munkavégzés, amire az API rákényszeríti a hardvert. Az Intel fel is vázolja, sőt, be is mutatja működés közben a megoldását.

-

Abu85

HÁZIGAZDA

Teljes körű RT van azokban is. A különbség, hogy a programozhatóságra van tervezve. Már elmondtam, hogy a traversal unit, ami hiányzik koncepció. Azért nincs benne, mert a traversal shaderrel használhatatlan. Nem lehet majd elérni a hardverben, ott fog porosodni a tranzisztorok között, egy hardveres /dev/null lesz.

Ugyanígy az Intelnek sem lesz fixfunkciós traversal unitja. Érdemes megnézni ezt az előadást. Nagyon jól bemutatja azt a gigantikus pazarlást, ami a gondot jelenti, ha a traversal lépcső nem programozható. Ha a pazarlást kilövöd a programozhatósággal, akkor sokkal több sebességet nyersz, mintha egy külön hardvert építenél a pazarlásra. [link]

-

Petykemano

veterán

JPU

Az nvidia eddig is készített SoC-okat arm cpuval. Most Fejből nem vágom, hogy custom design volt-e, vagy mindig arm CPU-kat használt.

A hír arról.szól, hogy az nvidia custom arm cput készít?

Mármint ha megveszik tényleg az armot, akkor ugye az is arm CPU lesz, vagy minden nvidia CPU lesz, de a lényege, hogy ellentétben a többivel, ez nem lesz licencelhető.Elég gyakori üzleti modell manapság, hogy van egy community verziója a terméknek, ami opensource, bárki megeshet benne hibát, bárki hozzájárulhat és használhatja is (bizonyos feltételek mellett), de az izgalmas részei fizetős szolgáltatási csomagban kaphatók.

Az Apple példája mutatja, hogy nem lehetetlen jobb cput készíteni, mint amit az arm, vagy az AMD/Intel kínál jelenleg az általuk elérhető gyártástechnológián.

Elég kulcs összetevő lett ez mostanság. A legújabb gyártástecnológiához való hozzáférés és a kapacitás. Aki kimarad, lemarad.

Azt mondják, az AMD részben azért is vette meg a xilinxet, mert így nagyobb szereplő a TSMC asztalánál és jobb feltételeket tud kicsikarni.Vajon lehet, hogy ez a megfejtés az nvidia arm felvásárlása mögött? Ugye abu szokta mondani, hogy az AMD nagyobb hal lett a tsmcnél, mint az nvidia, meg hogy az nvidia nem tud az AMD fölé ajánlani, stb

Lehet, hogy az arm azért kell az nvidiának, hogy ne szoruljon ki a.Legjobb gyártástechnológiákból? -

Abu85

HÁZIGAZDA

Az NV erre nem apellál. Ők a médiapistikkel ellentétben felfogják, hogy a Google számára a Stadia elképesztően kis költség. Ki vannak építve a peremhálózatra a szervereik, amikbe csak GPU-t raknak, és a szabad kapacitást használják a Stadiához. Az egésznek a lényege az, hogy elképesztően kevés extra fenntartási költséggel tudnak több pénzt visszatermelni a Stadia store-on keresztül. A Stadiának akkor lesz baja, ha a Google keresőszolgáltatása leáll, ugyanis akkor nem fognak kelleni a Stadiát működtető szerverek.

Ugyanez van a Microsoftnál és az Amazonnál is. A cloud gaming irányuk egy kiegészítés a meglévő szerverek szabad kapacitásának kihasználására. Költségben nem sok extrát visz, miközben a saját store-ral sokat hoz. -

Abu85

HÁZIGAZDA

Akkor nézd meg. Attól még nem lesz valami külső tér, mert a szabad ég alatt játszódik. Ezernyi trükk van, hogy épületekkel körbevedd a területet, és ezzel megteremted magadnak a zárt tér hatását.

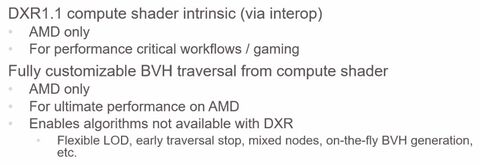

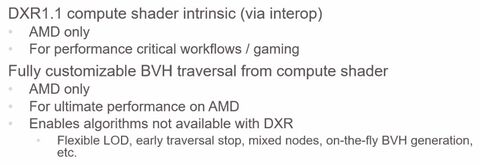

#42790 tisztelturam : Attól függ, hogy szabványosan lesz-e implementálva bele a sugárkövetés. A legtöbb játékban a DXR-rel van ez megoldva, de az AMD-nek van egy zárt kiterjesztése a DXR-hez, amivel olyan dolgokat is elérhetnek a fejlesztők, amelyek még nem részei a szabványnak. Minden esetben a Radeon Rays 4.0-t lehet meghívni, ez egészíti ki a szabványt. Ennek két külön módja van, amiről itt egy rövid leírás:

Ha utóbbi kerül egy játékba akkor kap egy külön dll-t, lásd a Godfallban az "amdrtshadow.dll", ebben vannak a szabványból hiányzó részek, például egyedi BVH bejárás. Ha így lesz implementálva a Resident Evil is, akkor azt az NV nem tudja majd futtatni, tehát kell nekik egy külön szabványos implementáció, ami megkerüli a binárisan szállított dll részét a játéknak.Szimpla API interop valószínűleg alkalmazva lesz, de az a jobbik eset, mert az csak intrinsic lehetőség, tehát maga a shader nagymértékben szabványos, csak vannak olyan részei, amelyek az AMD dizájnján meghívnak egy beépített függvényt, és akkor gyorsabban fut. Így van alkalmazva az RT a Dirt 5-ben és az új WoW: Shadowlands frissítésben. Ezeknél a kódoknál a beépített függvényeket az NV ugyan nem éri el, de elég könnyű kezelni ezt a problémát, mert csak írni kell rá pár extra shadert. Emiatt az RR 4.0 szimpla API interoppal nem akkora gond, mintha tényleg egyedi BVH bejárásra használná a Radeon Rays 4.0-t egy játék. Intrinsic lehetőségnél csak kismértékben kell módosítani a kódot, hogy szabványos szinten is fusson. A Godfall esetében azért marha sok munka volt teljesen eltérő LOD kezelést implementálni, mert a flexibilis LOD-ot a DXR nem kezeli, tehát kidolgoztak helyette egy DXR-rel kompatibilis sztochasztikus LOD eljárást. Ennek hasonló az eredménye a memória terhelésére vonatkozóan, csak többet számol, mint a flexibilis LOD.

#42791 huskydog17 : Semmiféle exkluzív szerződés nem volt. A Godfallba egy olyan algoritmus került eredetileg a bejárásra, amit a szabványos DirectX Raytracing nem támogat. Nem megvalósítható az aktuális specifikációkkal a flexibilis LOD. E mellé implementáltak a szabványos kódba egy sztochasztikus LOD eljárást, amit már megenged a DXR. A memóriaigény tekintetében a flexibilis és a sztochasztikus LOD hasonló, csak utóbbi eljárás elvégzéséhez többet kell számolni.

#42796 Locutus : Nem véletlen. A 8 GB-os VRAM igényt már nem egy játék meghaladta az Ampere kiadása előtt. Azóta csak nőttek a lehetőségek, így lassan meghaladtuk a 10 GB-ot is. Ezzel pokoli nehéz mit kezdeni, de ezért vannak a grafikai beállítások. Ha elfogy a memória, akkor lejjebb kell venni a grafikai részletességet. Régen is ez volt a megoldás, és ma is.

-

-

Abu85

HÁZIGAZDA

Nem a kizárólagosság a lényeg, hanem a pályadizájn kialakítása. Ezt leírtam neked először, hogy külső tereknél külön lehet arra dizájnolni, hogy belső tereknek megfelelő legyen a kialakítás. A CP2077 tipikusan ilyen játék. Egyedül akkor vannak dizájn szinten külső terek, amikor elhagyod a várost. Itt látszik is rajta, hogy az effektek nem működnek olyan jól.

-

Abu85

HÁZIGAZDA

Tudom miről beszélek. Arra próbálsz koncentrálni, hogy a játékmenet bizonyos százalékában találsz nyílt terepet, de nem ez a döntő tényező az effektek dizájnjának kialakításakor. Okkal néz ki a CP2077 zárt térben sokkal jobban, mint nyílt térben. Egyszerűen az effektek dizájnját zárt térre tervezték, és ez nem működik olyan jól nyílt térben. De ettől még vannak nyílt terek benne, csak nem ez volt a fókusz. A Godfall esetében pont ezek voltak fókuszban, mert arányaiban több nyílt térrel találkozik a játékos, mint zárttal. Emiatt a Godfall inkább zárt térben nem működik olyan jól.

-

Abu85

HÁZIGAZDA

Nem madártávlatra tervezik ezeket, hanem játékmenetre. A Cyberpunk 2077 nagy részében nem látsz el messzire, vagy zárt térben vagy, vagy megakadályozzák az épületek. A Godfall esetében nincsenek épületek, ott sűrűbben nagy a látótávolság. Más dolog az eltérő dizájnra effekteket tervezni. A Cyberpunk 2077 esetében tök reális lekorlátozni a sugárkövetés távolságát, mert a játékmenet nagy részében ezt nem veszed majd észre. A Godfall esetében nehezebb ügy. Alapvetően minden fejlesztő a korlátozást választaná, mert az csak egy napnyi munka. Senki sem szeret egy effektért fél évet dolgozni, de ritkán megteszik, ha nagyon fontos az effekt minősége. Ettől persze le lehet őket hurrogni, hogy miért optimalizálnak, de a saját idejüket lövik el erre.

-

Abu85

HÁZIGAZDA

A kép jól mutatja a dizájnt. Körül vagy véve az épületekkel, tehát nem kell túl messzire lőni a sugarakat. A Godfallban nem tudod körülvenni a játékteret épületekkel, nem a modern korban játszódik. Nem tudsz ilyen hatékonyan trükközni.

Nem számít a memória terhelésénél, hogy hány effektet futtatsz, mert mindegyik ugyanazokat a sugarakat használja. Nem fognak minden effekthez külön sugarakat kilőni. A memóriahasználat kizárólag attól függ, hogy mennyire messzire lövöd a sugarakat. És itt jön képbe a pályadizájn. A Godfall esetében is könnyebb lenne, ha nagy házakkal vehetnék körbe a játékteret, dehát...

És a Godfall is használhatna több effektet lényegében extra memóriaigény nélkül, de Unreal Engine 4-en fut, aminek a gyári SSR-je és SSAO-ja eleve nagyon jó.

-

Abu85

HÁZIGAZDA

Közel sem a végtelenbe számolnak. Egy játék három kategóriába eshet a pályadizájn tekintetében. Lehet a pályatervezés zárt, nyíltnak imitált zárt és nyílt. Az első kettő esetében reális dolog korlátoznia sugárkövetés távolságát, mert már maga a pályadizájn korlátozott. A Godfall esetében ez azért nem működne, mert a pályadizájn egészen nyílt, túl sokszor túl nagy terek vannak benne ahhoz, hogy jól működjön a jellemző limitálás. Emiatt választottak más módot, és nyilván nem jószántukból döntöttek így, mert nekik is sokkal egyszerűbb lett volna azt mondani, hogy a sugárkövetést tart 4 virtuális méterig és kész, mint konkrétan kidolgozni kétféle algoritmust, és elverni az egész probléma megoldáásra kb. fél évet. Ez tehát egy pályadizájnból eredő döntés. Más játékban, például a Cyberpunk 2077-ben nem feltétlenül ez a jó döntés, mert ott a városi nyílt terek is úgy vannak felépítve, hogy a lehető legtöbb oldalról körül vannak zárva. Természetesen ez egyszerűbbé tesz bizonyos fejlesztői döntéseket, csak egy Godfallban nem tudsz felhőkarcolókat felhúzni a játéktérbe.

Az RT teljesítmény játékfüggő.

Az optimalizáció azt jelenti, hogy egy problémára kitalálsz valami olyan megoldást, ami segít az erőforrás optimális használatában. Ezt tette a Godfall is. Az nem optimalizálás, hogy négy virtuális méterre korlátozod a sugarak távolságát, ilyenkor pont elkerülöd az optimalizálást, hiszen meghúzol egy olyan mesterséges limitet, amivel szükségtelenné válik az optimalizáció. Természetesen sokszor ennek is van értelme, de ahogy fentebb írtam, nehéz a nagyon nyílt dizájnú játékokra ezt ráhúzni, de persze nem mindegy, hogy fél évig optimalizálsz, vagy egy nap alatt limitálod a számítást. Ez is a fejlesztői döntések része.

Mindenki annyi VRAM-mal rendelkező VGA-t vesz, amennyit akar, de az világosan látszik, hogy ezek az új technológiák VRAM-zabálók.

Semmi gond nem volt az NV-nek a tesszellációs megoldásaival. Saját vásárlóikat szopatták meg vele, miután az AMD a meghajtóban kezelte a problémát. De a kettő nem ugyanaz. A tesszelláció esetében a problémát az jelentette, hogy felesleges volt egy pixelnél kisebb háromszögeket generálni, mert ugye a pixel a legkisebb elem, amit a monitor meg tud jeleníteni. Itt nem felesleges a sugárkövetés távolságát kitolni, mert észreveszed a 10-15 virtuális méterre lévő dolgokat is. De ugye akinek ez nem annyira fontos természetesen kikapcsolhatja az effektet.

-

Abu85

HÁZIGAZDA

A Godfall fejlesztőit lehet bántani, de tény, hogy ők az egyetlenek, akik szabványos kóddal raktak sztochasztikus LOD-ot a játékukba. Más erre sem veszi a fáradtságot, mert egyszerűen túl soknak tartják az ezzel járó bő négy hónapnyi munkát. Inkább lekorlátozzák a sugárkövetés távolságát, mert azzal is vissza lehet fogni a memóriahasználatot. Jelen pillanatban éppen azokat a fejlesztőket trágyázod, akik a piacon egyedüliként nem az egyszerű megoldást választották, nem a sugárkövetés távolságát limitálták, hanem igenis belefektettek egy rakás erőforrást, hogy más módon csökkentsék a memóriahasználatot. De eközben mindenki azért sír, hogy a PC-be nem fektetnek a fejlesztők semmi energiát. Hát persze, hogy nem. Beleölsz valamibe négy hónapot, és csak trágyázzák a megoldásod, amikor egy nap alatt meg tudnád oldani az effekt minőségének jelentős korlátozásával, amiért a userek simogatnak.

Hardveresen nincsenek igazán problémáin. Szoftveres tényezők hiányoznak. A traversal shader igazból bármilyen compute shadert támogató hardveren üzemképes. Az összes hardveres RT-t támogató rendszerrel kompatibilis, mert csak annyi történik, hogy a futószalag bejárás lépcsője nem egy specifikus hardveren fog működni, hanem a multiprocesszorokon, ugyanis programozhatóvá válik. Erre az AMD és az NV is tud meghajtókat írni, hiszen csak a futószalagot kell a multiprocesszoron futtatni, és kész, a shader fordítót kell kiegészíteni az új shader lépcsővel. Nem egy megoldhatatlan probléma, csak ki kell dolgozni a specifikációt.

-

Abu85

HÁZIGAZDA

Amíg nincs itt a traversal shader, addig az RT egy memóriazabáló technológia. Korábban leírtam, hogy miért. Egy sugár kilövésekor ki kell választani a LOD szintet, de előre nem tudod, hogy mennyire távoli lesz a metszés, tehát nem tudod meghatározni, hogy mi az optimális LOD szint. Ergo egyszerű megoldásként mindenre kiválasztod a LOD0-t, ami jókora extra információt jelent a VRAM-on belül. Egyedül a GodFall működik másképp, és jól jelzi, hogy mekkora nehézség ezt szabványosan megoldani, mert több hónapig csak ezt fejlesztették, hogy működjön a GeForce-okon. A Radeonokon ugye egy zárt kiterjesztést használnak, ami megengedi azt, hogy a sugár kilövése után LOD-ot válts. Ez lesz majd a traversal shader haszna szabványosan.

Amíg a játékok csak elsődleges sugarakat használnak, addig van koherencia, így a memória-sávszélesség nem akkora probléma, mert a memóriaelérések nem annyira véletlenszerűek. Ezek onnantól kezdenek el gondot okozni, ha vannak másodlagos sugarak is, azok már nem koherensek, és például a DXR 1.1 egyik visszalépése, hogy nem is tudod ezeket koherens csoportokba gyűjteni. De a Microosft mégis a DXR 1.1-re állt át, mert figyelembe vette, hogy ma még a másodlagos sugarakat nem igazán fontolják meg a fejlesztők, így a DXR 1.0 előnye hasztalan, és van egy rakás hátránya, amit a DXR 1.1-gyel megoldottak. Valószínű, hogy sem a DXR 1.0, sem a DXR 1.1 nem jelenti a jövőt, hiszen hosszabb távon azért erősen korlátozzák a lehetőségeket, de egyelőre nincs jobb megoldás.

Számítási kapacitás kell az RT-hez, de nem ez jelenti az erős limitet. Sokkal nagyobb baj, hogy nem tudsz LOD-ot váltani egy sugár kilövése után, így pedig akármilyen RT effektet írsz, az mindenképpen zabálni fogja a VRAM-ot.

A Resident Evilben többféle RT lesz. Pont emiatt lő ki a memória terhelése. Maga a motor eleve egy VRAM-zabáló szörnyeteg volt, ezt már a korábbi RE címekben is lehetett látni. 4K-ban RT nélkül is megette a 13 GB-ot. Ugyanez a motor lesz most is, csak átrakják a memóriakezelést az AMD-féle D3D12MA-ra, ezzel nyernek némi hatékonyságot, de nagyobbak lesznek a textúrák, amivel buknak is. Plusz mostantól az RT effektek jellemző +2 GB-ja is hozzájön. Értik, hogy kevés VGA-n van ennyi memória, de most ezzel mit kezdjenek? Annyit tudnak tenni, mint a korábbi RE címekben, lesz benne egy dinamikus textúraskálázás, hogy ha nem fér bele a VRAM-ba a highres textúra, akkor a motor azt érzékeli, és legközelebb már a medium vagy low részletességet tölti be, hogy spóroljon. Jelen pillanatban ez a reális megoldása a problémának, aztán idővel lesznek több VRAM-mal rendelkező VGA-k.

#42770 do3om : A memóriasávszél gond, ha egy játék másodlagos sugarakat is használ, hiszen ott véletlenszerű az elérés, tehát nem jól cache-elhető az információ. De ehhez muszáj másodlagos sugarakat is használni. Elsődleges sugarakkal marad a koherencia, tehát jól cache-selhető adatról van szó. Ezt korábban is leírtam. Az AMD számára az elsődleges sugarak megfelelőek, hiszen van a GPU-kban egy rakás cache, és úgy a sávszélesség 1,6+ TB/s. A másodlagos sugarakkal van gondban az RDNA2, de ezek pusztán a koherencia hiánya miatt eleve nem elterjedtek manapság a játékokban, mert a nagyon véletlenszerű adateléréshez nincs meg a kellő sávszél egyik mai hardveren sem.

-

gejala

őstag

Mindig épp az kell, amiben az AMD jobb. Pár éve ment a HBM őrület, hogy csak az a jó, aztán amióta AMD is GDDR6-t kezdett használni, senki meg se mer nyikkanni a témában.

Village meg továbbra is menni fog egy kenyérpirítón is, mint ahogy az összes eddigi RE Engine játék megy. Nálam 2080S-en RE3 1440p maxon 120 fps átlag körül száguld, ebbe simán belefér majd RT is DLSS nélkül is.

-

Abu85

HÁZIGAZDA

Nem kell ennyire parázni. Ez az AMD javaslata, ami marketing. A játék RT effektje bármilyen VGA-val jól fog futni, amin legalább van 12 GB VRAM. Persze nem biztos, hogy 4K-ban, ott 12 GB-nál több VRAM kell, de 1440p-ben bele lehet férni 11 GB-ba.

RT nélkül a VRAM-igény is 10 GB alá csökken.

-

Valdez

őstag

-

Valdez

őstag

Szerintem kiköthetik, ez nem magánszeméllyel kötött szerződés hanem cég-cég között kötött (nvidia mint gpu eladó és pl evga mint vga gyártó). Szerintem ki lehetne kötni szerződésben ezt, és azt is, hogy köteles a vevő cég jelentést készíteni (pl evga), hogy mennyi chipet (vga-t) mikor és hova értékesített. Már ha továbbra is akar az nv-től vásárolni persze. Mert nem kötelező gondolom.

-

huskydog17

addikt

Igen láttam ezeket, sajnos ez még rosszabb lesz.

-

Abu85

HÁZIGAZDA

A másik topikban belinkelt videódban látszik az eltérés több helyen is. [link]

A részletek a lényegesek, mert az árnyékok raszterizálás mellett az apró részletekben csúsznak el. Egyszerűen mag a raszterizálás nem igazán alkalmas a jó minőségű megvalósításra, a frustrum tracing pedig drágább eljárás, és konzervatív raszterizálást igényel.A videóban ezeket érdemes nézni:

- 1:20-21-nél a növény a két kép közepein. RT-vel a finom geometriákon is van árnyék. Ez általánosan is látható a fákon is. A háttérben látszódó kis épület is jobban van árnyékolva.

- 1:38-nál van a jelenetben egy rakás árnyék, és nagyon jól látszik, hogy RT nélkül mennyire erősen kell alkalmazni a lágy szélű árnyékolást. A valóságban ennyire gyorsan nem vesznek el a részletek, csak sokkal messzebb vetülő árnyéknál. Az RT-s megoldás megőrzi a részleteket, de mégis lágy szélű. Ez szintén megfigyelhető több helyen is.Ezek azok az apró problémák, amelyekre raszterizálással egyszerűen képtelenség reagálni. Trükközheted napestig, de sosem éred el azt a minőségi szintet, amit az RT shadows tud adni. Ráadásul utóbbit nagyságrendekkel egyszerűbb implementálni.

Ha messzire lövöd a sugarakat, akkor az kellemetlen a LOD számára. Az RT a jelenlegi specifikációban egy memóriazabáló dolog, hacsak nem maradsz nagyon a kamera közelében, de ezt a játékot nem úgy tervezték, hogy szűk terek legyenek benne, tehát nincs különösebb választás, muszáj sokáig lőni a sugarakat. Az más kérdés, hogy lehetne low szint is, ahova elég lehetne 1 GB VRAM is, azzal nem enne az effekt 3 GB-ot, de sokkal rosszabb is lenne a minősége, hiszen előtted jelenne meg pár méterre minden árnyék. Effektíve úgyis visszakapcsolnád a raszterizált verziót, mert az lehet, hogy nem kezeli jól az árnyékokat, de legalább nem csak a virtuálisan 4-5 méteres körzetedben lesznek láthatók.

Van a Godfallban teljesen dinamikus GI, a Sony-val közösen dolgozták ki az alapul szolgáló effektet. Az RT esetében az a lényeges kérdés, hogy meg tudod-e oldani a jó minőséget nélküle. Sok eljárásra meglehet, például GI-ra height field vagy distance field GI, visszaverődésre hibrid SSSR. De árnyékra sajnos nincs semmi értelmes megoldás.

-

Abu85

HÁZIGAZDA

Az AMD csak hozott pár jó döntést a múltban, és most úsznak az árral. Az NVIDIA is meghozhatta volna ugyanezeket a döntéseket, és ugyanúgy fordíthatnák az új pipeline-ra a régi shadereket.

Azért kevés cég optimalizál jobban PC-re, mint a Microsoft. Nem véletlenül fut elképesztően jól a Gears 5.

-

Abu85

HÁZIGAZDA

Ez mindig így volt, amíg egy új, de nagyon drágán hasznosítható technológiából csak a potenciális vásárlóbázis töredéke jut előnyhöz, addig nem is igazán piszkálják a fejlesztők. Vannak nagyobb gyorsulás biztosító, jóval olcsóbban beépíthető újítások. Ezeken lesz a fejlesztői fókusz. A VRS itt a fő irány mostanság. És már olyan formában is létezik, amihez nem kell VRS-t támogató hardver.

Szimplán compute shaderben le van implementálva. Az új Call of Duty ezt használja, és minden DirectX 12-es VGA-n megy.

Szimplán compute shaderben le van implementálva. Az új Call of Duty ezt használja, és minden DirectX 12-es VGA-n megy.Szorgalmazni lehet, de ha nem fizetnek százezer dollárnyi zsetont a kód karbantartására, akkor senki sem fog veszteséget bevállalni egy gyártóért. Egyszerűen nem jön ki pozitívra a mérleg, és így nincs értelme erre dolgozni. Gondolod véletlenül maradtak ki a mesh shaderek a PC-s portokból? Nem. Egyszerűen kurva drága beépíteni és karbantartani. Gondolkodj egy fejlesztő szemével. Van egy büdzsé gyorsítani a kódon valami új technológiával. A mesh shaderre írt culling a mai geometriai komplexitás mellett nagyjából képes eredményezni úgy 2-3%-nyi gyorsulást. Ezért +50 ezer sor beírása és költséges karbantartása kell. Ezzel szemben mondjuk a VRS képes biztosítani 5-15% közötti gyorsulást. Az implementációs költség a már elérhető kódoknak hála minimális, sokszor csak copy-paste az egész, és a karbantartási költség sem magas. Nyilván azt választják, ami olcsóbb és nagyobb gyorsulást hoz.

-

Abu85

HÁZIGAZDA

Alapvetően az AMD-nek mindegy, hogy van-e mesh shader egy játékban vagy nincs. A legacy kódokat mindenképpen szállítani kell, és azokból tudnak NGG módba fordítani az 5700-asokra is. Az RDNA 2 pedig megeszi a mesh shadert.

A fejlesztők számára nem kell az AMD kímélete. El tudják dönteni, hogy belefér-e +50 ezer sornyi kódot írni, és ezt folyamatosan karbantartani a vásárlóbázis maximum 10%-ára. Nyilván az AMD is átgondolta ezt a kérdést, és arra jutottak, hogy a magas költségeket figyelembe véve nem éri meg. Nem véletlenül tervezték úgy az RDNA2-t, hogy majdnem minden vertex és geometry shadert NGG-be fordítson a fordító. Ugyanígy gondolhatott volna erre az NVIDIA is. Egyébként létezik mesh shadert használó játék már. A Gears 5 Xbox Series S/X frissítése erre épít. Megvan írva a teljes kód, és azt se hozza át a Microsoft PC-re, mert jelentős többletköltsége lenne a support oldalán. Egyszerűen a vásárlókból nem termelik ki. Ehelyett olyan megoldásokat portolnak vissza PC-re, mint az új VRS. Az legalább a support költséget nem növeli jelentősen, és abból is lehet nyerni egy rakás teljesítményt. Talán többet is, mint a mesh shaderből, miközben a költségek szintjén olcsóbb. Persze a Microsoft igazán kinyithatná a pénztárcát a mesh shaderre, hiszen nagyságrendekkel nagyobb anyagi tartalékaik vannak, mint bárki másnak, de osztottak-szoroztak, és egyszerűen nem éri meg, még úgy sem, hogy a portolás copy-paste lenne.

A mesh shader akkor kezd majd igazán terjedni, amikor a vásárlóbázis 60%-a is el tudja majd érni. Addig igazából pénzkidobás fejlesztői szemmel. Nekem sem tetszik, de ez van. Némelyik fícsőr beépítése olcsó (például VRS), némelyiké pedig költséges.

-

Abu85

HÁZIGAZDA

Ezt valószínűleg az UL kérte, mert nem tudják befolyásolni a meghajtó működését, így a megfelelő százalékos gyorsulás kiértékeléséhez mindenképpen szükség van arra, hogy az AMD nem fordítsa a vertex/geomatry shadereket a mesh/primiive pipeline-ba. Ha megteszik, akkor a Radeonra nem tudja megmondani a tesztprogram a gyorsulás mértékét. Most, hogy kikapcsolták, meg tudja majd mondani. Nem kritikus fontosságú, de az UL számára fontos, mert ők képtelenek megkerülni a fordító működését. Csak az AMD tehet azért, hogy ez a teszt megfelelő értékeket adjon vissza a százalékos gyorsulásban. Az AMD ezt rohadtul leszarná, hiszen nekik aztán teljesen mindegy, hogy hány százalékot ír egy szintetikus teszt. Nekik a review policy-jük, hogy szintetikus teszteket senki se használjon. De nyilván meg tudják érteni, hogy az UL-nek ez bassza a csőrét, hiszen dolgoztak a programon, így átdolgozták a meghajtót, csak közben ez azért egy nehéz kérdés, mert az UL tiltja a 3DMark felismerését, tehát az AMD-t az egyik legfőbb szabály alól kellett felmenteni. Ez veszélyes az UL-nek, hiszen így az AMD-nek szabad a 3DMark felismerése, és manipulálhatják az alkalmazás futtatását, amit innentől folyamatosan ellenőriznie kell a finneknek, minden egyes kiadott Radeon driver után. Nekik sem lesz túl jó az élet innentől, havi két driverrel számolva, igencsak sok dolguk lesz.

-

AsakuraDave

őstag

[link] Ebben pedig azért látszik a különbség RT on/off -ban bár tény hogy ez a játék ezzel a nagyon ósdi third-person megoldással nem adja át a dolgokat egy sima TPS nézettel jobb lenne de ez szubjektiv.

A képek csalókák pl most Cyberpunk -ot kipróbáltam és tökre ledöbbentem hogy játék közbe mennyivel többet dob rajta az RT. Readás nem is a real time reflekciok hanem a lighting ami ebben a neon fényes városba teljesen átalakítja a környezetet. -

Devid_81

félisten

Viszont most a banyaszgepekbol kipotyogo hasznalt 3080/3090-esekkel erdemes lehet vigyazni.

Tobb honapos 100 fok + az biztos nem tesz majd jot ezeknek

Anno en akkor vettem az RX570-et amikor epp nagyon melyrepulesben volt az aruk, de meg volt belole mindenhol.

Kemeny £80 (32K) volt egy 3 honapot se hasznalt garis Gigabyte kartya, azota is megvan, bar az aztan jatekot se latott nagyon miota megvan, mert a felesegem gepeben van

-

Yutani

nagyúr

-

Devid_81

félisten

Nem is tudom kit tudnek hibaztatni itt.

A scalper ehen halna ha nem lenne olyan birka ami megveszi magasabb aron a cuccot toluk.

Szoval bele gondolva a legmelyere a user oldal fele billen a hulyeseg merlege, merre masfele?

Mekkora siras lesz kovetkezo generacional a penzbukasok miatt most, mar alig varom, hogy mehessek trollkodni kozejuk

-

#09256960

törölt tag

Megint egy termék ami drágább mint a Gamer GPUja és emiatt kiszorítja. Erre gondolsz ?

missing-chips-snarl-car-production-at-factories-worldwide -

AsakuraDave

őstag

Witcher 3 -mat ha akarod se tudod 1 nap alatt kitolni ezt meg fél nap se elvileg kitolni main szálon...

De mindegy itt próbáld bebizonyítani magadnak, hogy megért 20,000 forintot

De mindegy itt próbáld bebizonyítani magadnak, hogy megért 20,000 forintot

FC5 20k PC-re? Nem ilyen árra emlékszem de az FC3 óta nem veszem meg őket, az 5 -öt is nemrég vettem meg valami 2-3.000Ft -ért. Konzoloson sírás szerintem is szánalmas, bár vannak exkluziv címek amik 100x szebbek ennek a konzol verziojánál, persze mondom EXCLUSIVE címek. Csalódás a CP2077 még PC -n is, én sokkal többet vártam a srácoktól hisz már bizonyítottak, hogy tudnak k.va jót és maradandót alkotni. Witcher 3 -at se megjelenéskor vettem meg már bőven a Blood&Wine kieg után vettem GOTY kiadást. De persze modokkal toltam, HD Reworked Project nagyon sokat dob azért rajta, sok helyen elnagyolt textura van a játékba persze akkori hardveren így is épp hogy jól futott ha jól emlékszem. Meg egyébb sign effekteket tuningoló modok, 1-2 reshade proba de nem adta annyira, LOD itt is siralmas volt azért és sajna nekem a LOD modok nem akartak működni. Itt is a CP -be a LOD siralmas, 2D modellek és hogy látni, hogy hol spawnolnak be a modellek elég tré. Előbb legyen egy amíg a szem ellát LOD minthogy RT meg 8K texture mert hiába csilivili meg minden ha elötted 2m-re már minden statikus és low res, főleg egy ilyen játék ahol haladsz mész vezetsz nem a legjobb megoldás beáldozni az LOD -t arra, hogy szebb textura meg RT.

*szerk.:

RT -ből meg szerintem egyelőre elég lenne a reflection-öket erőltetni és erre találni egy módszert hogy minnél hatékonyabban lehessen futtatni mert ez k.va sokat tud dobni még a játékon. Bár ez is olyan, hogy pl Control -ba xartak SSR- ral megoldani a reflekciókat mert RT nélkül kb 0 van RT-vel meg persze le esik az állad de RT nélkül is lehetett volna kicsit gagyibban megoldani. Tök szép és jó dolog ez az RT csak akkor vagy RT -vel lesz csak szép és jó nélküle meg oda ültettek az utcáról egy kezdő fejlesztőt, hogy nah azért legyen benne RT nélkül is árnyék meg valami kis reflekció... -

Pahli

tag

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Gigabyte AORUS Radeon RX 6800 XT MASTER 16G

- GIGABYTE RTX 4070 12GB GDDR6X WINDFORCE OC Eladó!

- Gigabyte GTX 260 OC 896MB GDDR3 448 bit PCI-E videokártya -- augusztus 15.-ig jegelve!

- Készpénzes / Utalásos Videokártya és Hardver felvásárlás! Személyesen vagy Postával!

- 8GB-os RX570 - RX580-as VGA kártyák +1db RX 5500-as VGA eladóak

Állásajánlatok

Cég: FOTC

Város: Budapest

Ezért írtam azt, hogy a cikkíró jól kinézte magának a 8 magot és beírta a cikk címébe, aminek épp semmi értelme, mert az AMD Ryzen 7 1800X is 8 magos, de az nem elég a játéknak.

Ezért írtam azt, hogy a cikkíró jól kinézte magának a 8 magot és beírta a cikk címébe, aminek épp semmi értelme, mert az AMD Ryzen 7 1800X is 8 magos, de az nem elég a játéknak.![;]](http://cdn.rios.hu/dl/s/v1.gif)

Mondjuk a TSMC 6nm a 7nm half nodeja, nem tudom hogy így mennyi jut majd belőle.

Mondjuk a TSMC 6nm a 7nm half nodeja, nem tudom hogy így mennyi jut majd belőle.

Szimplán compute shaderben le van implementálva. Az új Call of Duty ezt használja, és minden DirectX 12-es VGA-n megy.

Szimplán compute shaderben le van implementálva. Az új Call of Duty ezt használja, és minden DirectX 12-es VGA-n megy.