Hirdetés

- sh4d0w: Kalózkodás. Kalózkodás?

- GoodSpeed: Kell-e manapság egérpad vagy sem?

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- Olcsó USB WiFi AC adapter

- sziku69: Szólánc.

- sziku69: Fűzzük össze a szavakat :)

- Luck Dragon: Asszociációs játék. :)

- eBay-es kütyük kis pénzért

- bambano: Bambanő háza tája

- Hieronymus: Kalózkodás. Kalózkodás? hozzászólás

-

LOGOUT

"A Proxmox Virtual Environment (röviden: Proxmox VE, PVE vagy proxmox) egy szerver virtualizációra optimalizált nyilt forráskódú Debian alapú Linux disztribúció. Lehetővé teszi a virtuális gépek és konténerek egyszerű telepítését és kezelését web konzol és command line felülettel. A programcsomag két LXC és OpenVZ konténerek, valamint a KVM alapú virtualizáció kezelését támogatja" (Wikipédia)

Hivatalos oldal: https://proxmox.com/en/

Hivatalos fórum: https://forum.proxmox.com/

Backup center, mail gateway, proxmox hypervisor és datacenter letöltés: https://enterprise.proxmox.com/iso/Véreshurka hozzászólásából

Új hozzászólás Aktív témák

-

J0shu4M1ll3r

senior tag

Sziasztok!

Windows 10 telepítése meoldható mentésről? Korábbi rendszerről csináltam mentést a windows belső biztonsági mentés funkciójával.

Elvileg akkor kellene egy virtuális meghajtó az installernek és egy a mentésnek? -

válasz

Kurrens

#3796

üzenetére

Kurrens

#3796

üzenetére

Szia!

Próbálj meg a 6.8.12-2-pve signed kernelre visszaállni:apt-get install proxmox-kernel-6.8.12-2-pve-signedproxmox-boot-tool kernel pin proxmox-kernel-6.8.12-2-pve-signedElvileg itt frissíti a grubot is. Kell egy reboot,

apt-get update && apt-get full-upgrade -yHa már nem akarod pin-elni, akkor:

proxmox-boot-tool kernel unpin -

Kurrens

tag

Sziasztok!

Múlt nyáron már összeraktam egyszer a Proxmox szerveremet, de aztán felhagytam vele. Most megint összeraktam. HA, Qbittorrent és fájlszerver van rajta. Teljesen jól működött, majd három nap múlva nem lehetett elérni a hálózat felől. Aztán pár nap múlva megint elérhető volt kb. egy napig, azóta meg nem (újraindítás sem volt hatásos). A router látja az ip címét (fix), pingelni is lehet, de a webui nem elérhető. A szerver a szokásos életjeleket adja, direktben be tudok lépni a parancssorba.

Mi lehet a probléma? -

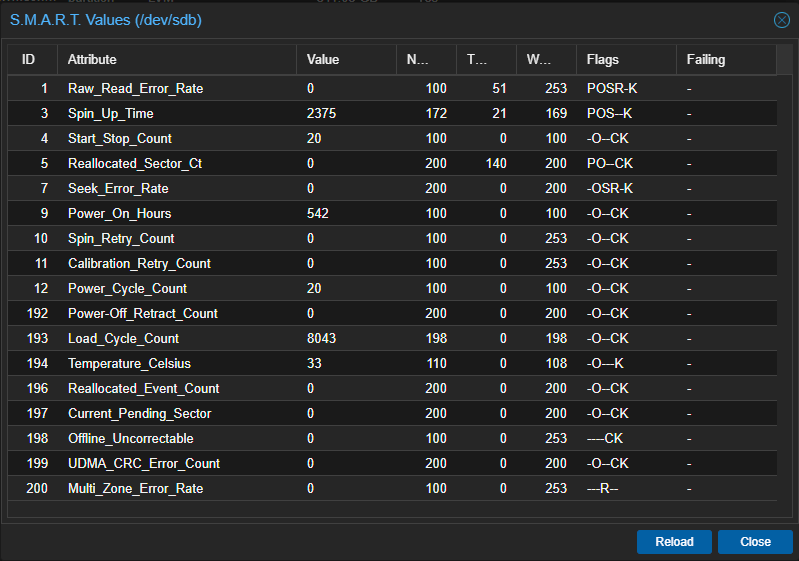

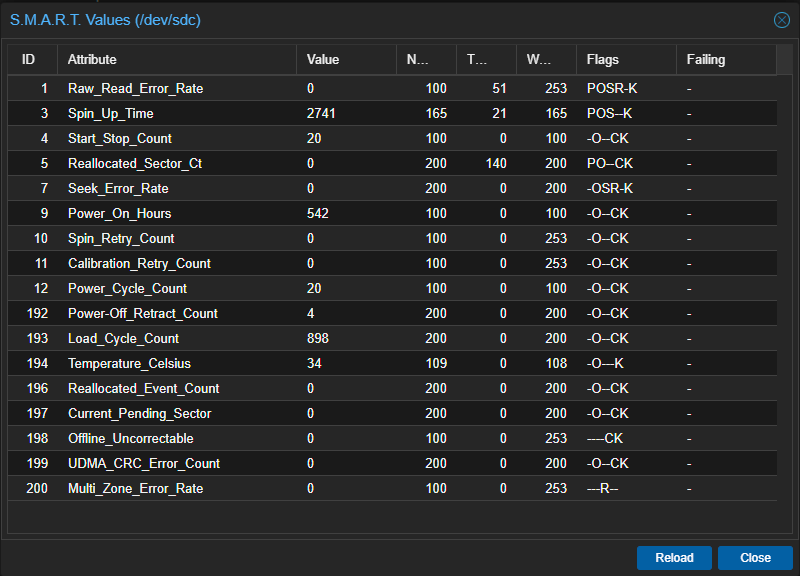

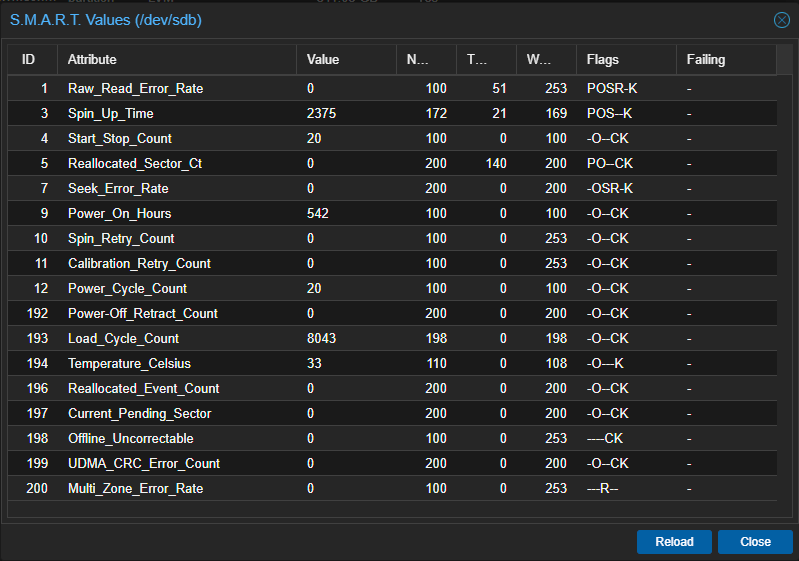

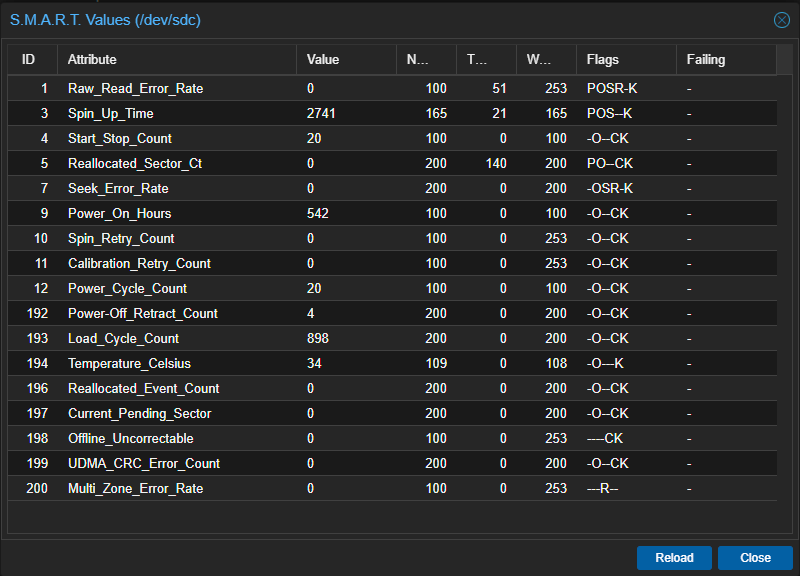

Az mitől lehet, hogy a nemrég bekerült 2*2TB HDD ZFS-ben (egyelőre felcsatolva sincs semmihez, nem volt még rá idő) közül az első folyamatosan parkoltatja és visszarakja a fejet? Csatolok képeket, hogy mire gondolok. Ilyenkor van is egy kis hangja, ami zavaró, na meg mivel használatban sincsen még kvázi így feleslegesen mozgatja a fejet. Keresgéltem de nem találtam még meg, hogy mi okozhatja. ZFS egyébként mirror-ban lett készítve.

-

-

válasz

tasiadam

#3791

üzenetére

tasiadam

#3791

üzenetére

igen, amikor felpakoltad, akkor az szerint csináltam, de most nagyon nem akarja, azért kerestem, h mit kellene.

Elírtam, a calibrate után is mehet a --html, akkor is lesz egy összefoglaló.Ha elcsendesedik a család, akkor reboot és bios piszkálás, mert a package C states is disabled, gondolom azért nem megy lejjebb a fogyasztás.

-

tasiadam:

összefoglalóban kellene kicsit kiegészíteni/javítani, ha lesz időd.powertop --auto-tunevagypowertop --auto-tune --html

(ez egy szép HTML fájlba menti a jelentést)

ha hibát dob, akkor indítsuk normál módon:powertop

Itt is látjuk, h milyen state-okba megy a proci, ven-e energiagazdálkodás a biosban letiltva, stb. Ha kell, akkor a biosban módosítsunk a beállításokon.

Az --auto-tune ha nem indul, akkor párszor futtasunkpowertop --calibrate

Ezután lehet újra próbálni az autotune-t, ha még most is bánatos, akkor reboot, calibrate és újra.A fentebbi hibakeresés miatt kikapcsoltam a biosban sok energiagazdálkodós cuccot, undervoltot kiszedtem, stb. a 34 W fogyasztás reinstall után 48-50 W-ra ugrott. Most autotune ezt levette 43 W-ra. Visszakapcsolom a biosban a spórolós cuccokat is.

#powertop #fogyasztás #idle

-

nem akarom elkiabálni, de talán megoldva a random mindentől elvágom a szervert probléma.

Van egy sorstárs a neten, aki végigszopkodta ezt, az akármi -4 kernellel nincs baja. Napok óta nekem sem. Minden -4 feletti, a 11 opt-in kernelekkel együtt problémás volt. Naponta ezzel foglalkozni... ehh... hátha ezzel kihúzza a következő nagyobb frissítésig. -

J0shu4M1ll3r

senior tag

Igazából ezek vannak most itt használaton kívül

Amúgy a rendszernek gondoltam egy külön meghajtót és a gépeknek. Nem állandó terhelés lenne, hanem több oprendszer, amikor épp kell, akkor használnám az adottat, viszont nem törölném őket, mert nem tudo mikor kellene megint.

Akkor lehet beruházok egy 512-es példányba és akkor az lesz a rendszer meg az iso részére, a 2tb meg a gépeknek.

Inkább szeretem túlmérni a dolgokat, minthogy állandóa fejlesszek és migráljak

Köszi a tanácsokat!!

-

-

a kérdés az volt, h elég-e a 128-as, nem az, h én hogy csinálnám...

Pl. iso-nak tök jó egy külső hdd, vagy pendrive. külső hdd-re meg mehet akár a proxmox mentése is, meg a vm backup, stb, aminek nem számít a sebesség.

külön drive azért jó, mert proxmox mentése gyorsabb, nem kell a vm-eket is menteni. Gyakorlás alatt a host mentése sem árthat, én mindent IS próbáltam rajta

jobb ssd többet bír, de hogy otthonra, gyakorlásra megéri-e, azt nem tudom megmondani. Nálam olyan szerény a terhelés, h inkább van tartalék ócó ssd. Mondjuk 2 tb még adata-ból sem olcsó. -

Magnat

veterán

Én mondjuk nvme ssd-n a rendszert sem tenném külön ssd-re, inkább vennék egyet, de akkor az legyen vmi pro széria, h jobban bírja a gyűrődést ... főleg tanulós gépen, de még élesen is

Btw, van az egyik munkahelyi gépemben 4db Samsung 850 Pro sata ssd, amik egy Exchange mailserverben voltak rendszer-, illetve adattárolók, a két 256-os 2400 napot ment és 33TB az összes írt adat rajtuk, ezek 100/77, illetve 100/79%-osak, az 512-esek 2037 napot mentek és 24TB az írt adat rajtuk, 100/98%-os mind a kettő.

-

válasz

J0shu4M1ll3r

#3782

üzenetére

J0shu4M1ll3r

#3782

üzenetére

Szia, rendszernek elég a 128as, ISO mehet máshova, pl. pendrive, vagy a VM mellé.

2tb rengeteg, nem tudom mi lesz a tanulós vason, de elfér...

Ha az írásokat kordában tartod, akkor nem vészesen csökken az élettartama. Ha sokat logolsz, akkor jobb a nagyobb ssd a rendszernek is, lassabban hal meg, de sztem a kis ssd olyan olcsók, h tökmindegy. Sebességben átlag user a sata-nvme sem érzi, de ha terheled, akkor az io előbb-utóbb limitálhat. -

J0shu4M1ll3r

senior tag

Sziasztok!

Tervezem a gépparkom csökkentését, és felmerült bennem, hogy átváltanék egy mini pc-re, amit amolyan tanulós / játszós gépnek használnék. Rendszernek lenne egy 128 gb nvme ssd (gen 3 x2) és a vm-eknek egy 2tb nvme ssd (gen 4 x4).

Kérdés: elég a 128 gb a rendszernek és az iso-knak vagy inkább valami nagyobb kellene, pl 256 vagy 512? Illetve van érezhető gyorsulás egy gen 3 vagy 4 és x2-x4 között? Vagy sata felett már mind1, hogy min van a rendszer? Mennyire amortizálja az ssd élettartamát?

Köszi! -

-

A PVE mentésre pattintottam be egy 250-es SSD-t, pont ma, felcsatoltam és pve-ben napi rendszerességgel állítottam be egy backupot a VM-ekről és LCX-ekről, ez nekem elég. A HDD(ke)-n csak a filmek lennének, amit egyrészt torrentkliens tölt oda és onnan az LCX-ek tudnak dolgozni belőle (samba, DLNA, ilyesmik), plusz a ZFS miatt (mirror) ha elszáll az egyik akkor menthető még az adat. Illetve majd a rendes gépemről akarom a fontosabb dolgokat a szerverre tükrözni, hogy több helyen meglegyenek.

Mappát parancssorból csináljak ZFS-rr, vagy pve-n belül van gyors és egyszerű megoldás rá? Tudom, IT-seknek a cmd is egyszerű, de én csak autodidakta és kérdezgetős módon tanulom ezeket a dolgokat

És próbálom meg is érteni amit csinálok, nem csak copy-paste módon létrehozni a dolgokat, így legalább tanulok

És próbálom meg is érteni amit csinálok, nem csak copy-paste módon létrehozni a dolgokat, így legalább tanulok

-

-

Szia(sztok)!

Ilyen tárhelymegosztást akkor is létre lehet hozni, ha ZFS-ben van két HDD? Próbálkoztam vele, de mivel fel van csatolva ZFS-ként pve-n belül így a datacenterben nem tudtam directory-ként már hozzáadni (vagy csak én vagyok a béna, ezt tartom valószínűbbnek )úgyhogy már az elején elakadtam

)úgyhogy már az elején elakadtam

-

-

és akkor megint csatt.

Vhogy a nic az utolsó üzi, majd reboot.

ovs bridge töröl, dual nic megy opnsense-nek, azon belül bridge (ez is megérne egy misét, h ez a része milyen retek).

egy nap és megint.... hmmm.

ismét a dual nic. A nagy optimalizálásban az energiagazdálkodásokat bekapcsoltam, igp alulfeszelve, stb.

Neten írták, h ez is lehet baj, 6.8 kernellel sokan szívnak.

ok, ezek is letiltva, csak a cpu maradt.

Hőfokok emelkedtek, frigate-val így a 32-35W felment 50 W-re...

12k körül lenne másik nic, de alig van, amire nem találtam valami panaszt. nem biztos,h érdemes cserélni. Hátha jön újabb kernel... -

Proxmox újrahúzva, stabil. ...még

Nem szórakoztam most a debian-ra telepítéssel, így lett LVM, de thin-t nem csináltam.

Elvileg ezt tudja a Clonezilla menteni, találtam egy fórum thread-et, ahol ezt tesztelik folyamatosan. Van pár hiba, de menti/helyreállítja. Azért nem lenne baj, ha lehetne telepítéskor is a systemd boot-ot és LVM mentességet választani.Single node finomhangolásnál pár service nem tűnik el, enabled marad.

Ezeket a

/etc/systemd/system/[servicename]

és a

/usr/lib/systemd/system/[servicename]

mappákból lehet törölni. [link]ZFS sincs, azokat is kitakarítottam...

Elvileg lehet finomhangolni még több dolgot is a /etc/sysctl.conf fájlban. Itt egy extra, még nem néztem végig, h mit állít át [link] , illetve itt is egy alaposabb írás: [link] , további itt: [link]

-

-

kutga

félisten

Hölgyek/Urak!

Meglévő Proxmox telepítés túlél vajon egy alaplap/cpu cserét?

-

-

nemurea

aktív tag

Bár nem teszteltem agyon, de nálam összejött az igpu passtrough, de csak a jellyfin-nek adtam transzkódolásra, az meg nagyon eseti téma, nem ilyen állandó, mint a frigate, szóval nem mérvadó ebben az esetben.

A dedikált VGA-val a fogyasztás lesz a probléma, már amennyiben az szempont Nálad.

A memória növelése jó ötlet.

-

PHenis

senior tag

Én qbittorrent lxc-vel jártam úgy hogy kimeredt tőle az egész proxmox felület. Nem fagyott meg mert elértem a webui-t csak nem töltődött be rendesen, teljesen szét volt esve, nem működtek a gombok, stop-olni is alig tudtam.

Nálam az volt a gond, hogy a lxc-nél a summary fülön hiába írja, hogy 120MB ramot használ, ha az lxc-n belül top-al nézem akkor 4,5 GB ramot foglal most. Míg a script alapértelmezett 2GB volt beállítva, neha így kifagyott félig amit fentebb írtam. Mióta több ramot kapott, egyszer sem volt ilyen hónapok óta.Nem pont ugyanaz a gond, de esetleg ideiglenesen meg lehetne próbálni több ramot adni a frigate-nak ha nincs jobb ötlet...

-

válasz

nemurea

#3763

üzenetére

nemurea

#3763

üzenetére

okkal, ezek szerint...

[link]

For the past four days I was playing with frigate installed in container in debian vm running on top of latest proxmox. I didn't had any issues with the two m.2 corals installed in my small server and their passthrough , but I had big problems with the passthrough of the igpu to be used for hardware acceleration of decoding the ffmpeg streams, also I had numerous freezes of the ethernet port, which to mitigate the issue had to disable offloading to the ethernet controller and this added more or less overhead to my cpu. Finally I went back to Debian on baremetal. Looks like Proxmox is still not good enough for passthrough of different hardware to the VM guest operating systems...Dettó ez van. Mi történne, ha vennék vmi régebbi PCIe VGA-t és ezt adnám a Frigate-nak, IGP-t nem?

-

Nah, nem oldódott meg, ma is volt fagyás...

Frigate LXC okozhatja ezt?

Visszakeresve kb. ezzel indultak a bajok.

Script telepítette, unprivileged és nem dockeres elvileg... Átadta az IGP-t.

OK, frigate doksiból:

Running Frigate in a VM on top of Proxmox, ESXi, Virtualbox, etc. is not recommended though some users have had success with Proxmox.

Ehh, gyanús, h ez a konténer mentes nagyszerű megoldás mégsem olyan nagyszerű

Várok pár napot, ha nem lesz fagyás, akkor erősen gyanúsan ez a hiba oka. -

PHenis

senior tag

A korábbi truenas vm-et lecseréltem egy ubuntu lxc-re mert kellett a ram más projekthez. Így a ~20 GB ram helyett meg vagyok 120MB-ból. Hát igen a ZFS... Meglepően egyszerű volt beállítani az nfs/samba share-ket és rsync taskokat. Bár nincs ssd cache meg ilyen huncutságok de rájöttem hogy, itthonra fölösleges nekem. Nincs semmi bajom csak meg akartam osztani

-

-

-

tasiadam

Topikgazda

updateltem a 2 képet, ami hibás volt, kiegészítve, hova kell kattintatni hozzá, és a paint segített ebben

-

-

nah, van itt minden...

bios update, korábbi kernel...

viszont feltűnt, h biosban alulfeszelve volt több dolog, pl. igp is. És a gondok kb. a frigate lxc-vel egyidősek, ami megkapta az igp-t asszem. Viszont akkor sűrűbben kellett volna meghalnia...

Mindegy, sokat nem jelentett, kiszedtem. -

A mostani is Intel, valamikor télen kezdődtek a bajok. Nem tudom a HW hibát kizárni, de a kernel is gyanús. Most kicsit visszalépek kernelben, hátha...

i340 van aprón, neten dícsérik ezt is, homelabba tökéletes. Nálam a PC-be megy egy kanóc, a modembe egy és az AP-ba. Szal. még bemelegedni sem tud, olyan szerény a terhelés. -

Nah, most volt a logokban egy kis infó, ezek szerint úgy tűnik, h az alaplapi LAN és a 2 portos kari fagyott először:

Mar 05 13:43:30 pve kernel: RIP: 0010:netif_set_real_num_rx_queues+0xa2/0xc0Mar 05 13:43:30 pve kernel: Code: 87 7c 89 35 00 41 83 e5 01 75 d1 ba ac 0b 00 00 48 c7 c6 94 53 6b 93 48 c7 c7 30 19 5d 93 c6 05 66 4f 70 01 01 e8 4e 2c 2b ff <0f> 0b eb ae b8 ea ff ff ff 31 d2 31 f6 31 ff c3 cc cc cc cc b8 eaMar 05 13:43:30 pve kernel: RSP: 0018:ffffaa6254f8fc50 EFLAGS: 00010246Mar 05 13:43:30 pve kernel: RAX: 0000000000000000 RBX: ffff95db0867c000 RCX: 0000000000000000Mar 05 13:43:30 pve kernel: RDX: 0000000000000000 RSI: 0000000000000000 RDI: 0000000000000000Mar 05 13:43:30 pve kernel: RBP: ffffaa6254f8fc68 R08: 0000000000000000 R09: 0000000000000000Mar 05 13:43:30 pve kernel: R10: 0000000000000000 R11: 0000000000000000 R12: 0000000000000008Mar 05 13:43:30 pve kernel: R13: 0000000000000000 R14: ffff95db0867c000 R15: 0000000000000000Mar 05 13:43:30 pve kernel: FS: 0000000000000000(0000) GS:ffff95e20ec00000(0000) knlGS:0000000000000000Mar 05 13:43:30 pve kernel: CS: 0010 DS: 0000 ES: 0000 CR0: 0000000080050033Mar 05 13:43:30 pve kernel: CR2: 000000c0001c1010 CR3: 0000000647238002 CR4: 00000000001726f0Mar 05 13:43:30 pve kernel: Call Trace:Mar 05 13:43:30 pve kernel: <TASK>Mar 05 13:43:30 pve kernel: ? show_regs+0x6c/0x80Mar 05 13:43:30 pve kernel: ? __warn+0x88/0x140Mar 05 13:43:30 pve kernel: ? netif_set_real_num_rx_queues+0xa2/0xc0Mar 05 13:43:30 pve kernel: ? report_bug+0x182/0x1b0Mar 05 13:43:30 pve kernel: ? handle_bug+0x6e/0xb0Mar 05 13:43:30 pve kernel: ? exc_invalid_op+0x18/0x80Mar 05 13:43:30 pve kernel: ? asm_exc_invalid_op+0x1b/0x20Mar 05 13:43:30 pve kernel: ? netif_set_real_num_rx_queues+0xa2/0xc0Mar 05 13:43:30 pve kernel: __igb_open+0x188/0x6d0 [igb]Mar 05 13:43:30 pve kernel: __igb_resume+0x252/0x2a0 [igb]Mar 05 13:43:30 pve kernel: ? __pfx_pci_pm_runtime_resume+0x10/0x10Mar 05 13:43:30 pve kernel: igb_runtime_resume+0x13/0x20 [igb]Mar 05 13:43:30 pve kernel: pci_pm_runtime_resume+0xa3/0x100Mar 05 13:43:30 pve kernel: __rpm_callback+0x50/0x170Mar 05 13:43:30 pve kernel: ? ktime_get_mono_fast_ns+0x43/0xe0Mar 05 13:43:30 pve kernel: rpm_callback+0x40/0x70Mar 05 13:43:30 pve kernel: ? __pfx_pci_pm_runtime_resume+0x10/0x10Mar 05 13:43:30 pve kernel: rpm_resume+0x4d5/0x6d0Mar 05 13:43:30 pve kernel: ? kfree+0x247/0x360Mar 05 13:43:30 pve kernel: pm_runtime_work+0x80/0xe0Mar 05 13:43:30 pve kernel: process_one_work+0x179/0x3c0Mar 05 13:43:30 pve kernel: worker_thread+0x2b8/0x3e0Mar 05 13:43:30 pve kernel: ? __pfx_worker_thread+0x10/0x10Mar 05 13:43:30 pve kernel: kthread+0xe4/0x110Mar 05 13:43:30 pve kernel: ? __pfx_kthread+0x10/0x10Mar 05 13:43:30 pve kernel: ret_from_fork+0x47/0x70Mar 05 13:43:30 pve kernel: ? __pfx_kthread+0x10/0x10Mar 05 13:43:30 pve kernel: ret_from_fork_asm+0x1a/0x30Mar 05 13:43:30 pve kernel: </TASK>Mar 05 13:43:30 pve kernel: ---[ end trace 0000000000000000 ]---Mar 05 13:43:34 pve kernel: igb 0000:04:00.0 enp4s0f0: igb: enp4s0f0 NIC Link is Up 1000 Mbps Full Duplex, Flow Control: RXMar 05 13:43:49 pve kernel: igb 0000:04:00.0 enp4s0f0: igb: enp4s0f0 NIC Link is DownMar 05 13:43:53 pve kernel: igb 0000:04:00.0 enp4s0f0: igb: enp4s0f0 NIC Link is Up 1000 Mbps Full Duplex, Flow Control: RX/TXMar 05 14:35:37 pve smartd[620]: Device: /dev/sdd [SAT], SMART Usage Attribute: 194 Temperature_Celsius changed from 71 to 70Mar 05 15:01:37 pve pvestatd[1183]: auth key pair too old, rotating..Mar 05 15:35:36 pve smartd[620]: Device: /dev/sdc [SAT], SMART Usage Attribute: 190 Airflow_Temperature_Cel changed from 72 to 71Mar 05 15:41:38 pve kernel: e1000e 0000:00:19.0 enp0s25: NIC Link is DownMar 05 15:41:38 pve kernel: vmbr0: port 1(enp0s25) entered disabled stateMar 05 15:42:03 pve kernel: e1000e 0000:00:19.0 enp0s25: PHY Wakeup cause - Link Status ChangeMar 05 15:42:06 pve kernel: e1000e 0000:00:19.0 enp0s25: NIC Link is Up 1000 Mbps Full Duplex, Flow Control: Rx/TxMar 05 15:42:06 pve kernel: vmbr0: port 1(enp0s25) entered blocking stateMar 05 15:42:06 pve kernel: vmbr0: port 1(enp0s25) entered forwarding stateMar 05 15:42:45 pve systemd-logind[621]: Power key pressed short.Mar 05 15:42:45 pve systemd-logind[621]: Powering off...Mar 05 15:42:45 pve systemd-logind[621]: System is powering down.Mar 05 15:42:45 pve systemd[1]: unattended-upgrades.service: Deactivated successfully.Csinálok ram tesztet, meg veszek vmi PCIe hálókarit, hátha...

Mik a tapasztalatok? A 4 portos aprósokból szabad válogatni?

Mi a minimum, problémamentes kari? Gigabit elég, gondoltam 2,5 nézek,

de mobilnet van és az AP sem tudja. -

-

PistiSan

addikt

Az összefogalóban lévő: "PVE Enterprise:"

Repo beállításhoz, tudnátok rakni a macskás kép helyett, valami olyat, ami segít a beállításban?

-

-

eddig folyamatos.

Maradjon is így

Nálam ha fagy, akkor inkább olyan, mintha a lan kábeleket kihúztam volna.

Jó hülye vagyok, h a zigbee-t nem teszteltem, legalább kiderült volna, h amúgy a VM-ek is fagytak-e vagy tényleg csak a 3 LAN port. Az a durva, h szépen pislákoltak a ződ fények rajtuk, alaplapin volt sárga + zöld is, ami a WAN portom. Mintha azok is működtek volna...Lehet kipróbálom,h a WAN-ból nem csinálok bridge-t, csak átadom az opnsense-nek, akkor kintről legalább látnám, h mi a bráner van ilyenkor.

-

van 2025-ös mikrokód frissítés, felpattintottam, hátha... majd kellene reboot is.

-

azt írják, h a bridge-nek is kell ez.

Futtattam, volt 2 vmi bekapcsolva, a többi offon. Meglátjuk mi lesz.

Azért fura, h mittomén 2 hónapja kezdte, előtte semmi.

Valamikor átállítottam a HA CPU-t host-ra, most keresem, h mire rakjam, x86-64 v3 elvileg jó, elindult. Flagokat belövöm, hátha...

Nested virtualisation flagot nem akarja, sebaj.

-

zoyoxy

tag

válasz

gyulavinwork

#3729

üzenetére

gyulavinwork

#3729

üzenetére

99%, hogy menni fog. Az 1%-ra meg ott van az incus, ezekre tuti megfelel.

-

-

kutga

félisten

-

kutga

félisten

válasz

soldi3r

#3380

üzenetére

soldi3r

#3380

üzenetére

Mostanában nem beszéltünk erről, de hétvégén én is összeraktam egy új szervert, PVE 8.3 alapon, és nálam is előjött ugyanez a probléma, samba lejátszás közben megszakad a hálózati kapcsolat a szerver és a kliens között, majd leáll a videó (TCL tévé, Kodi a lejátszó, wifi kapcsolaton keresztül).

Ránéztem gyorsan terminálban a szerverre, mutat-e valami hibaüzenetet, és ugyanaz fogadott, mint nálad:

e1000e 0000:00:19.0 <device name>: NETDEV WATCHDOG: CPU: 2: transmit queue 0 timed out XX ms. Ezt vasárnap eljátszotta kétszer napközben, és utána olvasva nem csak nálunk merült fel. [link]Ahogy néztem, főleg azt javasolták, hogy az

ethtoolalkalmazás használatával ki kell kapcsolani a hálózati csatolón ageneric-segmentation-offload, generic-receive-offload, tcp-segmentation-offload, tx-vlan-offload és rx-vlan-offloadfunkciókat, ezt meg is tettem az alábbi paranccsal:ethtool -K <device name> gso off gro off tso off tx off rx offAzóta nem tapasztalmtam hibát. Azt, hogy ezeknek a funkcióknak a kikapcsolása mennyire káros, sajnos nem tudom megítélni, de otthoni környezetben talán nem olyan nagy tragédia, nekem fontosabb, hogy stabil legyen a kapcsolat, mivel a router oprendszert is erre a gépre tettem. A héten, ha minden igaz kapok egy újabb kártyát (Intel I350-T2) a mostani Intel Pro/1000 PT helyett, ami már megérett a cserére, kíváncsi vagyok azzal előjön-e. Illetve ezt még be lehet írni az

/etc/network/interfacesfájlba, hogy megmaradjon újraindítás után is.post-up ethtool -K <device name> gso off gro off tso off tx off rx off -

gyulavinwork

friss újonc

Hello!

Köszönöm a gyors választ. Win. vm esetében windows servert (AD-val) próbálgatnék 2-3 windows/linux klienssel (ezeket csak időszakosan). Jelenleg VirtualBox-on teszem ezeket, egy jóval kevesebb erőforrással rendelkező gépen. Azért gondoltam a Proxmoxra, mert akkor, ha 0/24-ben menne (mini pc kevesebb fogyasztás) akkor működtetnék párhuzamosan pl. egy Plex-et, vagy valami más Média servert, torrent kliens-t, file servert, webservert, későbbiekben ezeket kívülről elérni megfelelő biztonsággal. Szóval tervek vannak... -

válasz

gyulavinwork

#3729

üzenetére

gyulavinwork

#3729

üzenetére

Szia!

A Proxmox is linux, valahol belül debian alapokon. Szal. kb. bármin elpöntyög...

Rákeresve iGPU Passthrough-al láttam pár topikot, hogy problémás (iGPU átadást nem is csinálnék, de kinek mi). Ami rizikós lehet még az a windows VM, nem tudom, h ezzel mi a cél. -

gyulavinwork

friss újonc

Segítséget szeretnék kérni. HomeLab servert szeretnék készíteni, és ez a mini PC-t néztem ki. AMD Ryzen 7 8845HS Mini PC--NucBox K8 Plus (RAM 32GB; 2TB nvme ssd) (későbbiekben bővíthető)

Kérdésem: Proxmox telepítése ütközhet problémába? (zen 4). Régebbi Ryzen proc.-al olvastam pozitív teszteket, láttam videókat. Van valakinek ezzel kapcsolatban tapasztalata. (windows-t, linuxot, media servert, stb. szeretnék virtualizálva futtatni) természetesen nem használnám játékra. Köszönöm. -

-

-

nemurea

aktív tag

Hm, vagy random hardver hibám van, esetleg tápellátás, vagy ez a kernel is okoz még hirtelen halált: Linux 6.8.12-8-pve on x86_64

Logokban semmi. De konkrétan semmi, üres. Érdekes amúgy, hogy most, resetgombos újraindítás előtt is volt még lemezaktivitás, legalábbis villogott a piros jelző, képernyőkép volt, egér mozgott, login-próbálkozásra kiírta hogy Auth error, de nem tudtam beleklikkelni a jelszó mezőbe. Hálózaton nem értem el a gépet. Szóval igazából olyan... autista vonások jellemezték.

Mar 01 21:31:44 pve anacron[3531969]: Anacron 2.3 started on 2025-03-01Mar 01 21:31:44 pve anacron[3531969]: Normal exit (0 jobs run)Mar 01 21:55:59 pve smartd[1062]: Device: /dev/sda [SAT], SMART Usage Attribute: 194 Temperature_Celsius changed from 24 to 25Mar 01 21:56:00 pve smartd[1062]: Device: /dev/sdc [SAT], SMART Usage Attribute: 194 Temperature_Celsius changed from 116 to 115Mar 01 22:25:59 pve smartd[1062]: Device: /dev/sda [SAT], SMART Usage Attribute: 194 Temperature_Celsius changed from 25 to 24-- Boot 40a5ed81f34446f88ca0e22010fdc09b --Mar 02 15:20:30 pve kernel: Linux version 6.8.12-8-pve (build@proxmox) (gcc (Debian 12.2.0-14) 12.2.0, GNU ld (GNU Binutils for Debian) 2.40) #1 SMP PREEMPT_DYNAMIC PMX 6.8.12-8 (2025-01-24T12:32Z) ()Mar 02 15:20:30 pve kernel: Command line: BOOT_IMAGE=/boot/vmlinuz-6.8.12-8-pve root=/dev/mapper/pve-root ro quiet intel_iommu=on iommu=pt usbhid.quirks=0x0463:0xffff:0x08 fsck.mode=force fsck.repair=yes -

válasz

chemand

#3723

üzenetére

chemand

#3723

üzenetére

szia, kulcsszavak: kereső itt, fstab, bind mount, pasthrough, samba.

1 oldallal feljebb összsze van szedve.

Ha a nextcloud lxc és a hdd-n már van adat, akkor pve alatt fstab csatolni, bind mount az lxc-nek a legegyszerűbb.

Ha elakadsz, itt vagyunk azért sokan, akik segítenek. -

chemand

aktív tag

Sziasztok!

Röviden annyit magamról, hogy több mint 30 éve érdekel (majdnem) minden az informatika világában. Mondhatom, hogy ez a hobbim, amit tudok azt mindent autodidakta módon tanultam meg. Mostanában kezdett el érdekelni a Proxmox, elsősorban azért, hogy egy helyre (egy gépre) költöztessem az eddig több eszközön lévő rendszereket/programokat (pl.: HA, Nextcloud, stb.) Pár napja egy viszonylag jól előkészített HP Elitedesken keztem próbálgani a Proxmoxot. Előtte azért sokat olvastam fórumokat, néztem YT videókat. A nagy problémám úgy tűnik az, hogy nincs (vagy inkább nagyon kevés) a linux ismeretem, ami azért igencsak kellene.

Kezdésként egy script és YT videó segítségével létrehoztam egy Nextcloud CT-t, ami alapvetően könnyű volt. Ez most egy nvme ssd-n van. Most azt szeretném megoldani, hogy Nextcloud a gépben lévő nagy kapacitású hdd-t használja majd a feltöltött adatok tárolására. Na... és itt kezdődnek a gondok, a linux ismeretek hiánya. Eddig mindent magam megtanultam, ezt is meg fogom. Azonban annyi segítséget kérnék, hogy milyen kulcsszavakra keressek, hogy megoldást találjak a fenti feladat megoldásához? Esetleg léteznek kezdők számára is érthető magyarázó oldalak, pl. blogok?

-

kutga

félisten

válasz

Balinov

#3716

üzenetére

Balinov

#3716

üzenetére

Mountolni ugyanúgy kell, mint OMV alatt, elkészíted a mount pointot, és fstab alatt csatolod. [link] Utána be tudod kapcsolni a sambát rá. [link]

A bind mount viszonylag egyszerű ez alapján a konténereknek ( [link] ), VM-ek alá meg szerintem a samba share-t lehetne felcsatolni ( [link] ). Esetleg még a jogosultságokat kell rendbe rakni.

-

tasiadam

Topikgazda

En hianyolom ezekbol a hypervisorokbol az ESXi-ben meglevo CPU es Ram overprovisiont. Pl siman csinalhattal 4 magbol 8-at. Oke, most is kioszthatsz 4 magnak 8 vCPU-nyi VM-et, de az megint mas, mint az ESXi megoldasa.

Ugye matek szerint adhatsz 8 darab 50%-os vCPU-t, de az ESXi azt dinamikusan kezeli. Veszi a 4 magot, osszeadja, es csinal belole 1 nagyot, es ezt osztja ki, de persze ugy, hogy nekunk mar nem kell matekoznunk vele.

-

tasiadam

Topikgazda

válasz

PistiSan

#3715

üzenetére

PistiSan

#3715

üzenetére

nálam a hdd-n telibe 1 vm van, és onnan osztom mindenkinek a sambat, windowsoknak, mindennek, aminek kell. Ha meghal a proxmox, bedugom, addolom és megy tovább. soloban 1 hdd, mert a torrenteken kívül minden backupolva van felhőbe.

Nincs passthru, mert ha meghal a vm alatta, a hdd oké hogy megmarad, de sokkal jobban akkor sem járok. de backup tekintetében nekem ez jó -

válasz

Pista0001

#3714

üzenetére

Pista0001

#3714

üzenetére

Amikor néztem, hogy lehetne VM alatt ZFS-t létrehozni, akkor olvastam a TrueNAS forumán, hogy csak a HBA átadás az, ami tényleg átadja a vezérlést a lemezek felett. A lemezek átadása nem, szemben pl a MIcrosoft Hyper-v megoldásával, ahol ha átadod a lemezt, akkor az tényleges.

Sajnos az ingyenes Hyper-v server 2019 frissítési ciklusa egy éve végetért. -

Pista0001

addikt

Ezzel szívok pont...

2 hdd-t adtam át az OMV vm-nek, amiket ott raid0-ba fűztem. Az OMV valamiért nem akar indulni, gondoltam semmi gond, átteszem másik linuxos gépbe, az felismeri a raid-et, le tudom másolni az adatokat. Hát nem. És gyanítom, hogy úgy se menne, ha a PVE alá tennék virtuálisan egy másik linuxot, és annak adnám ugyanazt a két hdd-t. Talán még adatvesztéssel is járna, de azért ezt még lehet hogy kipróbálom, ha nem sikerül az OMV vm-et feltámasztani.

-

Balinov

titán

egy parhuzamos univerzumban

az az erdendo gondom, hogy MSDOS/Windowson szocializalodott veglenykent teljesen biztosan alap dolgokkal nem vagyok tisztaban, igy lehet 1 dolgot 2- vagy tobb- felekeppen kerdezek, mikozben fogalmam sincs, hogy ugyanazt a dolgot hajkuraszom. YT videoert meg pirospont,

az az erdendo gondom, hogy MSDOS/Windowson szocializalodott veglenykent teljesen biztosan alap dolgokkal nem vagyok tisztaban, igy lehet 1 dolgot 2- vagy tobb- felekeppen kerdezek, mikozben fogalmam sincs, hogy ugyanazt a dolgot hajkuraszom. YT videoert meg pirospont,  viszonzasul egy kis YT csatorna ajanlo

viszonzasul egy kis YT csatorna ajanloAmugy tiszta szivbol irigylem a turelmedet, en munkahelyen a 3-ik magyarazat utan elkuldom a picsaba az ilyen kollegakat....

-

-

nemurea

aktív tag

válasz

Balinov

#3709

üzenetére

Balinov

#3709

üzenetére

No prob, érthető! Nekem is hosszú út ez a linux-tanulás és egy csomó része még mindig kínai...

Igen, a mount a pve shellből. Ha amúgy stabilan működik az OMV és a share, akkor nem lesz probléma megcsinálni. mount <mit> <hova>, a hova az magán a pve-n egy létező, üres könyvtár. Majd megnézed, milyen paraméterek szükségesek, ha szükségesek.

Az OMV+docker is egy jó út, egy csomó dologra megfelelő, sőt ahogy olvastam, az OMV alatt is megoldható a virtualizáció, tehát VM-ek készítése, vagyis nem is kell a proxmox. Ott a NAS-on van a hangsúly, a VM másodlagos (hegesztős), itt meg a VM-en van a hangsúly és a fileserver részt kellene belerakni. Ki mire használja.

-

Balinov

titán

válasz

nemurea

#3708

üzenetére

nemurea

#3708

üzenetére

Köszönöm szépen

igen, jól érted.

igen, jól érted. Z időzítés dolgot is jól látod, erre nem is gondoltam.

A mount parancsot talán meg tudom ugrani, gondolom a pve shellbol kell majd futtatni. A hszed majd 7 végén többször atolvasom, hogy jól értem-e, megegyszer köszi

A Nas vm is jogos, ha nem lennék ilyen kiserletezo, valszeg a pve helyett baremetal menne az omv és dockereznek amit lehet, csak az a rohadt kíváncsiság /tudasvagy ugye..

meg azért nem hátrány ha valamit elszabok akkor viszonylag büntetlenül tudok kísérletezni....

meg azért nem hátrány ha valamit elszabok akkor viszonylag büntetlenül tudok kísérletezni.... -

nemurea

aktív tag

válasz

Balinov

#3707

üzenetére

Balinov

#3707

üzenetére

A többiek majd finomhangolják a dolgot, ha butaságot írnék, de ha jól értem:

A share-t magát a VM-ben futó OMV szolgáltatja,

Ezt a share-t akarod a pve-be, tehát a host-ba az fstab-ba beleírni, hogy a pve maga is elérje, hogy aztán továbbadhassa más LXC-knek?Szerintem alapesetben így kellene megtenned, ahogy írod, az fstab-ba, ha nem ilyen hipervisor-os cuccról lenne szó, de ebben a konkrét esetben, amikor a pve boot-ol, és az fstab lefut, még híre-hamva nincs a VM-ek indulásának, és így az OMV-nek, tehát a share-nek sem. Ha jól gondolom.

Szóval ehelyett amit rövid távon tennék: ha már felállt a rendszer, van VM, OMV, share, minden, akkor a pve-ben egy mount paranccsal csatolnám fel egy mappába a share-t, és onnantól ugyanaz. Az LXC-k kaphatnak majd innen mappát.

Ezt a mount parancsot, ha beválik, bele is tudod tenni a crontab-ba, ez nagyon egyszerű, majd segítek, ott lehet a boot-hoz képest késleltetni a parancs lefutását.

Szerk: miért is lamantáltam egy napja, hogy nem javaslom a NAS funkciókat VM-be kiszervezni?

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Balinov

titán

Sracok, megint en vagyok.

Par dolog. visszaolvastam tomigonzo kerdeskoret, sok hasznos dolgot tanultam, koszi mindenkinek!

Meg mindig az OMV VM ala felcsatolassal kuzdok, ez az egesz mp, bindmount, fstab eddig teljesen kinai volt,de most olvasgatom a PMS telepitesi utmtatojat es a tech resze felhomalyositott par dolgot, remelem.

Szoval, ha a VM SMB share-jat mas VM-ek/LXC-kkel is szeretnem hasznalni, es a VM ala a partuuid 4f9e803c-ff23-bf44-99bb-574d46718950 van felcsatolva, akkor a PVE hoston a shellben az etc/fstab-ban valami ilyesmi bejegyzest kene letrehozniL:

# <device> <dir> <type> <options> <dump> <fsck>

UUID=94649E22649E06E0/srv/dev-disk-by-uuid-a5ec2c50-7587-4cea-9c77-99d17250f7da/data/media defaults,bind 0 0az SRV/devxxxx az az OMV-ben az absolute path.

Ha ez megvan, akkor PVE shell-bol pct set vm/lxc id -mp0/1/akrmi + kivant path az uj vm/lxc-ben paranccsal "konnyeden" fel tudom a samba share-t csatolni?

Rohadtul szeretnem mar ezt megerteni, vegerejarni az egesz altemanak, mivel nem vagyom a linux alapokat, ez konkretan gatol, hogy par dolgot kiprobalak PVE alatt.

Az fstab-os syntaxo-t az ArchWiki fstab oldalarol neztem ki, 3.7/Bind Mount

A jelenlegi pve fstab igy nez ki

# <file system> <mount point> <type> <options> <dump> <pass>

/dev/pve/root / ext4 errors=remount-ro 0 1

UUID=3845-3372 /boot/efi vfat defaults 0 1

/dev/pve/swap none swap sw 0 0

proc /proc proc defaults 0 0Ebbe kene azt az 1 nyamvadt sort behegeszteni a megfelelo mappanevekkel?

Koszi a turelmeteket!

Bali

-

MasterHUn

senior tag

Sziasztok, adott egy proxmox vm.

4mag 8gb ram, 50gb lvm disk.

Nincs mögötte snapshot, backup. lsblk 1 disket lát. Amikor megpóbálom RAW-ba kimenteni a meghajtót, hogy tudjak belőle vmdk-t csinálni. 250gb ra olvassa fel a VM-et. csináltam máűr több migrálást, de ez a Vm szivat. 238gb.-os külső hdd-re nem tudom kimenteni, leállítani a proxmox-ot pedig nem lehet.

Ötlet tanács?

-

tomigonzo

aktív tag

válasz

nemurea

#3694

üzenetére

nemurea

#3694

üzenetére

Igen azt mar en is realizaltam/osszeraktam magamban (jol atgondoltam amiket irtatok

), hogy eloszor egy lxc-bol a pve-re kell mountolni a mappat amit szeretnek, aztan a pve-bol pedig felmountotlni a masik lxc-be.

), hogy eloszor egy lxc-bol a pve-re kell mountolni a mappat amit szeretnek, aztan a pve-bol pedig felmountotlni a masik lxc-be.

@ViZion : az is megvan hogy tobb tobb tarhelyet is le tudok osztani egy adott lxc-nek

@nemurea: nem eufemizmus

de nem a transmission/barmeluik torrent letoltot szeretnem 'bekotni' a plex ala, van erre mar sokkal komplexebb (kenyelmesebb, biztonsagosabb,

de nem a transmission/barmeluik torrent letoltot szeretnem 'bekotni' a plex ala, van erre mar sokkal komplexebb (kenyelmesebb, biztonsagosabb,  ) megoldas, ha erdekel irj ram privatban

) megoldas, ha erdekel irj ram privatban -

Balinov

titán

bocsi, hulye vagyok meg tegnap este agyilag zokni. az elso screen shot az az OMV VM-rol keszult, annak at van teljesen adva az 1TB. A masodik az nem az extra VM-rol van, egy debian alapu LXC amit az arr stacknak csinaltam meg multkor, csak nem esett le, hogy az nem VM ikon, mikor irtam

a jelenlegi VM-nek a PVE shell-ben kiadott kovetkezo paranccsal adtam hozza a tarhelyet

qm set 100 -sata1 /dev/disk/by-partuuid/4f9e803c-ff23-bf44-99bb-574d46718950

Ez lenne a passthru?Bali

-

válasz

tasiadam

#3699

üzenetére

tasiadam

#3699

üzenetére

Ha már debianra épül a Proxmox, akkor a NAS funkió tud mellette futni natívan a rendszeren, és csak a többi funkció van virtualizálva. Mondjuk én is VM-ben futtatom a XigmaNAS-t, de nem tetszik, hogy Proxmox ZFS-én csináltam még egy UFS fileredszert.

Sajnos natívan nem tudtam átadni a HBA-t valamiért nem működött, el sem indult a WM, a lemezek egyenkénti átadása meg azért nem sikerült, mert a lemez tipuszáma tartalmaz egy pontot. Mondjuk a lemez átadás sem teljes, mert azon is van egy virtuális réteg. Kb. olyan, mintha a vezérlő RAID módban van és egy lemezes JBOD-ban adja át a lemezeket.

Új hozzászólás Aktív témák

- Veszélyben vannak az adataid? Gond van a WD népszerű HDD-ivel

- Robotporszívók

- Path of Exile (ARPG)

- sh4d0w: Kalózkodás. Kalózkodás?

- exHWSW - Értünk mindenhez IS

- Építő/felújító topik

- BestBuy topik

- GoodSpeed: Kell-e manapság egérpad vagy sem?

- Anime filmek és sorozatok

- Android alkalmazások - szoftver kibeszélő topik

- További aktív témák...

- HIBÁTLAN iPhone 12 Mini 64GB Purple -1 ÉV GARANCIA - Kártyafüggetlen, MS3481,96% Akkumulátor

- Telenor 5G Indoor WiFi Router (FA7550) + töltő

- Eladó Samsung Galaxy S22 8/128GB / 12 hó jótállás

- Gamer PC-Számítógép! Csere-Beszámítás! Ryzen 7 3700X / RTX 2070 Super / 32GB DDR4

- Bomba ár! Dell Latitude 5300 - i5-8GEN I 8GB I 256SSD I 13,3" I HDMI I Cam I W11 I Gari!

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: NetGo.hu Kft.

Város: Gödöllő

És próbálom meg is érteni amit csinálok, nem csak copy-paste módon létrehozni a dolgokat, így legalább tanulok

És próbálom meg is érteni amit csinálok, nem csak copy-paste módon létrehozni a dolgokat, így legalább tanulok

ezekre gondolok a tünetekből.

ezekre gondolok a tünetekből.

![;]](http://cdn.rios.hu/dl/s/v1.gif)