Hirdetés

- Luck Dragon: Asszociációs játék. :)

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- sziku69: Szólánc.

- Rap, Hip-hop 90'

- Sub-ZeRo: Euro Truck Simulator 2 & American Truck Simulator 1 (esetleg 2 majd, ha lesz) :)

- f(x)=exp(x): A laposföld elmebaj: Vissza a jövőbe!

- Brogyi: CTEK akkumulátor töltő és másolatai

- GoodSpeed: A RAM-válság és annak lehetséges hatásai

- GoodSpeed: Márkaváltás sok-sok év után

- sziku69: Fűzzük össze a szavakat :)

-

LOGOUT

"A Proxmox Virtual Environment (röviden: Proxmox VE, PVE vagy proxmox) egy szerver virtualizációra optimalizált nyilt forráskódú Debian alapú Linux disztribúció. Lehetővé teszi a virtuális gépek és konténerek egyszerű telepítését és kezelését web konzol és command line felülettel. A programcsomag két LXC és OpenVZ konténerek, valamint a KVM alapú virtualizáció kezelését támogatja" (Wikipédia)

Hivatalos oldal: https://proxmox.com/en/

Hivatalos fórum: https://forum.proxmox.com/

Backup center, mail gateway, proxmox hypervisor és datacenter letöltés: https://enterprise.proxmox.com/iso/Véreshurka hozzászólásából

Új hozzászólás Aktív témák

-

paizinho

tag

Köszönöm a felajánlást

, segítséget, elemzést. A gmail reg még nem elég, az csak az alap. Az ingyenes nekem is vegyes eredményeket hozott. Volt amiben a ChatGPT4 (volt akkor még) volt a jobb.

, segítséget, elemzést. A gmail reg még nem elég, az csak az alap. Az ingyenes nekem is vegyes eredményeket hozott. Volt amiben a ChatGPT4 (volt akkor még) volt a jobb.

Szerintem az asszonyét próbáld ki Deep search-ben a különböző AI forrásokkal. A Comet böngésző is jól jöhet.

Én erősen AI prompt tanuló fázisban vagyok. Az AI-kkal is úgy vagyok, mint a human részleggel : meg kell tanulni jól kérdezni, hogy minőségi, tartalmas választ kapjak. Szerintem erre a kísérletezésre, tesztelésre jó a pár száz forintos beruházás .

.

Nekem ZFS, Snapraid+MergerFS témában jelentősen lerövidítette a régóta tologatott információhiányom megszűntetését. De minden infot mérlegelek, főleg amiben azt gondolom van erős hátterem.

De befejezem, mert a végén azt hiszitek Perplexity ügynök vagyok , pedig már nézegetem a NotebookLM, Gemini3-t is. És még a topikgazda is kopogtathat a fejemen.

, pedig már nézegetem a NotebookLM, Gemini3-t is. És még a topikgazda is kopogtathat a fejemen.

Köszönöm a türelmeteket, segítségeket!

-

paizinho

tag

Szia Vizion!

Köszönöm a tippet. , nyert!

, nyert!

Nemrég vettem ezt a kis Chuwi Ubox-t, amit beraktam 0-24-be.

A BIOS-ban csak így második körre találtam meg, az IGP 3GB-ra volt állítva. Most egyelőre 512MB-ra tettem és máris megugrott a Proxmox RAM.

Az AI témához csak annyit, hogy a Perplexity-t érdemes lenne megnéznetek. Ez a AI-k keresője és folyamatosan "scan-eli" a netet, nem statikus adatokkal dolgozik.

Pro verzióban választhatsz Deepsearch-höz : ChatGPT 5.1-t, Gemini, Cloude, Deepseek, ..

A Pro verzió az Allegro-n 650 Ft / év (!!!), nem megújuló. Én ezzel kísérletezem mostanság. Bízom benne tudtam én is egy kicsit segíteni. -

-

Szia,

Na en meg most olvasom, bocs

A VM-ek meg a proxmox meg minden is 1 db SATA SSD-n vannak.

Tehat az !TB SATA-rol klonoznek a 2TB nvme-re, majd kiterjsztenek.Utana bemenne a 4TB-os SATA SSD, es arra atmennenek a VM-ek Proxmoxon belulrol mar.

Sokan mondjak, hogy rakjam ki a VM-eket kulon SSD-re, es turjam le magat a Proxmoxot hogy friss legyen, de nem latom ertelmet. Szervert nem szoktunk ujratelepiteni.

-

Na nálam egy db 1 TB MVE ssd van benne, azon van a rendszer és minden.

Van még benne 4x4 TB HDD is, de az vezérlőstől át van adva a Xigmanasnak.

Akkor szereznem kell valami külső tárat amire megcsinálom a biztonsági mentést.

A VM-ekről csinálok rendszeresen backupot, mielött jön valami upgrade és upgrade után is, csak a rendszerről nincs semmi. -

Balinov

titán

hat ezaz, bacca meg! amikor disk passthru-t csinaltam PVE alatt erdedileg az OMV VM-nek uuid-vel csinaltam es mukodott honapokig, aztan ugye elbasztam az egesz omv vm-et, ujra fel kellett huzni, mindenestol beallitani 0-rol, akkor is ugyanazzal az uuid modszerrel csinaltam, meg a regi fajl/konyvtartstrukrurat sem szabtam el. IGPU pass eltavolitasa megis osszefosott mindent

ujabb tanulsag, legkozelebb erre is figyelnem kell (mer hogy tuti lesz legkozelebb az fix, ezert is jo a PVE, mert majd' buntetlenul garazdalkodhatok)

Ugyanitt kerdezem, hogyha az OMV7-t csak SMB share-ra hasznalnam mi az a minimum VM disk size, ram/cpu beallitas, ami ajanlott ? jelenleg van 4 mag/8gb meg 64GB VM disk, ilyen 2mag/2,max 4GB meg mondjuk 8GB VM disk eleg?

udv

Bali -

-

-

danih

veterán

Jó kis app, én sokat használom főként apróbb (egylépéses, amolyan "ha ez, akkor az történjen") típusú automatizációra - még a mobilon elérhető kis dashboardomra is raktam ikonokat, amit ha megnyomok, elindít/újraindít/megállít valamit proxmoxon vagy dockerben.

Sok messaging platformot is támogat, tehát küldethetsz magadnak üzit hogy pl "nincs áram baszki és merül az akksi, verem is le a szerót 30 mp múlva!"

-

danih

veterán

-

Gabesz87

veterán

Igen, ezt a címet írtam be böngészőbe.

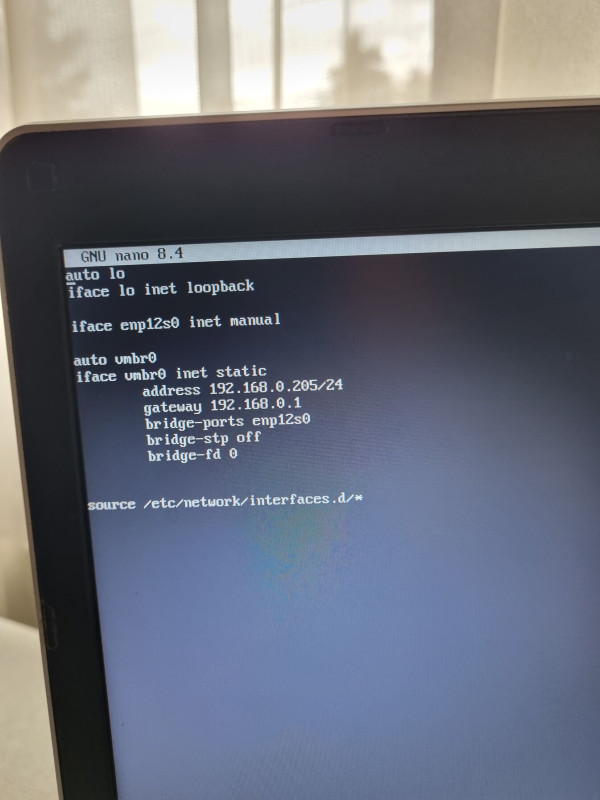

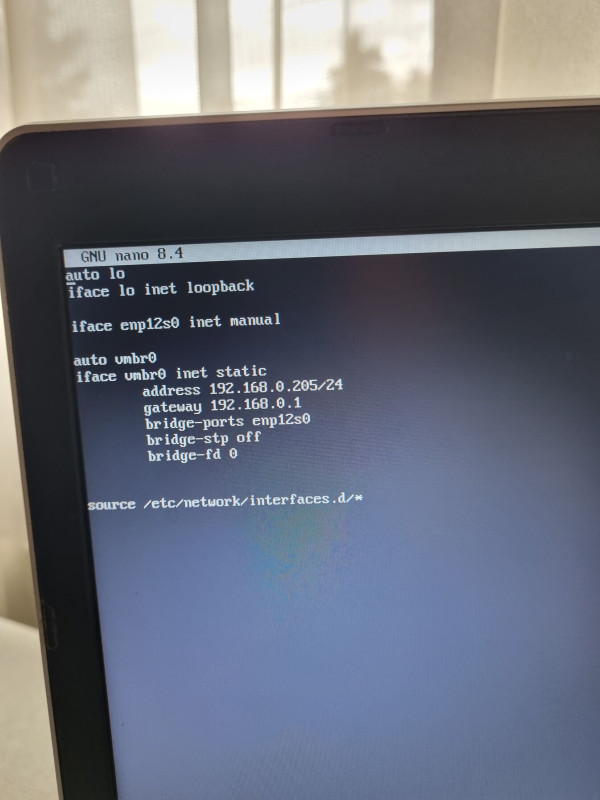

Telepítőnél az IP sorban volt egyszer az IP cím, ahol megadtam a 192.168.0.205-öt, és a sorban mellette egy külön blokkban szerepelt eleve beírva a /24. Ezt nem nagyon vágtam, micsoda, de utánanéztem, és elvileg ez utal arra, hogy a subnet mask a 255.255.255.0 tehát feltételezem, ez jó.

A wifi izoláció nem is tudom pontosan, mi, de azt sem tudom, hol van. Utánajárva Asus routerekben a Wifi szekcióban kéne legyen ilyen, de nekem ExpertWifi EBG15 routerem van+EBA63 AP. Más kissé a struktúra, nem találtam ilyet.

Elvileg elindult, fut a rendszer, írja, hogy active (running), látok több enabled megjegyzést is.

A network/interfaces meg ezt adja:

OMV-n fut PiHole Dockerben, megpróbáltam leállítani, de így sem jön meg a Proxmox

-

ncc1701

veterán

Köszi.

Rendszernek mindenképp marad a mirror, nem azért, mert nem bízom az OS-ben, hanem már volt jó pár neves ssd elhalásunk is.

Migrálásnak még utána járok, xen alatt van egy linux vm-em, amin fut egy icinga, ami vagy 100 hostot ellenőriz. Na, azt nem akarom újracsinálni, de egyátalán. És annak külön lvm partíciója van. De jó hír, h elvileg van rá opció.

-

danih

veterán

Nekem úgy jött le, hogy a Canva-val van baj, Windows VM-ben, és tervezted esetleg az IGP átadását ennek (ergo jelenleg nincsen HW gyorsítás Win alatt).

Erre írtam, ha HW gyorsítással egyszerűbb módon le akarnád tesztelni a Canva-t (ami ha jól értem webes alkalmazás de 3d gyorsítást használ) akkor nézd meg amit írtam, hogy úgy hogyan teljesít -

danih

veterán

Beírtad volnda hogy "dab" és megtaláltad volna a korábbi hsz-t erről (amire reagáltál is

)

)

Csináltam egy 13.0 minimál lxc-t: 135 mega. Aztán kijött a 13.1 "hivatalos" LXC: 127 mega. Haha. Amit viszont többször használtam már az a minimál deb13 előtelepített dockerrel. Ez lett 223 mega.Webtop - erre is rákereshetsz, gyakorlatilag kész rendszer LXC-ben, böngészőből érhető el és (kliensmentes) x264-t használ transzportra (ebben kicsit hasonlít a Moonlight-ra).

-

danih

veterán

Ugyanaz a vas

Csak a VGA driver más, kíváncsi voltam a különbségre. Amúgy sima N100 - amire használom bőven elég, és alig fogyaszt. P-E core dilemma itt nem gond, mert nincsen P core

Csak a VGA driver más, kíváncsi voltam a különbségre. Amúgy sima N100 - amire használom bőven elég, és alig fogyaszt. P-E core dilemma itt nem gond, mert nincsen P core

Pressure stall-ról nem tudok nyilatkozni, mert nem érdekel, nem igzulok miatta, szerintem ilyen kicsi százaléknál neked sem kell

-

danih

veterán

Igazából nem szeleteket oszt, inkább annyi hozzáférést ad - tehát nem Xe magot osztasz vagy ilyesmi, hanem van egy scheduler-ed ami eldönti minek mennyi erőforrást ad. Tehát pl. adott pillanatban a render csak egy Windows 11 VM-ben aktív (pl játék), akkor az megkapja a teljes erőforrását az iGPU-nak...

A Xe driver az i915 helyett ezért is fontos, mert ebben jobb, modern scheduler van. -

tasiadam

Topikgazda

Igen. Az intel eleg jo arc lett ujabban. Konkretan a B50-ell ledominalta a worksation piacot. Mert hat, nem kell licence. Es SR-IOV-t az alder is tudott, meg a raptor iGPU is. Azt nem tudom, hogy a twin lake tud-e.

Ryzen nem van, mert RDNA az nem enterprise. De am siman jo lenne, ha egy vega11-et felvaghatnad tobb darabra. Csak hat szoftveresen a veganal merfoldekkel jobb barmelyik intelJobban jartal volna egy ujabb intellel, mint egy ryzennel

-

fudi2002

nagyúr

Igaziból ebben a környezetben nem lesz szükségem automatizált mentésre vagy ha így állítom elég lesz ritka sűrűséggel.

Az amdnél nem tudom a 40w jónak számít-e, de eme intelnél kb 10-wra le tudom vinni win alatt, nomeg a hibrid felépítés miatt az ütemező is fontos, bár ilyen feladatokhoz a kis magok is elegek lesznek, ha oda osztana feladatot. -

fudi2002

nagyúr

Cache nagyon gyilkolja az ssd-t gondolom (folyamat írás), ezért írod. Keressek oda valami nagy írástűréses 250-500gb-ost? A tervem valami olyasmi lenne, hogy az 1tbos m2-n lennének a vm-ek, a raid10 meg csak az egyik vm-hez lesz mint adattár. Utóbbit csak időnként menteném, a vm-eket esetleg gyakrabban.

-

huan

őstag

-

Pista0001

addikt

Az enyém is tud wifit is, de az nekem nem szimpatikus. van pár készülékem anélkül, szóval a kábeles megoldás nekem univerzálisabb. De amúgy usb-n sem a háziszerverre dugnám, hanem a routerre, szinte mindnek van printer servere, és erre (is) használható usb portja. Épített routerrel nyilván más a helyzet.

-

nemurea

aktív tag

Köszi mindkettőtöknek! Nem célom a túlkomplikálás, ezért is kérdeztem, mert láttam, hogy a végtelenségig lehet fokozni. Nálam is van samba és most gyorsba' NFS is (linux-linux között, ahogy írtad). Valóban az LDAP jött szembe, még a neve is bizalomgerjesztő (Lightweight...), azt körüljárom. Az elsődleges cél tényleg az, hogy ha be akarok lépni bármelyik gépemre vagy a szerverre, akkor ne kelljen saját magamat, a normál useremet minden gépen külön regisztrálni és karbantartani. Ugyanúgy ha a család más tagja teszi meg ezt (háh, távoli célok), akkor ugyanez legyen. Kb. ez az idea, majd formálódik a folyamatban.

-

-

Pista0001

addikt

A mini-itx topicban keress rá a hsz-aimra, B550+5600g-vel szívtam, úgy rémlik, leírtam végül, mi volt. Úgy 1,5 éve talán. Vagy 2,5...

Szerk.: Most látom a másik hsz-odat. Fura, nekem a felülírott konfig pico 160XT-ről megy, ami meg egy 12 V 10 A-es kockáról. Nálam amúgy indult, csak képet nem adott, úgy rémlik, de az is valami ismertebb bug talán.

-

-

danih

veterán

Lehet, nem tudom. Ezt a scriptet használtam.

Proxmox 9-ben kicsit megváltozott, hogyan mutatja a RAM használatot, emiatt gondoltam felrakom - nincs amúgy nagy szükségem rá, mert elvan a rendszer, IP címekre meg emlékszem

-

Pont ez idegesít. Minimál angol tudással, egy kis virtualizációs tapasztalattal (nálam Hyper-v Windows alatt) mellett egyérteműen használható, kis buktatókkal és utána olvasással.

És akkor ott van ez a "resize", igen most rákeresve sokan szencségelnek.

Na mindegy, ha a tinik leszakadnak a netről, akkor rendbe rakom a dolgot. Lesz vagy 15 perc. -

Lecseréltem a VM-ben az ISO-t egy frissre, adtam hozzá mégegy 128 GB-s lemezt. Arra újratelepítem és kész. Abba visszatöltöm a confot, így az interface-ek is rendben lesznek.

A Proxmoxban nevezzék át a resize disket, mert szerintem az oda-vissza méretezést jelent.... nem csak növelést. -

OPNSense. És 128g-ről indult, arra lett telepítve. Az betelt a logok miatt, gondoltam megnövelem. Aztán rájöttem, hogy a partíció kiterjesztése nem olyan egyszrű, gondoltam visszaállítom. Azt nem fifyeltem, hogy a resize disk menünél megadott érték, az nem a diszk mérete, hanem az az érték, amivel növelni szeretném, na így hizott tök fölöslegesen majdnem 1 TB méretre. Úgy különben az utolsó backup az OPNSenséről 12.34 GB.

Egy 1 TB-os SSD van a gépben a rendszernek és a VM-eknek. -

danih

veterán

mi a vm hw beállítása?

Mármint azzal kapcsolatban, amit írtam? Nem VM, LXC - ez a jó hogy sima device passthrough elég hozzá, nem kell GPU passthrough.UserFriendly ThinClient van, ezt egy rendszergazda/support polgár csinálja, minimál, csak login screen van, meg freerdp beállítások.

Amit én írtam alant azzal ez nem kompatibilis mert ehhez böngésző kell, freerdp-hez az rdekstop megoldás passzolhat, vagy sima VM -

danih

veterán

Lehet a legjobb megoldás egy modernebb CPU lenne, manapság a videók youtube-on vp9-et és av1-et használnak amit hardveresen nem hiszem hogy tud vinni egy régi proci...

Frigate-nek talán jobb a dedi, veszel valamit olcsón ami keveset fogyaszt, és ha váltani akarsz, mondjuk egy 12th gen intel-t oszt szétdobod a GPU-t SRIOV-val ahova akarod (VM, lxc)... Két GPU-t tuti nem raknék be, második a Win-nek totál overkill ha nincs játék. -

tasiadam

Topikgazda

Leeht szétosztani mezei kártyákat is, meg újabb intel iGPU-kat is lehet már virtualizálni. 12.gentől fölfele tudják. GT1030 szétosztva elég harmatos lenne. GT1050 meg sokat kajál. akkor inkább egy iGPU + egy P400 vagy vmi hasonló kaliber. Passthru is lehet, meg lehet split is. De ha splitet akarsz, T1000 alá nem mennék.

-

Kurrens

tag

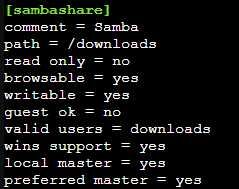

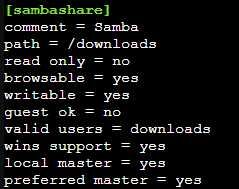

A privileged-et az NFS miatt csináltam. Elvileg minden Samba beállítás megvan, tasiadam leírása alapján csináltam. A chmod is megvan. Az nem lehet gond, hogy a user és a könyvtár neve ugyanaz?

Régebben is csak guesttel tudtam összehozni a dolgot, de próbálnám szofisztikáltabban megcsinálni.

-

danih

veterán

Szerintem tudja az a quicksyncet vagy hogy hívják, h264-et biztos.

Érdemes akkor megpróbálni továbbítani a két eszközt amit írtam, kell hozzá a GID az LXC-ben: card0-nak a video, renderD128-nak a render groupok száma.

Aztán dockerben a konténereknél és hozzá lehet adni hogy

devices:

- /dev/dri:/dev/dri

vagy valahogy így, firgate docker doksiban kell nézni, lehet hogy a renderd128-at kell direktben

Aztán hoston: intel_gpu_top és mutatni fogja hogy használja-e a hardveres gyorsítást amikor megy a stream -

-

v.attis

őstag

Közben kiderült, hogy az usb keretem nem küld semmilyen, vagy nem küld szükséges adatot a Proxmox számára, hogy leálljon, vagy leállítsa a hdd pörgését. 2 nap alatt mindent kipróbáltam, de még az állapotot sem tudja lekérdezni.

Mivel 2 ilyen hdd-m van, arra gondoltam, ha már veszek valamit, akkor miért ne vennék olyan usb (raid) házat, ami minimum 2 hdd-t fogad. Ami a különbség, hogy nekem a raid nem kell, így a jó, hogy külön látom és kezelem a hdd-ket.

Tudtok olyat ajánlani, ami:

- minimum 2x2,5" usb-SATA ház,

- raid nem kell,

- változatlanul hagyja a hdd-k sorozatszámát, mivel az alapján vannak mountolva a hostra,

- tudja a spindown-t és ehhez szükséges állapotot is át tudja adni a proxmoxnak.Chat gpt ezt ajánlotta:

[link]

meg ezt:

[link]

Ha van nálatok bevált eszköz, szívesen veszem a javaslatokat. Még annyi, hogy itthoni rendszerre kell, nem szükséges ipari-irodai minőségűnek és árazásúnak lennie. -

v.attis

őstag

Látom, Te otthon vagy a témában, kérdeznék még.

Van két hdd-m külön usb keretben: média és backup hdd.

A média hdd leáll pihenni, de a backup nem. Pedig a mentések éjszakára vannak beállítva, illetve macbook timemachine óránként, de most direkt kikapcsolták rendesen, hogy ne mentsen. A lényeg, hogy nappal, szinte mindig aludni a kellene, de ez pörög.

Proxmox előtt csak home assistant volt a gépen, akkor elment aludni, ahogy kell.

Erre van ötleted? Gyakorlatilag egy napon belül kb 23 órát állhatna.

A hdd-k a host-ra vannak csatolva, a konténerek csak bind mount-ot kaptak és mindkettő teljesen egyformán, mégsem egyformán állnak le.

Új hozzászólás Aktív témák

- Árváltozás + játék DVD: Watch Dogs Deadsec Edititon

- Árváltozás+játék!The Witcher 2 Assassins of Kings Collector's Edition

- Windows 10 11 Pro Office 19 21 Pro Plus Retail kulcs 1 PC Mac AKCIÓ! Automatikus 0-24

- Eredeti Microsoft termékek - MEGA Akciók! Windows, Office Pro Plus, Project Pro, Visio Pro stb.

- BLACK FRIDAY! - Jogtiszta Windows - Office & Vírusirtó licencek- Azonnal - Számlával - Garanciával

- ÁRGARANCIA!Épített KomPhone Ryzen 7 5700X3D 32/64GB RAM RX 7800 XT 16GB GAMER PC termékbeszámítással

- Keresek Xbox Series S / Series X / Playstation 5 konzolokat

- Samsung Galaxy S10 128GB, Kártyafüggetlen, 1 Év Garanciával

- Bomba ár! HP EliteBook 840 G2 - i5-5GEN I 8GB I 500GB I 14" HD+ I Cam I W10 I Garancia!

- iPhone XS Max 256GB Black -1 ÉV GARANCIA - Kártyafüggetlen, MS3997, 100% Akkumulátor

Állásajánlatok

Cég: BroadBit Hungary Kft.

Város: Budakeszi

Cég: Laptopműhely Bt.

Város: Budapest

, segítséget, elemzést. A gmail reg még nem elég, az csak az alap. Az ingyenes nekem is vegyes eredményeket hozott. Volt amiben a ChatGPT4 (volt akkor még) volt a jobb.

, segítséget, elemzést. A gmail reg még nem elég, az csak az alap. Az ingyenes nekem is vegyes eredményeket hozott. Volt amiben a ChatGPT4 (volt akkor még) volt a jobb. .

. , pedig már nézegetem a NotebookLM, Gemini3-t is. És még a topikgazda is kopogtathat a fejemen.

, pedig már nézegetem a NotebookLM, Gemini3-t is. És még a topikgazda is kopogtathat a fejemen.

tasiadam

tasiadam