Hirdetés

- GoodSpeed: Alza+ Megéri?

- Luck Dragon: Asszociációs játék. :)

- Meggyi001: A kérdés...

- Brogyi: CTEK akkumulátor töltő és másolatai

- gerner1

- Magga: PLEX: multimédia az egész lakásban

- GoodSpeed: 3I/Atlas: Üstökös vagy idegen civilizáció űrhajója?

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- sziku69: Fűzzük össze a szavakat :)

- GoodSpeed: Nem vénnek való vidék - Berettyóújfalu

-

LOGOUT

Új hozzászólás Aktív témák

-

dolon75

senior tag

Megéri a Cloud, főleg a fejlesztőnek.

Az ügyfélnek már azért érdemes lenne számolnia, mielőtt nekiáll megrendelni egy felhős szolgáltatást, persze felmérve, hogy milyen van a 'spájzban', mennyire fontos neki az adatai fizikai helye, valamint mekkora a függés a madzagtól ahhoz a helyhez. -

coco2

őstag

Szerintem a felsoroltakat egy kicsit eltúloztad.

Ha malware vagy bármi felcsúszik gépre, azért bármelyik felhőből pont ugyan úgy hajítják ki az ügyfelet, mint macskát sza*ni. Sőt, üzleti felelőssége van a károkozásért. Bizony a production security nem vicces. Letiltani a saját érdekében tiltják le, hogy legalább korlátos legyen az a számla. Image feltöltés / letöltés nyers szervereknél mindenütt van. Automatizálás és adatmentés gyanánt elég kell legyen, ha amúgy is van devops.

És nyilván nem gondoltam sirdogálni besenyő pistike nénike bt havi 1k huf-os vps-ét lecserélni, ami a havi aktív 1-2 ingyenes felhasználójukat szolgálja ki, mert arra nyilván az a célszerűbb eszköz. Az üzleti matek 100k havi aktív felhasználó alatt fel sem vetődik. Viszont azon túl már elkezd igény lenni valódi teljesíményre, és ha teljesítmény is kell, a felhő kényelme nagyon sokba kerül. Azon a pénzen gondolkodok, hogy a kényelmetlenségekkel együtt biztos nem érdemesebb-e inkább zsebre tenni, mint google-nek adni?

A felsoroltakban valódi bajt én semmit sem találtam. A felhő előtt is volt élet, és volt security check is, amin át tudtak menni. De ha valamit komolyan veszélynek látsz, kérnék rá egy külön említést.

-

coco2

őstag

Azure nem ad szervert, csak vm-et

VDS a maximum, amit kaphatsz, de a nagyja csak VPS. Vagy SaaS/PaaS.

VDS a maximum, amit kaphatsz, de a nagyja csak VPS. Vagy SaaS/PaaS.Viszont a kérdés független tőle. Az update domain azt mondja, sosincsenek egyszerre állítva le a vm-ek, mert update domain-enként halad a frissítés, és a karbantartási idők el vannak szigetelve egymástól ráhagyással. Ami érdekel, hogy milyen sűrűn vannak azok a karbantartások? Minden hónapban 1x lepörög a 20 update domain? Vagy 3 évente egyszer? Mégis mennyi időnként?

-

coco2

őstag

>Hany eve van full Windows ARM-on? Leglabb 5?

Vannak hosszú ideje olyasmik, mint az ARMbian és társai, de amíg még egy normális LAMP-ot sem lehet felépíteni rá, a roseb sem veszi komolyan. A magam részéről úgy számoltam, hogy előbb egy Linux-ot fognak kicsiszolni, mielőtt a Windows komolyan sorra kerülne. Hanem az a cucc, amit @pelyib linkelt, na az kezd tényleg "vicces" lenni.

>Az valami fegyveres alakulat?

Van egy film, Night Train. Rövid részlet belőle (film idő 6. perc környékén):

"- See, our friend is pissing off some really scary people now."

"- Who's scarier than the Mexican cartel?"

"- American big Pharma."

"- Oh."Nevess nyugodtan

-

dqdb

nagyúr

Tehát nincs teljesítményveszteség, stb.

Ahol teljesítményvesztés van, az az eset, amikor WSL alól a Windows fájlrendszerét éred el. Gyorsítottak rajta valamennyit az idők során, de még mindig nem az igazi. WSL-ben érdemes a virtualizált Linux ext4 fájlrendszerét használni, és a /mnt/c típusú eléréseket minimalizálni (vagyis egy Windows alatt checkoutolt repót ne akarj lefordítani /mnt-n keresztül bemappelve, mert tetű lassú lesz, helyette checkoutold ki ext4-re is és gyors lesz, de a végeredmény átmásolására már tökéletes). -

Szóval pl. a network stack a virtualizált hardverek fölé rakott rendes Linux stack, a virtualizált hardvert a Hyper-V intézi, a Windows kernelen nem megy át a forgalom. Azt hiszem, mostmár CUDA támogatás is van.

Kicsit hasonló ehhez (bár nem teljesen):

(Ez az én desktopom, ugyanazon a fizikai gépen megy két OS, mindkettőnek saját GPU-ja van, a "virtualizált" Windowson is lehet full sebességgel játszani, etc.) -

coco2

őstag

>Lassú.

Vitatnám. Az új adat felírása lassabb. Az a része igaz. De mi van azzal, hogy cserébe az adatok visszaolvasását oszthatod? Egy kiegyensúlyozott alkalmazás egészében mindig az olvasás a nagyon sokszor több. Egy fürt mindig gyorsabb tud majd lenni, mint egy node. Nekem kicsit szűklátókörűnek tűnik a kritika.

>100% uptime nem szükséges egyébként, és a kliens szempontjából úgysem elérhető soha. A blockchain sem 100% a kliens szemszögéből.

Na itt egybedaráltál pár dolgot. A "nem szükséges" állítása egy kicsit savanyú a szőlő esetére hajazik. Nem tudják megcsinálni elavult technológiai alapon, szóval ráfogják, hogy az a felhasználói élmény nem szükséges. "Az ki van zárva, mert nem tudom"

És szőnyeg alá söprik azt az esetet, hogy ha valaki azzal kezd marketingelni a piacon, hogy ők azt is meg tudják csinálni, mindjárt megváltozik a szükséges-e vagy sem minősítése. Nem csak bankok, de mezei pici cégek sem szeretnek a köztudatban arcot veszíteni. Egyik brand sem szeret arcot veszíteni konkurenciával szemben. Nyilván idő kell hozzá, de ha az utólagos statisztika eredményére kellene pénzzel fogadnom, azt arra tenném fel, hogy a "nem szükséges" veszíteni fog.

És szőnyeg alá söprik azt az esetet, hogy ha valaki azzal kezd marketingelni a piacon, hogy ők azt is meg tudják csinálni, mindjárt megváltozik a szükséges-e vagy sem minősítése. Nem csak bankok, de mezei pici cégek sem szeretnek a köztudatban arcot veszíteni. Egyik brand sem szeret arcot veszíteni konkurenciával szemben. Nyilván idő kell hozzá, de ha az utólagos statisztika eredményére kellene pénzzel fogadnom, azt arra tenném fel, hogy a "nem szükséges" veszíteni fog.Az uptime veszítést sem érzem jogosnak. Fürtöt is kellhet leállítani, ha pancserek fejlesztik az alkalmazás egészét, és nem tudják megoldani a rolling restart-ot, vagy alkalmazás hibák miatt esetleg adat integritás sérül. Még a cyber attack problémája fordul elő (konkrétan a rendszerre történő behatolás lopott jogosultsággal), de az meg biztonságtechnikai probléma, ha elő tud fordulni, és nem írnám a partícionált rendszerek természetének számlájára. Ha azok mind megértek elég sok időt és hozzáértést, de bizony tud lenni az uptime 100.0%. Ha konkrét technikai kifogásod van, légyszíves fogalmazz konkrétan, milyen esetben látod elkerülhetetlennek a down time-ot?

>A blokklanc lenyege az, hogy akarhanyan beallhatnak szavazni arrol..

Amit írsz, az alkalmazás szintű kérdés, mint hogy páran felhasználták cryptocurrency-re ugyan azt a technológiát, amit lehet használni adatbázis építésére egy webservice mögött. Igen, lehet szavazósdit építeni belőle, ha valaki azt akar. De az mind alkalmazás és nem a technológia maga. De mondjuk megkérdezendő harmadik felet, rákerestem google-el, és ezt dobta ki:

"Blockchain defined: Blockchain is a shared, immutable ledger that facilitates the process of recording transactions and tracking assets in a business network."

Ha valakinek az angol kevésbé megy, nekik segítségképpen a "ledger" nem csak számlakönyv, hanem bármilyen jegyzék, az "asset" nem csak pénz eszköz jellegű tulajdon, hanem bármilyen természetű, és a "business network" nem csak pénzügyi hálózat, hanem bármilyen alkalmazás hálózat.

Az "akárhányan beállhatnak szavazni" azért alkalmazás szintű kérdés, mert vagy úgy van kivitelezve az alkalmazás, hogy mindenkit elfogad a megbízható hálózat tagjának, vagy nem. Nem kötelező része a technológiának. Vagy talán csak elbeszélünk egymás mellett, nem egyértelmű. Majd pontosítasz, ha gondolod.

-

coco2

őstag

Viccen kívül, végigolvastam a CAP blogot a wiki-n, és ott van a blog végében a PACELC kritikája. Nem csak én gondolom úgy, hogy a CAP kissé figyelmetlen.

Sőt, szerintem a PACELC is figyelmetlen annyiban, hogy akár scriptes jellegű alkalmazások esetén csak egy erőforrás szemafor kiegészítés kell, és akár elosztott rendszerekben az A/C probléma L/C problémává változik. Tranzakció-mentes környezetek számára az adatverziókat már feltalálták az Availability alapértelmezetten biztosítható.

Egyenlőre nem találtam másik gyakorlati megoldást a "közelben", amelyik foglalkozna az A/C -> L/C probléma transzformációval, mint például Redis cluster-t futtatni. Ha te mégis tudsz olyat, sikíts.

Ami vélemények eddig érkeztek, mindegyik tool, amelyik a problémát egyáltalán kezelheti bármilyen szinten, Raft / Paxos alapú. Azt kijelenteni vajon korrekt?

A trollkodást meg nyugodtan hanyagolhatod. Arra nem tartok igényt.

-

K1nG HuNp

őstag

https://www.nginx.com/blog/using-free-ssltls-certificates-from-lets-encrypt-with-nginx/

1. Run the following command to generate certificates with the NGINX plug‑in:

$ sudo certbot --nginx -d example.com -d www.example.com

2. Respond to prompts fromcertbotto configure your HTTPS settings, which involves entering your email address and agreeing to the Let’s Encrypt terms of service.

Ez alapján itt manuálisan kell hozzáadni a domaint és megadni néhány adatot, ezt a Caddy önmagától csinálja, ami azért egy jóadak komplikációt kivesz a dologból. -

K1nG HuNp

őstag

AWS Layer 3-4re alapbol mindenkinek ingyen ad Shield Standard neven egy DoS védelmet/megoldást.

Caddyt amikor valasztottam az On-Demand TLS miatt tettem mert akkor a piacon csak ő tudott ilyet. (https://caddyserver.com/docs/automatic-https#on-demand-tls) NGINX hasonlo szolgaltatasat be tudod linkelni? -

K1nG HuNp

őstag

Kontextus: A Caddy proxyt arra hasznaljuk, hogy az userek a sajat domainjeiket ezen proxy IP cimere tudjak iranyitani es ezaltal a sajat domainjukon a nalunk krealt weboldalaikat tudjak mutogatni, mikozben a mi infrastrukturank szolgalja ki a kereseket. Igy tehat hosszutavon statikus IP cimmel kell rendelkeznie a proxynak es kvazi publikus is ez az IP cim mert benne van a Support/How-to doksinkban. Azert Caddyt hasznalunk mert o kepes arra, hogy az TLS handshake soran Lets Encryptel certificatet gyart es igy HTTPSen keresztul tudjuk kiszolgalni az userek domainjat.

Egyszeri eset volt de elég volt arra, hogy lefektesse a Caddy proxyt. A beérkező késések patternje pedig egyértelműven attackra utal, az kérdéses, hogy specifikusan ránk vagy csak valami crawler szedte fel az IP-t és utána nyomták ránk is többek között a dolgot.AWS-en futunk, egy sima EC2 egy statikus Elastic IP-vel.

Belenéztem milyen lehetőségek vannak L7 támadások ellen, de elég kacifántos megoldások vannak. Alapvetően van egy WAF-juk de azt csak Application Load Balancerekre lehet kötni szóval első nekifutásra az ALB+WAF -> EC2 megoldás tűnt jónak aztán kiderült, hogy az ALB nem támogat statikus IPket.

Erre megoldás, hogy egy Network Load Balancert huz fel az ember az ALB elé, az már tud Elastic IPhez csatolodni. Szoval eddgi az a keplet, hogy NLB+Elastic IP -> ALB -> EC2

Kerdeses, hogy az NLB és az ALB közé (vagy az ALB mellé kerül és akkor nem zavar igazabol?) be lehet e rakni a WAF-ot..

Mindegy, ha folytatodnak a tamadasok majd jobban belenezek meg megprobalom tenylegesen leimplementalni.

Addig meg jo megoldas lehet penzt dobalni a problemara, nagyobb EC2, meg valamiert a Caddy proxy nem indult ujra miutan elhasalt az EC2 szoval lehet erdemes lenne a systemd konfignak is utana nezni hogy legalabb self-healeljen a proxy ha tamadas is eri.

-

coco2

őstag

Dollártízmilliárd a hócipőt

Több hónapnyi munka után ha saját célokra akarok több alkalommal felhasználni valamit (bármit), githubra kell minimum kirakni pusztán a jogi problémák lekezelése miatt, és ingyen adni ország-világnak, amiért még egy "köszönöm"-öt sem fogok soha kapni. Az a realitás, nem a dollártízmilliárd.

Több hónapnyi munka után ha saját célokra akarok több alkalommal felhasználni valamit (bármit), githubra kell minimum kirakni pusztán a jogi problémák lekezelése miatt, és ingyen adni ország-világnak, amiért még egy "köszönöm"-öt sem fogok soha kapni. Az a realitás, nem a dollártízmilliárd.Apropó, olvastam azt a blogot, és ami a mindhármat egyszerre esetét illeti, az maximum az alkalmazható gyakorlat korlátos esetében lehet meg. De lehetetlennek éppen nem lehetetlen, hogy meglegyen. Elméletben biztos az, de a gyakorlat más.

-

Drizzt

nagyúr

Elsőre a Redis pubsub channel-nél arra jöttem rá, hogy nekem nem lenne ideális, mert én akkor is szeretném tárolni az üzeneteket, ha valaki offline. De úgy látom a Redis Stream-szel ez is megoldható, bár a last read message ID nincs karbantartva subscriberenként, mint a Kafkanal. De ez nem egy tragédia.

NATSt még ennyire sem ismerem, de utánanézek. -

coco2

őstag

Ha írnék valami célirányosat C-ben, plusz dokumentálni, az első lépésben minimum 2 hónapnyi munka. Azért keresek inkább valami kész cuccot. Sok idő. Egyszer csak rá fogok szánni annyit. De első körben ofc megkérdeztem itt a népet, van-e normális cucc. Akár szerencsém is lehetett volna.

-

K1nG HuNp

őstag

en mar irtam errol jo regen, hogy elegge munka feltesem van. remelem az msc diploma meg a hardver iranyba valo elmozdulas megved a webfejlesztoket / codemonkeyokat kivalto dolgoktol. vagy ha masnem addigra elegsegesen megszedem magam

marmint tokre megvan, hogy holtjaig tanul az ember es mindig is hobbim volt a rendes munka/suli mellett hogy itthon magamnak a bleeding edge cuccokba assam bele magam, de azert engem az elet mas dolgai is melyen erdekelnek, napi 2-3 ora gordeszka, asszonnyal meg a 30as eveink elott csaladalapitas stb es ezek miatt kicsit felek, hogy az ilyen gyorsan rotalodo szakmabol ki fogok esni

ugyhogy kivancsi leszek mivel tudom majd kivedeni ezt, egyetem utan sajat ceg alapitasa vagy kulfoldon/rol nagyon fizuk leszakitasa es befektetese

-

Ez bonyolult?

import redis

r = redis.Redis()

# Semaphore name

semaphore_name = "my_semaphore"

# Client identifier

client_id = "client_1"

# Acquire semaphore

if r.sadd(semaphore_name, client_id) == 1:

# Semaphore successfully acquired

try:

# Critical section of the code goes here

# Release semaphore

r.srem(semaphore_name, client_id)

except Exception:

# An error occurred, release semaphore

r.srem(semaphore_name, client_id)

else:

# Semaphore is already held by another client

print("Semaphore is already held by another client") -

coco2

őstag

A redis egyszerű, épp csak nem az

Van még másik "hasonló" eszköz?

Van még másik "hasonló" eszköz?Ha erre utaltál, megint csak nem olyasminek tűnik, amit keresek. Master-kliens alapokra épít, és nem kliens-kliens-re. Abban a pillanatban, hogy egy node-ot masternek választott az algoritmus, kiesik az a node (mert pont akkor pont az kampeca), elég rendesen lesz adat vesztés, amiből nem lesz recovery. Talán a maradék "észhez tér", de ami elveszett, az addigra már elveszett.

-

coco2

őstag

-

Drizzt

nagyúr

Lazán kapcsolódó.

Van-e olyan framework készen, amit lehetne SSE-hez úgy használni, hogy minden embernek csinálni egy topicot, aztán arra subscribe, ha megjön az SSE connection, az üzenetküldők meg publisholnák a cél ember topicjába az üzeneteket? Minden ember 100e-es nagyságrendet értve. Szóval van-e olyan pubsub, ami nem kezd el kétségbeesni 100e topictól? -

coco2

őstag

Nem biztos, hogy értem a problémádat. Aki épelméjű informatikai igénnyel keres fejlesztőt, és sportszerűen bánik vele, értem úgy kifizeti előre az időt, amit felhasznál, kap rátermett fejlesztőt, amennyit csak akar. Ami a többit illeti, a szellemileg megkérdőjelezhető tisztaságú ügyfél, a nem fizető ügyfél, a con artist divíziók, az investor pénz lopás, meg a többi, az mind teljesen külön játék, és ne keverd őket egybe. Végső soron mindenki azt kapja, amit megérdemel, úgyhogy én nem hiszem, hogy csakugyan lenne bármiféle probléma.

-

emberek jo resze igazabol lofaszhoz se ert

A most már kvázi CTO - aki btw a legjobb fejlesztő, akivel valaha dolgoztam - haverommal szoktunk azon keseregni, hogy a fejlesztők nagy része objektív hülye és/vagy nem hajlandó gondolkodni. Agyatlanul lefejleszt valamit, ami le van írva, és még véletlenül sem gondolja végig, hogy van-e értelme.

-

JoinR

őstag

Az emberek máshogy értelmezik a "normális" fogalmát. Ha megismersz olyan helyeket, ahol a kompetens emberek komplex problémákat oldanak meg napi szinten, jó eséllyel neked az lesz a normális. Aki pedig egy multinál van, ott meg az a normális, hogy...hát az, amit leírtál.

Az átlag átlagos teljesítményre képes, nem életszerű a magas mérce beállítása normálisnak. Célnak persze nemes dolog kitűzni, de a tapasztalatom alapján a legtöbbször irreális elvárás és csak konfliktust eredményez, ha mások nem tudják az "elvárásaidat" teljesíteni. -

JoinR

őstag

Hú én nem vagyok scrum mester, de azt hiszem, nem kizáró ok ilyen esetben (ha pl. sprinthosszon túlnyúlna a megoldás), hogy anélkül is létezzen a részfeladat, hogy közvetlen értéket teremtsen az ügyfélnek. Viszont ez a mondat, amit írtál, szerintem minden csapatban elhangzik heti egyszer.

-

-

De te most melyik irányból nézed a dolgokat? Igen is nem jó dolog ha egy kód komplex. Komplexitását ne a mennyisége adja hanem az összetettsége szerintem. Egy komplex kód és én itt most a töb 100 soros függvények összeségéről beszélek, vagy próbáltam beszélni nem jó.

És ez nem butaság. Szerintem a coding style és a "teszt lefedettség" - itt megint mit értünk nem a code review része. Annak előtte kell megtörténnie normál esetben automatikusan (pl. sonar qube + egyéb linter).

-

cucka

addikt

Jókat írsz, pár random gondolat:

- A fejlesztők többsége nem tud különbséget tenni az essential és az accidental complexity fogalmak között, és ez meg is látszik a munkájuk minőségén.

- Nekem a szoftveres komplexitás nagy kedvenc interjú témám, sajnos nagyon ritka az a versenyző, akivel egyáltalán eljutok ide. Tényleg, ti nem vettétek észre, hogy a diplomás, profi, sok év tapasztalattal rendelkező programozók többsége egyszerűen nem tud programozni?- Ez a Datomic nagyon szexi. Igazából eddig is tudtunk hasonló, objektum-history alapú adatstruktúrákat csinálni pucér sql-el, de na, ígéretes.

- A YAGNI elv lényege pont az, hogy ha valamire jövő hónapban lesz szükséged, akkor jövő hónapban írod meg. Falra tudok mászni attól, amikor a fejlesztők előre gondolkoznak és általánosítanak, 10-ből 9 alkalommal az lesz belőle, hogy kiderül, segg hülyék az üzleti igényekhez, és fogalmuk sincs, milyen absztrakciókra lesz szükség a jövőben.

-

Uhh, nem akartam én ennyire mélyen belemenni.

Tömören próbáltam megfogalmazni alapvető trendeket, amiket látok. Nyilván nem a gányolásra gondoltam az egyszerűség alatt, hanem arra, hogy az üzleti igényre nem a pmonitor által folyamatosan pedzegetett elv a válasz, hanem a peremfeltételek mellett (fenntarthatóság, stabilitás, fejleszthetőség, biztonság, stb.) az egyszerű és gyors implementáció. Egy AI leletező szoftver kódbázisa nyilván komplexebb lesz, mint egy random Java weboldalé. De amúgy nincs köztünk vita semmiben.

Tömören próbáltam megfogalmazni alapvető trendeket, amiket látok. Nyilván nem a gányolásra gondoltam az egyszerűség alatt, hanem arra, hogy az üzleti igényre nem a pmonitor által folyamatosan pedzegetett elv a válasz, hanem a peremfeltételek mellett (fenntarthatóság, stabilitás, fejleszthetőség, biztonság, stb.) az egyszerű és gyors implementáció. Egy AI leletező szoftver kódbázisa nyilván komplexebb lesz, mint egy random Java weboldalé. De amúgy nincs köztünk vita semmiben. -

cucka

addikt

Az az előnye, hogy számomra, az én napi munkámban komfortos

.

. - Sok projekt van a gépemen, amelyeken kell tudjak alkalomadtán dolgozni.

- Nem nagyon van köztük olyan, aminek az üzemeltetése konténerizált. Fejlesztőként max. a saját magam örömére írhatnék dockerfileokat, a konténerizáció fő előnyét nem tudnám kihasználni.

- A projektek egy része ilyen webes szutyok, node vagy php vonalon, ahol állandó kényelmetlenség volt, hogy melyik milyen verziójú dependenciákkal hajlandó működni.

- A projektek kis része pedig natív, ahol magunknak fordítunk mindent kézzel.

- Macen dolgozok, és macen a docker kifejezetten szar. Vagy legalábbis szar volt amikor próbáltam, fura bugok, értelmezhetetlen erőforrás-használat, stb.Szóval nem találtam fel a szent grált, egyszerűen csak erre az élethelyzetre kitaláltam egy fapados megoldást, ami eddig nekem bevált.

-

akkor te is érted, mit mondtam, tehát ez a hsz felesleges volt.

másoknak: a konténerizáció nem lehet cél, max. eszköz.ha azt akarom, hogy egy böngésző ne férjen hozzá a desktopomon a dolgaimhoz, akkor vagy másik felhasználóként indítom el, vagy másik gépen.

egyébként annak a gyökere, hogy megmondod, hogy egy app nem fér hozzá bármihez, csak az lehet, hogy nem bízol benne, hogy az app azt csinálja, amit te akarsz vagy amit te hiszel.

q.e.d.: az informatika mélyrepülésben van.ha azt akarom, hogy egy app ne férjen hozzá a cuccaimhoz, akkor másik számítógépen indítom, feltéve, hogy az app nem ócskán programozott java awt-s app. mint az abevjava vagy az eclipse....

-

ez (idézem magam): "sok helyet foglal a diszken, egy teljesen felesleges infrastruktúra a rendszerben, ami redundáns" miért nem konkrétum?

nem mondtam, hogy a mai fiatalok hülyék, én nem tudhatom, hogy melyik fejlesztő milyen idős."Hat, pedig a modern Linux desktopon az appok egy jelentos resze mar kontenerizalt.": azért remélem, hogy a konténerizáció sosem lesz cél.

-

fatal`

titán

Semmi bonyolult nincs benne, hullafelesleges extra erőforrás.

Minek akarnék egy zenelejátszót vagy egy fájlkezelőt több példányban telepíteni? És ezért az egésszel együtt járó overheadet futtatni? És miért kéne ehhez konténer? Rendesen kell megírni a szoftvereket és akkor az OS kezeli a felhasználói profilokat.

Háttérben futó dolgokhoz, meg szervereken izolált környezethez jó a konténer. Én csak a desktopon futtatott appoknál látom teljesen feleslegesnek, bár egyelőre még nem ebbe az irányba megyünk szerencsére.

-

de nem az a kérdés, hogy sima processz-e vagy sem.

hanem az, hogy sok helyet foglal a diszken, egy teljesen felesleges infrastruktúra a rendszerben, ami redundáns, csak azért, mert a programozók azon része, akik konténert fejlesztettek, nem bírtak megülni a fenekükön és hasznos dolgot csinálni, a másik része meg, aki nem akarja rendesen megírni a programját, felmentést kap a konténerrel a tisztességes munka alól.felhasználói profilok szétválasztása??? az adduser mire való azon a rendszeren, amit nem is láttam még?

-

-

bLaCkDoGoNe

veterán

Köszönöm!

Megnyugtat, hogy úgy látom alapvetően jó volt az elképzelésem, csak szokás szerint kicsit túlbonyolítottam a dolgot (pl. azzal, hogy mindent csoportokba rendeztem) – ez meg gondolom majd idővel meg a megszerzett rutinnal változik majd.1. Jogos, látom én is. Azt hittem, hogy jobban át tudom majd tekinteni, hogy mi hova tartozik, de leginkább csak jól összezavartam magam vele.

2. + 3. A \b-vel szerettem volna a string végét ellenőrizni, de valami érthetetlen okból nem a végére raktam. (Persze lehet, hogy ott sem lett volna jó helyen. Szerk.: ott sincs jó helyen, nem jól értelmeztem, hogy mit csinál a \b.)

4. Ó basszus, valóban! *homlokra csapós szmájli* Erre magamtól biztosan nem jövök rá. Itt is a saját dugámba dőltem, mert itt pont azért használtam tartományt \d helyett, hogy akkor majd jobban szembetűnik, hogy ott két opció közül kell egyet megtalálni.#17686 dabadab: Neked is hálás köszönetem!

Sikerült magamnak egy amúgy is nehezen átlátható kérdéskört egészen túlbonyolítanom olyan dolgokkal, amikről azt hittem, hogy majd segítenek (például a capturing group-okkal).

Sikerült magamnak egy amúgy is nehezen átlátható kérdéskört egészen túlbonyolítanom olyan dolgokkal, amikről azt hittem, hogy majd segítenek (például a capturing group-okkal).Külön hálás vagyok mindkettőtöknek a hozzáfűzött magyarázatokért, sokat tanultam belőlük.

Leginkább arról, hogy bőven van itt még gyakorolni való...

Leginkább arról, hogy bőven van itt még gyakorolni való... -

bLaCkDoGoNe

veterán

Szuper, köszi.

A freeCodeCamp-en a Javascript blokkot csinálom, és az egyik projekt feladat az, hogy kell írni egy telefonszám formátum ellenőrző függvényt, ami a megadott számsorozatot adott szempontok szerint validálja, és visszaköp egy boolean-t eredményül.

Elsőre úgy gondoltam, hogy ezt regex-szel lenne a legegyszerűbb megoldani, úgy, hogy egy viszonylag komplex kifejezéssel ellenőrizném az összes szükséges szempontot, de két napja szuggerálom a megírt regex-emet, mert két teszteset elbukik rajta, és egyszerűen nem látom, hogy hol megy félre. A legvalószínűbb persze, hogy mivel most tanulom a dolgot, hülyeséget csináltam valahol, bár a regex101.com-on végigzavarva olyan nagy marhaságot elsőre nem találtam benne, lehet hogy egyszerűen valahol rosszul tagoltam valamit például, ami működik így is, csak nem a szándékaim szerint.

A regex, amit összeraktam, így néz ki:

/(^(1))?(\s)?((\([0-9]{3}\))*|\d{3})(\s|[-])?(\d{3})(\s|[-])?(\b\d{4})/

és szándékaim szerint az alábbiakat ellenőrizné:

- opcionálisan 1-essel kezdődik-e a szám

- az egyes után opcionálisan whitespace

- van egy három számot tartalmazó blokk zárójelek között VAGY zárójelek nélkül

- ezt követően opcionális whitespace vagy kötőjel

- ezt követően három számot tartalmazó blokk

- ezt követően opcionális whitespace vagy kötőjel

- végül egy négy számot tartalmazó blokk.Ez a két testcase nem az elvárt eredményt adja vissza:

telephoneCheck("5555555555") should return true.

telephoneCheck("555-5555") should return false.Tudnátok valami iránymutatást adni, hogy hol van a hiba abban, amit csináltam? Vagy eleve lehetetlen az összes teszt esetet egy regex-szel lekezelni, és egy többszintű, elágazó szűrést kellene csinálnom több kifejezéssel?

Köszi a segítséget.

-

Hat terminalt ertem, igen, de kifejezetten regex(egular expression) parancsokat hasznalva.

Erre valamilyen univerzalis dolgot keresek, hogy ugye ha hosszu a fajl, tudjak szurni ugy, nem egyesevel fajlokra.Amit en csinaltam konkretan valtozokkal:

var1="anauuuana\n""anauuuata\n""anaanaana\n""asd\n""file_record_transcript\n""file_07241999\n""file_fake.pdf.tmp\n""file_tmp\n""loremipsum.tmp\n""lorem\n""test s"var2="-1.pdf\n""-2.pdf\n""-3.pdf\n""-4.pdf\n""-5.pdf\n""-6.pdf\n""\n""-7.pdf\n""\n""-8.pdf\n""-9.pdf"paste <(echo $var1) <(echo $var2)paste -d "\0" <(echo $var1) <(echo $var2)

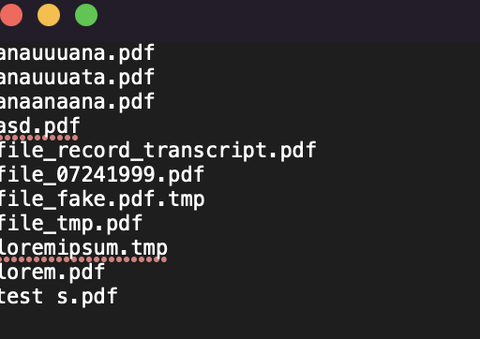

Ez amugy a kezdo fajl:

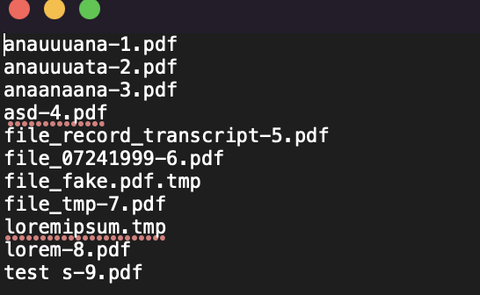

Es ez kene legyen az eredmenyem:

Es ez kellene univerzalis formaban, tehat ha meg beszurok x sort a szovegbe, akkor is kellene mukodjon ra a kod.

Amilyen parancsokat hasznalhatok az a grep, sed, paste, echo, cat nagyjabol.

2 napja kuzdok vele, nem talalok univerzalis megoldast, csak specifikusat.

-

pmonitor

aktív tag

Képzeld, van olyan webshop, ahol ha utánvétes fizetést választasz(nem átutalásost, bankkártyást), akkor a tulaj ügyintézője az általam megadott telefonszámon felhív, és közli, hogy a csomagot feladják, másnap megérkezik. Gondolom ez azért van, mert "elég sokan" false nevet, címet adtak meg. És én természetesen ezért nem kapom fel a vizet. Tehát az általam írt esetben is be lehet kérni több infót(pl. nagyker neve, számlaszám, kapott darab stb...). És ha ez a több infó megvan, akkor már ki lehet zárni pl. azt, hogy ugyanazt a számlaszámot többször beüssék. És ez független attól, hogy egy egyszerű .csv-ben, vagy komolyabb adatbázisban tárolják az adatokat.

-

cucka

addikt

Ha rendesen szét van választva az üzleti logika és az alkalmazáslogika, akkor az a megfigyelésem, hogy az üzleti logika szinte mindig stateless, az alkalmazáslogika meg általában nem az.

Szóval a cél nem az, hogy lisp-el büntesd magad meg a kollégáidat, hanem hogy az üzleti logikát mellékhatás-mentes függvényekkel fogalmazd meg. És akkor mindegy miben írod, akár lisp-ben is megteheted, ha tényleg azt szeretnéd, hogy az összes kollégád gyűlöljön.

-

coco2

őstag

Egy jelenkori "népszerű" prog nyelv iránti legfontosabb követelmény, hogy csak és kizárólag szemetet lehessen vele gyártani. Folyamatos alkalmazás karbantartás nélkül korlátos időn belül tönkremenjen egy alkalmazás anélkül, hogy hozzá kellene nyúlni. Igen a C# és Java népszerű nyelvek

![;]](//cdn.rios.hu/dl/s/v1.gif) A lisp is tud olyat?

A lisp is tud olyat? -

coco2

őstag

"Spec hardver"? Arra nehezebb fejleszteni. Drágább. Biztos megéri?

Az az alpha zero sakkozik talán. Asszem ott találkoztam a nevével stockfish meg lilo mellett. Azokat megérhette betanítani, mert a chess.com-on jó sok pénzt kaszálnak. Aztán még lehetnek marketing költség / fogyasztás előrejelzések, amik tuti nyereségesek. Az önvezetés meg high freq trade a hírek szerint már egy évtizede csak viszik a pénzt, de a programozók lehet, hogy azon is nyernek. A felsoroltakon túl van még reálisan főterület, ahol az ML előkerül?

#17449-re "ertelmi minoseg": Nem árulod el az AI-nak, mi az a ceruza rajz, csak beadsz neki fényképeket, meg ceruzarajzokat, és azt mondod, azok alapján készítsen ceruzarajzot. Ha meg tudja csinálni, az minőségi különbség. Program felismerheti, hogy az egyik kép kontrasztosabb (éles vonalakkal van rajzolva színek nélkül), mint a másik. Azt mondod a programnak butítson le egy fényképet a kontraszt határok mentén behúzott vonalakkal, kész egy "ceruza rajz". De attól még a gép nem fogja tudni, mi az a "ceruza rajz". Az a része csak "marketing" (diplomatikusan fogalmazva meg a bulls**t-et).

-

martonx

veterán

Azt állítom, hogy ha a sok maszlagot (amiben természetesen rohadt sok fejlődés volt mind hardveres, mind elméleti vonalon) félretesszük, és eléggé felülről nézzük, mert egy laikusnak kell elmagyarázni, hogy mi az az AI és ML, akkor a statisztikával nem lövünk mellé. Végtelenül leegyszerűsítve a koncepciót, beküldünk rohadt sok (féle) adatot, és ezek alapján kapunk egy valószínűséget (ami bármi lehet, akár egy kép is, egy érzelem, bármi, amit az AI a legvalószínűbbnek tart).

-

martonx

veterán

Az általánosítás valahol nem statisztikai fogalom? :D

Értem én, hogy volt fejlődés a statisztikában (manapság trendibb data-sciencenek hívni) az elmúlt 50 évben, és ez pont a számítógépeknek volt köszönhető. De ne tegyünk úgy ML, AI kapcsán mintha most valaki feltalálta volna a spanyol viaszt, és a semmiből idekerült volna valami tökéletesen új csoda. Igen, a számítógépeknek köszönhetően új szintre emelkedett. -

coco2

őstag

Amennyire felmérni tudtam, vannak bemeneti mátrix minták (tartalmazzanak bármit), meg vannak kimeneti mátrix minták (tartalmazzanak bármit), és a kettő közötti kapcsolatot próbálják tömör formájú összefüggéssel leírni, amiről úgy vélik, később feltételezett kimeneti minták ismeretlen bemeneteinek visszakutatásához is felhasználhatják. A statisztika egykoron tapasztalati alapon volt jegyezve, de feltételezésekhez mindig is használták. Hogy most elektronika végzi az emberek munkáját, én azt nem nevezném túl nagy információtechnológiai különbségnek. Fejlődésnek mindenképpen, de az fejlődés, és nem különbség.

-

-

Talán segíti a megértést ez a kiegészítés: sokszor ugyan fix a szkóp, de bonyolult ökoszisztémák esetén nagyon nehéz eljutni oda, hogy ez feltöltődjön üzleti tartalommal. Például szeretnél csinálni egy új netbankot. Hiába készíted el a legmodernebb UI-t, azt ki kell szolgálni adattal, össze kell kötni core és szatelit rendszerekkel, amelyeknek vagy nincs normális dokumentációja, vagy elavult. Ez mind idő. Gyakran sokkal jobb elindulni agilisan egy szűkített szkóppal, lépésről-lépésre feltérképezni az integrációkat, és folyamatosan szállítani az új funkciókat. Ezt waterfallban megvalósítani szinte lehetetlen, legalábbis belátható időn belül.

Szóval az agilis értékekből nem csak az ügynökségek/szállítók profitálhatnak, hanem a nagy megrendelők is. Persze a valóság kijózanító.

-

martonx

veterán

Ilyen filozófiai mélységekbe ne menjünk bele, hogy mi számít felhőnek, és mi nem.

Arra gondolok, hogy ezekhez nem igazán kell szerver. Garázs cégeknél szerver bérlés meg pláne zsákutca. Ha önképzés a cél, akkor a felhőben futtatási lehetőségekkel kellene ismerkedni, nem linux szervert konfigurálgatni. No persze felhőben (ok, számomra a felhő az AWS, Azure, Google Cloud) is lehet komplett szerver instance-t keríteni, ha valaki mindenáron ehhez ragaszkodik. -

coco2

őstag

Na mindazokat magyarázd azoknak a főnököknek akiknek ha olyat mondasz, nem tudod előre felmérni és garantálni, hogy mennyi idő lesz az, amit el sem tudnak neked mondani, mert annyira kiforratlan és ködös az alapgondolat, azonnal látod rajtuk, hogy a következő pillanatban üvölteni kezdenének. És persze faképnél lehet őket hagyni, de hát pénzt locsolnak az informatikába, és szerintem cserébe jár nekik az idő, hogy tanuljanak, amennyire a cérnájuk bírja, bármennyi is legyen az.

-

coco2

őstag

Egy korlátos emberi erőforrás környezetben a többlet adminisztrációs teher fejlesztési időt von el. És még csak nem is dokumentálásra, hanem bürokráciára. De igazad van, a sebesség egy teljesen mellékes kérdés, elvégre nem is az alapból képtelen határidők mindig a baj. Szóval a szakmai oldalt nyugodtan félretehetjük - elvégre ki a fenét érdekel az - és lássuk az üzleti oldalát.

Az üzleti oldalon szakmailag hozzá nem értő emberek eggyeznek meg valami képtelenségben, amit a "körülmények összessége folytán realizálható objektivitás"-nak neveznek, miközben a buksija mélyén mindegyik azt gondolja, hogy majd pont a másikon fog csattanni az ostor az egyezményesen elkövetett hazugságok miatt. Ugyan mi is tudhat lehetségesen félresikerülni, ugye?

-

-

coco2

őstag

Mérföldkövezni persze mindig lehet. Főleg, ha az adott cégnél képben van a "vezetés", hogy ne engedje eltűnni az ügyfelet fél évre, amikor 2 hónap a project idő, mert befejezés után 4 hónappal elővenni valamit, ami után azóta már 10 másik dologgal foglalkoztál, na az pont olyasmi, hogy tökre esélyes leszel az egykori miértekre meg mondásokra mind emlékezni. Apropó sajnos vannak cégek, ahol eltűnnek az ügyfelek - hosszú időre. "Most nem tudok rá figyelni, azért kértem meg egy céget! Akkor szóljon, ha már kész van." és társai.

-

Drizzt

nagyúr

Na, itt jön egy igazán váratlan pont: nálunk nincsen code review.

Eleinte teljesen kizártnak tartottam, hogy ebből ne süljön ki valami katasztrófa hosszabb távon, de meglepő módon egész jól megy. Persze ennek alapja, hogy elég sok microservice van és ritkaságszámba megy az olyan, amin 3-nál több ember dolgozik összességében. Amin dolgozik 5-6 ember, na ott hiányzik a code review már egyértelműen. Ilyenkor már elkerülhetetlen az architekturális rohadás, indokolatlan kód és funkció duplikáció. De elenyészően kevés az ilyen "mikrolit".

Eleinte teljesen kizártnak tartottam, hogy ebből ne süljön ki valami katasztrófa hosszabb távon, de meglepő módon egész jól megy. Persze ennek alapja, hogy elég sok microservice van és ritkaságszámba megy az olyan, amin 3-nál több ember dolgozik összességében. Amin dolgozik 5-6 ember, na ott hiányzik a code review már egyértelműen. Ilyenkor már elkerülhetetlen az architekturális rohadás, indokolatlan kód és funkció duplikáció. De elenyészően kevés az ilyen "mikrolit". A tesztelés még tényleg ott marad így is, mint amihez jó a ticket, az biztos. És tök jól jönne a CR-hez is, amennyiben az lenne.

-

Voy15

tag

Dolgoztam UK governmentes projekten, és kifejezetten ők kérték, hogy githubot használjunk, illetve a különböző environmentekhez ec2-kat.

A confot ránk bízták, de a finishben ők külön intézték a pen testeket.

Beszéltem az ottani sys adminnal és mondta, hogy szinte mindenhol awst használnak.

Hozzáteszem, hogy ezek azért nem ilyen mi6 titkosságú dolgok voltak

-

Új hozzászólás Aktív témák

● olvasd el a téma összefoglalót!

- Ne várj sokat a vásárlással: drágulás a láthatáron

- Kínai és egyéb olcsó órák topikja

- Sony MILC fényképezőgépcsalád

- AMD Ryzen 9 / 7 / 5 9***(X) "Zen 5" (AM5)

- SteamOS gyere már PC-re! Nem, még nem jött el az idő.

- Eredeti játékok OFF topik

- E-roller topik

- Óvodások homokozója

- Elektromos autók - motorok

- OLED TV topic

- További aktív témák...

- Gigabyte AORUS 16X - i9 14900HX, 32gb ram, RTX 4070 (140w) 1tb SSD + gyári gari

- HTPC házi szerver config eladó ÁFÁS számla (Ryzen 5 2400G, 16 GB RAM)

- Jack Wills Parka Jacket Men kabát eladó

- HP Spectre x360 Érintős Hajtogatós Laptop Tab 16" -60% i7-13700H 16/1TB Iris Xe 3K+

- 7 DARAB! HP ELITEBOOK LAPTOP (Tartós, Elnyűhetetlen) 850 G8, 840 G8, 840 G9, 840 G10

- Kezdő Gamer PC-Számítógép! Csere-Beszámítás! I5 7500 / GTX 1050Ti / 16GB DDR4 / 128SSD+1TB HDD

- BESZÁMÍTÁS! ASUS ROG Strix RTX 2080Ti 11GB videokártya garanciával hibátlan működéssel

- Xiaomi Poco M7 Pro 256,Újszerű,Dobozával,12 hónap garanciával

- Telefon felvásárlás!! Samsung Galaxy A16, Samsung Galaxy A26, Samsung Galaxy A36, Samsung Galaxy A56

- GYÖNYÖRŰ iPhone 14 128GB Red -1 ÉV GARANCIA -Kártyafüggetlen, MS3678, 100% Akkumulátor

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: NetGo.hu Kft.

Város: Gödöllő

![;]](http://cdn.rios.hu/dl/s/v1.gif)