sry a dupláért, már nem tudtam szerkeszteni, most értem haza és a pcn nem engedi azt amit 1 perce irtam mobilon

Szóval ha belgondolok, mindig is ilyen 30-40ks vgaim voltak, és én ugyanezt éreztem mint amit te is leirtál. Low- medium részletesség, vagy low fps, lag, szaggatás-

nekem kb igy alakult hogy: s3 chrome , mx400, Geforce2 Ti(de ez valami nagyon dzsunka volt, kinai irásjeles dobozban) aztán jöttek az ati kártyák, 8500, X800 , x1600 , HD 3470 , aztán már a jó isten tudja mi, de ebben az időben szerintem a havi fizetésem is ilyen 30-40k, aztán 48000 ft volt , és utánna jöttek a durva minimálbér emelések.

És amikor már 180 ezret kerestem, akkor még mindig 30-40 ért akartam vga-t venni, mert ez volt a megszokott, menjen minden de szenvedjünk csak a beállításokkal, meg kinek kell 30nál több FPS.

Aztán kaptam valami szép adó visszatéritést , és bamm, befigyelt a 110-120 ezres r9 290 ( igaz mint mondottam 85ért ) ami talán egy 4850est váltott (amit amúgy nagyon szerettem, és jó áron adtam el pár évesen) és azóta se kellett szerintem medium alá tenni semmi single player játékot, és jól elvoltam nagyon-nagyon hosszú ideig. Főleg hogy a TFT monitorjaim sose tudtak többet 60Hznél , kivév talán az ősöreg EIZO CRT-m  Most hogy van egy normális (280hzes gamer) monitorom, meg valamennyire normális gépem (ryzen5 2600x ,16gb ddr4) most gondolkodtam el igazán egy vga upgraden , csak aztán szépen elindultak felfele az árak amig gondolkodtam hogy mit is kéne venni, most meg már mindenhol azt nyomják az ember képébe hogy nem jó az idő az upgradere

Most hogy van egy normális (280hzes gamer) monitorom, meg valamennyire normális gépem (ryzen5 2600x ,16gb ddr4) most gondolkodtam el igazán egy vga upgraden , csak aztán szépen elindultak felfele az árak amig gondolkodtam hogy mit is kéne venni, most meg már mindenhol azt nyomják az ember képébe hogy nem jó az idő az upgradere

amúgy egy -már meglévő- 1070Ti -vel még jó sokáig ellennék szerintem

Gyorskeresés

Legfrissebb anyagok

- Bemutató Route 66 Chicagotól Los Angelesig 2. rész

- Helyszíni riport Alfa Giulia Q-val a Balaton Park Circiut-en

- Bemutató A használt VGA piac kincsei - Július I

- Bemutató Bakancslista: Route 66 Chicagotól Los Angelesig

- Tudástár AMD Radeon undervolt/overclock

Általános témák

LOGOUT.hu témák

- [Re:] [Luck Dragon:] Asszociációs játék. :)

- [Re:] [D1Rect:] Nagy "hülyétkapokazapróktól" topik

- [Re:] [ubyegon2:] Airfryer XL XXL forrólevegős sütő gyakorlati tanácsok, ötletek, receptek

- [Re:] [Sub-ZeRo:] Euro Truck Simulator 2 & American Truck Simulator 1 (esetleg 2 majd, ha lesz) :)

- [Re:] [Adrian Mole:] Friss konfig, Win 11, gyere rám

- [Re:] [sziku69:] Szólánc.

- [Re:] Négymagos Xeon(!) CPU LGA775-ös deszkában

- [Re:] [bambano:] Bambanő háza tája

- [Re:] [sziku69:] Fűzzük össze a szavakat :)

- [Re:] Elektromos rásegítésű kerékpárok

Szakmai témák

PROHARDVER! témák

Mobilarena témák

IT café témák

GAMEPOD.hu témák

Hozzászólások

Diniboy

aktív tag

Diniboy

aktív tag

bár nem neked szántam, de lásd az előző hszem  Koca, talán az aki csak a single playerekkel játszik, meg talán lolozik stb, de mindegy neki hogy hol lesz a rangsorban, mert a jaték a lényeg . Amig beleszartam a pvp-be , én is ugyanigy voltam, csak menjen, jó nekem LOW grafika is , bár a WOW raideken már akkor is zavart amikor leesett 20 alá, ott már meglátszott a dpsen is ez xD

Koca, talán az aki csak a single playerekkel játszik, meg talán lolozik stb, de mindegy neki hogy hol lesz a rangsorban, mert a jaték a lényeg . Amig beleszartam a pvp-be , én is ugyanigy voltam, csak menjen, jó nekem LOW grafika is , bár a WOW raideken már akkor is zavart amikor leesett 20 alá, ott már meglátszott a dpsen is ez xD

De aztán sajnos rászoktam egy olyan túlélős játékra (RUST) ami leginkáb PVP, és ahol bőven számít kinek milyen gépe van, meg mennyi a monitor késleltetése, meg meddig látsz el a jatékban. ÉS iszonyat optimalizálattlan .

Persze le lehet venni részletességet, a látótávolságot, akkor jó az FPSem is, 80-120 is van néhol.. az ellenfeleket ugyanúgy észreveszed, csak nem biztos hogy azt is betölti a game hogy az bizony egy fedezék mögött van, és csak akkor jösz rá amikor rálőttél , azaz feladtad a poziciód de nem kapod a hitmarkert

Szóval amikor kicsit is elkezd érdekelni hogy igen, most téged amiatt lőtt be a 8 éves pistike, mert neki apu megvette a 2080ti-t akkor onnantól már nem casual a dolog szerintem

Kansas

addikt

Igen, valószínűleg még a két RDNA generáció közti optimalizációval együtt sem fog keveset enni - nem véletlen, hogy a csúcs-Ampere-re is 300+W TDP-t és 350W körüli TBP-t jósolnak, ennek a teljesítménynek jelen állapotok szerint ez az ára.

Ami érdekesebb, hogy azonos paraméterek mellett hogy alakul a W/frame érték(fajlagos fogyasztás), nem kizárt, hogy abban jobb lesz a 5700XT-nél, de ki tudja, esélyesebb, hogy nem.

Még mielőtt megint azzal hozakodnál elő, hogy ez nem NVidia cikk, jelzem, hogy az nem kifogás, egy kártya sem a vákuum közepén van, a teljesítménye és a fogyasztása is akkor nyer értelmet, ha az elődéhez illetve a közvetlen riválisához van hasonlítva. Az meg hogy mi a közvetlen riválisa(RTX3080 v RTX 3090), az árcédulától függ, amit egyelőre a legkevésbé ismerünk az összes paraméter közül

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

#00137984

törölt tag

Megjelenés idejében ezek a custom videókártyák még a középkategória felső részéhez tartoztak, ezért hivatkoztam az idővonalra. Mindig érkezik egy újabb VEGA56 vagy Radeon RX 5600 XT, ami gyorsabb és átrendezi az AMD termékvonalában az erőviszonyokat. Ez a középkategória ár/teljesitményén jelentősen nem javitott, mert mindig az az Nvidia...

Azért látom szintén érzékeled, hogy a nagyobb GPU teljesitmény a játékélményre is hatással van (alacsony input lag és a magas fps és látótávolság nem rossz dolog).

[ Szerkesztve ]

Kupszi

aktív tag

Én is így gondolom, viszont a 300+watt már nagyon soknak számít, mármint ami a hűtést illeti. Nos papíron az 5700XT nagyon jó watt-al promotálták, ám ennek ellenére hogy a kártyám nincs húzva 200-220wattal játszadozik. A nevezzük big navinak szerintem simán 350watt és ez csak több lehet használat közbe. Persze papíron szépen le fogják faragni a wattokat. Ha már Nvidia , mint ellenfél hát nem tudom... az AMD jól tenné ha még előtte kidobná a piacra a csúcskártyáját, mert az Nvidia szerintem a 3xxx -el nagyot fog robbani.(Persze ez csak az én gondolatom)

Pipapapa strikes back again! Avagy újabb tégla a falba!

sb

veterán

Mik a platformok, hol választod szét? Átfedés van.

Konzol:

- Sony-AMD

- MS-AMD

PC

- MS-AMD

- MS-NV

arn

félisten

amd vs nvra gondoltam.

facebook.com/mylittleretrocomputerworld | youtube.com/mylittleretrocomputerworld | instagram.com/mylittleretrocomputerworld

Kansas

addikt

Az RX5700XT-nek papíron 225W a fogyasztása, tehát nálad hozza a papírformát - nekem nincs fogyasztásmérőm de tippem szerint itt is, hangját legalább is nem hallom a Pulse-nak...(és nem, nem fejhallgatóval tolom általában).

Hogy mennyire nehéz lehűteni a 300W-ot? Nem egyszerű, de régen is megoldották, azóta meg fejlődött a technológia - abban azért reménykedek, hogy a blower ref-hűtőt elengedik végre, azzal tuti baromi hangos lenne.

Régi, kajálós kártyák(275W< referencia TDP értékekkel, ):

NV:

GTX 295 - 289W

GTX 590 - 365W

GTX 690 - 300W

GTX Titan Z - 375W

AMD:

HD 4870 X2 - 286W

HD 5970 - 294W

HD 6990 - 375W

HD 7990 - 375W

HD 8990 - 375W

R9 285X - 300W

R9 295X2 - 500W

R9 Fury X - 275W

Radeon Pro Duo - 350W

RX Vega 64 - 295W

RX Vega 64 Liquid - 345W

Radeon VII - 300W

Ez kb. a VGA történelem kezdete óta az összes VGA-nak álcázott fűtőtest - nem sok, általában a generációk teteje, de bővel elég, hogy legyen vele tapasztalat, szóval szerintem megoldják. Akinek ilyen kell, az általában vagy elviseli a hangját, vagy fejhallgatóval tolja, esetleg felvizezi vagy eldugja a szomszéd szobába.

Az árával kapcsolatban már nincsenek különösebb várakozásaim, ez drága lesz, alighanem skippelem is az RDNA2-t, és majd az RDNA3 kártyák közül veszek az 5700XT helyére egy kicsivel erősebb modellt - ha addigra elterjed a DRX olyan játékokban is amik engem érdekelnek és nem jók konzolon.

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

MeszesKPT

őstag

Legyen csak verseny, mert ez az egyetlen esély arra, hogy emberi szinten maradjanak a már amúgy elszabadult dVGA árak.

tasiadam

veterán

Egyik videos mondta, hogy az nvidia es az AMD dolga nem egymas, hanem az RX580 8gb legyozese. Miert? Nezzuk meg az árát, mennyibe is kerult, es mivel tud tobbet egy 200euro/dollaros kartya, igy ma.

Es valahol igaza van.

Gyermektelen, nem házas, másodrangú állampolgár

#00137984

törölt tag

Influencer akkor ezt nem mondta pontosan és mondok egy jobbat...

Intel/AMD/Nvidia legfőbb feladata a PC hardverek fejlődésének fentartása vagy a technológiák biztositása és a küzdelem a PC játékpiac elsőbbségéért ami veszélyeztetni látszik. A gamer PC játékosok megtartása miatt küzdjenek.

Ez igy most nehéz ügy miközben folyamatosan emelkednek a költségek és a játékfejlesztők igy generálják a gépigényeket. A játékosokra erőltetett növekvő költségek és a játékélmény nincs már arányban, miközben az átlag játékos ezeket nem tudja felvállalni. Ha az egyensúlyt a Radeon hozza meg idővel (RDNA3), akkor legyen és sosem a színek érdekeltek, hanem a játékélmény.

[ Szerkesztve ]

#06658560

törölt tag

Azért adott térfogatban adott hőteljesítményt annyival jobban nem tudunk elvinni. Még mindig korlát a fizikai tér, amibe be kell férni. Ugyanazok a megoldások maradnak. Sőt mintha rosszabb lenne a helyzet, legalábbis sokkal több vizes hűtésre emlékszem a közelmúltból, mint tíz évvel ezelőtt.

tasiadam

veterán

Inkabb en arra ertem, hogy a 230 dollaros indulo ara az rx580 8gb verzionak 3 eve nem igazan van semmi ellenfele. Most kapsz 200 dollarert? Lecserelned a legolcsobb 1660 superre? Nem. 5500xt? Nem. 1650s? Kizart. 5600xt pedig 280-300 dollar.

Gyermektelen, nem házas, másodrangú állampolgár

Kansas

addikt

Tíz évvel ezelőtt még nem volt ekkora divat a vízhűtés, sőt, akkoriban még hőterítő fém backplate-ek se nagyon voltak.

Arról nem is szólva, hogy amit az akkori 300W-körüli kártyák tudtak, azt most egy "belépő szintű" GTX1650 vagy pláne RX5500XT a kisujjából kirázza, negyed annyi fogyasztásból.

A mostani 300W-os kártyákra az emberek túlnyomó többségének nincs "szüksége". Persze, minél gyorsabb, annál jobb, de kompromisszumokkal(ahogy itt fentebb is többen írták), bőven meg lehet lenni nélkülük.

Ahogy eddig is (egy kivétellel, bár az inkább kuriózum), szvsz ezután is meg fog állni a csúcs VGA-k fogyasztása 300W körül, és javarészt épp azért, amiről itt diskurálunk: nagyjából ennyit lehet egy VGA kártyára való méretű hűtővel lehűteni. Tudnának ennél nagyobb fogyasztású, erősebb GPU-kat csinálni, csak azokhoz egzotikus hűtés(pl. Peltier-elem+folyadék) kéne, ami erősen megdobná az árát és/vagy korlátozná a rendszerekbe való beépíthetőségét(pl. 4-slotos videokártya).

Szóval ja, 300W nem kevés, de biztos lehetsz benne, hogy kitalálnak valamit a megfelelő hangerő mellett való lehűtésére, miellőtt piacra dobják - NVidia se véletlenül kísérletezik új hűtő design-nal...

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

jo, csak ezek a fury es a harom vega (vii is az) kivetelevel mind ketkartyas megoldasok. dupla die, dupla akkora helyen oszlik el (jellemzoen) a memoria, VRM is jobban eloszthato.

a 8990 egy rebrandelt 7990. a 285X meg egy felupgradelt 7970GHz volt.

300W folott volt a Vega 64 LC (limited run), a radeon vii (ami egy rebrandelt, bugos workstation kartya volt amibol kb alig adtak el), meg a 290X (uber) OC (mas neven a 390X). illetve volt par GTX480 OC amik elvileg 300W folott voltak gyarilag. 290Xnel volt haromfajta user: akinek vaporX volt (es orult), aki levizezte (es orult) es aki utalta.

az 5700XTbol egyebkent a blower is teljesen jo volt, vizesblokkal meg a hotspot meg mindig hidegebb, mint egy 5% gyari OCs 290X GPU tempje.

legen utobbi 10 evben gyakorlatilag nem volt fejlodes, vizen gyakorlatilag szinten semmi erdemleges. a backplate inkabb kinezet es mechanikai serulesek ellen van, ha mar az is beszall a hutesbe akkor altalaban komoly baj van.

Don't dream it, be it. // Lagom amount.

arn

félisten

igazan halkan tdpben szvsz kb 100w cpu es 200w gpu hutheto meg leghutessel. mindig azt veszem, ami kb ebbe belefer, az ilyen tulhuzott, csucsrajaratott vasakat mindig elkerulom.

[ Szerkesztve ]

facebook.com/mylittleretrocomputerworld | youtube.com/mylittleretrocomputerworld | instagram.com/mylittleretrocomputerworld

Kupszi

aktív tag

Ez egy nagyon jó összeírás, ami szemlélteti azt is , hiába az éves fejlődés a csíkszélesség csökkentés, a fogyasztás az évek alatt se csökkent. Tehát ezt a normát tartsák évek óta, de ennek oka is valószínű a versengés. Ugye a világon minden arról szól, minden energiatakarékos legyen, de emellett hozza a normákat. Értem én hogy számítástechnika, de itt inkább minden elszáll, mintsem takarékos legyen.

Már sajnos lassan alap lesz 2.5 slotos kártyák, és a 30 centi hosszúság amiről beszéltem. Igaz ott a referencia amik sokkal kisebbek, de általában a vásárlók 80% Custom felé veszi az irányt.

Pipapapa strikes back again! Avagy újabb tégla a falba!

ergoGnomik

tag

legen utobbi 10 evben gyakorlatilag nem volt fejlodes, vizen gyakorlatilag szinten semmi erdemleges.

Hát igen. Végül is a hőcserélőkben tényleg rengeteg fejlődési potenciál látszik. Ugye, a termodinamika a fizikának egy még kidolgozatlan, sok alapkutatást igénylő szakterülete.

Szakiii

addikt

Srácok segítsetek már kicsit, lemaradtam hardverek terén egy pár éve, ha egy felső közép kategóriás gépet szeretnék amd proci és vga-val. Melyik Vga-t éri megvenni most amd fronton? 100 ezer körül.

tasiadam

veterán

Milyen gepet vegyek topic.

Amugy ha talalsz akkor 5600xt.

Cpu meg 3600

Gyermektelen, nem házas, másodrangú állampolgár

Diniboy

aktív tag

És pontosan ezért írtam az 5600xt - t, ez azért most egy kicsit jobb mint a GCN - es közép kategória (elvileg számában ha a 460 - 5500 470- 5600 480- 5700 (mivel ugye nem lett 5800 vagy 5900 ezért egyel feljebb pozíciónálltam a számokat xD) akkor az 5600 sokkal jobb vétel mint a 470 volt. Persze árban feljebb léptünk (179usd vs 279 plusz a magyar valóság)szóval valahol nem jó a relacióm, látom én is. De én egyre inkább úgy látom hogy 100k alatt ne várja az ember FHD ultra magas fps meglegyen, sajna ez van. Aki nem akar vagy tud ennyit raszanni annak egy használt 480/580 30-40 körül meglepően jó élményt adhat, személyes tapasztalat :)

Kansas

addikt

Nem, nem száll el semmi, ugyanazt a teljesítményt töredék fogyasztáson kapod meg, vagy ugyanazon a fogyasztáson egyre nagyobb teljesítményt(és persze ez a két ellentétes sarka a mátrixnak, közte is van sok minden). Senki sem kötelez arra hogy mindig a legbivalyabb VGA-t vedd meg az aktuális lineup-ból.

30 centis kártyát se kötelező venned, sok gyártó hoz ki "ITX"-nek csúfolt 20 cm-es vagy annál is rövidebb custom karikat is(bár a csúcsból nincs ilyen).

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

BemAnyó

senior tag

Én azért azt remélem hogy kevésbé melegszik majd mint vega64nitro -m, ugyan kb

mindkettő 300watt, de a navi -nak kb min. kétszer akkora lesz teljesítménye, ezért gondolom hogy nem fog annyira "izzadni" ugyan azon a belállításokon/játékon mint a vega

#00137984

törölt tag

Diniboy és tasiadam

Videókártya gyártási költségek emelkedése egy természetes folyamat része.

PCB panel többrétegű a GPU és a GDDR6 VRAM bekőtése miatt, miközben a sokfázisos VRM és a tápellátás részre szintén egyre nagyobb terület kell.

Hűtési rendszerhez nagyobb hűtőbordák és arányosan több és vastagabb hőcsővekre van szükség, de ezeket már 2-3 ventillátor szellőzteti át és ezért a videókártyák méretesek lettek. Hűtés miatt a videókártyák megint egy tégla méretét érték el (Geforce 9800 GTX+), és legalább 2-3 PCI-E helyet elfoglalnak.

Ezt még tovább fokozzák az Nvidia RTX 3080 és a NAVI Radeon videókártyákon, ahol 300W körüli fogyasztásra számithatunk.

[ Szerkesztve ]

tasiadam

veterán

Szerintem ha lenne egy 250w tdp limit mindenre is, akkor is lenne teljesitmeny emelkedes.

Gyermektelen, nem házas, másodrangú állampolgár

Kansas

addikt

Lenne hát, csak amit most a 300W-os nagy VGA--kkal megkapsz, arra egy generációval többet kéne várni... most meg pont ugyanazt kapnád, amit a csúcs alatt eggyel levő kártyák fognak tudni, kb 200-250W fogyasztással.

Kb mintha azt mondanád: nem kell nekem RTX3090(vagy 3080Ti), elég az RTX3080 mert nem akarok 250W felett fogyasztó kártyát. Hát akkor vedd azt, senki nem erőlteti rád a 300W-os monstrumokat.

Ja és igen, így hogy van a 300W-os kategória, a 250W-osakat olcsóbban kapod meg, mert nem rájuk rakódik a csúcskártyák presztizs-árrése.

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

tasiadam

veterán

Csak a xx80 ti, titan es tarsaik mind inkabb "munkas" kartya nekem, mint gamer. Lenyegeben ok egy mainstream quadro kartyak, amik nem mentek at a QC-n a quadro cim eleresehez. Gondolok tensorflowra peldaul. 4k 60fps gamingre jo, de az uri huncutsag. 2k 144 es 1080p 240hz meg inkabb gamer. Az is inkabb esport alatt. Ezt szerintem nem a gyartok eroltetik, hanem a felhasznalok veszik agy nelkul ezeket. Ismerek olyat, aki 1080 ti-t akart, de nem tudta minek. Es 5700xt-je lett. A freesinc miatt megertem, de 1080p 75hz monitor melle?

Gyermektelen, nem házas, másodrangú állampolgár

Kansas

addikt

Nem mindegyik Quadro-ból van butítva, a többség az aktuális Titan-ból.

A 2080Ti nem gaming kártya? A nap vicce...

Nekem is 5700 XT-m van 1080p 72Hz mellett, és bizony pl AC: Odyssey-ben ritkán megy 50fps fölé... persze mikor vettem, még 1440p/144Hz monitorom volt, és előbb-utóbb beruházok egy 4K-sra, ha lesz belőle LFC-s értelmes áron(150e alatt), mert kell a 30-40fps közti tartomány is.

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

az marketing, egy TI / Titan komolyabb ML felhasznalasra keves. adott esetben hetekig fog tanulni a modell egy egyszerubb datasetnel is.

Don't dream it, be it. // Lagom amount.

tasiadam

veterán

A 2080ti-t inkabb hasznalnam tensorflowra, es nem feltetlen jatekra. Na ott izzadna igazan. Maskulonben nem adnam ki erte a felarat.

De emberunk nem igazan jatszik ilyet. Hanem regebbi jatekokkal fokent. A 1070 is eleg volt neki powerben, csak a freesync miatt akart amd-t vegul. De vegulis boldogan kiadott erte 175 ezret azert, hogy freeysncet bekapcsolja....

Gyermektelen, nem házas, másodrangú állampolgár

tasiadam

veterán

Hat akinek meg olyan nagy power kell, ott mas a megoldas. De pl a munkahelyemen egy 1080 ti-os geppel csinaltak teszteket, tanulast, stb, es az is lett a bemutato gep.

Gyermektelen, nem házas, másodrangú állampolgár

nalunk vettek egy negy quadros bladet, az valamennyit javitott a helyzeten.

mondjuk olyanrol is tudok, ahol 50 ilyen negyquadros bladet hasznalnak, igaz az egy nagyobb hely.

Don't dream it, be it. // Lagom amount.

Kansas

addikt

Azért vicces, hogy akitől én anno a 1440p/144Hz Freesync monitort(Samsung LC27HG70) vettem, az vígan hajtotta egy GTX1070-nel a Freesync-et, mert addigra már az NV is támogatta(nekem akkoriban Nitro+ RX480-am volt).

Szóval ezért kár volt neki...

[ Szerkesztve ]

Nincs olyan MI, ami képes lenne szimulálni az emberi hülyeséget... ha valaha lesz, annak tuti az emberi hülyeség lesz az oka... A Föld erőforrásai közül a legjobban az ész van elosztva - mindenki meg van róla győződve, hogy több jutott neki, mint másoknak.

Darmol

senior tag

A HBM technikai paraméterek tekintetében hatalmas előnyben van, ezt nyilván te is tudod. Ott ahol bevetették, és ez nem a játékos kártyák kategóriája, ott kihasználható. Az ára miatt nem terjedt el, ha ár nem lenne probléma, akkor most mindenki, és minden tehát nV is HBM-el menne. Érdekes, hogy pont ezt hoztad fel, mert nem írtam de azon forogtak a fogaskerekeim, ha a bigNavi és Ampere olyan árban lesz ahogy sejtem, én gyártók helyében nem tökölnék és mindkettőre ráraknék 16-32-64GB HBM2-t, mert árban nem oszt nem szoroz.

A CUDA is érdekes példa. Én arra emlékszem, mikor a Vulkan-ról írtak cikket, és abban írták, hogy az OpenCL felejtős hosszú távon, a CUDA-ra nem emlékszem, lehet hogy arra is ugyanezt a sorsot várta. De a telefonok Vulkan támogatás bevezetésének a fényében nem hiszem, hogy nagyot tévedett. CUDA-val ugyanaz a helyzet, mint a GSync-el: nV nagyon magánál akarja tartani a gyeplőt, ezért idővel olyan hátrányba kerül a technológia, ahol nV fel fogja adni. Ez nV számára üzletileg jó, vásárlók számára nem feltétlenül. De az is igaz, hogy ez vagy érdekli a delikvenst vagy nem, illetve a vásárlókat ért hátrány a többség számára nem releváns.

Aki azt mondja "nem tudom elhinni az igazságot" az naiv. Aki azt mondja "nem akarom tudni az igazságot" az ostoba. Aki azt mondja "az igazság tilos" az gonosz. Aki azt mondja "én határozom meg az igazságot" az beteg.

#06658560

törölt tag

Egyedül a sávszél amiben előnyben van. Cserébe komplexebb, és ha elcseszik a chipek beépítését, magasságát, akkor a felét megfőzik. Komplex, drága. Vagyis rohadtul nem consumer technológia, még Pro vonalon is csak kis szegmensben éri meg. Ehelyett az itteni fővizionárius szerint már az NV-nek létezni se nagyon kéne, annyival jobbnak kellett volna lennie az AMD-knek hála a HBM-nek.

Az, hogy te nem tökölnél megmagyarázza miért nem te vagy az adott cégeknél a döntési pozícióban lévő managga.

Volt az a korszak, amikor még sehol nem volt Vulkan (aminek amúgy semmi köze a CUDA-hoz, szóval felesleges kevered egymással a kettőt), amikor az AMD minden második szava az OpenCL volt, akkor annak kellett volna eltűntetnie az NV-t és a CUDA-t. Mert az utóbbi nem nyílt. Aztán az OpenCL elhalt, a CUDA ment tovább, hála annak, hogy az NV nem csak annyit csinál, nesztek itt a homokozó, hanem ad lapát, formát, vödröt is játszani benne.

#06658560

törölt tag

Fogyasztásban eddig sem volt előnyben.

Abu85

HÁZIGAZDA

A fogyasztás a HBM legnagyobb előnye a hagyományos memóriákkal szemben. Az egész alaptechnológiát azért dolgozta ki az ipar, hogy a memóriafal jelenségére reagáljon.

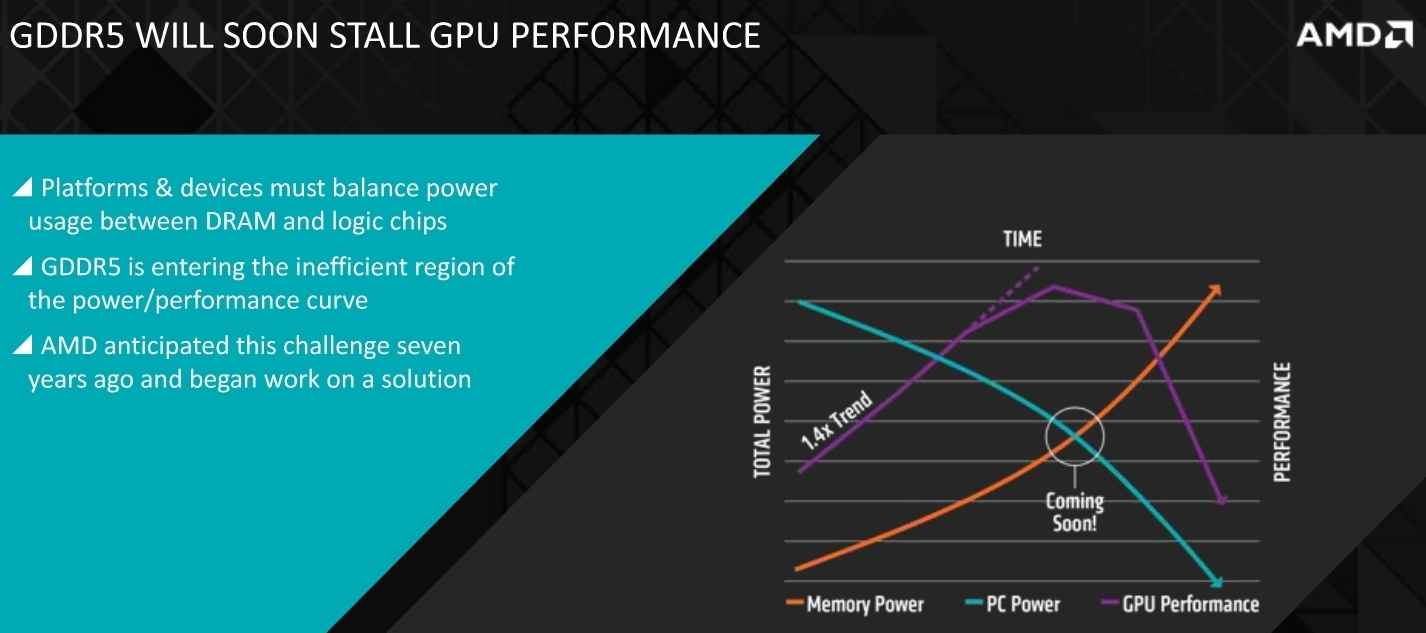

Ez a grafikon az alapprobléma. Minden egyes új memóriával az történt, hogy egy stack működéséhez több energiára volt szükség. A GDDR5 volt az első memóriaszabvány, ahol ez az energiaigény nagymértékben nőtt, vagyis bekerült a rossz hatékonyságú régióba. 2 watt per stack, az nagyon rossz hatékonyság, mert ahhoz, hogy növelni lehessen a sávszélt, szélesebb busz kell, de a szélesebb busz miatt több stacket kell használni. 64 bitenként kettőt vagy négyet, attól függően, hogy mennyi memória lesz a végterméken. Tehát már a 2010-es évek előtt átvillant a mérnökök agyán, hogy ha ez így megy tovább, akkor az 1 TB/s-os határ irreálisan magas fogyasztással hozható csak. Olyan magassal, hogy maga a lapka mellé épített memória többet fog fogyasztani, mint a konkrét lapka. És ez azzal jár, hogy ha nem lehet majd az egekig növelni a TDP-t, akkor a gyorsabb memória miatt alacsonyabb órajeleket kell beállítani a lapkára, vagyis összességében csökken a teljesítmény.

Erre reagál a HBM, méghozzá azzal, hogy kiszedi azt a részt, amitől a GDDR olyan baszott nagy fogyasztó lett. Tehát az effektív órajel alacsonyra van véve, cserébe a memóriabusz rendkívül széles. Ez is bajos lesz később, mert csak nyertünk 10 évet, hogy addig kitaláljuk mit kezdünk majd a HBM problémáival, majd olyan 10-15 TB/s környékén. Addig viszont ezt el tudjuk skálázni, és majd ott a HBM is nagy fogyasztó lesz, de ugye a GDDR esetében még az 1 TB/s is egy neves álom.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

#06658560

törölt tag

Csakhogy a tíz évből elment már durván három és még sehol a tömeges HBM.

arn

félisten

Szoftveresen kell hatekonyabb memoriahasznalat  egy adott technologiaban mindig hatalmas tartalekok rejlenek, csak a swek evolucioja semmivel sem gyorsabb, mint a hweke, es gyakran azert akad meg egy szinten, mert ott a “kesz” hw. Ha 10-20 evet porognenek ugyan azon a hwen, teljesen mas szintu dolgokat lehetne elerni, de a pcs piac hozzaszokott, hogy majd ugyis lesz masik.

egy adott technologiaban mindig hatalmas tartalekok rejlenek, csak a swek evolucioja semmivel sem gyorsabb, mint a hweke, es gyakran azert akad meg egy szinten, mert ott a “kesz” hw. Ha 10-20 evet porognenek ugyan azon a hwen, teljesen mas szintu dolgokat lehetne elerni, de a pcs piac hozzaszokott, hogy majd ugyis lesz masik.

facebook.com/mylittleretrocomputerworld | youtube.com/mylittleretrocomputerworld | instagram.com/mylittleretrocomputerworld

az a baj algoritmikusan vagy a futasido, vagy a memoriahasznalat fog megnoni egy szint felett.

trukkozni egy pontig lehet, aztan utana exponencialisan elszall az implementacios bonyolultsag is. azaz vagy sose fog mukodni, vagy eszmeletlenul draga lesz vagy par funkcioval sose fog mukodni.

vannak featureok amiket annyira maceras kihasznalni a gyakorlatban, hogy nem fogja megerni.

Don't dream it, be it. // Lagom amount.

sb

veterán

Valahol a kettő között, de inkább a fentebb írthoz közelebb van (volt) szvsz a valóság.

Nyilván kell technológiai fejlődés is, hogy szintet ill. akár paradigmát lehessen váltani programozási oldalról.

Az utóbbi 10-20 év viszont olyan szintű nyers hw fejlődésről szólt, hogy kényelmesen bele lehetett sz*rni* az sw oldalba. Inkább szvsz ez volt a jellemző.

*Ez így csúnyán hangzik és nyilván sokszor hozzáállás kérdése is, de a legtöbbször ez tudatos választás is volt. Az sw fejlesztés drága. A végletekig optimalizált főleg. A hw meg aprópénzért fejlődött nagyokat.

Amdahl torvenye gondolom megvan, ami ad egy felso hatart ara, hogy tobbmagos kornyezetben a szoftver tulajdonsagaitol fuggoen mennyire lehet kihasznalni az eroforrasokat. gondolom az is megvan, hogy nem csak vegtelenig parhuzamosithato problemak vannak.

programozasi oldalrol utobbi 10-20 evben azert eleg sok minden tortent. nezz meg egy weboldalt vagy appot 10 eve, nezd meg hogy nezett ki alatta a stack.

jatekoknal 20 eve volt egy mag, egy szalon, terhelestol fuggetlenul fix orajelen, meg mondjuk egy multiqueue round robin utemezo. jelenleg van X mag valtozo orajelen (sok sikert a race conditionokkal) amibe meg az utemezo belepiszkithat. 10 eve mar elkezdtek szalasitani, de igazabol a modernebb motorok a sok szalat az utobbi par evben kezdtek kihasznalni. ja hogy tobb szalra validalni "kicsit" macerasabb? machine learning teruleten meg egyaltalan gyerekcipobe jar a validalas (aktiv kutatasi terulet, jelenleg meg csak foleg kerdojelekkel).

paradigmavaltas volt, igaz inkabb munkaszervezes, mint programnyelv szempontbol. hala egnek, a covid-19 scrummal nem ment volna. bar ez sem igaz, mert az osszes nagy iterativ nyelv kapott lambdakat az utobbi evekben, meg persze vannak programnyelvek amik skalazodnak mint a prolog, de azt nem veletlenul csak es kizarolag bizonyos taskokra hasznaljak.

a jatekok valaszido valtozasra erzekeny, valosideju kritikus rendszerek. amik a tetejeben egy csomo kulonbozo hardveren futnak.ez mondjuk azert problema, mert lehet, hogy kevesebb memoria is eleg lenne, csak mondjuk kene fixen par extra orajelciklus takaritani, ami miatt a render thread sulya none. szoval a kerdes, ez megeri-e? na ez nem trivialis.

a hwfejlesztes is draga egyebkent, meg persze van rossz szoftver is ahogy van rossz hw. masik oldalrol viszont tenyleg ott vannak az algoritmusok a futasidejukkel, meg ott vannak a matematikailag bizonyitott hatarok, amiket egyszeruen nem lehet atlepni.

lehet trukkozni, de onnantol, hogy sokat kell trukkozni onnantol meg lehet megint romlik valamelyik teljesitmeny parameter. meg lehet mondjuk offloadolni CPU fele, csak aztan beterhel 8 magot a jatek, aztan a verpistikek meg dunat sirnak a steam forumokon, hogy az Assassins Creed hogy mer tovigterhelni 8 szalat es mert nem megy a 2mag (+HT) processzoran? vagy 120 GB lesz a jatek, hogy a texturakat annyira ne kelljen tomoriteni. vagy csak 60GB lesz a jatek, de HDDrol 5 perc lesz a toltesi ido, SSDrol meg ketto. nem egyszeru.

[ Szerkesztve ]

Don't dream it, be it. // Lagom amount.

Lacok

őstag

+1

"Errare humanum est, sed in errare perseverare diabolicum"

Mai Hardverapró hirdetések

prémium kategóriában

- Új, bontatlan Samsung S24+ 256 GB black

- Dell Latitude E7270, 12,5" HD Kijelző, i5-6300U CPU, 8GB DDR4, 256GB SSD, W10, Számla, Garancia

- Amazfit I T-REX 2 I GTS 3 I GTR 3 I GTR 3 Pro

- Új Latitude 7440 2-in-1, FHD+ IPS kihajtható érintő, i7-1365U, 32GB DDR5, 512GB NVMe, IR kamera, gar

- Beszámítás! GB H610M i5 13400F 32GB DDR4 1TB SSD RTX 3070Ti 8GB MONTECH AIR 1000 Lite Corsair 650W